今天的huggingface第一名是来自智谱的一款大模型:GLM-4.1V-9B-Thinking。

这个大模型最近几天一直徘徊在第二名,第一名是黑森林的Flux Kontext Dev,不过后者是一个AI绘画模型,二者没有可比性。

GLM-4.1V-9B-Thinking的优势在于以比较小的参数(9B)实现了接近DeepSeek和Qwen大参数模型的效果。对于私有化部署来说,非常的有价值,可以节约大量的资源,又基本不影响使用效果。

模型介绍

视觉-语言模型(VLMs)已成为智能系统的基础组件。随着现实世界 AI 任务的日益复杂,VLMs 必须超越基本的多模态感知,以增强其在复杂任务中的推理能力。这包括提高准确性、全面性和智能性,使应用能够解决复杂问题、理解长上下文以及多模态代理。

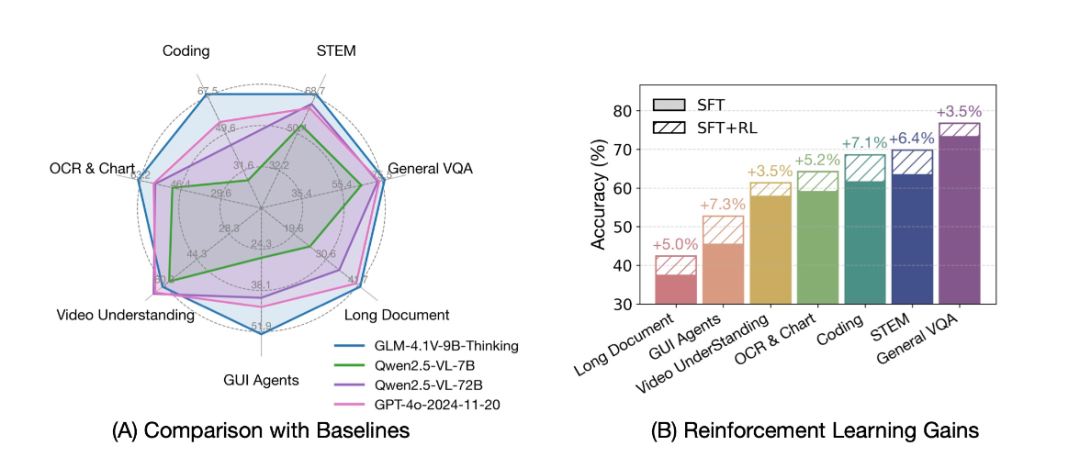

基于 GLM-4-9B-0414 基础模型,我们提出了新的开源 VLM 模型 GLM-4.1V-9B-Thinking,旨在探索视觉-语言模型推理能力的上限。通过引入“思考范式”并利用强化学习,该模型显著增强了其能力。它在 10B 参数 VLM 中达到了最先进的性能,甚至在 18 个基准任务中与 72B 参数的 Qwen-2.5-VL-72B 相当或超越。我们还开源了基础模型 GLM-4.1V-9B-Base,以支持进一步研究 VLM 能力的边界。

与上一代模型 CogVLM2 和 GLM-4V 系列相比,GLM-4.1V-Thinking 提供了以下改进:

- 系列中的第一个以推理为重点的模型,不仅在数学方面,还在各种子领域中都取得了世界领先的性能。

- 支持 64k 的上下文长度。

- 处理 任意纵横比 和高达 4K 的图像分辨率。

- 提供一个开源版本,支持同时使用中文和英文双语。

基准性能

通过引入链式思考推理范式,GLM-4.1V-9B-Thinking 显著提高了答案的准确性、丰富性和可解释性。它全面超越了传统的非推理视觉模型。在 28 个基准任务中,它在 23 个任务上达到了 10B 级模型的最佳性能,并且在 18 个任务上甚至超越了具有 72 亿参数的 Qwen-2.5-VL-72B。

快速推理

这是一个使用 transformers 库运行单张图像推理的简单示例。

First, 从源代码安装 transformers 库:

pip install git+https://github.com/huggingface/transformers.git

然后,运行以下代码:

from transformers import AutoProcessor, Glm4vForConditionalGeneration

import torch

MODEL_PATH = "THUDM/GLM-4.1V-9B-Thinking"

messages = [

{

"role": "user",

"content": [

{

"type": "image",

"url": "https://upload.wikimedia.org/wikipedia/commons/f/fa/Grayscale_8bits_palette_sample_image.png"

},

{

"type": "text",

"text": "describe this image"

}

],

}

]

processor = AutoProcessor.from_pretrained(MODEL_PATH, use_fast=True)

model = Glm4vForConditionalGeneration.from_pretrained(

pretrained_model_name_or_path=MODEL_PATH,

torch_dtype=torch.bfloat16,

device_map="auto",

)

inputs = processor.apply_chat_template(

messages,

tokenize=True,

add_generation_prompt=True,

return_dict=True,

return_tensors="pt"

).to(model.device)

generated_ids = model.generate(**inputs, max_new_tokens=8192)

output_text = processor.decode(generated_ids[0][inputs["input_ids"].shape[1]:], skip_special_tokens=False)

print(output_text)

模型下载(免梯子):

https://hf-mirror.com/THUDM/GLM-4.1V-9B-Thinking

(文:路过银河AI)