不想看内容,试试听推送吧!(该博客基于 MOSS-TTSD 合成)

当前的文本到语音(TTS)模型在单句或孤立段落的语音生成效果上取得了令人瞩目的进展,合成语音的自然度、清晰度和表现力都已显著提升,甚至接近真人水平。不过,由于缺乏整体的对话情境,这些 TTS 模型仍然无法合成高质量的对话语音。

现在,历史时刻来到!上海创智学院、复旦大学和模思智能的 OpenMOSS 团队携手推出了革命性成果 ——MOSS-TTSD!首次基于百万小时音频训练,成功破除 AI 播客的「恐怖谷」魔咒。

MOSS-TTSD-V0 全新释出,模型权重及推理代码全面开源,商业应用无障碍!

-

项目地址:https://github.com/OpenMOSS/MOSS-TTSD

-

在线体验:https://huggingface.co/spaces/fnlp/MOSS-TTSD

与传统 TTS 模型只能生成单句语音不同,MOSS-TTSD 能够根据完整的多人对话文本,直接生成高质量对话语音,并准确捕捉对话中的韵律变化和语调特性,实现超高拟人度的逼真对话语音合成。

接下来听听实测效果,并比较一下与其他 TTS 模型的听感差异。

中文播客示例

团队以奇绩「前沿信号研究体系」的每日推文作为内容,对比了豆包(商业产品)的播客生成与 MOSS-TTSD 的开源播客生成工作流程,结果发现两者在多个维度上表现相当。

无论是情感的丰富度、语气的自然度,还是整体的表现力,MOSS-TTSD 作为开源模型都展现出与商业解决方案相媲美的性能水平。

生成的几组对照效果如下:

说明:因豆包无法控制博客的文本内容,因此两者的内容无法控制保持一致。

团队进一步整理了更多 MOSS-TTSD 的音频样例,以展示模型的出色表现。以下是更多的 MOSS-TTSD 生成播客片段,表现出了优秀的零样本音色克隆能力和稳定的长语音生成能力,进一步验证了其在情感表达、语调自然度和整体流畅性上的优异性能。

邓紫棋 & 周杰伦

潘长江 & 嘎子

Speed & Xqc

更多长播客:

根据过往机器之心关于「Context Scaling」推送,使用 MOSS-TTSD 开源的播客生成工作流生成的播客

原神游戏讨论

接下来就让我们一起来深入了解 MOSS-TTSD 的技术内核。

模型技术解析

MOSS-TTSD 基于 Qwen3-1.7B-base 模型进行续训练,采用离散化语音序列建模方法。团队在约 100 万小时单说话人语音数据和 40 万小时对话语音数据上进行训练,实现了中英双语语音合成能力。

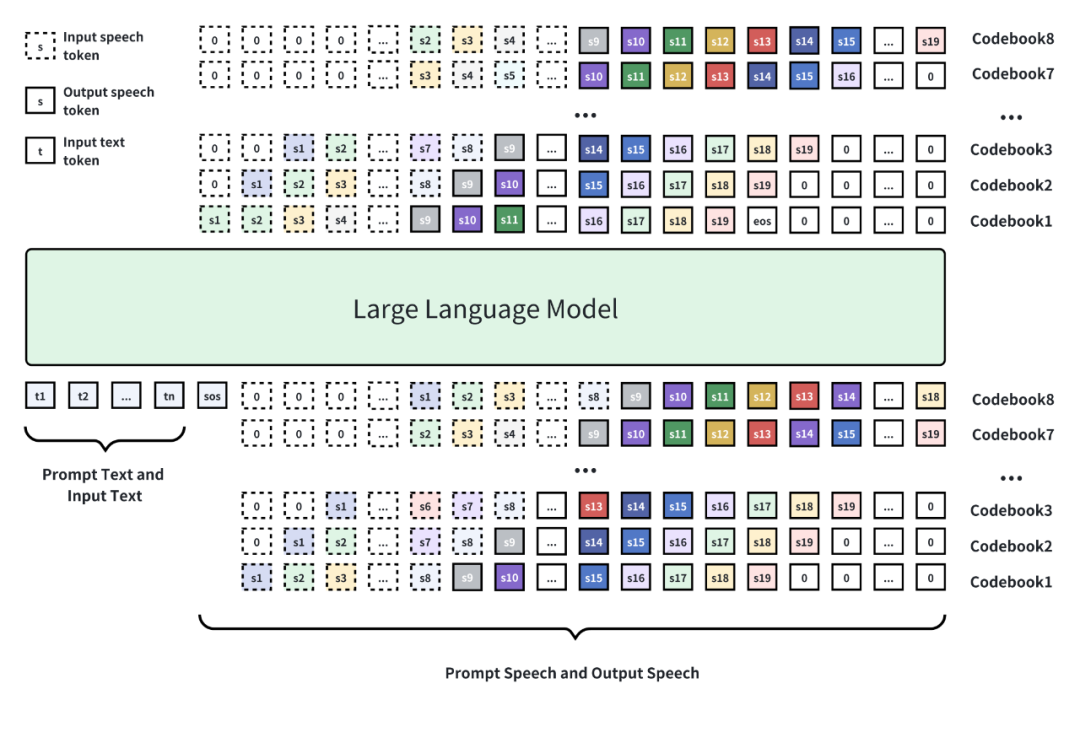

模型结构概览:基于 Qwen3-1.7B-base 模型进行训练,使用八层 RVQ 码本进行语音离散化,使用自回归加 Delay Pattern 进行语音 token 生成,最后使用 Tokenizer 的解码器将语音 token 还原为语音。

XY-Tokenizer 的创新突破

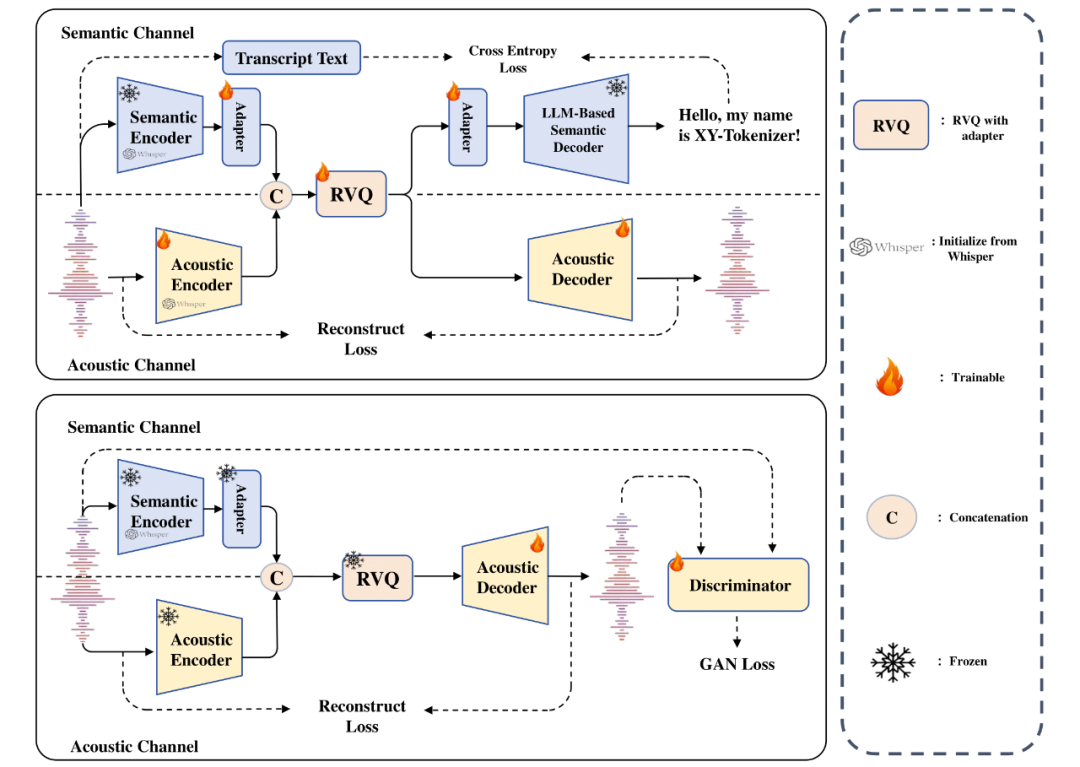

MOSS-TTSD 的核心创新在于 XY-Tokenizer—— 一个专门设计的语音离散化编码器。

这个 8 层 RVQ 的音频 Codec 能够同时建模并编码语音的语义和声学信息,将比特率压缩至 1kbps,使得大语言模型能够有效学习音频序列并建模细节声学特征。

如下图所示,XY-Tokenizer 采用了双阶段多任务学习的方式进行训练。

第一阶段(上半部分)训练 ASR 任务和重建任务,让编码器在编码语义信息的同时保留粗粒度的声学信息。

第二阶段(下半部分)固定住编码器和量化层部分,只训练解码器部分。通过重建损失和 GAN 损失,利用生成式模型的能力补充细粒度声学信息。

XY-Tokenizer 采用了两阶段多任务学习的方式进行训练。

得益于超低比特率 Codec,MOSS-TTSD 支持最长 960 秒的音频生成,可以一次性生成超长语音,避免了拼接语音片段之间的不自然过渡。这使得 MOSS-TTSD 特别适合播客、影视配音、长篇访谈、数字人对话带货等应用场景。

数据工程:海量真实数据的处理挑战

高质量的数据是优秀 TTSD 模型的基础。

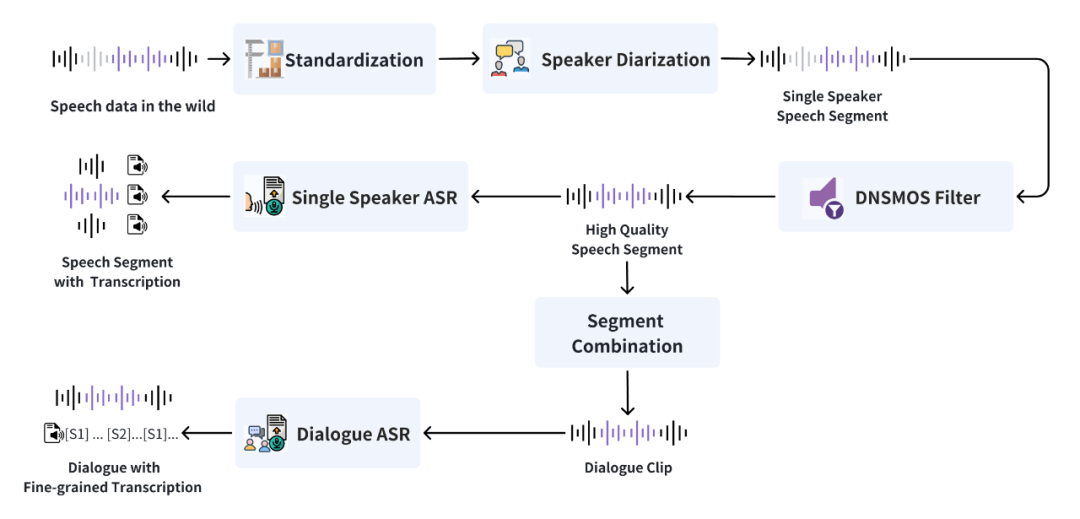

团队设计了高效的数据处理流水线,能够从海量原始音频中准确筛选出单人语音和多人对话语音,并使用内部工具模型进行标注,具体如下图所示。

MOSS-TTSD 数据清洗流水线概览。

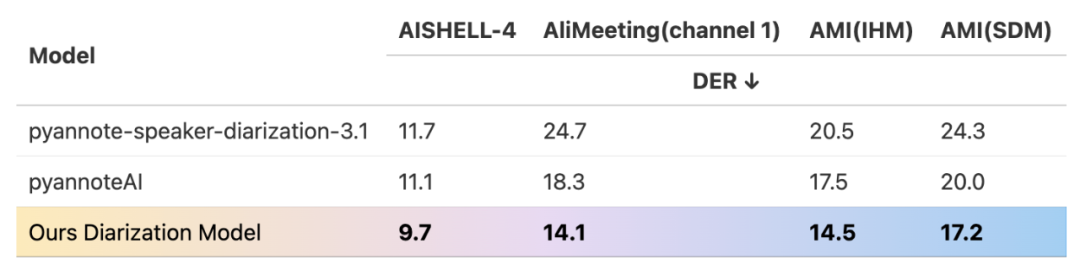

团队首先使用了内部的说话人分离模型进行语音分段和说话人标注,该模型在性能上已经超越了开源的 pyannote-speaker-diarization-3.1 及其商用版本。接下来使用 DNSMOS 分数评估语音质量,只保留分数≥2.8 的高质量语音片段。

下表为说话人分离模型在不同数据集上的 DER(Diarization Error Rate)结果(越低越好),MOSS-TTSD 使用的工具在四个测试集上都取得了最优性能。

对于多人对话语音,团队还训练了自研的对话 ASR 模型来进行细粒度说话人标注和文本转录,解决了现有 ASR 模型无法准确转录重叠语音的问题。

实验结果:达到业界领先水平

为了客观、全面地评估 MOSS-TTSD 的优异性能,团队精心构建了一个包含约 500 条中英文双人对话的高质量测试集。

在评测流程中,团队首先利用 MMS-FA(Meta’s Massively Multilingual Speech Forced Alignment)模型,将输入文本与生成音频进行词级别对齐,并依据标点符号切分为句子片段,每个片段的说话人标签则由输入文本直接指定。

为了量化评估音色克隆的保真度和准确性,评测采用了 wespeaker-SimAMResNet100 作为说话人嵌入(speaker embedding)模型。该模型会计算每个生成片段与 prompt 中两位说话人音频的音色相似度,并将相似度更高的一位判定为当前片段的说话人。

如此,最终得出了每条语音的说话人切换准确率和平均音色相似度。团队与开源模型 MoonCast 进行了对比,中文客观指标上取得了大幅领先的结果。

此外,MOSS-TTSD 的语音韵律和自然度也远胜于基线模型,更多 demo 对比请见:https://www.open-moss.com/cn/moss-ttsd/

说明:本文展示音频仅用于效果演示,不表示团队观点立场。

©

(文:机器之心)