新智元报道

新智元报道

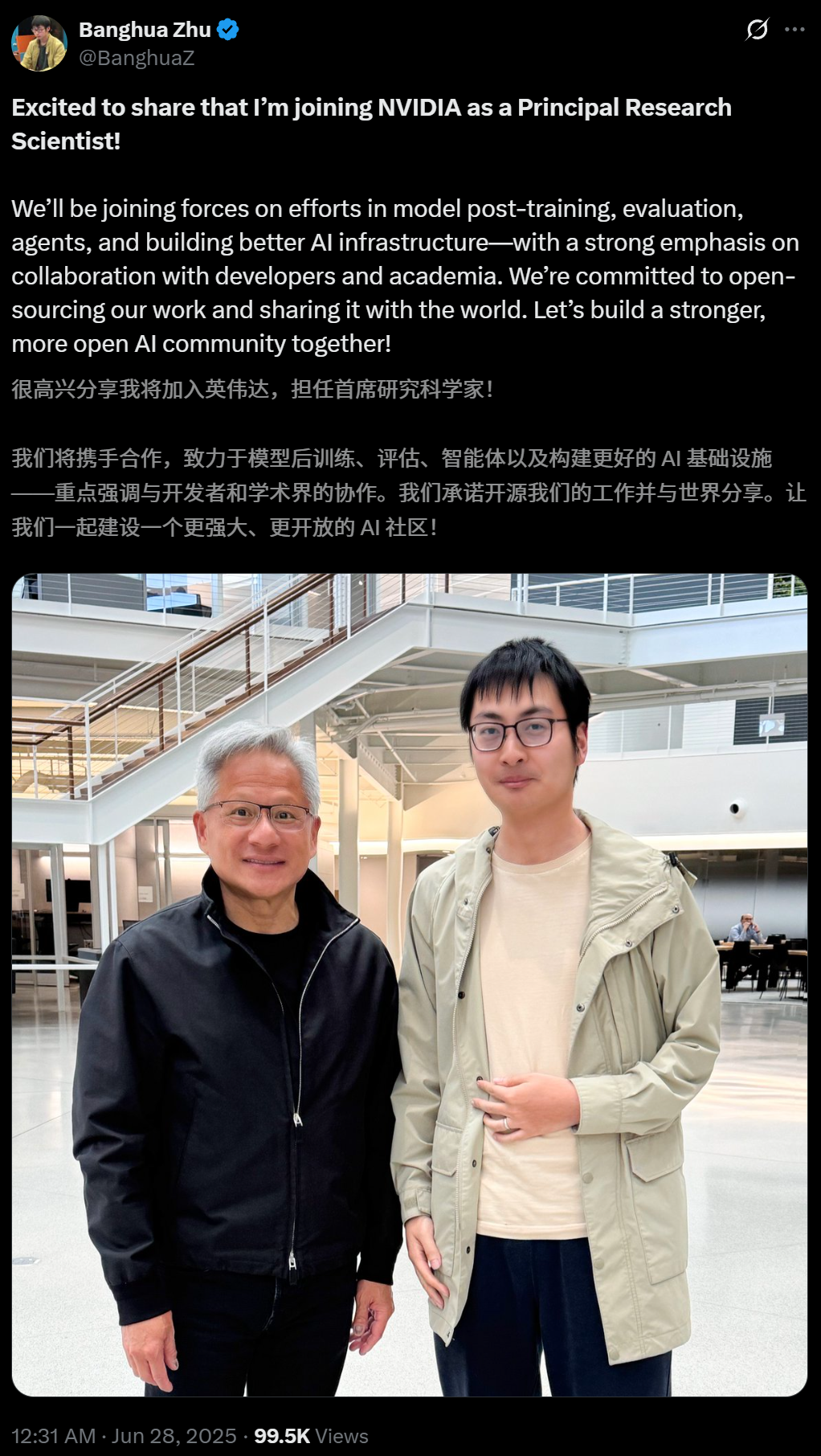

【新智元导读】老黄惊喜现身,与95后清华校友合影曝光,确认Banghua Zhu加入Star Nemotron团队,专注企业级智能体研发。同时Jiantao Jiao官宣入职英伟达。两人曾联合创办Nexusflow。

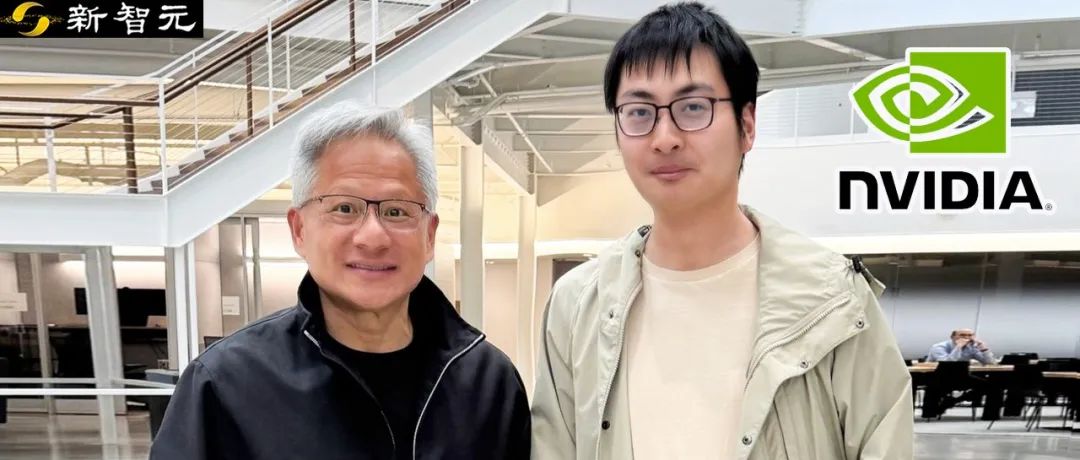

就在刚刚,行踪一向神秘的老黄终于出现了!

他与两位华人在同一地点的合影,登上热搜,而且这次老黄并没有穿着他那标志性的皮衣。

老黄这次「悄悄地」将这两位华人AI大神收入麾下。

两人的评论区都是各种大佬的恭喜,看都看不过来。

上下滑动查看

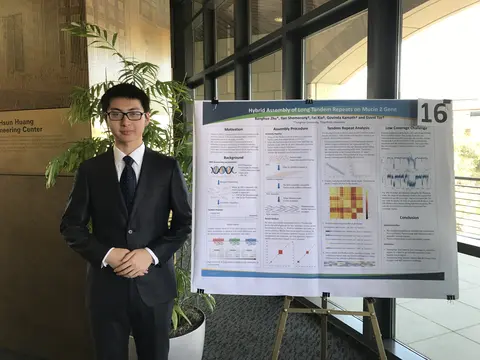

通过比对照片背景,我们发现拍摄地点很大概率就在NVIDIA位于加州圣克拉拉总部园区的 「Voyager」大楼。(但尚未获得官方确认。)

老黄的英伟达似乎正在酝酿什么大事件?

这两位华人大神的背景都非常硬核,并且共同创办了一家公司Nexusflow,致力于为企业构建智能体。

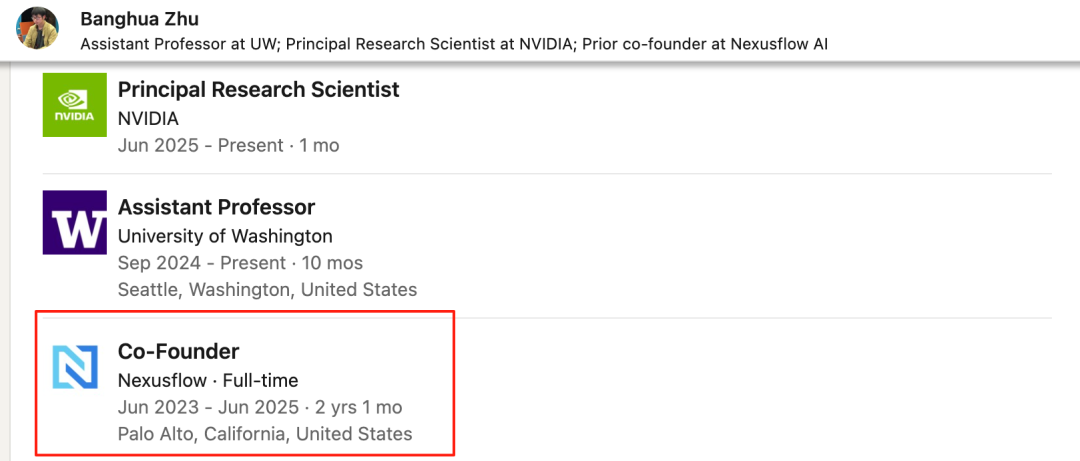

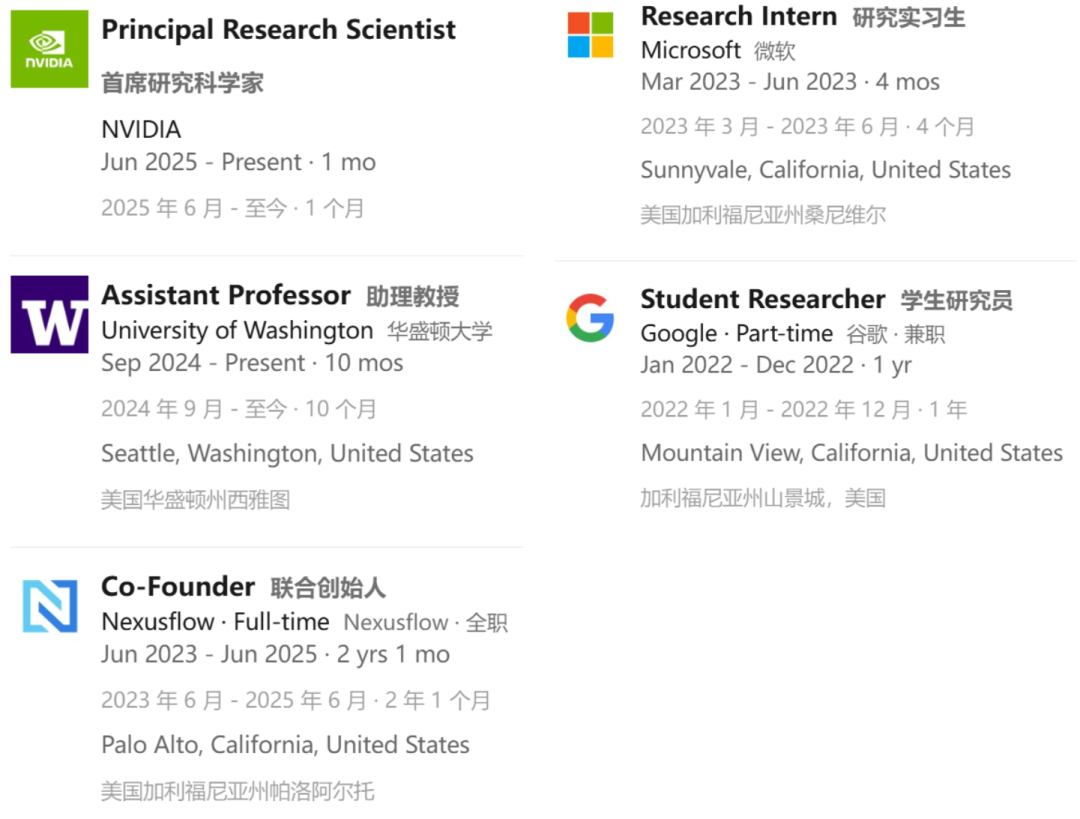

Banghua Zhu是华盛顿大学电子与计算机工程系(ECE)助理教授,并在计算机科学与工程系(CSE)兼任教职。

他曾在2023年联合创立了Nexusflow AI。

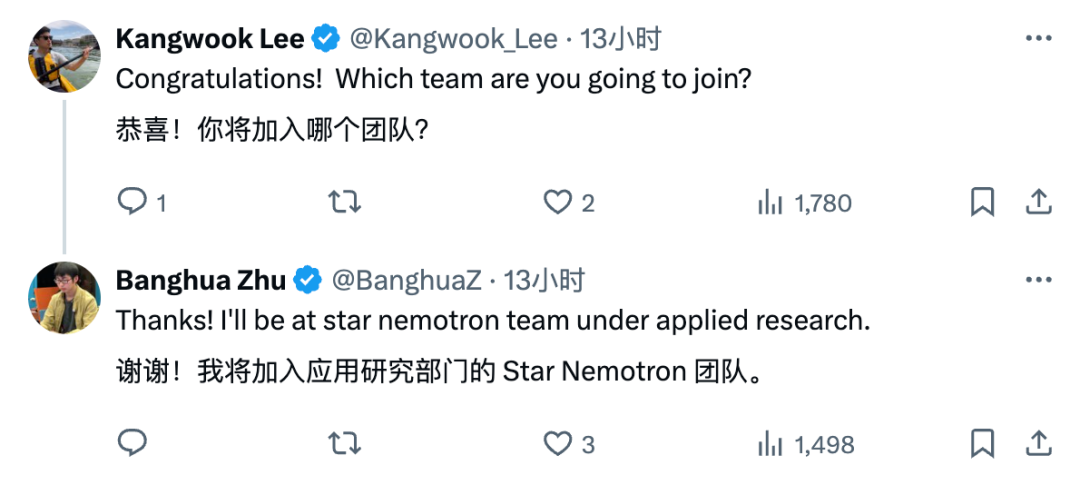

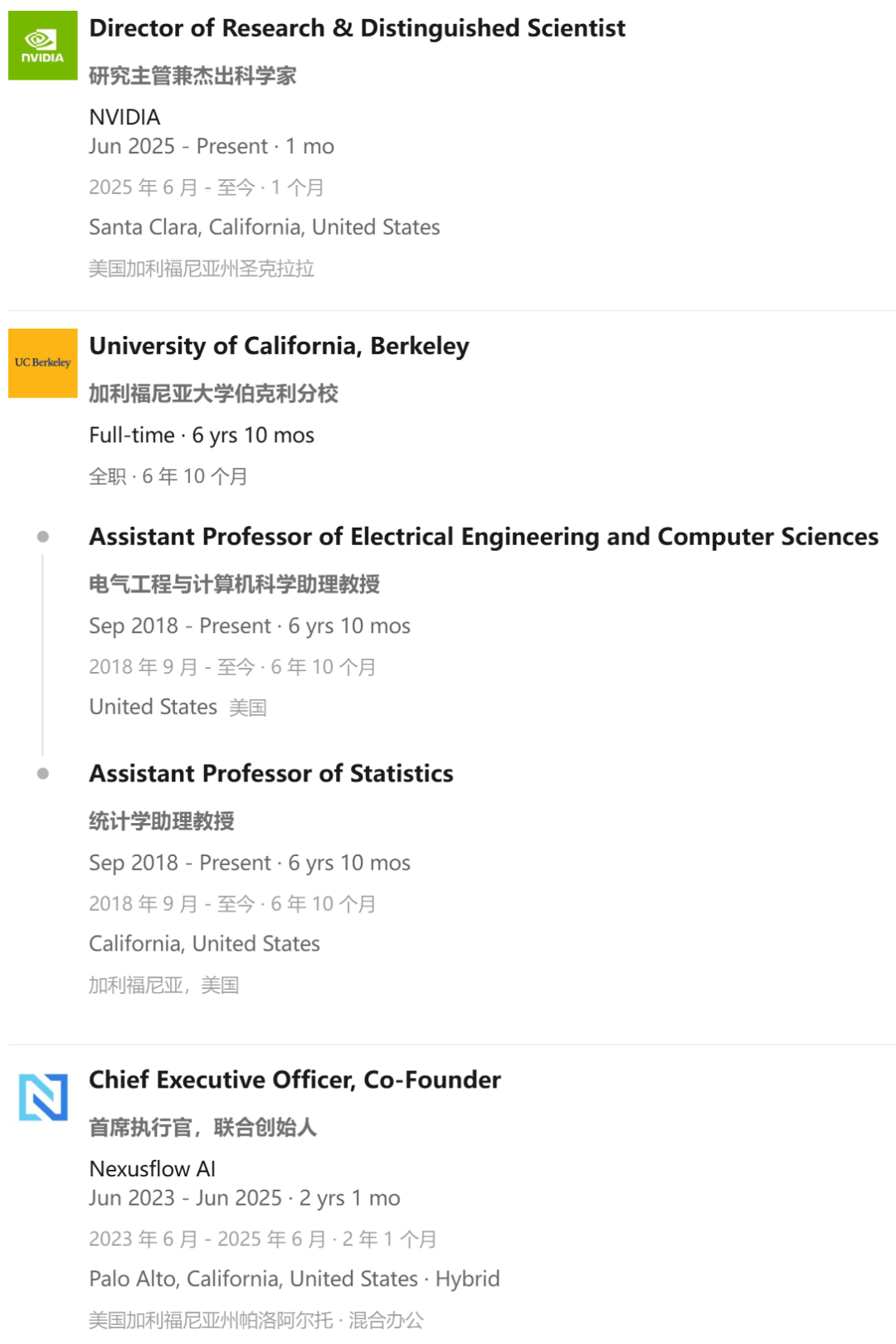

这一次他以首席研究科学家的身份加入英伟达的研究部门的Star Nemotron团队。

Star Nemotron团队在英伟达专注于企业级智能体构建,算是「专业对口」了。

Jiantao Jiao是加州大学伯克利分校电子工程与计算机科学系(EECS)和统计系的助理教授。同时也是伯克利CLIMB的联合主任,以及BAIR Lab、BLISS和RDI的成员。

值得一提的是,他还是上文提到的Nexusflow的联合创始人兼CEO。

如果继续深挖两位华人专家的背景和经历,也许能得出一个结论。

老黄这次也下场在AI领域「抢人了」。

Banghua Zhu是华盛顿大学电子与计算机工程系(ECE)助理教授,并在计算机科学与工程系(CSE)兼任教职。

他曾在2023年联合创立了Nexusflow AI,致力于为企业级应用场景提供可靠的AI智能体解决方案。

此前,他在加州大学伯克利分校电子工程与计算机科学系(EECS)获得博士学位,师从Jiantao Jiao教授和Michael I. Jordan教授。

并在清华大学获得电气与电子工程学士学位。

凭借着杰出的博士科研工作,他还荣获了伯克利颁发的2023年度David J. Sakrison纪念奖。

他目前的研究方向包括基础模型的理论基础、训练、服务、评估与应用。

此外,他也长期致力于统计学、信息论和机器学习领域,及其在博弈论、稳健统计、强化学习和人机交互等方向的应用。

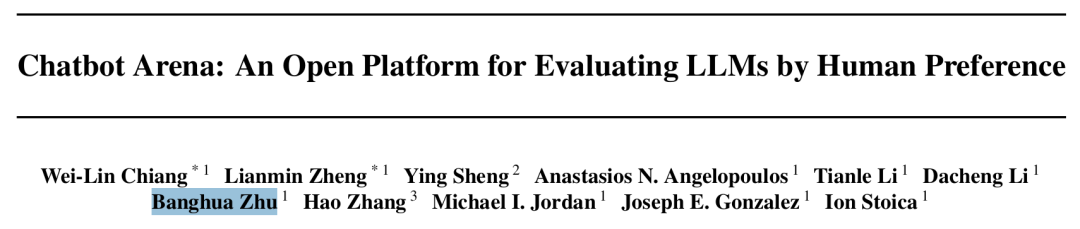

如今堪称「最权威」LLM评测的LMArena,他就是创始作者之一。

论文地址:https://arxiv.org/pdf/2403.04132

在模型训练、评估方面和理论基础等研究上,Banghua Zhu的成果颇丰。

在模型训练方面:

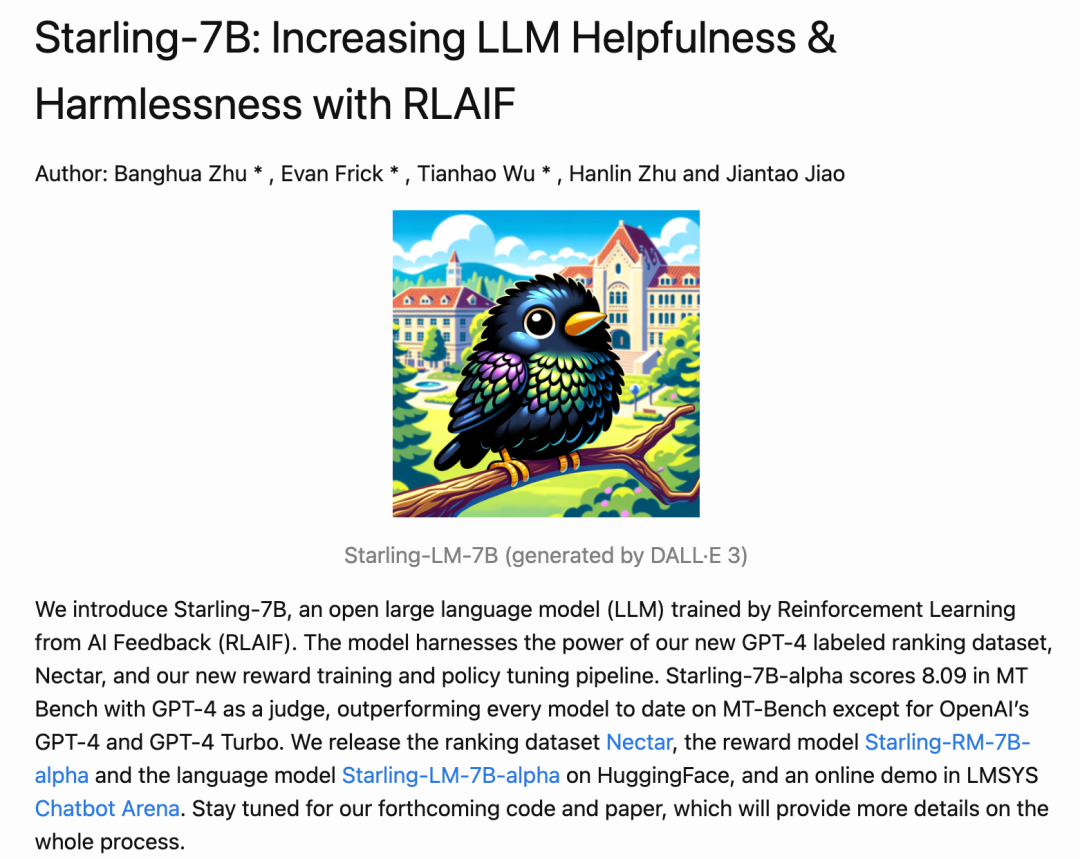

Starling-7B

-

Starling-7B使用团队创建的开源高质量偏好数据集Nectar,以及创新性的奖励模型训练和策略模型微调算法进行训练。

-

根据Chatbot Arena的评估结果,Starling-7B在所有基于Mistral的7B模型中高居榜首。

Athene系列

-

Athene-70B:团队首个基于Llama-3-70B微调的模型,在Chatbot Arena上的Elo评分提升了30多分,并显著增强了其多语言能力。

-

Athene-V2-72B-Chat:基于Qwen-2.5-72B微调而来。作为一个非推理模型,它在Chatbot Arena上的排名仅次于DeepSeek V3和DeepSeek R1,并在MMLU-Pro、GPQA、AIME、IFEval等多个基准测试中直接对标GPT-4o。

-

Athene-V2-72B-Agent:一款专为函数调用和AI智能体应用场景设计的模型,在复杂的函数调用任务中(尤其是在并行和嵌套调用上)性能超越了GPT-4o。

在模型评估方面:

-

Huggingface函数调用排行榜:被Llama-3.1技术报告用于评估模型的函数调用能力。

-

Chatbot Arena:基于人类偏好来评估模型的最可靠平台之一。

-

Arena-Hard-Auto:一种自动化的基准创建流水线,采用「大语言模型即裁判」(LLM-as-a-judge)的模式来快速评估模型性能。

-

基于代理模型的偏好评估(Preference Proxy Evaluations):一套高质量的奖励模型评估流水线,用于评估RLHF中的奖励模型,其结果与下游强化学习的最终性能高度相关。

在理论基础方面:

-

RLHF的根本极限:识别了RLHF的根本局限,并为奖励模型训练开发了具有更优样本复杂度的近乎最优算法。并且还提出了近端策略优化 (PPO) 的一种替代方案,该方案在策略优化中更稳定、样本效率更高。

-

大语言模型水印:提出了一种在统计意义上近乎最优的大语言模型水印算法。

在模型服务方面:

-

模型路由与缓存:分析并提出了用于大语言模型服务中缓存和模型复用的近乎最优算法,显著提升了推理效率。

-

S-Lora:提出了一套能够同时服务数千个LoRA适配器的算法与框架——S-Lora。

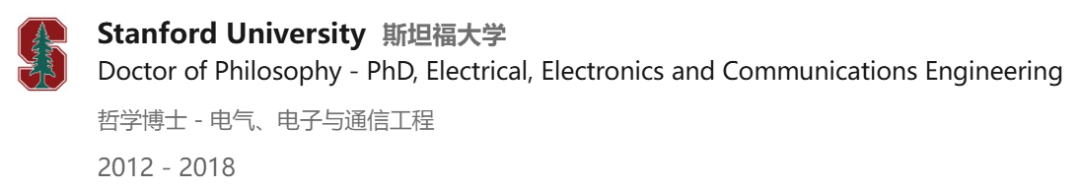

Jiantao Jiao是加州大学伯克利分校电子工程与计算机科学系(EECS)和统计系的助理教授。同时也是伯克利CLIMB的联合主任,以及BAIR Lab、BLISS和RDI的成员。

他同时也是上文提到的Nexusflow的联合创始人兼CEO。

此前,他在斯坦福大学获得博士学位。

他最近的研究重点是生成式AI与基础模型,涵盖了从数据策管、预训练、有监督微调、指令微调、基于人类反馈的强化学习(RLHF)、模型推理,到构建防御「越狱」和「提示词注入」攻击的安全护栏等全链条技术。

此外,他也对统计机器学习、优化、机器学习系统的隐私与安全、强化学习、机器学习的经济学视角,及其在自然语言处理、代码生成、计算机视觉、自动驾驶和机器人等领域的应用有广泛兴趣。

老黄为何要招募这两位华人?也许老黄不想仅仅只卖GPU!

英伟达的下一步是提供端到端的智能体解决方案——软硬通吃。

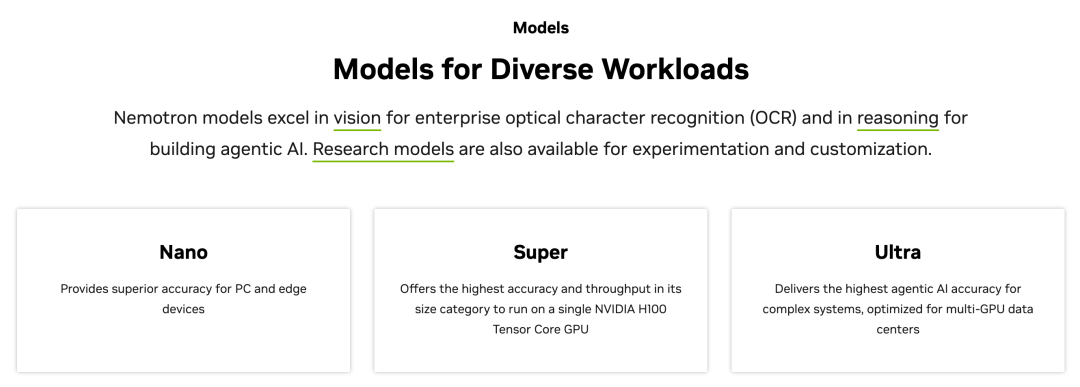

NVIDIA此前在GTC上推出的Nemotron系列,主打多模态推理、函数调用和工具链接口能力。

细分Nano/Super/Ultra三档算力梯度,旨在给开发者与企业提供「业务级」Agent底座。

这两位华人都是在企业级智能体领域创业多年,并且横跨学术界和产业界,也许正是英伟达模型训练急需的人才。

并且,老黄此前就表示过,他真的看好华人,他说:

中国人工智能研究人员是「世界级」的——美国公司正在雇佣「大量」此类人才。

估计是眼看人才都要被抢光了,老黄也赶紧出手了。

如果再结合此前何恺明入职谷歌、Meta挖走OpenAI苏黎世团队、小扎还不断挖OpenAI的墙角等事件。

这场AI的抢人大战,也许才刚刚开始。

(文:新智元)