打包行李时随口问一句“亚麻裙子怎么叠不起皱”,听到回答后接着问“要是还皱了怎么办”。这是来自谷歌的新功能,它让搜索不再需要键盘与屏幕,只需动动嘴皮子。

“帮我找防止亚麻裙在行李箱起皱的方法”,美国加州的一位用户对着手机说。不到两秒,一个自然的女声回应:“建议将裙子卷起来放入塑料袋中,减少摩擦。”用户接着问:“如果拿出来还是皱了怎么办?”声音再次响起:“您可以使用酒店熨斗低温处理,或者挂在浴室利用洗澡蒸汽除皱。”

这段流畅的对话并非来自客服电话,而是谷歌公司最新推出的Search Live语音搜索功能。

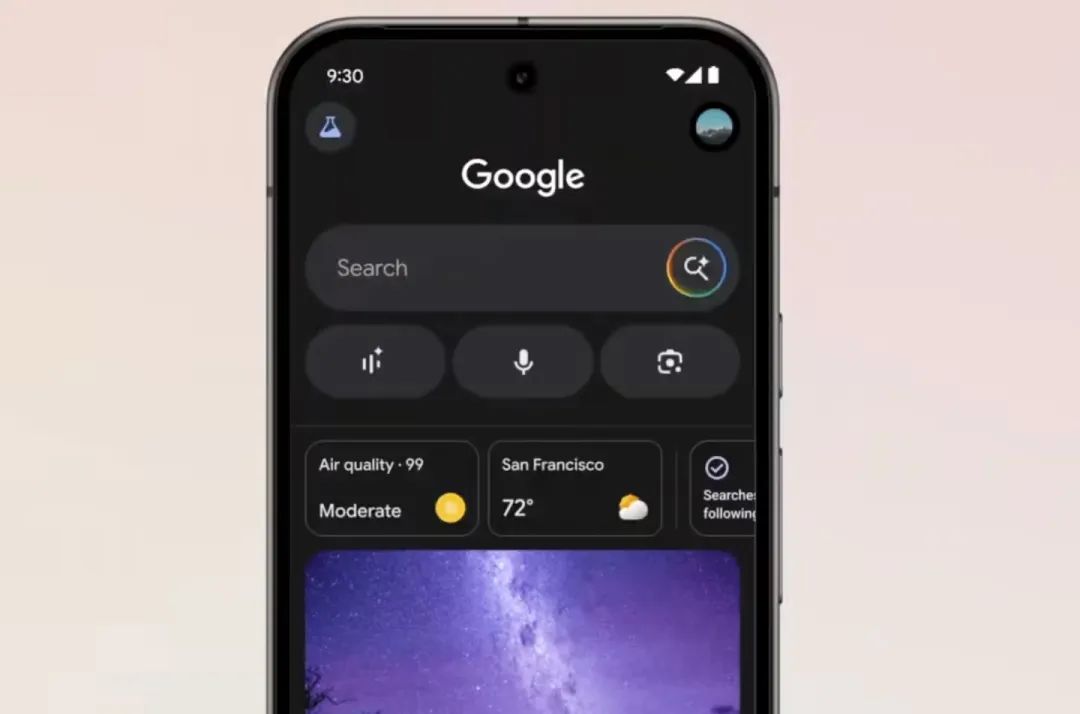

近日,谷歌向美国地区的AI Mode实验用户开放了这项革命性功能,个人觉得它标志着搜索引擎从关键词输入时代正式迈入自然语言对话时代。

⋯ ⋯

Search Live的体验与传统搜索截然不同,用户只需在谷歌应用中点击新增的“Live”图标,便可开始一场语音对话之旅。

这个看似简单的界面背后,是谷歌对移动搜索场景的深刻洞察。当在厨房双手沾满面粉,在健身房挥汗如雨,或是在行李箱前手忙脚乱整理衣物时,语音成为最自然的交互方式。

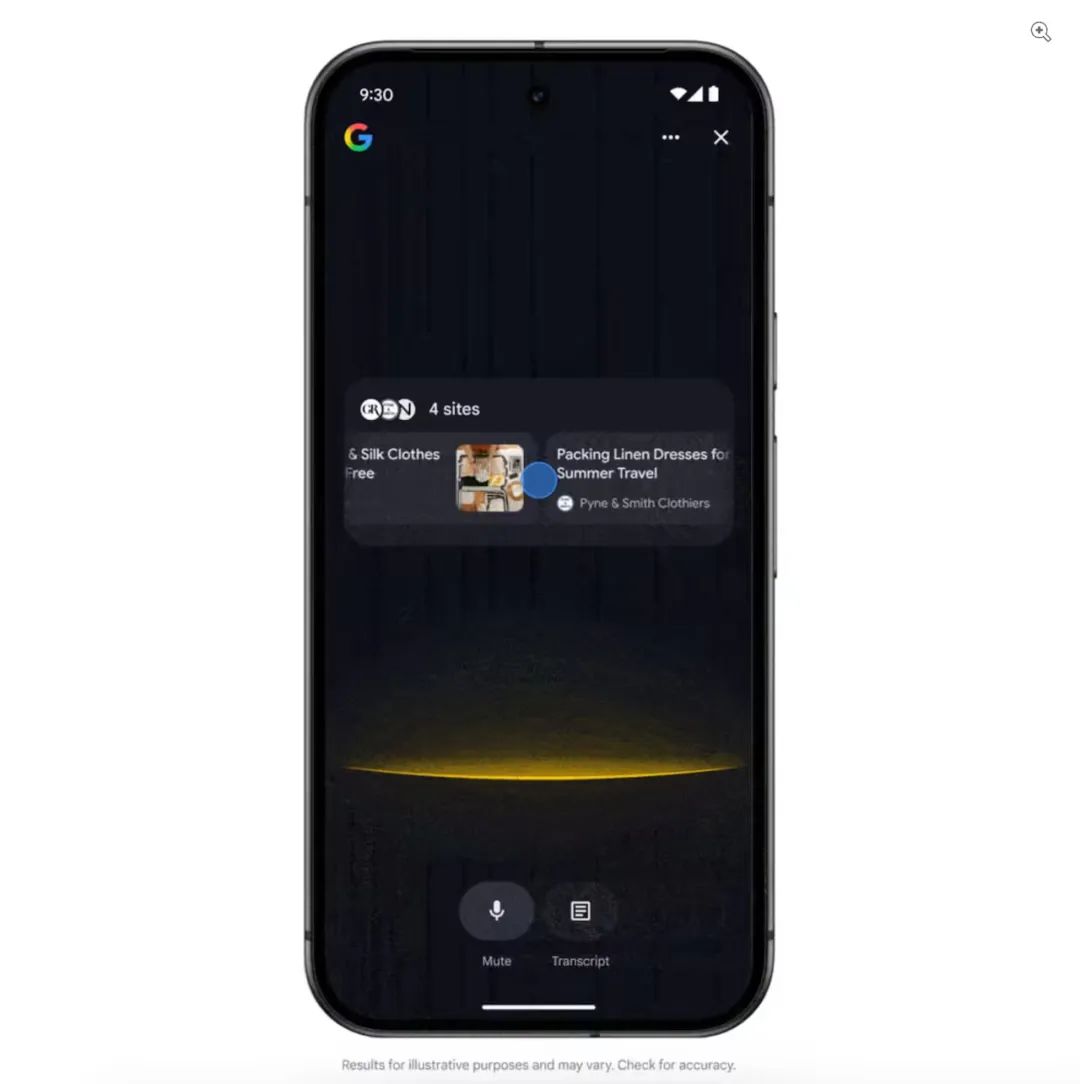

与过去的单次语音指令不同,Search Live的核心突破在于其连续对话能力。它能理解上下文,允许用户基于前一个回答进行追问,形成真正的交流。

谷歌产品团队在官方介绍中举了个典型例子:用户先问“周末短途旅行打包技巧”,得到回答后接着问“如果目的地下雨怎么办”,系统能准确理解这是在继续讨论旅行准备。

它的多任务处理能力,令人印象深刻。当用户切换至地图查看路线或打开邮箱回复工作邮件时,Search Live的对话仍在后台持续进行。

整个过程中,彻底解放了用户的注意力,使搜索体验从“主动操作”转变为“被动获取”。

⋯ ⋯

支撑这一流畅体验的,是谷歌多年积累的多重技术突破融合能力。Search Live并非单一技术创新,而是多项前沿技术深度整合。

核心引擎采用了定制版Gemini模型,也是谷歌专为语音交互优化的AI系统。与传统语音助手不同,这个模型继承了谷歌搜索的高可靠性和信息质量。

谷歌工程师曾透露:“我们的定制模型建立在搜索领域顶尖的质量和信息体系上,因此无论您在何处、以何种方式提问,都能获得可靠、有用的回答。”

Search Live还应用了一项名为query fan-out创新技术,它能将用户的一个语音问题拆解为多个相关查询,从网络上获取更广泛的内容。

谷歌用户问“如何保养亚麻衣服”时,系统不仅寻找直接答案,还会自动搜集去皱技巧、清洗建议、存放方法等关联信息,为后续对话做铺垫。

而Project Astra的实时语音处理技术,解决了对话流畅性的关键挑战。它让AI能够处理复杂的语音输入,生成自然、连贯的回答,消除了传统语音助手令人沮丧的延迟感。

⋯ ⋯

Search Live的推出远不止是一项功能更新,它会引发搜索引擎生态链的重塑。搜索行为从关键词输入变为自然对话,整个行业规则都将改变。

用户习惯也将经历重大转变,语音搜索的便捷性将推动更多场景下的“免提”操作,尤其是在驾驶、旅行或家务等多任务场景中。搜索不再是一个需要停下手中事务专门进行的“仪式”,而是融入生活背景的持续存在。

对内容创作者和营销人员而言,变革带来的冲击更为直接。当用户开始以“如果…怎么办”这样的自然句式追问时,传统的SEO策略将面临失效。

内容优化需要转向长尾问题和对话逻辑,网站需要预测用户可能的追问路径,提供结构化的知识网络而非孤立的关键词页面。

更微妙的影响在于信息获取方式的转变,用户听到语音回答的同时也会看到屏幕上的相关链接,听觉结合视觉的双通道体验也会改变人们对信息来源的信任度。

谷歌在演示中特意强调“每次回答都附带相关网页链接”,这既是对内容提供者的尊重,也是对信息透明度的承诺。

⋯ ⋯

我认为,科技巨头激烈角逐的AI语音助手领域,Search Live 此刻推出是谷歌公司攻守兼备的战略棋之一。

(一)OpenAI去年推出ChatGPT的Advanced Voice Mode,Anthropic在今年5月为Claude应用添加语音功能,苹果也在开发LLM Siri。这个时候,谷歌需要一款深度整合到核心产品的语音方案。

(二)Search Live的最大优势在于原生集成性,它不是独立App,不是浏览器插件,而是直接融入全球数十亿用户每天使用的搜索引擎。无缝整合让用户无需学习新工具,就能将熟悉的搜索体验自然升级为语音对话。

(三)谷歌的发布策略也颇具深意,选择通过Labs实验功能向早期用户开放。这既控制了初期风险,又创造了稀缺感。

谷歌采用渐进式创新策略,先推出纯语音版本,几个月后再加入视觉功能,让市场逐步适应变革。

⋯ ⋯

即将到来的摄像头整合将完成Search Live的最后一块拼图,届时用户将能“展示给搜索看正在看的东西”。比如拿着一件衣服问“这种面料怎么清洗”,或对着冰箱问“用这些食材能做什么菜”。

视觉结合语音的多模态搜索体验,将彻底模糊搜索引擎与AI助手的界限。

传统搜索是具有工具性的,用户有明确需求,输入关键词,获取信息后离开。而对话式搜索是关系性的,用户与搜索引擎建立起持续的交流关系,搜索成为一位随时待命的“懂很多的朋友”。

谷歌在官方博客中描绘了这一愿景:“让搜索变身为语音导览式聊天助手,不再只是单方面查资料,而是可以真正对话。”

交互界面也将随之消失,用户直接通过自然语言就能获得精准答案,不再需要思考如何组织关键词,搜索框这一存在了二十五年的互联网标志性元素也将逐渐淡化。

技术伦理专家提醒道:“当搜索引擎开始像人类一样与我们对话,我们可能不自觉地赋予它超过其能力的信任。保持对信息来源的批判性思考将比以往任何时候都重要。”

⋯ ⋯

手机屏幕熄灭,加州那位用户已经将叠好的亚麻裙放入行李箱。她不需要记住任何技巧,因为知道下次需要时只需开口再问。厨房里,另一位用户边切菜边问:“西兰花怎么做好吃?”语音回答响起时,她的手从未离开砧板。

谷歌对于人工智能的理解是深刻的,也是通透的。未来这项能力加入摄像头功能之后,搜索体验的终极形态已清晰可见:举起手机对准生锈的水龙头,问“怎么修理这个”,谷歌将同时理解你看到的图像和听到的问题,给出针对性答案。

搜索引擎与用户的交互方式正在发生根本性变革,因为每一次对话都是搜索引擎理解人类意图的一次训练。终有一天,当人们在街头驻足,对着空气说“附近哪有好的咖啡馆”时,谷歌已在耳边低语答案。

(文:陳寳)