OpenAI 终于发布新模型了。

但不是 GPT-5。

而是,o3-pro。

严格来说,o3-pro 不是完全“新”的模型,更像是 o3 的高阶形态。

一个专为 ChatGPT Pro 用户准备的高算力版本,也正式接替了上一代的 o1-pro。

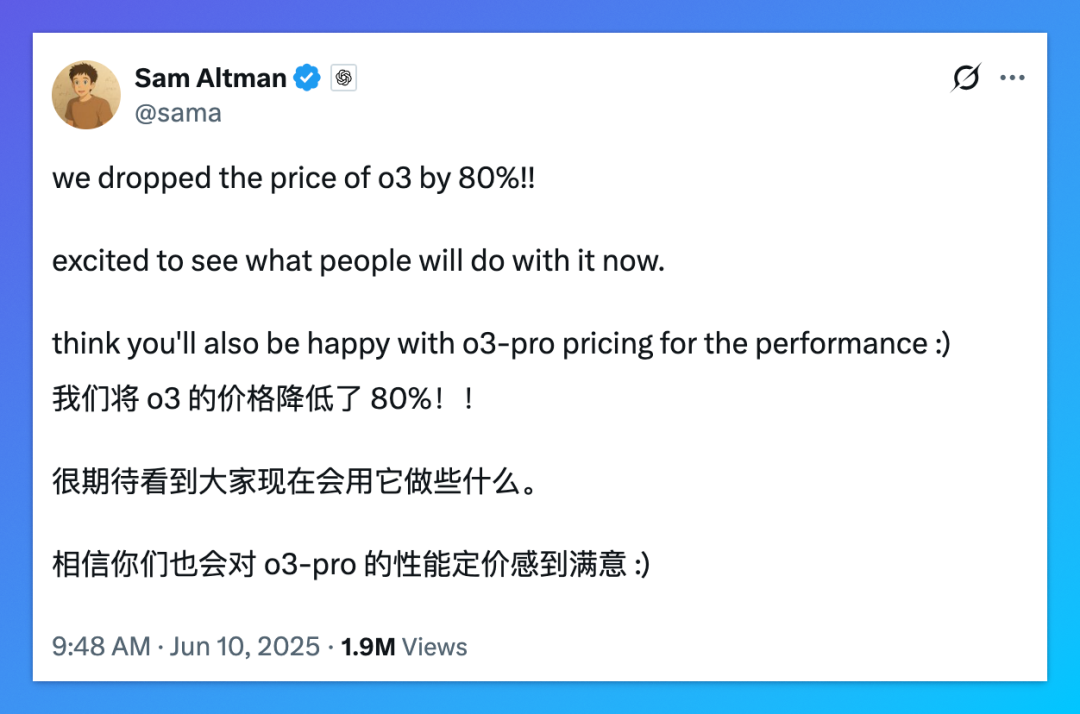

与此同时,OpenAI 还宣布:o3 模型的 API 定价,直接下调了 80%。

而这,只是 OpenAI 一天内丢出的几颗重磅炸弹之一。

从 API “骨折”级降价,到 Pro 模型全新发布;从联手 Google Cloud 到全球服务宕机,这家公司正在用一种“高频快跑”的节奏,把整个 AI 行业拖入新一轮加速带。

01|o3 降价 80%,高端推理突然“白菜价”

我们先说价格。

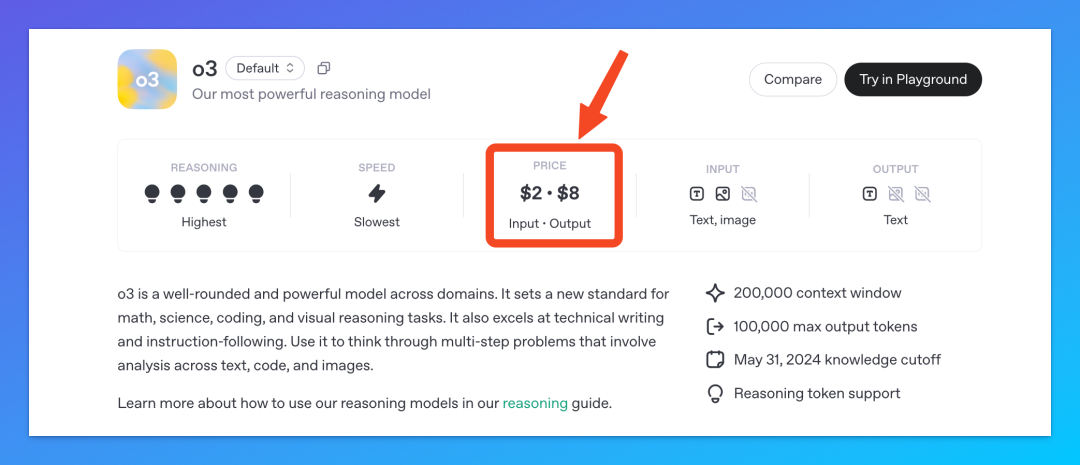

OpenAI 直接把 o3 的 API 单价,从输入 10 美元/百万 tokens、输入 40 美元/百万 tokens,砍到了 2 美元和 8 美元。

更狠的是:缓存输入只要 0.5 美元/百万 tokens。

官方没多解释,只有 CEO Sam Altman 在 X 上一句看似轻描淡写的话:“we dropped the price of o3 by 80%!! excited to see what people will do with it now.”

最新的价格已在 OpenAI 开发者平台的模型介绍里更新。

这次的降价明显意味着,OpenAI 已经从“卷性能”,转到了“性价比”这条赛道。

毕竟,高达 80% 的降幅并不多见。

更不用说,o3 可是 OpenAI 在 o3-pro 发布前最强的模型,是在 LiveBench 排行榜长期霸榜的存在,总评分超过了 Claude 4 Opus 和 Gemini 2.5 Pro。

02|o3-pro 正式上线,工具全开,取代 o1-pro

几小时后,OpenAI 又突然宣布:

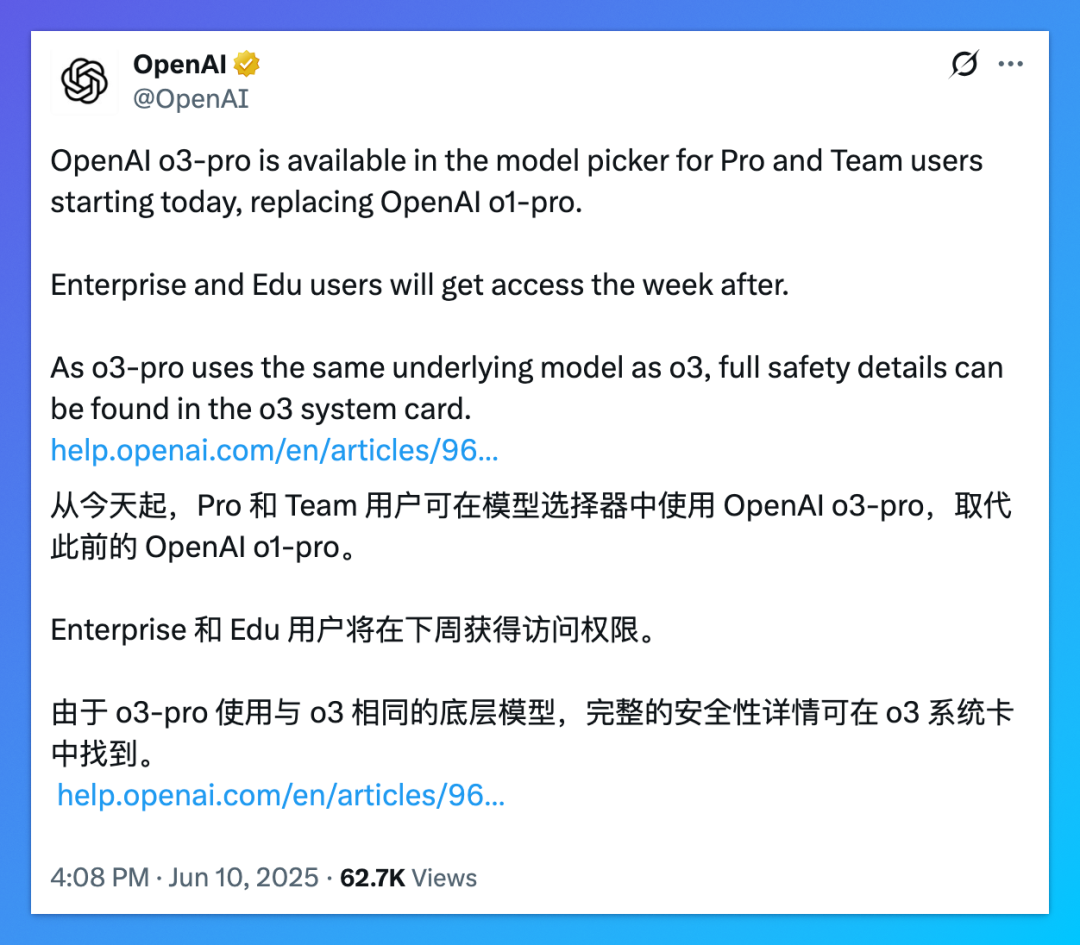

o3-pro模型正式面向 ChatGPT Pro 和 API 用户开放,全面替代o1-pro。

这个 o3-pro 并不是模型的常规升级 —— 它和 o3 用的是同一底层模型,但多了两个关键词:性能调优和工具调用全开。

用大白话说就是:它能联网搜索、读文件、看图、运行 Python 代码,还自带记忆功能。

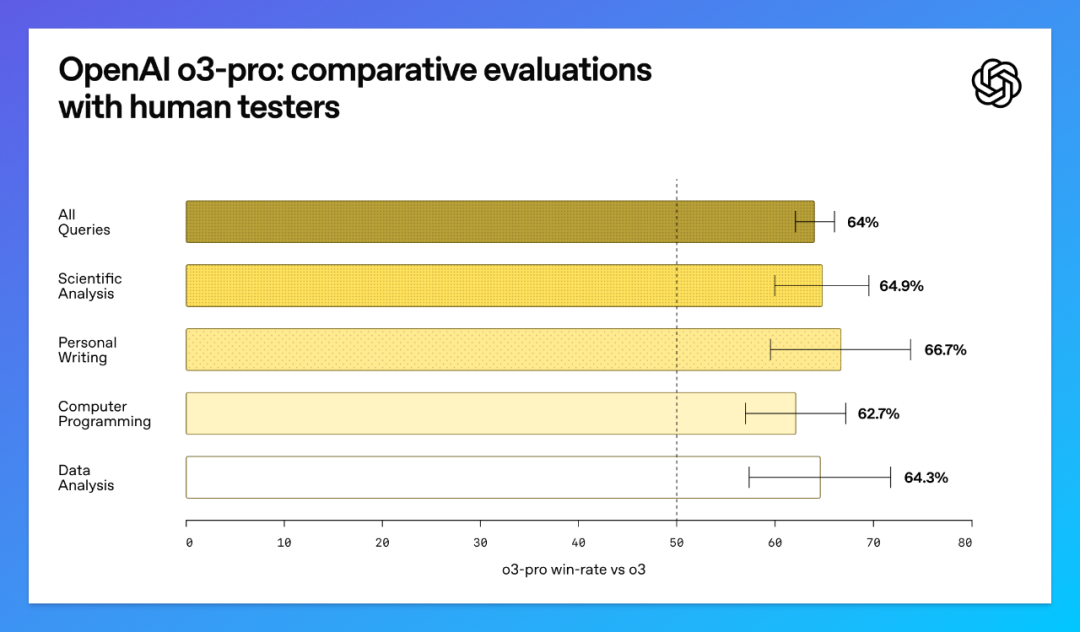

OpenAI 的专家评测表示:o3-pro 在科学、教育、编程、写作这些场景下,稳定性和准确率全面压过 o3。

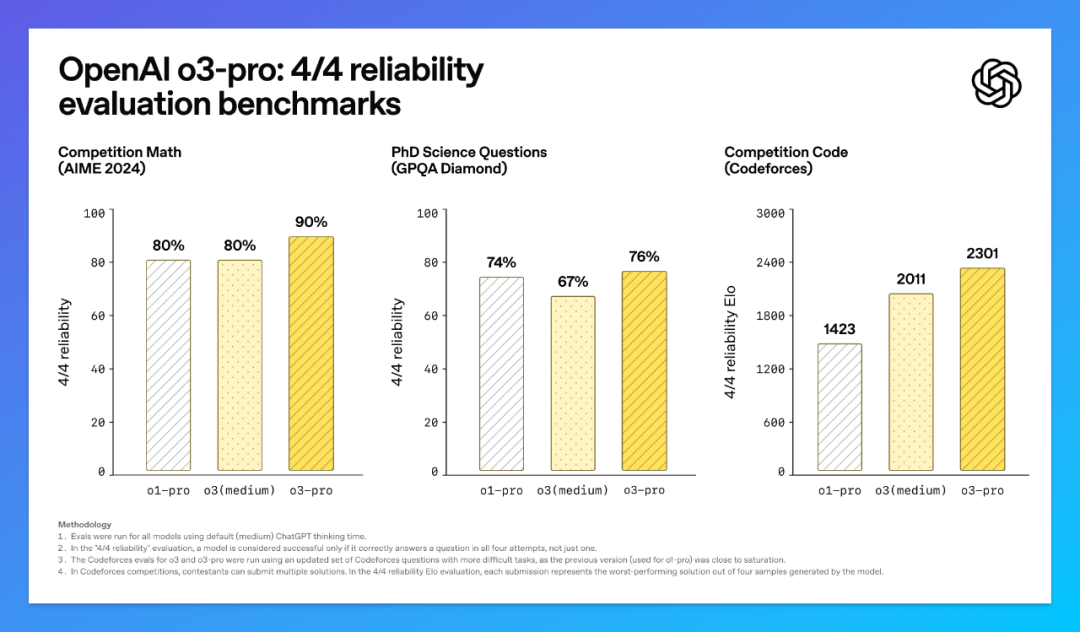

基准测试中,o3-pro 比 o1-pro 强的不是一点半点,尤其是编程方面。

在“4/4 可靠性”评估(连续答对四次才算合格,排除运气、蒙对的因素)中,o3-pro 的优势则更大。

简单总结:o3-pro 是 OpenAI 当前最靠谱、最全能的高端模型,没有之一。

值得注意的是,除了 ChatGPT Pro 用户外,OpenAI 还破天荒的第一次将对 ChatGPT Team、企业、教育用户开放 o3-pro 模型的使用权限。

开通了这些订阅计划的小可爱,只需坐等推送就可以。

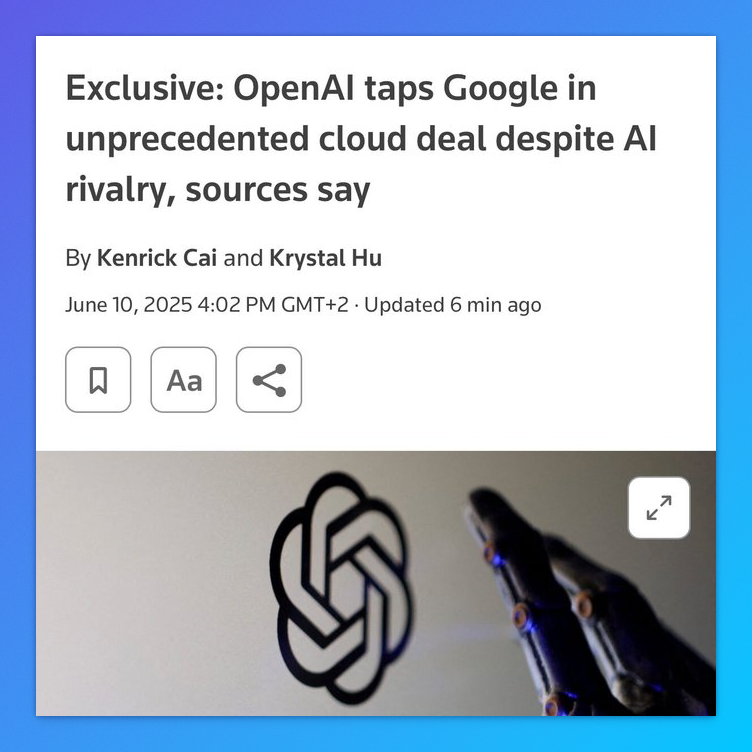

03|联手 Google Cloud:是对手也是供应商

那么,OpenAI 哪来的底气在同一天宣布大幅调整 o3 的价格,又同时发布 o3-pro?

实际上,OpenAI 早在 5 月份就和谷歌的 Google Cloud 签了协议,开放使用对方的 TPU 计算资源来训练和推理。

也就是说,OpenAI 现在一边用微软 Azure 运行 GPT-4o,一边用 Google TPU 跑 o3/o3-pro。

“两条腿走路”,怪不得敢降价,并且向其他订阅的用户开放 o3-pro。

这背后反映出一个现实:AI 模型卷到这个量级,拼的不只是参数和提示词,而是 底层算力供应链。

谁能拿到稳定、高效、便宜的芯片,谁就能降价、拉新、抢用户。

OpenAI 这波“左右逢源”,一方面缓解对 Azure 的依赖,另一方面还让 Alphabet 股价直接涨了 2.1%。

04|服务宕机 10 小时,AI 不是万能的

当然,也不是没有代价。

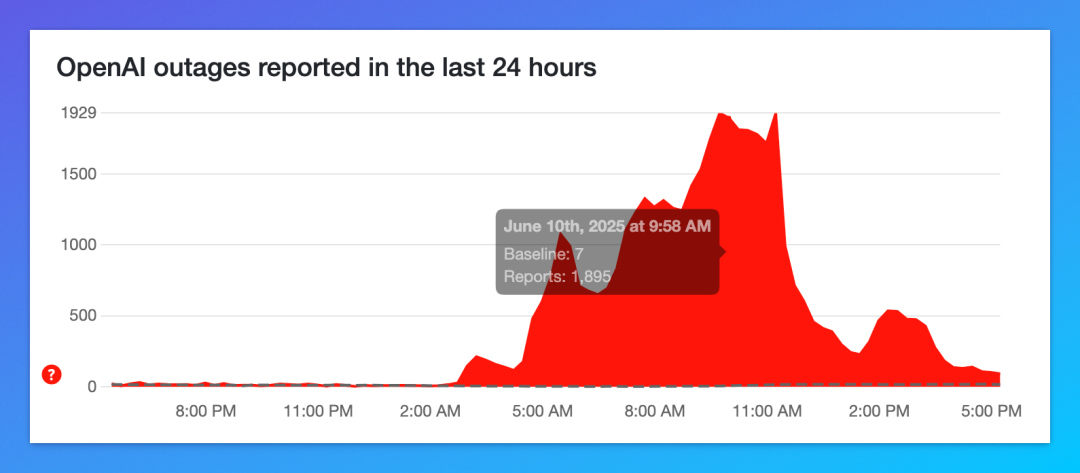

就在宣布新模型上线前,全球的 ChatGPT、Sora、API 服务就陆续挂了。

从凌晨开始,DownDetector 上的故障报告一路飙升,最多时每分钟 1700+ 报告,很多人直接打不开 ChatGPT,API 报错率高得吓人。

OpenAI 官方连续更新状态页,从“正在调查”到“已定位根因”,再到“缓解措施实施中”,前前后后持续了超过 10 小时。

这场“AI 停电”,让不少创业团队临时切换到 Claude、Gemini、DeepSeek 撑场。

也算是一次提醒:

当你把所有流程都交给 AI 运行时,AI 一旦停摆,业务也真跟着断电了。

结语

我们把今天这四条新闻放在一起看,会发现一个共振逻辑:

-

降价,是成本策略

-

o3-pro上线,是产品节奏 -

联合 Google,是算力布局 -

宕机,是暴露的问题

OpenAI 正在用一个非常明确的节奏,把“成本-性能-工具”三件事串起来做闭环。

它的逻辑很清楚:如果我能提供更强的模型、更低的价格、更全的工具,那你凭什么用别家的?

但这个闭环,有一个前提 —— 基础设施必须跟得上。

所以这盘棋,才需要 Google Cloud。

我是木易,一个专注AI领域的技术产品经理,国内Top2本科+美国Top10 CS硕士。

相信AI是普通人的“外挂”,致力于分享AI全维度知识。这里有最新的AI科普、工具测评、效率秘籍与行业洞察。

欢迎关注“AI信息Gap”,用AI为你的未来加速。

(文:AI信息Gap)