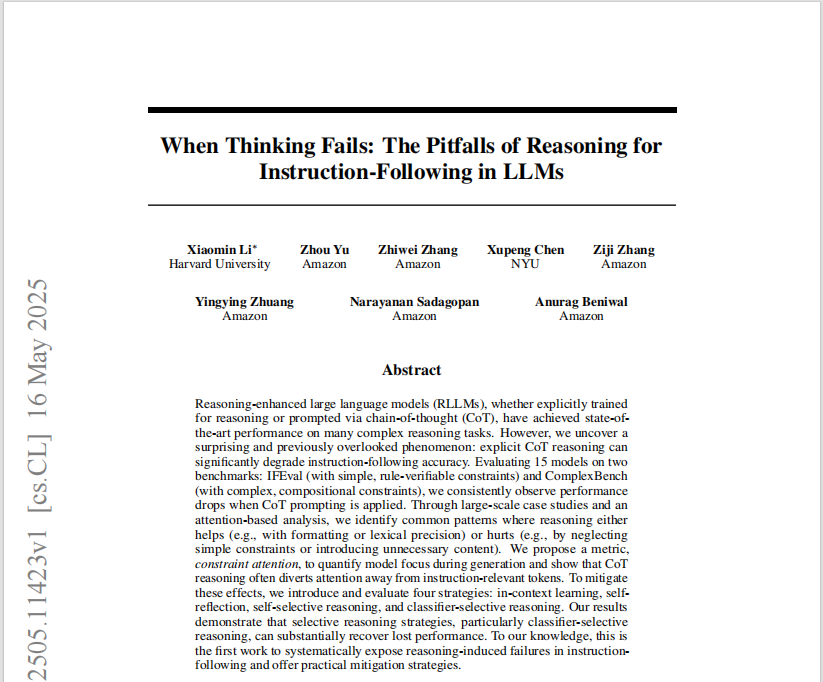

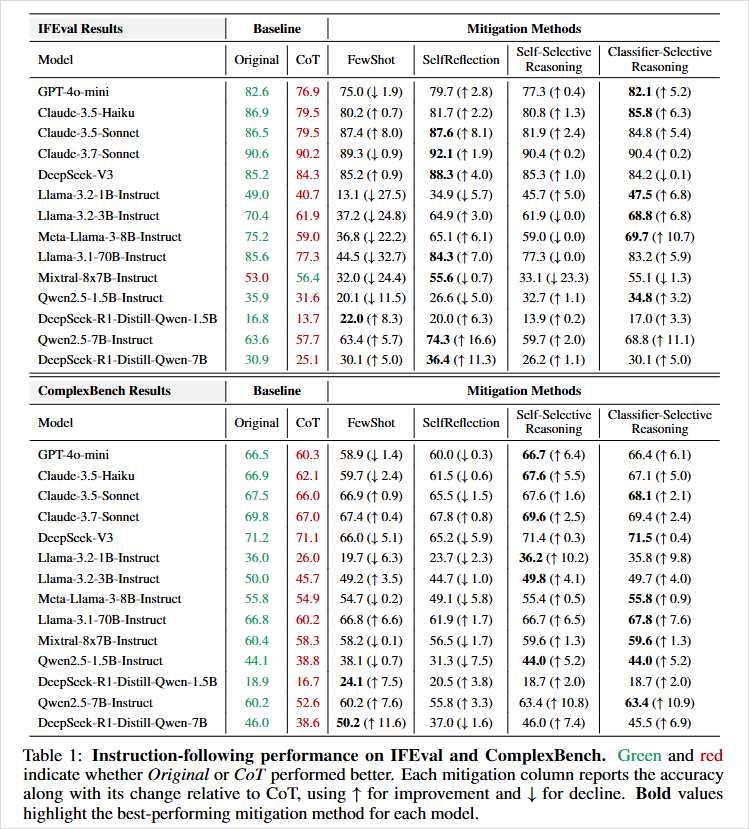

第一组叫IFEval,一个标准的执行类任务测试集,每个任务都非常简单。

比如“写400字以上”“必须提到AI三次”“输出格式必须是JSON”“句末不能有标点”等等。

所有的任务都有明确的可验证标准,要么做对要么做错,没有模糊地带。

第二组叫ComplexBench,这就更有趣了,是那种“多约束、逻辑组合、顺序嵌套”的复杂指令,比如“先做A中的三选一,再加上B的格式要求,最后加上C的语言限制”。

听起来好像推理模型在这种任务上应该更有优势?毕竟这不是随便一两句话就能糊弄过去的内容。

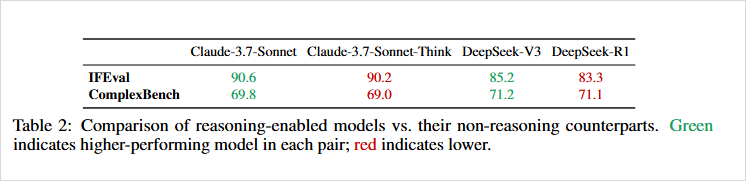

然而,论文的结论惊人又统一:绝大多数模型在使用CoT推理后,执行准确率反而下降了。而且,下降得还不轻。

他们发现,当模型用了思维链条之后,它确实变聪明了,比如能更好地遵守格式、注意字数、精确用词,像是“必须用15个大写字母”这种题,靠CoT反而更稳。

但,它也变得神经质了。

它开始自作主张,觉得自己懂了任务的深层含义,于是它会擅自删掉、修改,甚至加上有帮助的解释。

论文里提到很多模型会在“只允许输出法语”的题目中,善意地补上一句“这是‘Bonjour’的英文翻译”,在“只能输出引号内容”的任务里,自动补充前情摘要。

它太想表现自己了,太想证明我真的理解你了,于是它忘了本该严格遵守的指令。这就是它学会推理之后的副作用。

第一种,是“Few-Shot少样本示例”。

给模型提前看几个做对的例子。

效果一般般,问题在于输入太长,而且示例选自已有模型,容易有偏。

第二种,是“Self-Reflection 自我反思”。

模型第一次输出之后,再自己复查一遍,“你刚才做对了吗?”然后再决定是否修改。

这招对大模型效果很好,因为它们确实能自省,但小模型效果惨不忍睹,因为它们智力不够,就像个不知错的小孩,越反思越错。

第三种,是“Self-Selective Reasoning”。让模型自己判断这个任务是否需要推理。

结果是:它召回率很高,基本上只要推理有用它都能猜出来,但精确度很低,一言不合就开始推理,哪怕你只是让它改个词。

第四种是最有效的,“Classifier-Selective Reasoning”。

直接训练一个小模型作为判断器,来帮主模型判断某个任务是否该启用CoT。

效果显著,在两个测试集上几乎都能恢复失去的准确率,甚至有些模型比原始还高。

缺点就是每个主模型都要单独训练一个判断器,成本太高。。。

这篇论文大概就是这样,对我自己非常有帮助,我看的论文不多,这篇是我自己看的,我认为对“CoT推理在执行任务中的潜在副作用”这个话题,比较完整的研究之一。

同时,我也想聊聊,这篇论文对我的启示。

我们总觉得,聪明,就意味着知道得多、分析得细、每个变量都不放过.

但事实上,真正强大的智能,从来都不是把所有细节一股脑地扫过一遍,而是,知道在哪一秒钟,把注意力放在哪个点上。

比如我们小时候考试,很多人因为太想得高分,最后反而在最简单的题上丢分。

成年人做选择,明明已经知道该怎么做了,却非得做个SWOT分析表、拉个10页PPT讨论,最后被复杂困死。

公司做决策,明明方向明确,却因为分析得太多、风险评估太细,最后团队谁也不敢拍板,错过风口。

AI其实跟人很像。

上面很多CoT的验证,还有Constraint Attention,其实也证明了,大模型不是笨,而是思维资源错配了。

你让它完成任务,它却跑去想着“怎么把这段话说得更优雅”、“这句话需不需要加个逻辑转折”、“前后是不是够自然”。

你让它干活,它在脑子里脑补了几万种情节。

但是,真正牛逼的智能,其实应该是聚焦。

比如你叫一个人帮你看一下一份报告有没有错,一个低阶执行者可能就只会一句句校对标点。

而一个高阶智能,可能会反过来先问你,“你重点是要我看错字,还是看数据逻辑?”

你说清楚重点,他就能把80%的注意力锁死在正确位置。

而如果他啥都想看一点,最后很可能错得最离谱。

我们真正需要的,可能,是对“该想什么”有判断能力的智能。

就像我们人类那些最令人敬畏的时刻,不是我们知道多少,而是我们能瞬间把注意力聚焦在关键节点上。

危机时刻,考场钟响,夜深人静一个念头浮上心头的时候,你知道的,你不能全看,你只能看准。

那个“看准”,在我看来,可能就是智能真正的体现。

这一点,看似简单,却足够让AI从“聪明”,变成“智能”。

这就是我读完论文之后,真正想跟大家分享的东西。

我们不缺思考的能力,我们缺的,是思考的分寸感。

注意力,不是撒网。

而是出击。

(文:数字生命卡兹克)