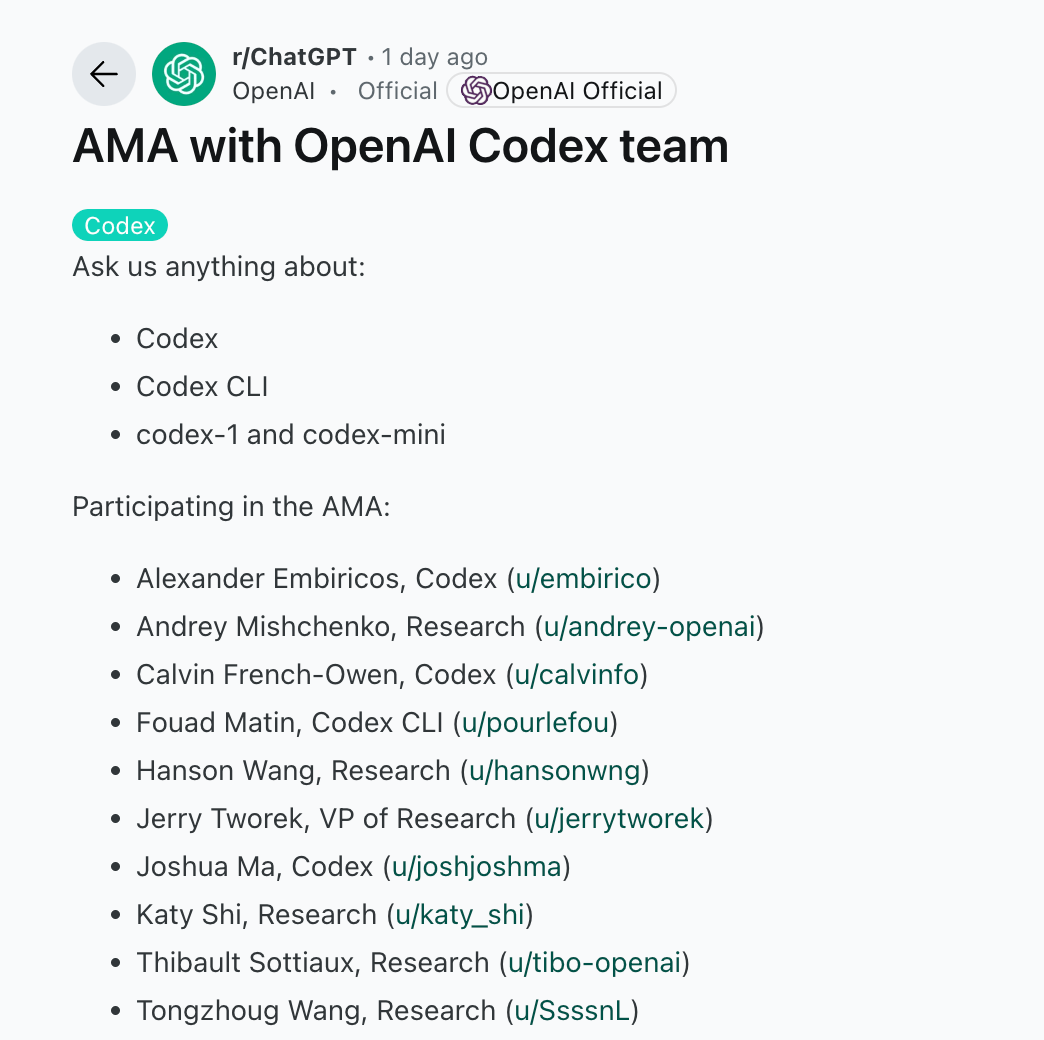

Codex发布后,OpenAI Codex在Reddit举行了AMA(Ask Me Anything)活动

在这场 1 小时的 AMA 中,Codex 核心研发和研究负责人围绕 :为什么先推云端代理、CLI 为何用 TypeScript、未来多语言绑定与 IDE 插件、GPT-5 与 Operator 的整合、定价与 API 计划、安全沙箱、最佳实践 等问题给出了清晰路线图:

Codex-1 目前是「云端沙箱 + ChatGPT 原生入口」的研究预览,面向大仓库 + 测试驱动工作流效果最佳;

CLI 走开源 + API 计费,本体将在 Plus/Pro 长期集成并提供“弹性”付费;

短期不会给代理外网,但已支持 –approval-mode full-auto;

他们希望 10 年内实现“按规格即可落地可靠软件”,并把 Codex、Operator、Deep Research、Memory 等工具融合为一套完整代理体系

详细 Q&A

Codex产品定位与长期愿景

1 .为什么先做云端

本地 CLI 因单机算力与线程受限,只适合轻量任务;云端可并行跑多个容器并隔离风险,是先发形态

10 年愿景:给出“合理规格说明”即可在可观时间内得到可靠软件;云端并行 + 沙箱是实现路径。

2 .GPT-5 与 Codex、Operator 等工具是什么关系?

GPT-5 是下一代“统合”模型,目标是把 Codex、Operator、Deep Research、Memory 等工具融合成“一体化桌面代理”,真正替用户在电脑上执行任务

CLI 设计与多语言计划

之所以选 TypeScript,是作者 @pourlefou 最熟悉且擅长做终端 UI;很快将提供高性能引擎并做多语言绑定

Codex使用场景与最佳实践

最擅长:大仓库 + 明确单元测试;拆小任务优于一句“帮我造一个 App”

Ask → Code 工作流:先用 Ask Mode 解析设计文档自动拆任务,再交给 Code Mode;AGENTS.md 里写测试/格式化/提交模板可显著提升成功率

Ask vs Code 边界:当前由用户显式切换,两种模式各跑独立容器,后续将探索带“记忆”的自适应流程并支持多 repo

任务上限:ChatGPT 版默认允许单任务跑满一小时,以保障解决复杂问题

安全模型与联网策略

代理获得运行时后即断网,只用本地 repo 与预加载文件,确保可审计输出;未来会逐步开放“安全联网”

CLI 已支持 –approval-mode full-auto,但仍处于云端沙箱中——放权与安全会一起前进

接入方式与计费

CLI:开源,需要正常 API 计费;不会因为你是 Pro 就免 token

ChatGPT 内的 Codex:

Pro/Team/Enterprise 用户两周内享“慷慨配额”;Codex 将长期集成 Plus/Pro,并提供灵活付费选项(不限量+按需)

正在面向 Pro 用户逐步灰度;移动端支持“在网页里用”,App 原生入口“很快上线”

API 与生态路线

Codex-1 目前仅适配 ChatGPT UI,不直接开放 API;团队正努力让代理能通过 API 调用,并支持更多 Git 托管与工作流工具

参考:

https://www.reddit.com/r/ChatGPT/comments/1ko3tp1/ama_with_openai_codex_team/

⭐

(文:AI寒武纪)