跳至内容

智东西5月13日报道,近日,英伟达AI总监兼杰出科学家、Project GR00T(人形机器人项目)与GEAR实验室联合负责人Jim Fan用17分钟时间,在红杉AI Ascent大会上分享了他对具身智能领域未来面临的核心挑战和对应解法。

Jim Fan认为,大语言模型已突破传统图灵测试,但机器人在物理世界的表现仍远未达到人类水平,数据是这一过程中的最大瓶颈。机器人需要的是物理交互的真实数据,而这些数据无法从网页抓取,只能靠人类手动采集,效率极低。

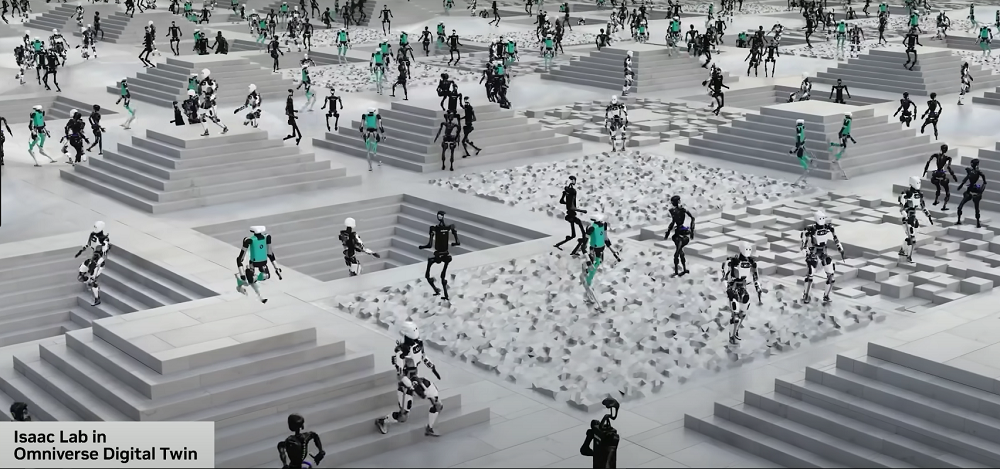

面对这一挑战,Jim Fan和英伟达团队希望在仿真世界中找寻解法。在超高速仿真打造的数字孪生中,机器人可在2小时内完成相当于现实世界10年的训练量,再将知识无缝迁移到物理世界。3D生成、纹理生成等生成式AI技术,则将进一步降低仿真训练对人工数据的依赖。

当视频生成模型构建的虚拟世界逐渐成型,机器人将能够在无限可能的“梦境空间”中训练,无需依赖人工建模,不仅成本极低,还通过提示词自由创造反事实的训练场景,进一步拓宽机器人的能力边界。

未来,世界模型与仿真技术的深度融合,将推动机器人技术进入“仿真2.0”时代,为具身智能发展提供源源不断的“核动力”。当机器人获得操控物理世界的能力,并最终演化为无处不在的“环境智能”时,人类突破“物理图灵测试”的临界点就将到来。

以下是Jim Fan今年5月在红杉AI Ascent大会上所发表演讲的完整编译(为提高可读性,智东西在不违背原意的前提下进行了一定的增删修改):

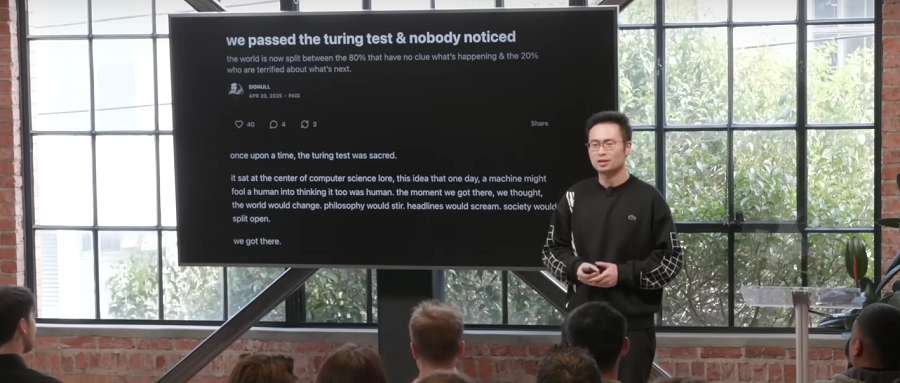

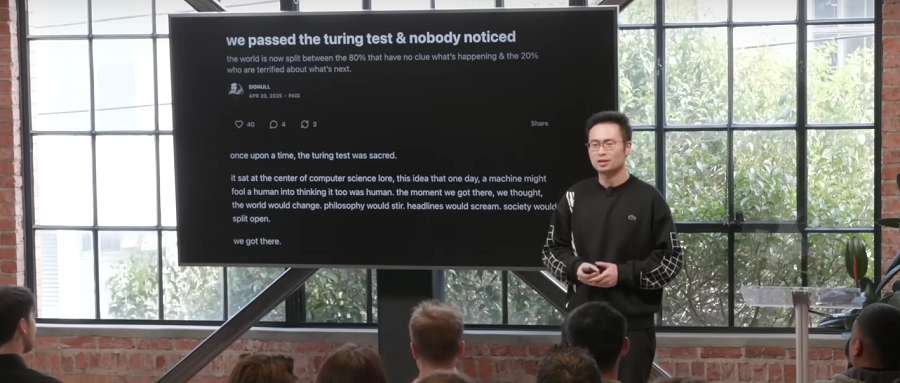

几天前,有一篇博客文章引起了我的注意。这篇文章说,我们通过了图灵测试,却无人在意。图灵测试曾经是计算机科学的圣杯,如果一台机器能让人无法通过对话分辨它是人还是机器,就算通过了测试。

现在,我们已经实现了这一目标,自然而然地就实现了。不过,当OpenAI o3-mini思考的时候多花了几秒钟,或者Claude无法调试代码时,人们还是一样会感到不满。

我们已经习惯于把每一个大语言模型领域的突破都当作是稀松平常的事情。说实话,在座的各位(AI业内人士)是最难取悦的。

今天,我想提出一个新的概念,叫做“物理图灵测试”。这个测试大概是这样的:假设你在周日晚上举办了一个黑客马拉松派对,家里一片狼藉。周一早上你想找人收拾残局,再准备顿烛光晚餐哄伴侣开心。当你回家时,如果无法判断这是人类还是机器人的劳动成果,这就算通过物理图灵测试了。

那么我们现在离这个目标还有多远?我们可以看几个例子。这台人形机器人看上去不太行,机器狗踩到香蕉皮就滑倒了,而这个做牛奶燕麦的机器人准确识别了牛奶,但其他都搞得一团糟。

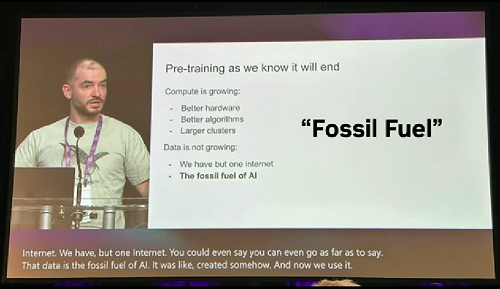

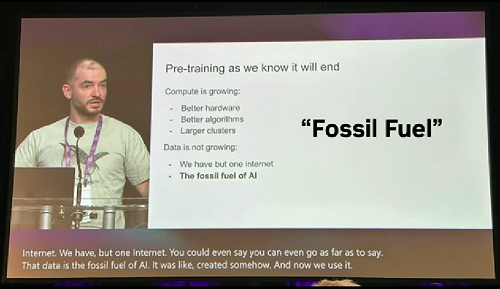

那么,为什么解决物理图灵测试如此困难呢?他们做大语言模型的研究人员很喜欢抱怨,最近Ilya把互联网称作是AI发展的“化石燃料”,而大语言模型预训练的数据要用光了。不过,只要和机器人研究者共度一天,你就会知道这些做大语言模型研究的科学家都被“宠坏了”。

研究机器人的学者根本没有所谓的“化石燃料”可用。在英伟达总部的这家小餐厅里,我们通过遥操作机器人收集数据。

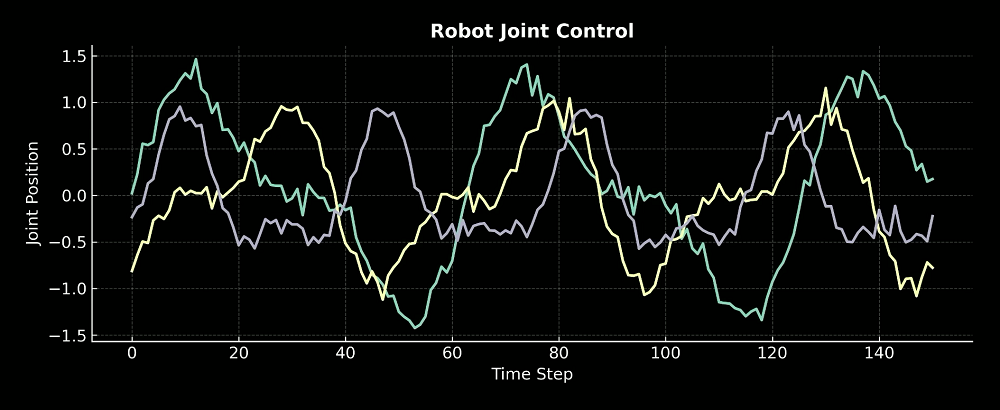

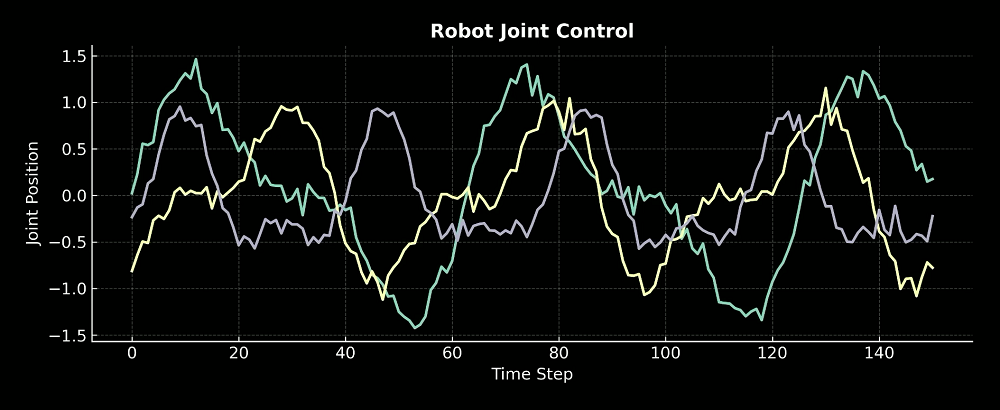

而数据是长这样的(下图)。这是机器人关节的控制信号,连续的数值,随着时间变化。从互联网上可找不到这种数据,维基百科里没有,YouTube里没有,Reddit里也没有。

我们必须亲自收集这些数据,需要使用一种非常复杂且很昂贵的方法,叫做遥操作。让一个人戴着一个VR头盔,这个头盔可以识别手部姿势,并传输到机器人上。通过这种方式,操作者可以教会机器人各种操作,比如从烤面包机中拿起一片面包,然后倒上蜂蜜。

这是一个非常缓慢和痛苦的过程,基本上不具备可拓展性。机器人训练烧掉的数据是“人类”,因为数据需要人类手工采集。更糟糕的是,每台机器人每天理论上最多也就训练24小时,而实际时间会更短。人会累,机器人可能比人还累。

那么,我们该如何突破这个瓶颈?机器人研究的“核动力”是什么?我们不能永远依赖“化石燃料”。答案在仿真世界。

我们可以脱离物理世界,然后在仿真世界中进行训练,甚至可以让机器人完成超人类的灵巧任务,比如转笔。这对我来说已经是超人的技能了,我不会转笔,而机器人至少在仿真世界中可以做得比我还好。

那么,我们如何训练灵巧手做这样一个复杂的任务呢?关键有两点。

第一点是,必须以比现实快1万倍的速度进行仿真。这意味着我们需要在单块GPU上并行运行1万个物理仿真环境。

第二点是,1万个环境的副本不能完全相同,必须改变一些参数,如重力、摩擦和重量,我们称之为域随机化。

这便是所谓的仿真原则(Simulation Principle)。这一原则为什么有效?想象一下,如果一个神经网络能够控制机器人在一百万个不同的世界中解决问题,那么它就很有可能解决第一百万零一个世界中的问题,即我们的物理现实。换句话说,我们的物理世界只是这种训练所涵盖的各种可能性中的一种情况。

我们该如何应用这一原则呢?我们可以建立一个数字孪生(Digital Twin),即机器人和世界的1:1副本。在仿真世界中训练,然后在真实世界里测试。仿真世界的知识可以直接迁移,无需调整。

这是我们尝试过的最让人印象深刻的案例。我们在仿真世界中训练机器人在瑜伽球上行走,之后将其迁移到真实世界中。可以看到我们的研究员正在真实世界溜机器狗,画面看上去超级奇怪,就像《黑镜》的一集。我们的一位研究员还尝试了让真正的狗在瑜伽球上行走,狗是做不到的。

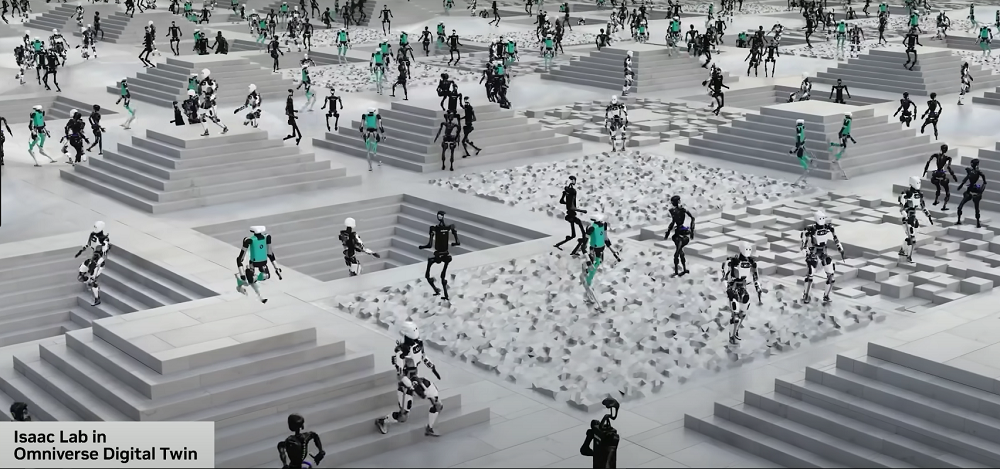

接下来,我们也可以将其应用于更复杂的机器人,如人形机器人。画面中的人形机器人在学习行走,它们仅用了2小时的仿真时间,就完成了真实世界里耗时10年才能完成的训练,之后我们可以将这些技能迁移到现实世界。而仿真的效果并不取决于本体。只要有机器人模型,进行仿真训练,就可以行走。

除了让机器人学会行走之外,我们还能做些什么呢?所以,正如我们控制我们的身体一样,你可以跟踪任何你想要的姿势,跟踪关键点,跟随任意的速度向量。这被称为人形机器人的全身控制问题。

这一问题非常困难,但我们可以在1万个并行运行的仿真中进行训练,然后直接将其转移到真实机器人身上,无需任何微调。

在英伟达的实验室,我们已经进行了很多训练,可以看到机器人所做的运动是十分复杂的。可以模仿人类的敏捷动作,同时保持平衡。150万个参数的神经网络就可以准确地捕捉人体的下意识动作。

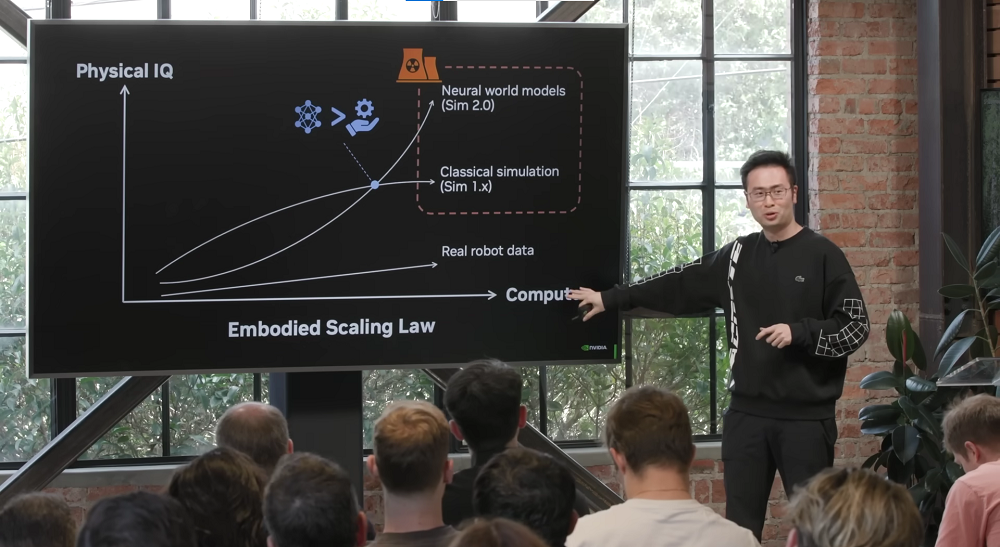

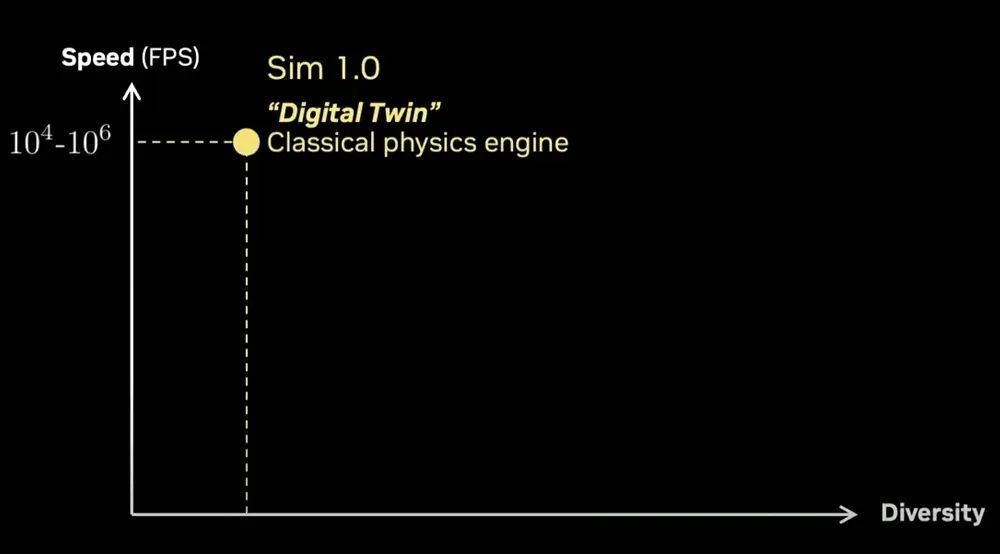

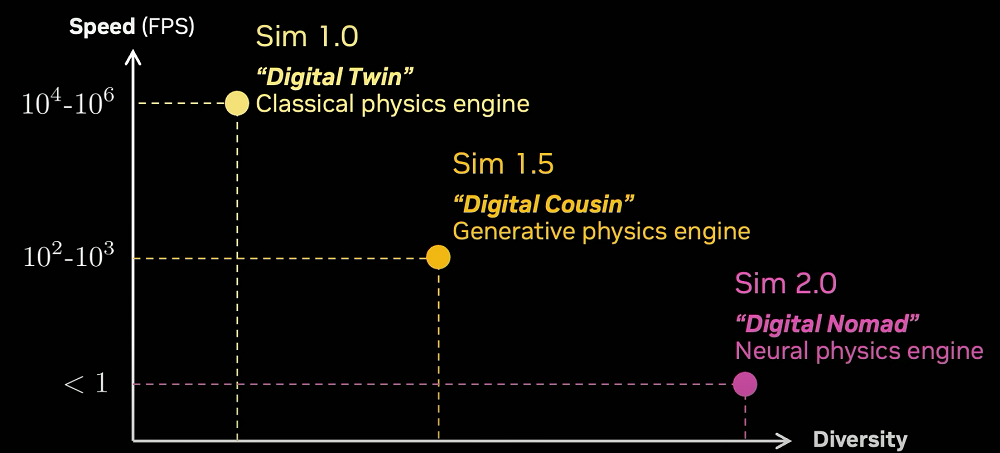

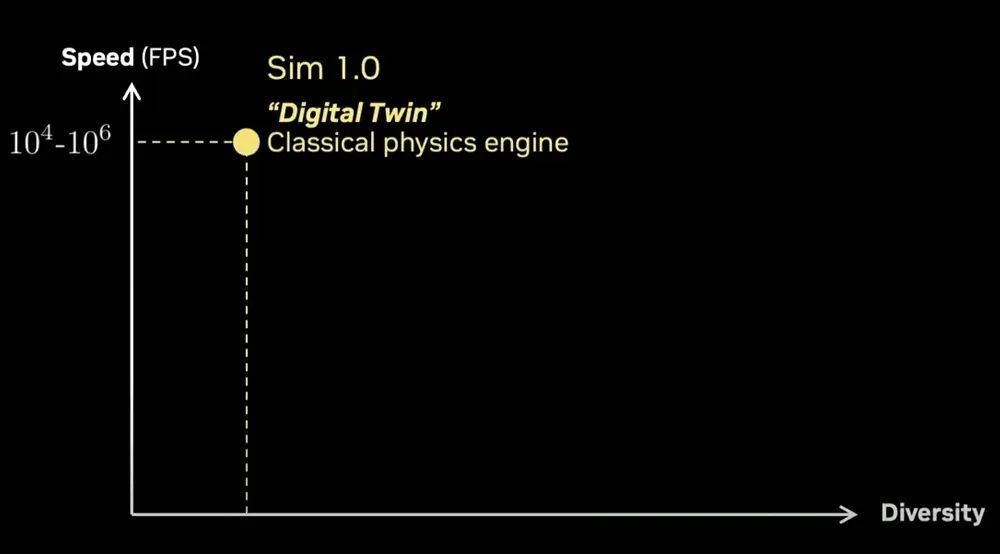

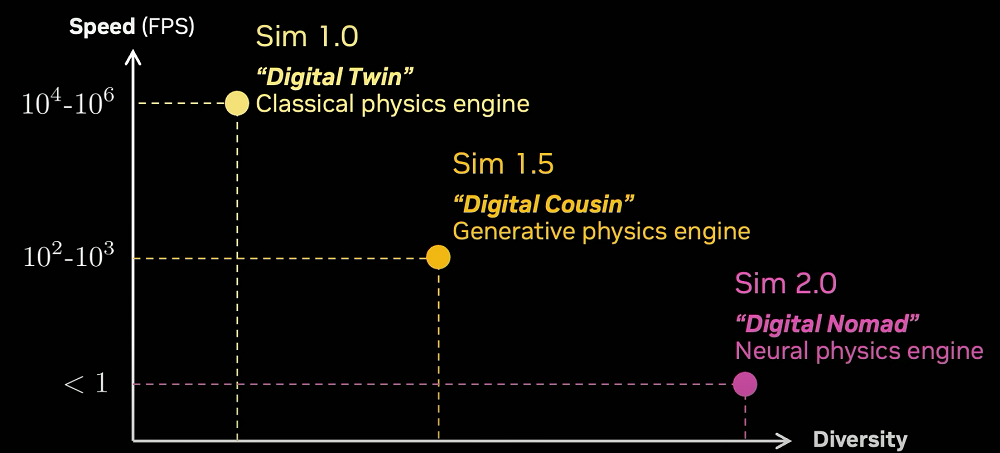

在这张体现速度与仿真多样性的图表,上述仿真可以被称为“仿真1.0”,即数字孪生范式,是一个经典的矢量化物理引擎,运行速度可以达到每秒1万帧到100万帧。

但问题是,这一仿真的实现,必须依赖数字孪生。需要人工建模一个机器人,建立一个环境,这是非常繁琐的工作,耗时耗力。想象一下,如果我们能将仿真中的部分事物用生成的方式呈现呢?

下图中所有的3D资产都是由3D生成模型生成的。纹理是Stable Diffusion生成的,或者也可以使用任意的扩散模型。布局是通过提示词指导大模型撰写XML文件生成的。我们将这些元素组合起来,建立了一个叫做RoboCasa的框架。

RoboCasa是一个大规模仿真平台,用于日常任务的仿真。在这个系统中,除了机器人本体之外,所有视觉元素都是由AI生成的。平台支持灵活的场景组合,虽然其底层仍依赖于传统物理引擎,但已经能够支持大量复杂任务的训练。

操作者可以在虚拟环境中进行遥操作。与传统方式不同,这次操作完全在仿真环境中进行。系统可以回放仿真轨迹,并利用硬件加速的射线追踪技术来呈现逼真的光影效果,甚至允许实时调整运动轨迹。

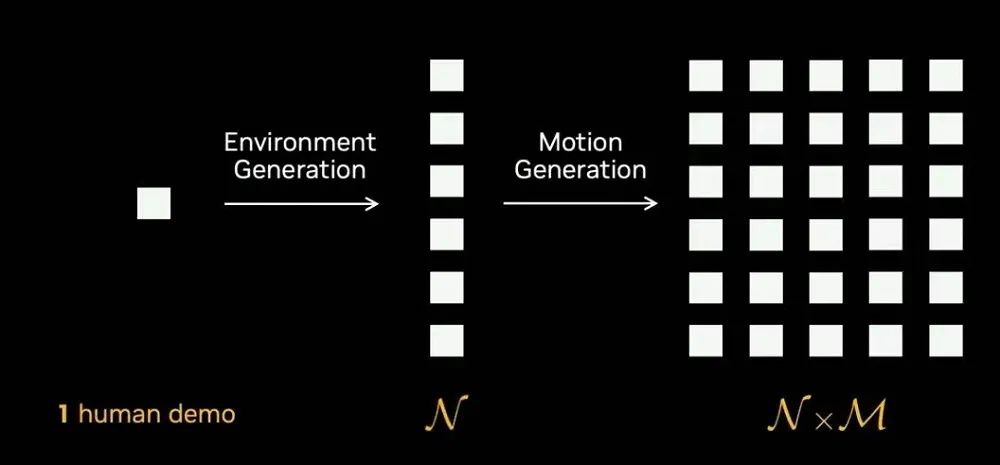

这种仿真遥操作带来了显著优势:比如当需要演示“将杯子从A点移动到B点”时,操作者只需完成一次演示,系统就能自动生成各种变体,无需重复操作。

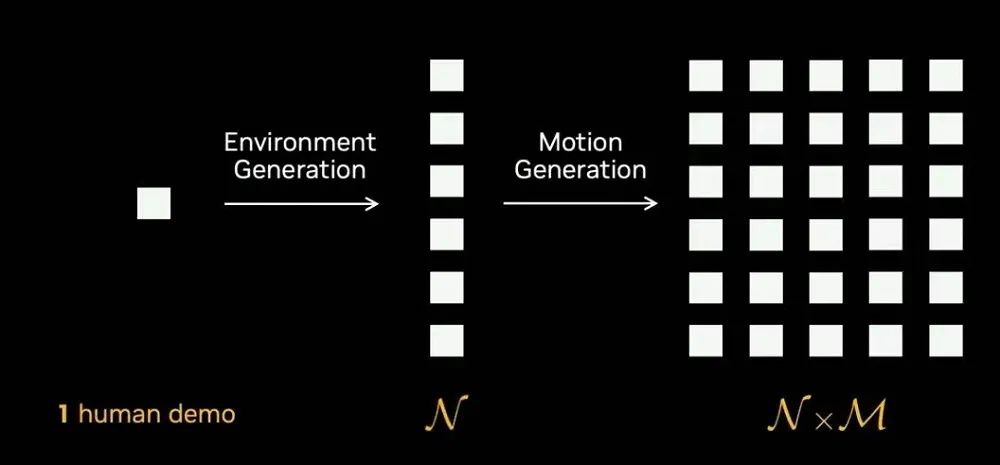

将所有这些技术整合后,我们就获得了“仿真环境中的真人演示”方案。通过环境生成技术,我们可以将场景数量扩展N倍;通过运动生成技术,又能将演示数据扩展M倍。

实际效果对比显示,第1列和第3列是真实机器人的操作视频,而第2列和第4列则完全来自Robocasa仿真系统。虽然仔细观察仍能发现某些纹理不够真实,但整体效果已经非常接近。

我们将这种接近真实但又并非完全一致的仿真称为“数字表亲”(Digital Cousin)。它不同于追求完全一致的数字孪生,而是捕捉了关键特征。虽然这些仿真运行速度较慢,但它们采用了一种创新的混合架构:部分内容由AI生成,其余部分则交由传统图形管线处理。

让我们来仿真这个场景:软体、流体以及各种不同形态的物体。在传统计算机图形学中,要精确模拟这样的场景需要艺术家或图形工程师投入大量时间。

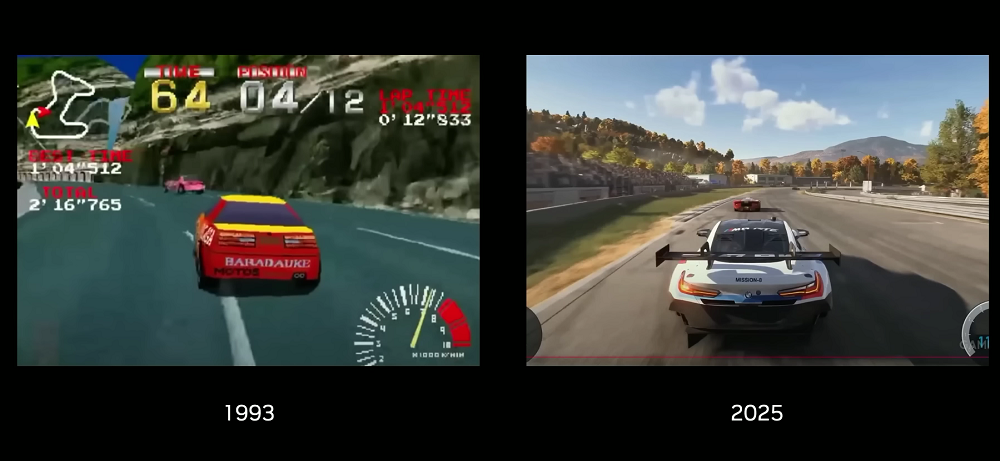

从图形技术的发展历程来看,实现下图中从左到右的进步,我们花费了整整30年时间。

然而,视频生成模型仅用一年就完成了同样的跨越,成功展现了下图中面条的形变等各种复杂元素。虽然在这个过程中可能损失了一些幽默感,但为了获得Sora、Veo等最新生成模型的能力,这个代价是值得的。短短一年就能取得如此突破,这充分展现了规模化训练和数据驱动方法的强大力量。

还记得我开始时展示的视频吗?我骗了你们,这个视频中没有一个像素是真实的,完全是由一个定制模型生成的。我们选择了一个通用的开源视频生成模型,使用机器人实验室收集的数据进行微调。画面中的一切都是生成的。

还可以通过提示词让模型想象不同的未来场景,模拟各种反事实情况。注意,这两个框架是完全相同的,但根据不同的语言提示,生成的视频能够准确理解并执行指令,即使这些动作在现实中从未发生过。

视频扩散模型的强大之处在于:它不关心场景有多复杂,也不在乎是否存在流体或软体等难以仿真的元素。

在同一个场景中,你可以要求机器人拿起不同的物品,而模型会准确地用正确的手势抓取物体并放入篮子。所有这些细节都是生成的,包括反射效果、物体交互等,没有一个真实像素。

我最欣赏的一个例子是那个弹奏尤克里里的机器人角色。实际上,视频模型可能已经“见过”数百万人类弹奏尤克里里的画面,现在它只是将这些知识迁移到机器人手指的仿真上。尽管实际硬件可能无法完成这个动作,但视频生成模型却能完美呈现。

这就是“仿真2.0”。它具备惊人的多样性,但目前运行速度还比较慢。我想将这一仿真称之为“数字游民”,它已经漫游进了视频扩散模型的梦境空间。

那么,什么是视频扩散模型呢?本质上,它是一个将海量互联网视频数据压缩成多维宇宙仿真的先进系统。就像《奇异博士》中的魔法世界一样,这个模型可以在虚拟空间中实例化智能体,使它们能够与任何环境中的对象进行交互。这体现了规模效应的强大威力。

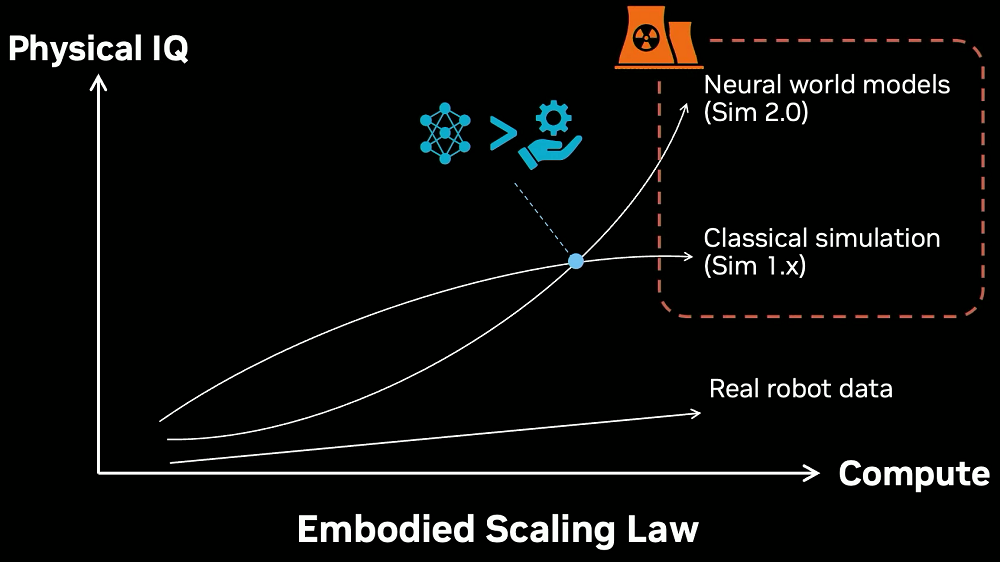

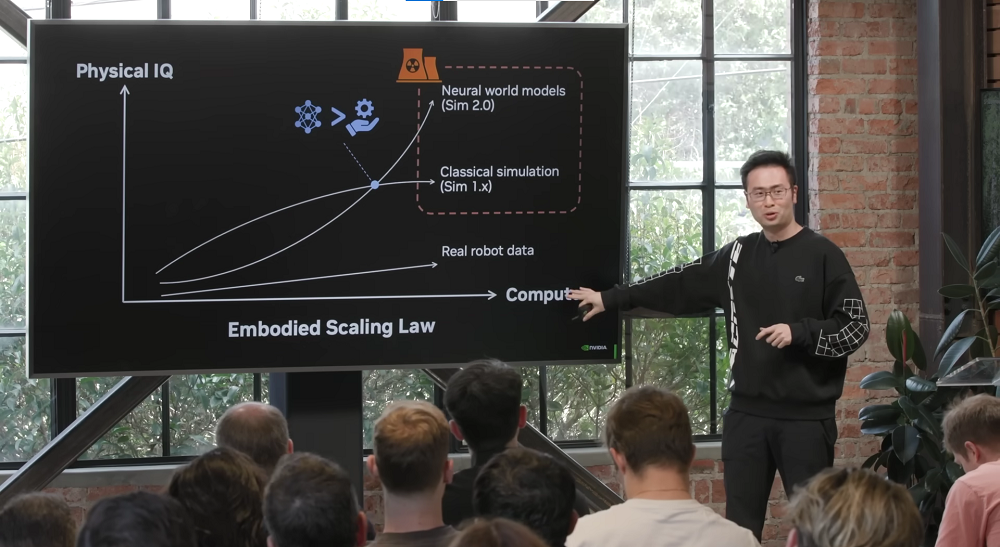

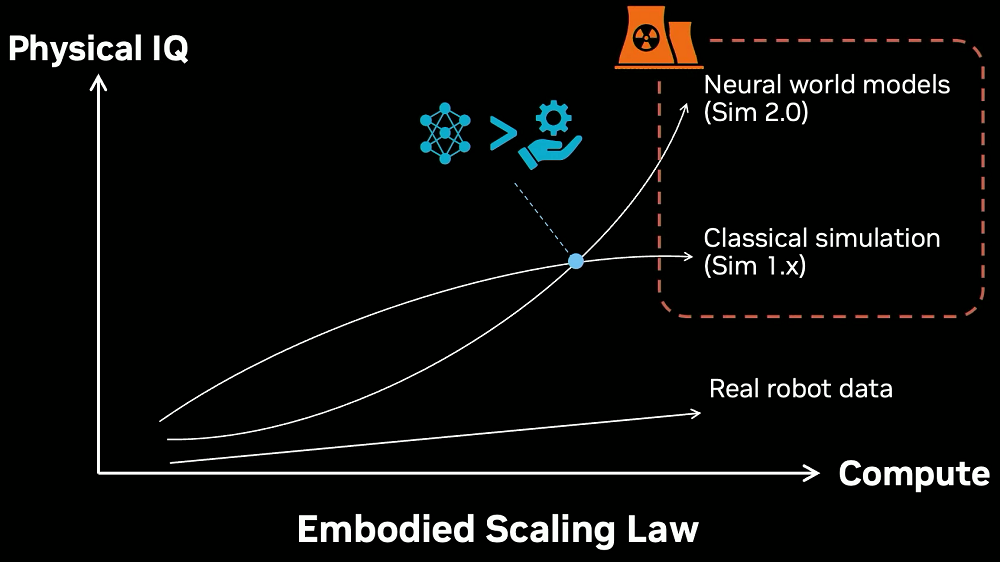

虽然黄仁勋已经离场,但我相信他一定会对这个突破感到兴奋。在传统仿真系统(1.x系列)中,我们需要投入巨大的计算资源来实现扩展。然而,这种方法很快就会遇到瓶颈,因为人工系统的多样性存在固有局限。

而全新的世界模型(仿真2.0版本)则完全不同——它的拓展能力随着计算资源呈指数级增长。这正是新一代网络超越传统图形工程师的关键所在。将这两种技术相结合时,我们就获得了推动下一代机器人系统发展的“核动力”,而且“买得越多,就省得越多”。

我们可以将这些数据输入到视觉-语言-动作(VLA)模型中,这个模型能够处理视觉像素和自然语言指令,并输出精确的电机控制信号。在实际应用中,我们使用了今年三月GTC大会上黄仁勋主题演讲中开源的GR00T N1模型。

令人惊喜的是,这个系统展现出了出乎意料的灵活性——比如它能够优雅地握住香槟酒杯。不过,在训练这个看似简单的动作期间,我们失败了很多次。这一系统在工业场景中同样表现出色,可以精抓取工厂零件,还能实现多机器人协同作业。

需要特别强调的是,我们不仅会开源GR00T系列模型的当前版本,未来迭代的版本也将持续开源。这完全遵循黄仁勋提出的“开源与民主化物理AI”的发展理念。

那么,物理AI之后的下一个前沿是什么?我认为将是“物理API”的革命。纵观人类五千年文明史,虽然工具不断革新,社会持续进步,但我们准备晚餐的方式与古埃及时期相比并无本质区别。

在人类99%的历史中,我们始终依赖人力劳动将原材料转化为文明成果。直到最近50年,我们才开始使用高度专业化但功能单一的机器人系统——这些系统开发成本高昂,应用范围有限。

而未来,我们将实现物理API的普及。就像今天的大模型API处理数字信息一样,物理API将能够操控物理世界的物质变化。

物理API将催生全新的经济形态。该如何教会这些机器人做事情呢,语言本身是不够的,我们可以打造“物理App Store”,培养“物理提示词工程”、“技能经济”等行业。

届时,米其林大厨不必亲临厨房,只需将其烹饪技艺传授给机器人,就能提供米其林级别的餐饮服务。正如黄仁勋所说的:“未来,所有可移动的物体都将实现自主化。”

想象这样一个场景:你回到家中,迎接你的是整洁的沙发、烛光晚餐,以及伴侣温馨的微笑——而不是因为没洗衣服而引发的争吵。这样的愿景每天都在激励着我前进。这些机器人将逐渐融入生活背景,成为环境智能的一部分。我们或许都不会注意到机器人通过物理图灵测试的历史性时刻,只会把那天当作生命中平凡的一天。

(文:智东西)