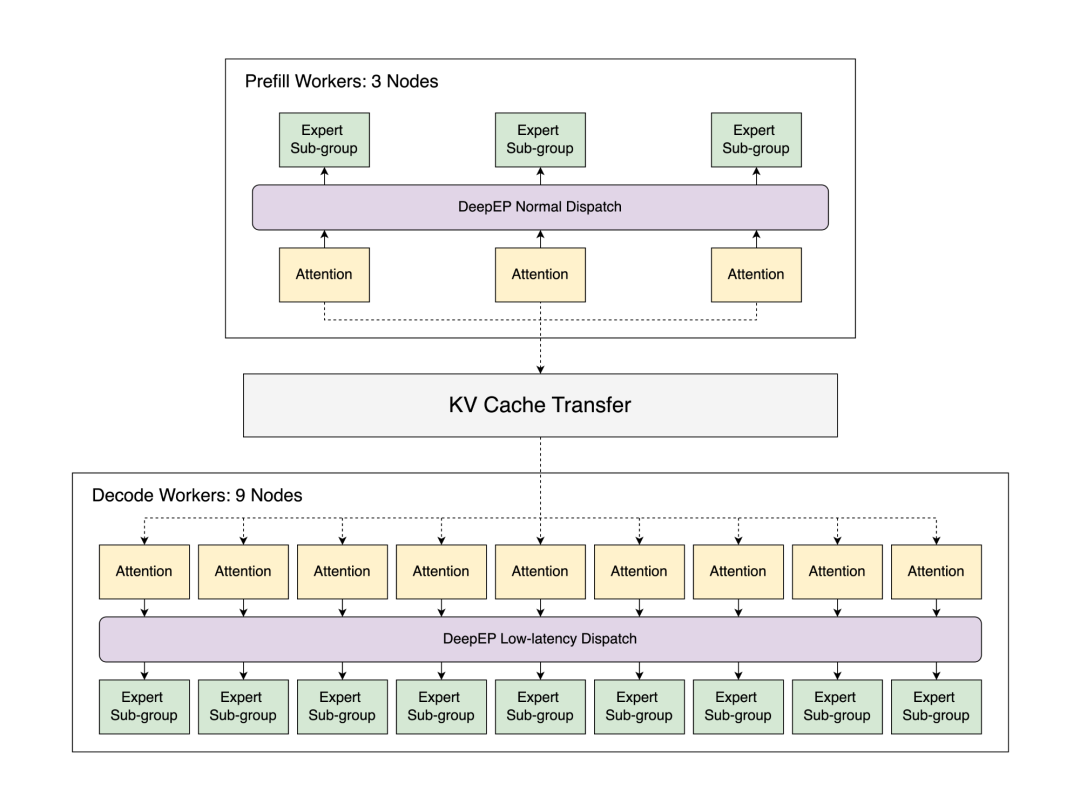

在 96 块 H100 GPU 上通过参数分解与大规模专家并行技术部署 DeepSeek。SGLang 的官方博客,写这篇博客是他们做到了“首个在大规模场景下接近官方 DeepSeek 博客所报道吞吐量的开源实现”。

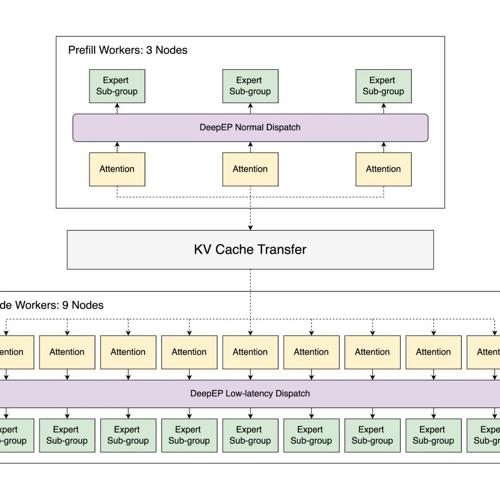

DeepSeek 是一款广受欢迎的开源大语言模型,其卓越性能备受赞誉。然而该模型庞大的参数量及独特架构——采用多头潜在注意力机制(MLA)与混合专家系统(MoE)——需要先进的系统架构来实现高效的大规模推理服务。本篇博客将详解如何通过 SGLang 实现与 DeepSeek 推理系统性能的精准匹配。

参考文献:

[1] https://lmsys.org/blog/2025-05-05-large-scale-ep/

知识星球服务内容:Dify源码剖析及答疑,Dify对话系统源码,NLP电子书籍报告下载,公众号所有付费资料。加微信buxingtianxia21进NLP工程化资料群。

(文:NLP工程化)