还在为“全量微调大模型”望而却步?显存不够、算力太贵、调不动7B模型……这些痛点,被一个技术方案悄悄解决了——它叫 LoRA(Low-Rank Adaptation)。

如果你是零基础、刚入门大模型开发的新人,这篇文章会让你迅速掌握 LoRA 的原理、优势、实操流程和进阶路径。一张3060,也能微调大模型!

🧠 什么是 LoRA?一句话解释

LoRA 是一种高效微调大模型的技术方案。它的核心思路很简单:不改原模型,只在关键层插入极少量可训练参数,通过这部分“小打小闹”的优化,就能获得和全量训练相近的效果。

可以这样理解:如果全量微调是一篇论文的“通篇重写”,那 LoRA 就只是“修改几段关键内容”,成本低、效率高,而且效果还不差。

⚙️ 为什么大家都在用 LoRA?

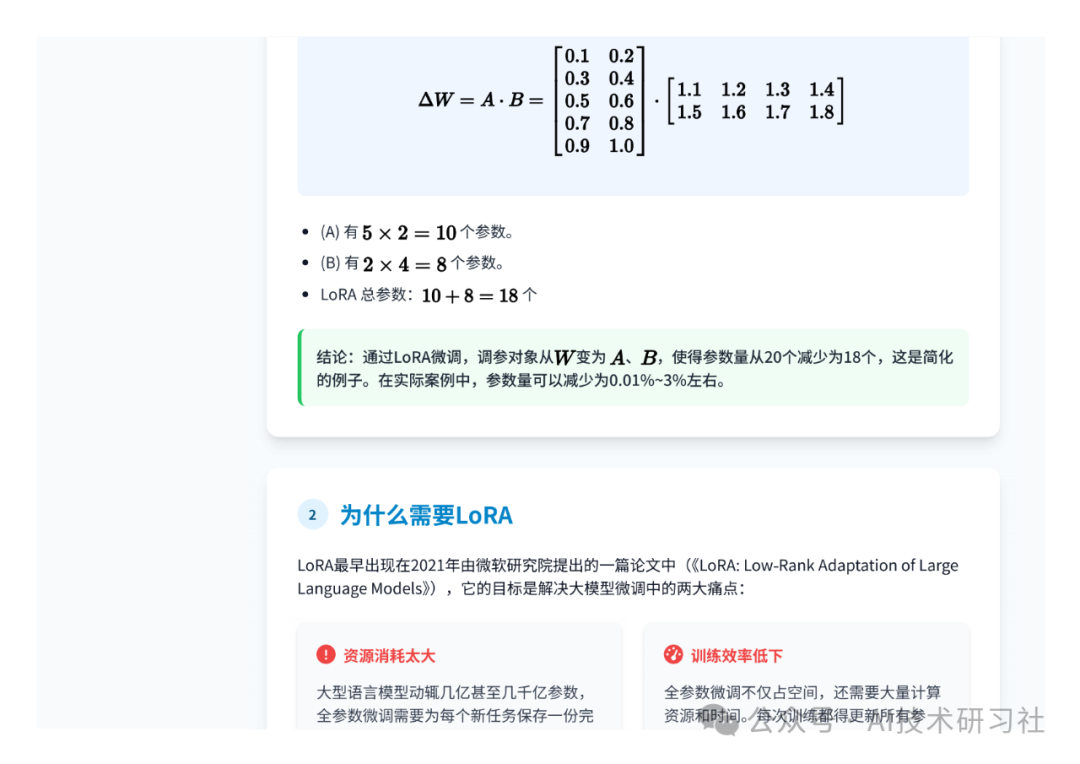

相比传统微调方式,LoRA 有几个堪称“革命性”的优势:

-

显存节省高达99%:比如 7B 的模型,全量微调需要 30GB 显存,而 LoRA 只需 4GB,3060 也能搞定。

-

训练速度提升数倍:只优化低秩矩阵,参数少了,训练当然快。

-

模型体积小、易部署:LoRA 只保存微调部分,文件轻量,适合快速上线。

在大模型动辄几十GB、百亿参数的今天,这种“只调关键点”的做法,不仅节省资源,更适合个人开发者、科研小团队快速试错与创新。

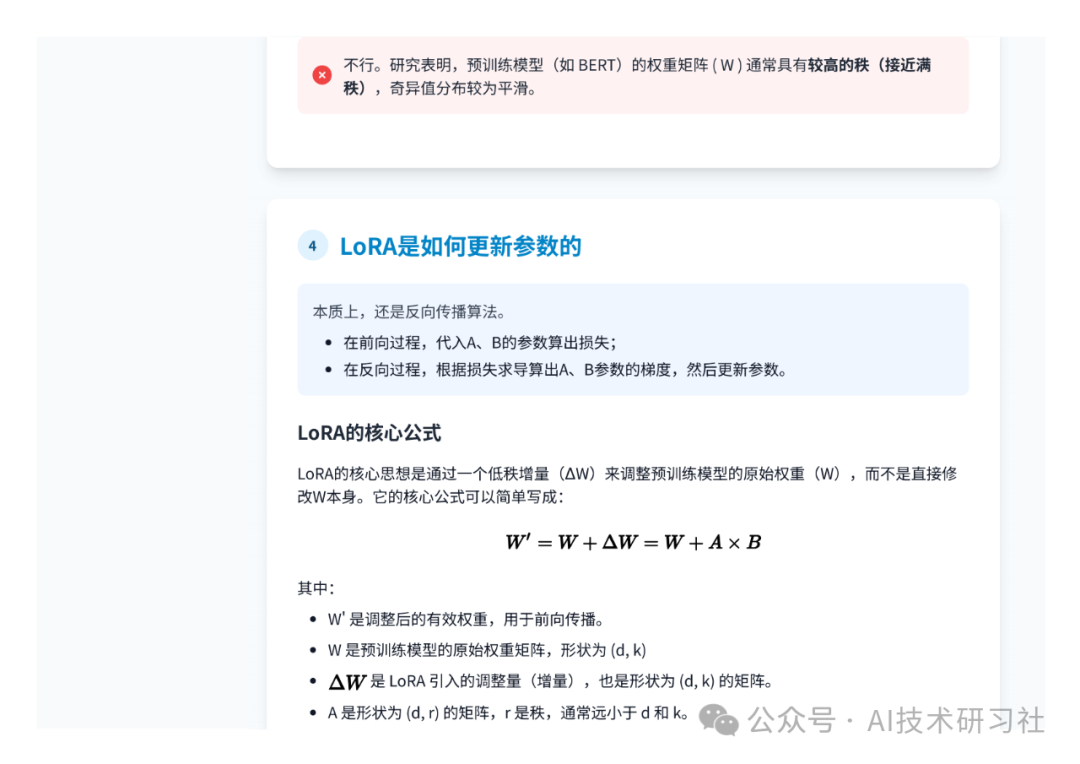

🔍 LoRA 背后的工作原理

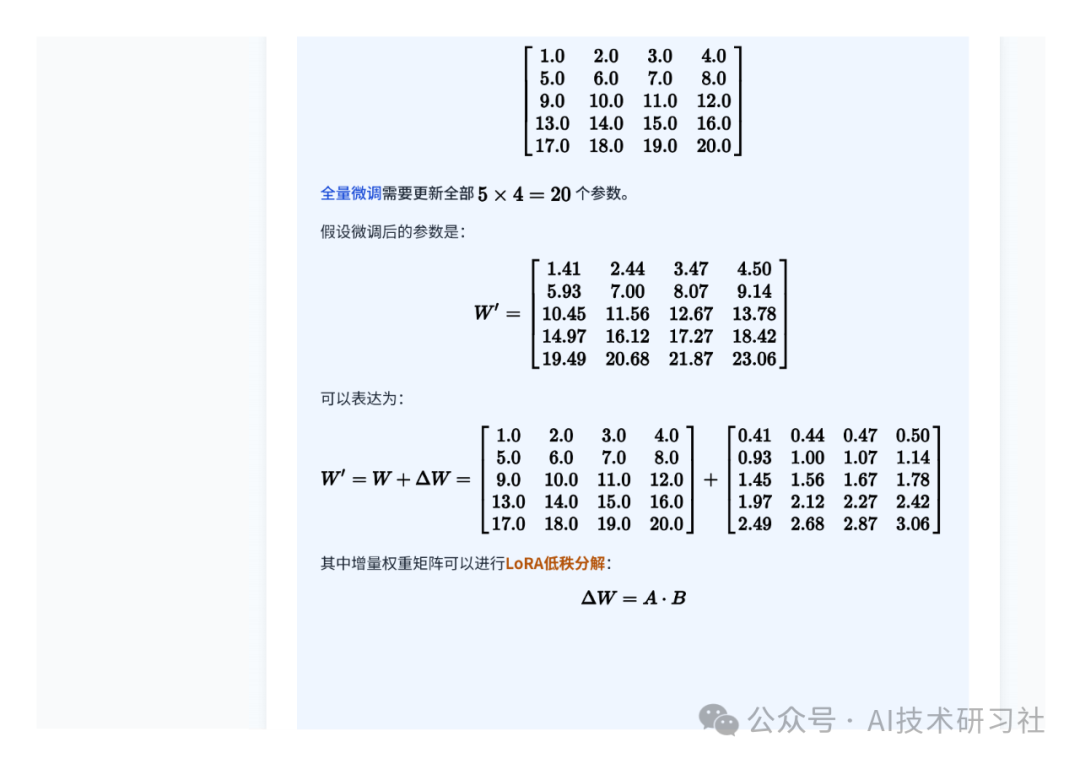

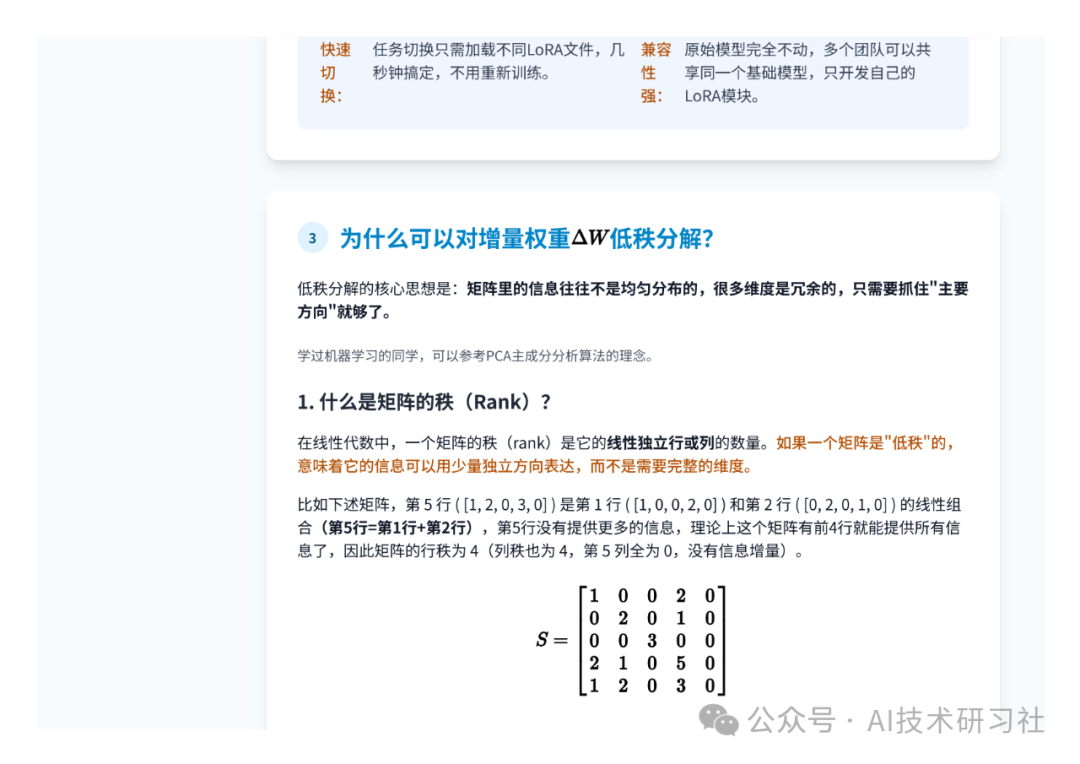

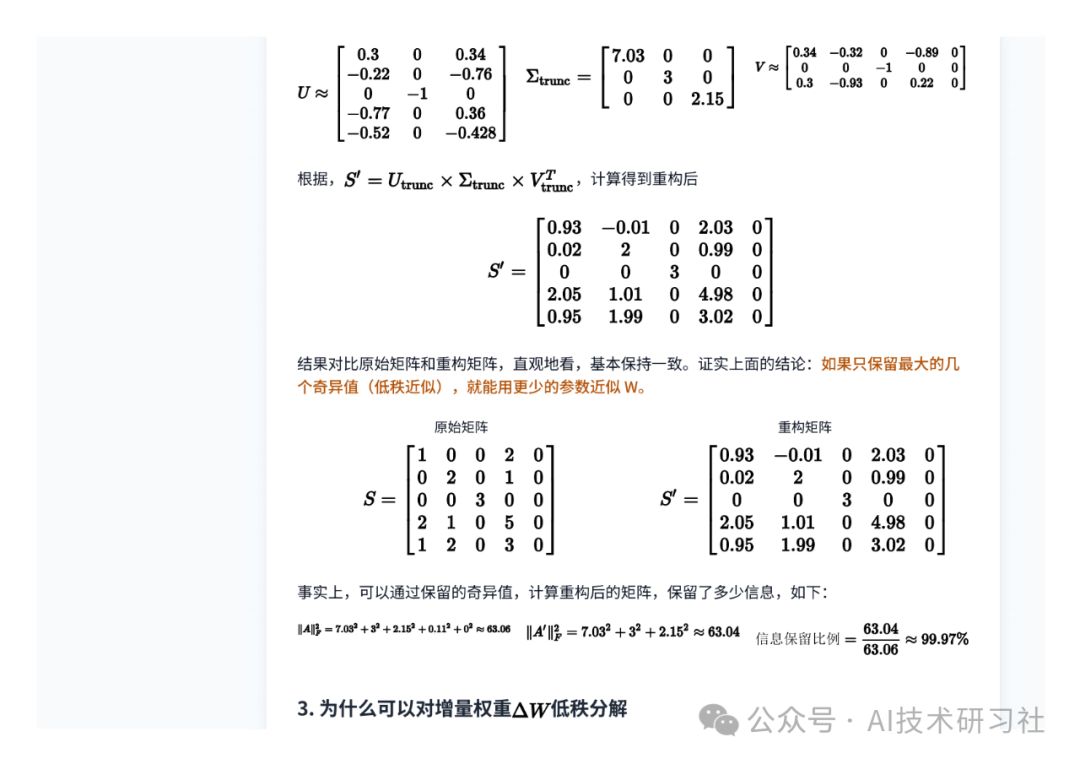

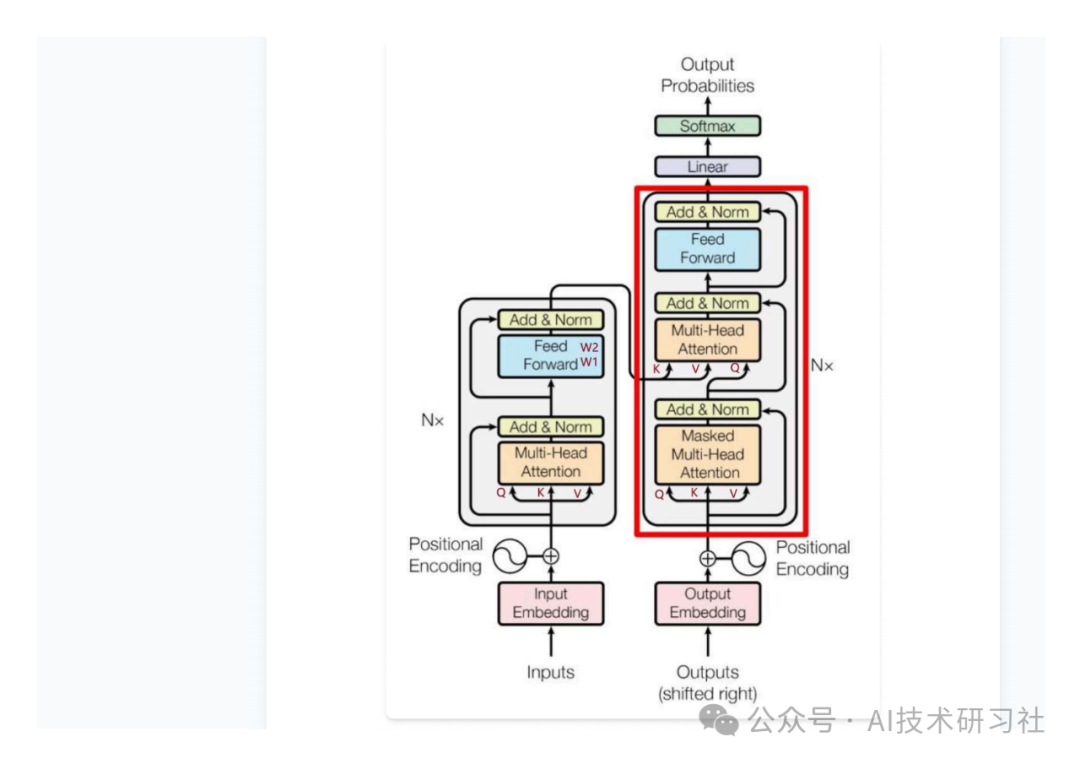

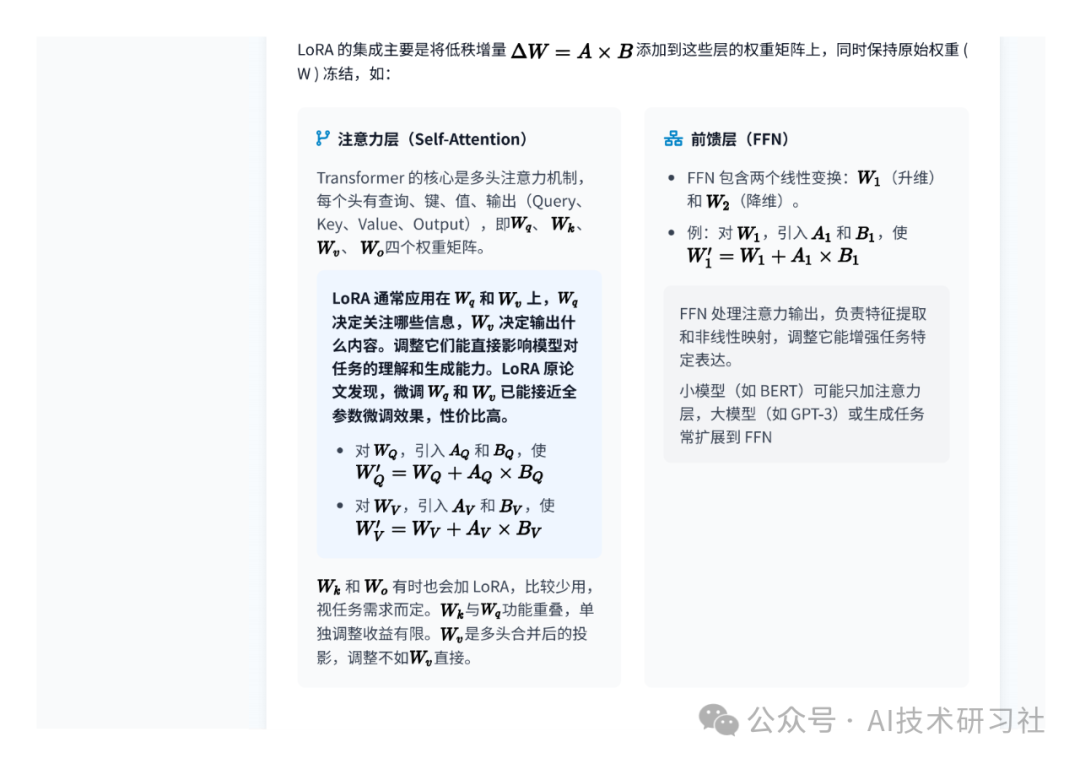

LoRA 的关键技术点在于:冻结原始模型权重,仅对插入的“低秩矩阵”进行训练。

通俗点说,就是在 Transformer 的注意力层(如 q_proj、v_proj)中,加入两个小矩阵 A 和 B,通过它们计算出的参数增量 ΔW 来完成调整。

这两张“小矩阵”的秩(rank)通常远小于原始矩阵,所以计算量极低,但调优效果却足够优秀。

🛠 零基础也能上手的 LoRA 实操指南

下面是一个完整的 LoRA 微调流程示例,基于 Hugging Face 生态,适合跑在消费级 GPU 上(如 RTX 3060)。

Step 1:安装依赖

pip install transformers peft accelerate datasetsStep 2:加载预训练模型

from transformers import AutoModelForCausalLM, AutoTokenizermodel_name = "baichuan-inc/baichuan-7B"model = AutoModelForCausalLM.from_pretrained(model_name,load_in_8bit=True,device_map="auto")tokenizer = AutoTokenizer.from_pretrained(model_name)

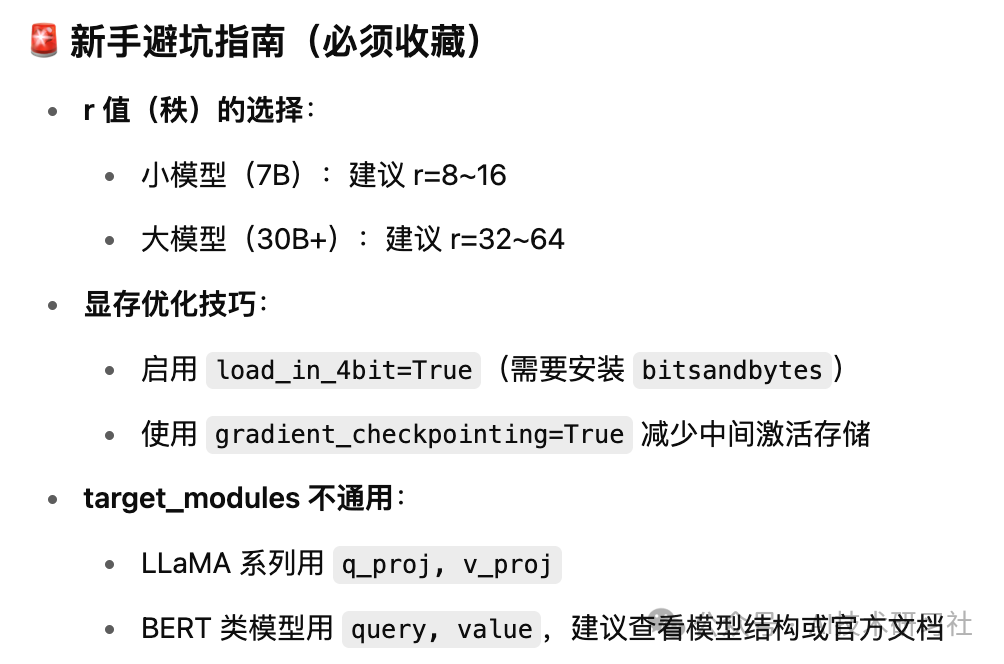

Step 3:配置 LoRA 参数

from peft import LoraConfiglora_config = LoraConfig(r=8,lora_alpha=32,target_modules=["q_proj", "v_proj"],lora_dropout=0.1,bias="none",task_type="CAUSAL_LM")

Step 4:应用 LoRA 并启动训练

from peft import get_peft_modelfrom datasets import load_datasetfrom transformers import Trainermodel = get_peft_model(model, lora_config)dataset = load_dataset("imdb")texts = [f"Review: {item['text']} Label: {item['label']}" for item in dataset["train"]]training_args = {"output_dir": "./lora_baichuan","num_train_epochs": 3,"per_device_train_batch_size": 2,"gradient_accumulation_steps": 4,"learning_rate": 2e-4,"logging_steps": 100,"fp16": True}trainer = Trainer(model=model,args=training_args,train_dataset=texts)trainer.train()

Step 5:保存与加载 LoRA 模型

# 保存

model.save_pretrained("./lora_baichuan")# 加载from peft import PeftModelbase_model = AutoModelForCausalLM.from_pretrained(model_name)lora_model = PeftModel.from_pretrained(base_model, "./lora_baichuan")

在大模型走向全民开发的今天,LoRA 给了我们一条“低成本、高效率”的捷径。它不要求你有上万卡的集群,不要求你熟悉复杂分布式系统,甚至不需要写太多代码——只要你敢动手,一张3060,也能跑出属于你的大模型微调成果。

如果这篇文章帮你打开了 LoRA 的大门,欢迎点赞、转发、收藏;如果你已经开始实操,也欢迎留言告诉我你的成果与问题,我们可以一起进阶探索 QLoRA、多模态 LoRA、Agent 微调的新方向!

完整资料PDF下载:https://t.zsxq.com/kXmCB

(文:AI技术研习社)