近年来,ChatGPT 的爆火让“大语言模型”(LLM)走进了大众视野。我们每天都在用它们聊天、写作、写代码,但你是否真正了解它们是怎么工作的?本文系统梳理了大语言模型的原理、训练方式及其实际应用。

不妨花几分钟,跟我一起深入了解这项 AI 核心技术的本质与潜力。喜欢看视频的同学可以直接划到结尾看视频了~

一、什么是大语言模型(LLM)?

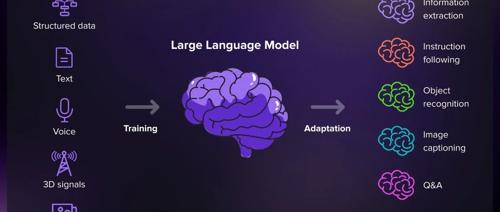

大语言模型,全称是 Large Language Model,本质上是一种基础模型(Foundation Model)。它们在海量文本上进行自监督学习,通过理解数据中的模式,具备了强大的语言生成和理解能力。

这类模型不仅可以处理文本,还能“读懂”代码等类似语言结构的内容。GPT 就是这类模型的代表。

✅ 延伸知识:所谓“基础模型”,指的是在通用数据上预训练的模型,可迁移到各种下游任务;比如 ChatGPT 就是用 GPT-3.5/GPT-4 微调后获得的对话模型。

二、LLM 是怎么训练出来的?

一个 LLM 的训练可以分为三大核心要素:

-

数据(Data):

模型训练所需的数据规模惊人。比如 GPT-3 使用了约 45TB 的原始文本数据,数据来源包括书籍、文章、网页对话等,甚至总规模可达 PB(千万 GB)级别。 -

架构(Architecture):

GPT 所采用的架构是目前最流行的 Transformer。这种神经网络结构擅长处理序列数据,能够通过“注意力机制”理解一个句子中词与词之间的关系,从而捕捉上下文语义。 -

训练(Training):

模型通过预测句子中下一个词来进行训练。例如给出“The sky is”,初期模型可能预测“The sky is bug”,但通过不断调整参数,它最终会学会预测出正确的词:“blue”。

三、什么是“参数”?为什么越多越强?

在深度学习中,参数(Parameter) 是模型在训练过程中调整的数值。参数越多,模型的表达能力就越强。

以 GPT-3 为例,它拥有高达 1750 亿个参数。这也是它能生成近似人类语言的原因之一。

💡 形象理解:一个 1GB 的文本文件大约能容纳 1.78 亿个英文单词,而 GPT 的训练数据远远超过这个量级。它“读书”的数量,堪比成千上万个图书馆。

四、模型训练完成后,还能“进修”吗?

当然可以。LLM 完成初步训练后,还可以针对具体任务进行微调(Fine-tuning)。例如,让 GPT 更擅长医学对话、法律合同分析,或者数学题求解。

通过在小而专业的数据集上再次训练,模型会对特定任务理解更深入,表现也更精准。

五、大语言模型可以用来干嘛?

LLM 正在重塑多个行业的工作方式,以下是几个典型应用场景:

-

客户服务:智能客服机器人可以处理大量用户问题,减轻人工压力。

-

内容创作:自动生成文章、邮件、社交媒体文案,甚至视频脚本。

-

代码辅助:协助开发者写代码、找 Bug、自动补全函数。

-

教育领域:个性化答疑、语法纠错、学术写作建议等。

未来还有更多可能等待我们去发现。

写在最后:为什么我们要关注 LLM?

随着 LLM 技术的持续进化,它正在快速融入我们的工作与生活。这不仅是一次技术革新,更是认知方式的变革。

如果你也对 LLM 感兴趣,欢迎留言交流你的看法;如果你想了解更多 AI 知识,也别忘了点个关注~

📩 你还想了解哪些 AI 技术?留言区见!

🔍 如果你觉得这篇文章有用,欢迎分享给朋友~

📬 关注我,下次更新不错过!

(文:PyTorch研习社)