在音乐的世界里,每个人都曾幻想过拥有属于自己的主题曲,一首能够完美诠释个人独特气质和情感的音乐。虽然我们常常会将某首歌视为自己的“专属”,但这种感觉与真正拥有一首完全根据自己的个性和需求定制的音乐是截然不同的。幸运的是,随着人工智能技术的飞速发展,这种幻想正在逐渐成为现实。香港科技大学的工程师团队开发了一种名为 AudioX 的新型机器学习模型,它能够根据用户的个性化输入生成独一无二的音频和音乐作品,无论是主题曲、音效,还是其他任何类型的音频内容,都能轻松实现。

-

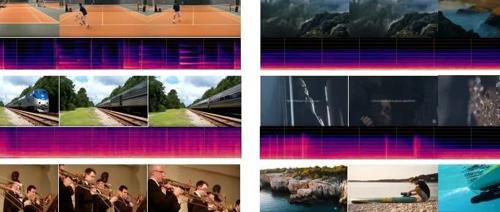

文本到音频(Text-to-Audio):根据文本描述生成相应的音效。例如,输入“狗吠声”,模型可以生成狗吠的音频。 -

视频到音频(Video-to-Audio):根据视频内容生成与之匹配的音效。例如,输入一个汽车行驶的视频,模型可以生成汽车发动机的声音。 -

图像到音频(Image-to-Audio):根据图像内容生成相应的音效。例如,输入一张暴风雨的图片,模型可以生成暴风雨的声音。 -

音乐生成(Music Generation):根据文本描述或视频内容生成音乐。例如,输入“轻松的钢琴曲”,模型可以生成一段轻松的钢琴音乐。 -

音频修复(Audio Inpainting):根据上下文信息修复音频中的缺失部分。例如,输入一段有空白的音频,模型可以填补空白部分,使音频完整。 -

音乐补全(Music Completion):根据给定的音乐片段生成后续部分。例如,输入一段音乐的开头,模型可以生成后续的音乐片段。 -

高质量音频生成:AudioX 使用扩散模型(Diffusion Model)技术,能够生成高质量、高保真的音频和音乐,确保生成的音频在音质和细节上接近真实音频。 -

灵活的自然语言控制:用户可以通过自然语言描述来精确控制生成的音频内容。例如,用户可以指定音效的类型、音乐的风格、乐器的使用等,使生成的音频更符合需求。 -

跨模态学习能力:AudioX 能够处理多种模态的输入,并将它们有效整合,生成与输入条件一致的音频。例如,同时输入文本和视频,模型可以综合考虑两者的语义信息,生成更贴合场景的音频。 -

强大的泛化能力:在多个数据集和任务上表现出色,包括 AudioCaps、VGGSound、MusicCaps、V2M-bench 等,证明了其在不同场景下的泛化能力和适应性。 -

零样本生成能力:即使没有针对特定模态(如图像)的专门训练,AudioX 也能在零样本条件下生成高质量的音频,展示了强大的通用生成能力。

AudioX 的技术原理

-

扩散模型(Diffusion Model):AudioX 基于扩散模型的核心思想,通过逐步向输入数据添加噪声,再通过逆向过程逐步去除噪声,最终生成高质量的音频或音乐。

-

前向扩散过程:将输入数据逐步添加高斯噪声,生成一系列含噪的潜变量。

-

反向去噪过程:通过训练一个去噪网络(通常是一个 Transformer),逐步去除噪声,重建干净的音频数据。

-

多模态掩码训练策略:为了增强模型的跨模态学习能力,AudioX 采用了多模态掩码训练策略。在训练过程中,模型会随机掩码部分输入模态,迫使模型从不完整的输入中学习,提高模型的鲁棒性和泛化能力。

-

多模态编码器和解码器:AudioX 集成了多种专用编码器,分别处理不同模态的输入数据,然后将这些编码后的特征融合到一个统一的潜空间中。

-

视频编码器:使用 CLIP-ViT-B/32 提取视频帧的特征。

-

文本编码器:使用 T5-base 提取文本的特征。

-

音频编码器:使用自编码器提取音频的特征。

-

特征融合:将不同模态的特征通过线性变换和连接操作融合到一个统一的多模态嵌入向量中。

-

扩散过程中的条件嵌入:在扩散过程中,多模态嵌入向量作为条件输入,帮助模型生成与输入条件一致的音频或音乐。将融合后的多模态特征与扩散时间步一起输入到扩散模型中。通过逐步去除噪声,生成与输入条件匹配的高质量音频或音乐。

-

数据集和训:为了训练 AudioX,研究人员构建了两个大规模的多模态数据集:

-

vggsound-caps:基于 VGGSound 数据集,包含 190,000 个音频字幕。

-

V2M-caps:基于 V2M 数据集,包含 600 万音乐字幕。

AudioX 的能力不仅限于简单的音频生成。它能够处理各种复杂的任务,包括文本到音频的转换、视频到音频的生成、音乐的补全,甚至音频修复(audio inpainting)——即恢复音频音轨中缺失或损坏的部分。这种能力使得 AudioX 在影视制作、音乐创作、游戏开发等领域具有巨大的应用潜力。

经过广泛的测试,AudioX 的性能已经超越了许多现有的单一任务系统。与大多数 AI 工具不同,AudioX 作为一个单一的统一模型运行,而不是由多个小型专业模型拼凑而成。这种设计使得 AudioX 在处理多模态输入时更加高效和灵活。

(文:AI音频时代)