OpenAI 称,o3 是其迄今为止最先进的推理模型,在数学、编程、推理、科学和视觉理解能力的测试中表现优于公司之前的模型。与此同时,o4-mini 提供了 OpenAI 所说的在价格、速度和性能之间的竞争力平衡。

o3 和 o4-mini 将具备「图像思维」能力,即能够「将图像直接融入其思维链中」。OpenAI 称,这些模型还能在推理过程中通过放大或旋转图像来调整画面。

OpenAI 宣布其推理模型将能够使用所有 ChatGPT 工具,如网络浏览、Python 代码执行、图像处理及图像生成。这些工具今日起面向 ChatGPT Plus、Pro 及 Team 用户开放,适用于 o3、o4-mini 和 o4-mini-high 版本,并将在「几周内」登陆 o3-pro 版本。(o1、o3-mini 及 o3-mini-high 版本将逐步从这些层级中淘汰。)

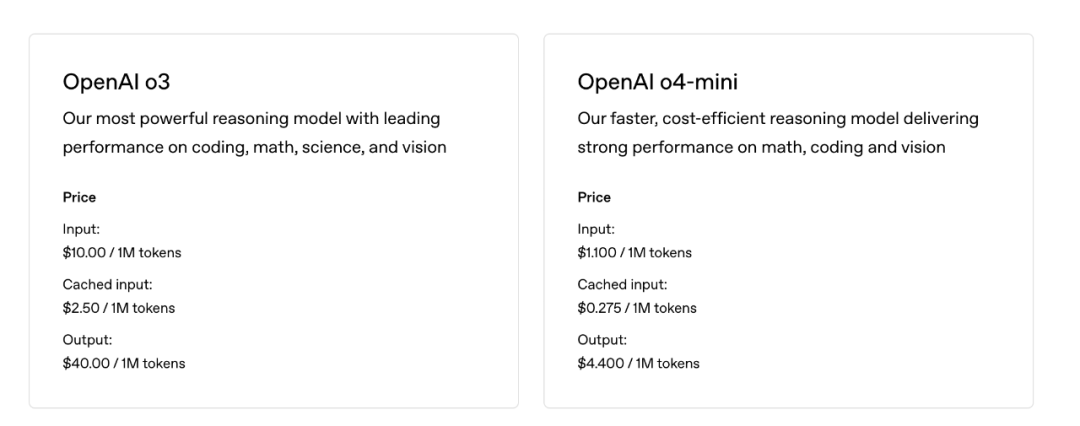

定价较 o1 同档大幅下降(o3‑mini 对 o1‑mini 便宜 63%)。

在 API 中,o4-mini 和 o3 提供 200,000 个 token 的上下文窗口,最多 100,000 个输出 token,知识截止日期为 2024 年 6 月 1 日

Sam Altman 表示,o3 和 o4-mini 可能是 ChatGPT 在 GPT-5 之前的最后独立 AI 推理模型。GPT-5 是该公司宣称将统一传统模型(如 GPT-4.1)与其推理模型的新一代产品。

o3 和 o4-mini 现已通过 Chat Completions API 和 Responses API 向开发者开放(部分开发者需验证其组织身份以访问这些模型)。

01

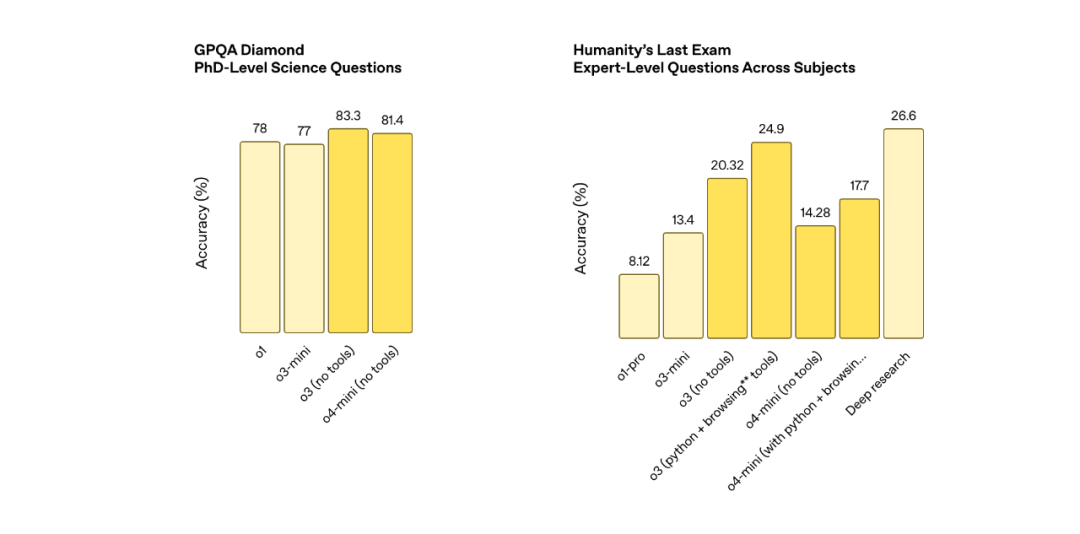

评测成绩继续刷新榜单记录

o3 在 Codeforces、SWE-bench 和 MMMU 等基准测试中创下了新的 SOTA 记录。它特别适合需要多角度分析且答案可能并非显而易见的复杂查询。在视觉任务方面,如分析图像、图表和图形,o3 表现尤为出色。根据外部专家的评估,在困难的现实世界任务中,o3 比 OpenAI o1 减少了 20% 的重大错误——尤其在编程、商业/咨询和创意构思等领域表现卓越。

OpenAI o4-mini 是一款专为快速、经济高效的推理而优化的轻量级模型——凭借其小巧的体积和低廉的成本,在数学、编程及视觉任务中展现出卓越性能。在 AIME 2025 基准测试中,当配备 Python 解释器时,o4-mini 以 99.5% 的成绩近乎完美地突破了该测试上限。专家评估还显示,其在非 STEM 领域和数据科学等任务上的表现也超越了前代产品 o3-mini。得益于高效设计,o4-mini 支持比 o3 显著提升的使用频率上限,成为需要复杂推理场景下理想的高吞吐量解决方案。

本次的两款模型效率通常也超越了前代产品 OpenAI o1 和 o3-mini。以 2025 年 AIME 数学竞赛为例,o3 在性价比边界上全面优于 o1,同样地,o4-mini 的边界表现也显著超越 o3-mini。总体而言,在大多数实际应用场景中,o3 和 o4-mini 将分别比 o1 和 o3-mini 更智能且成本更低。

录首批使用图像思考的模型

OpenAI 宣称 o3 和 o4-mini 是其首批能够「用图像思考」的模型。实际应用中,用户可向 ChatGPT 上传图片,如白板草图或 PDF 中的图表,模型会在「思维链」阶段分析这些图像后再作答。得益于这一新能力,o3 和 o4-mini 能理解模糊和低质量的图像,并在推理过程中执行放大或旋转图像等操作。

它能无缝结合高级推理与网络搜索、图像处理等工具——自动缩放、裁剪、翻转或优化图片——甚至能从有缺陷的照片中提取洞见。例如,用户可以上传经济学习题集的照片获取逐步解析,或分享构建错误的截图迅速获得根本原因分析。

OpenAI 在多样化的人类考试和机器学习基准上测试了 OpenAI o3 和 o4-mini。这些新型视觉推理模型在所有测试的多模态任务中均显著超越前代产品。

会自主使用工具

OpenAI 的 o3 和 o4-mini 模型能够完全访问 ChatGPT 内的工具,并通过 API 中的函数调用使用用户自定义的工具。这些模型经过训练,能够推理解决问题的方法,选择何时以及如何使用工具,快速生成详细且深思熟虑的答案,通常在一分钟内完成,并以正确的输出格式呈现。

例如,用户可能会问:「加州夏季能源使用量与去年相比会如何?」模型可以搜索网络获取公共事业数据,编写 Python 代码构建预测,生成图表或图像,并解释预测背后的关键因素,将多个工具调用串联起来。推理能力使模型能够根据需要对其遇到的信息做出反应和调整。例如,它们可以在搜索提供商的帮助下多次搜索网络,查看结果,并在需要更多信息时尝试新的搜索。

强化学习的 Scaling Law

在 OpenAI o3 的开发过程中,OpenAI 观察到大规模强化学习展现出与 GPT 系列预训练相同的「计算量越大=性能越好」趋势。通过重新探索扩展路径——这次是在强化学习领域——将训练计算量和推理时的思考量都提升了一个数量级,但依然能看到明显的性能提升,这验证了模型性能会随着思考时间的增加而持续进步。在与 OpenAI o1 相同的延迟和成本下,o3 在 ChatGPT 中提供了更高的性能——而且已经验证,如果让它思考更长时间,其性能还会继续攀升。

OpenAI 还通过强化学习训练了两种模型使用工具的能力——不仅教会它们如何使用工具,还教会它们推理何时使用工具。它们根据预期结果部署工具的能力,使它们在开放式情境中表现更出色,尤其是在涉及视觉推理和多步骤工作流程的情况下。据早期测试者反馈,这一改进既体现在学术基准测试中,也体现在实际任务中。

Codex CLI:终端推理工具

Codex CLI,一个可以从终端运行的轻量级编码代理。它直接在您的计算机上运行,它能将自然语言转化为可运行的代码,旨在最大化 o3 和 o4-mini 等模型的推理能力,并即将支持 GPT-4.1等更多 API 模型。

OpenAI 的一位发言人向 TechCrunch 表示:「Codex CLI 是一款轻量级、开源的编码代理,可在您的终端本地运行。」其目标是「为用户提供一个极简、透明的界面,直接将模型与代码和任务联系起来。」

用户可以通过命令行将截图或低保真草图传递给模型,并结合本地代码访问,获得多模态推理的优势。OpenAI 将其视为连接我们的模型与用户及其计算机的最小界面。Codex CLI 现已完全开源,请访问 github.com/openai/codex。

(文:Founder Park)