-

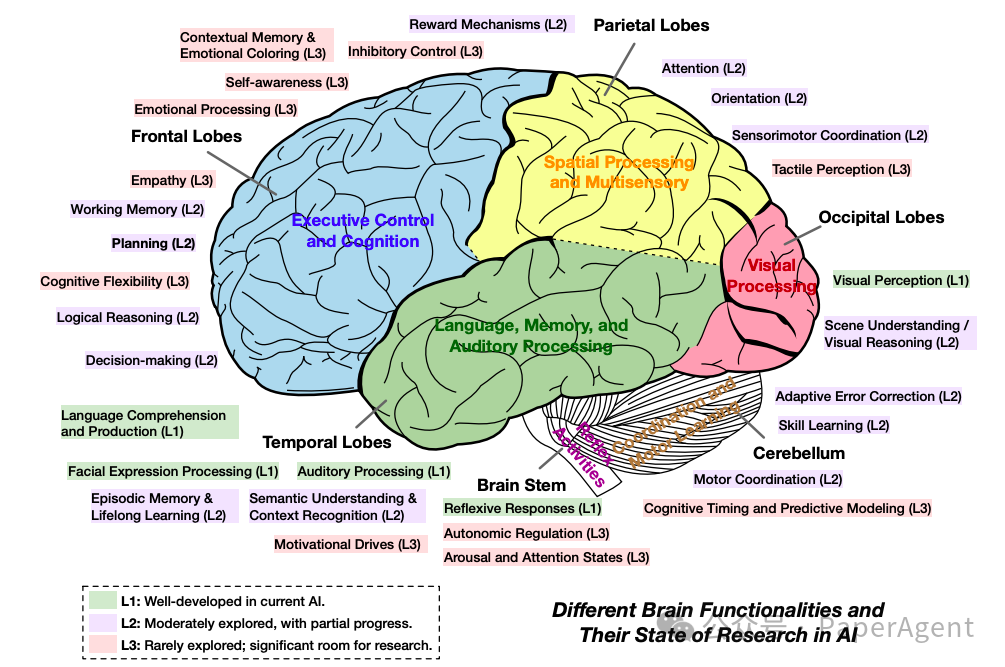

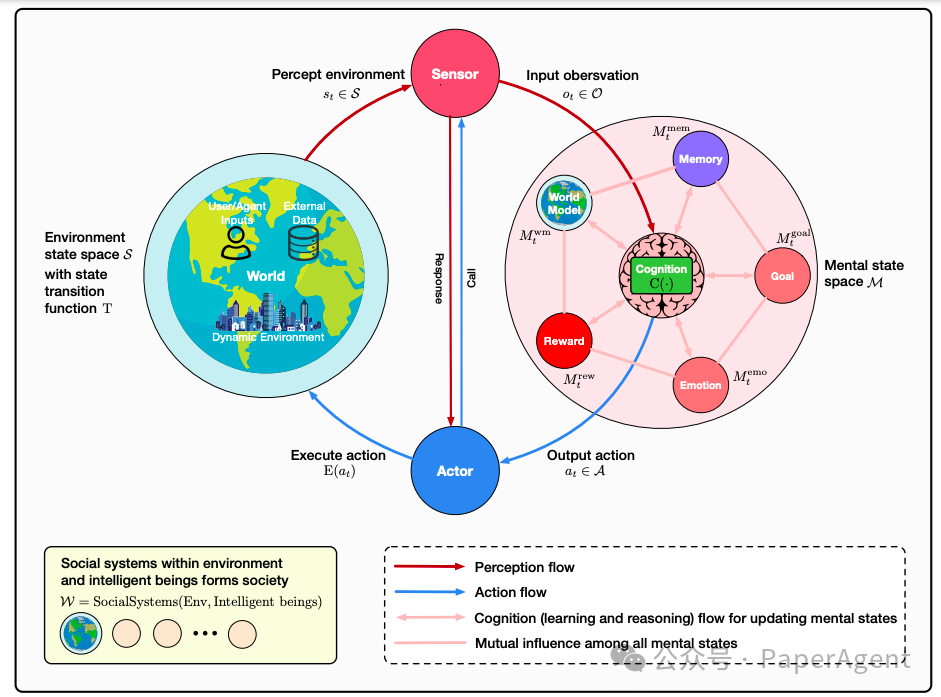

首先,深入研究智能Agents的模块化基础,系统地将其认知、感知和操作模块映射到类似人类大脑的功能,并阐明记忆、世界建模、奖励处理以及类似情感系统等核心组件。 -

其次,讨论自我增强和适应性进化机制,探讨如何通过自动化优化范式(包括新兴的AutoML和LLM驱动的优化策略)自主完善其能力、适应动态环境并实现持续学习。 -

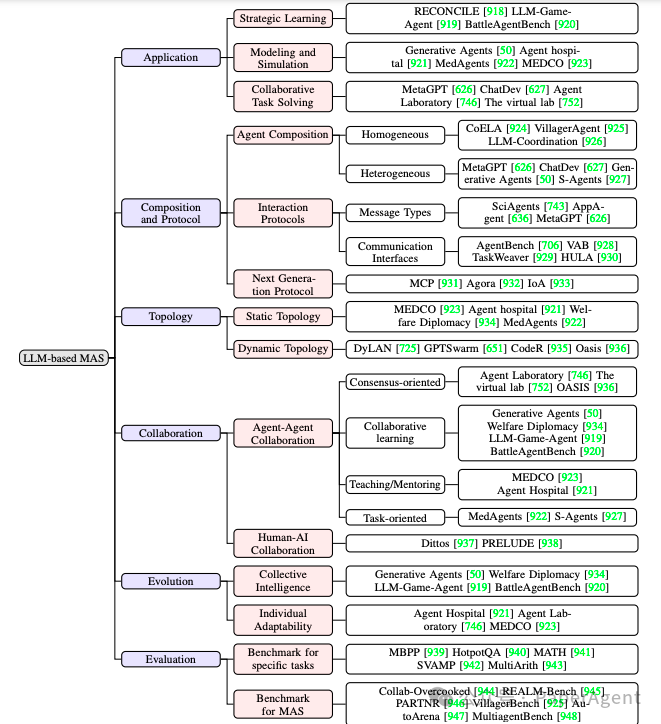

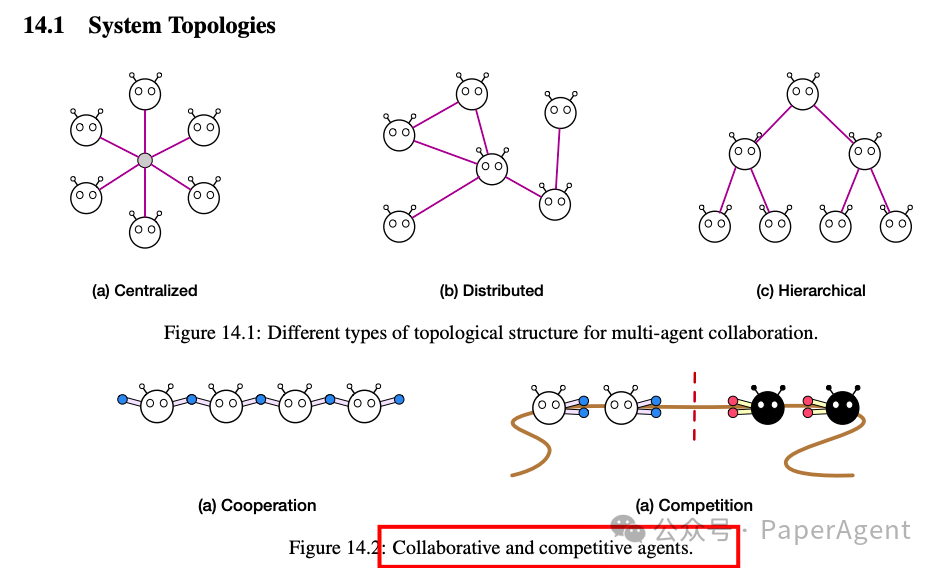

第三,研究协作和进化multi-Agent系统,调查从Agent互动、合作以及社会结构中涌现的集体智能,并强调其与人类社会动态的相似之处。 -

最后,着重讨论构建安全、可靠且有益的AI系统

-

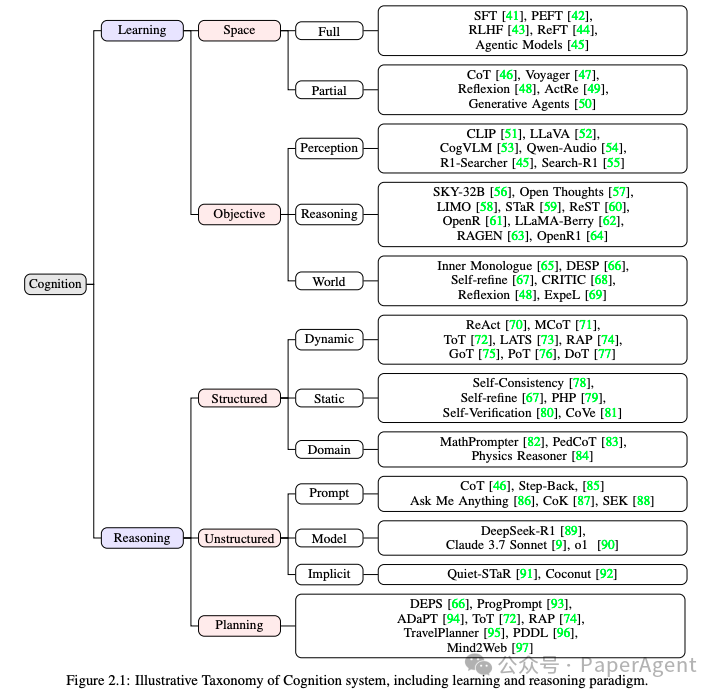

认知(Cognition):首先探讨学习,研究它在心理状态内部发生的空间以及它所服务的具体目标。随后,研究推理,分析结构化和非结构化的方法,最后专门探讨规划能力作为一种特殊的推理行为。

-

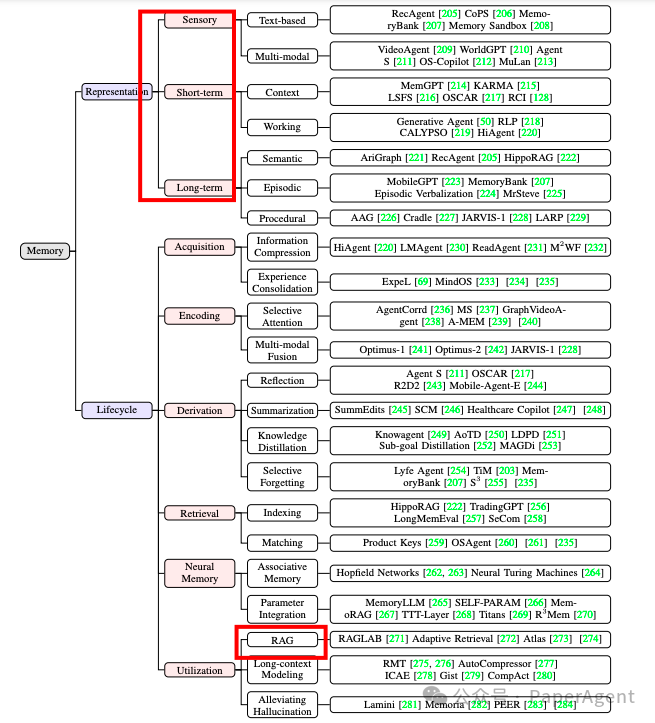

记忆(Memory):首先简要概述人类记忆,重点关注编码、巩固和检索等关键阶段。然后,将探讨设计人工智能代理记忆系统的多样化方法,从传统的符号表示到前沿的基于神经网络的方法。最后,将考虑如何从神经科学和认知心理学中汲取原则以指导未来研究。

-

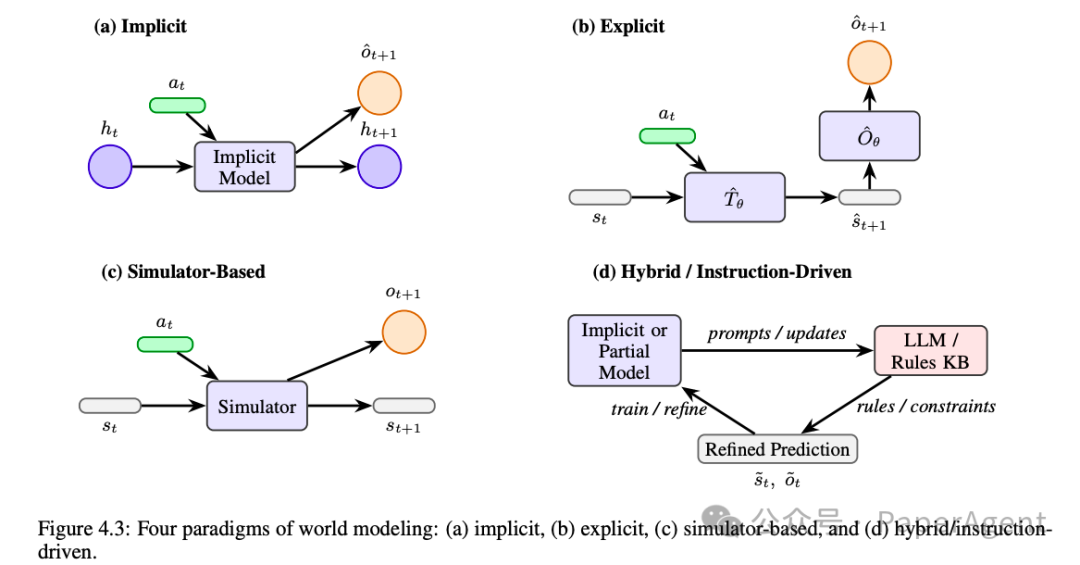

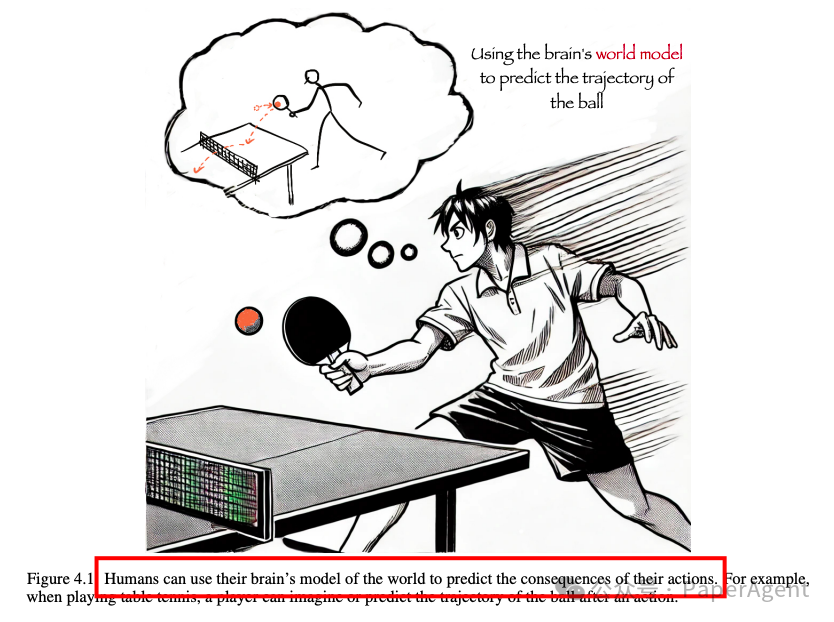

世界模型(World Model):探讨了人类认知研究中的“心理模型”与人工智能中的AI世界模型之间的关系,并将其归类为四种范式:隐式范式、显式范式、基于模拟器的范式以及一类其他新兴方法(例如,指令驱动范式)。

-

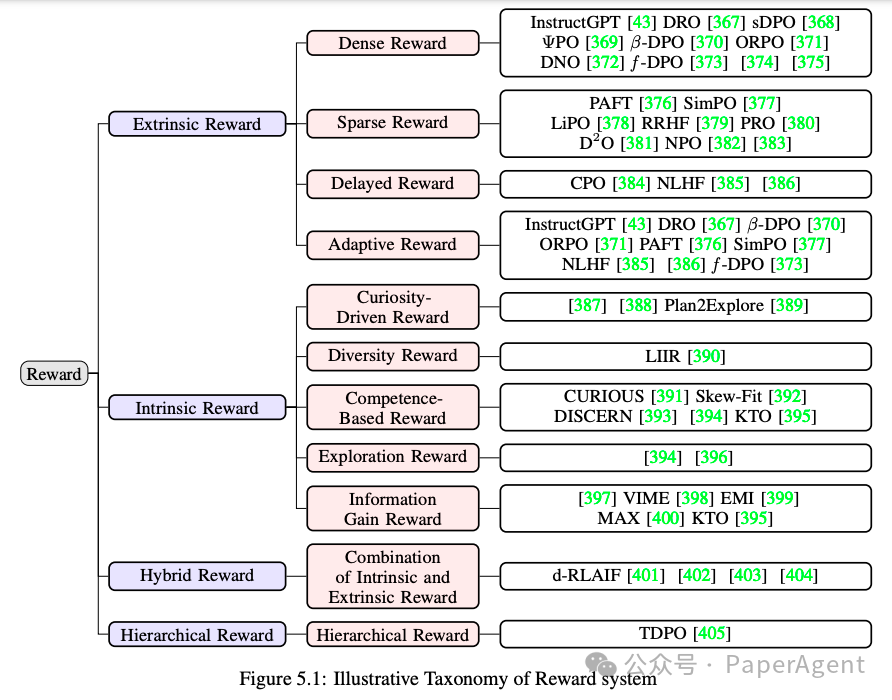

奖励(Reward):奖励帮助代理区分有益和有害的行动,塑造其学习过程并影响其决策制定。

-

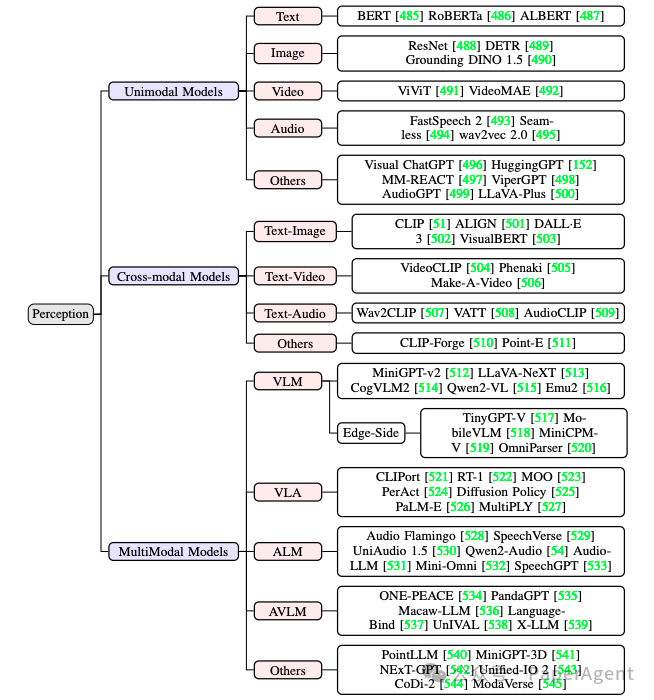

感知(Perception):感知是人类和智能Agent获取信息、解释周围环境并最终做出明智决策的基础途径

-

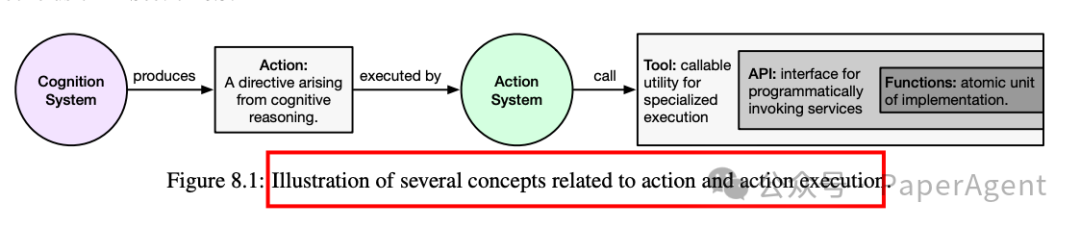

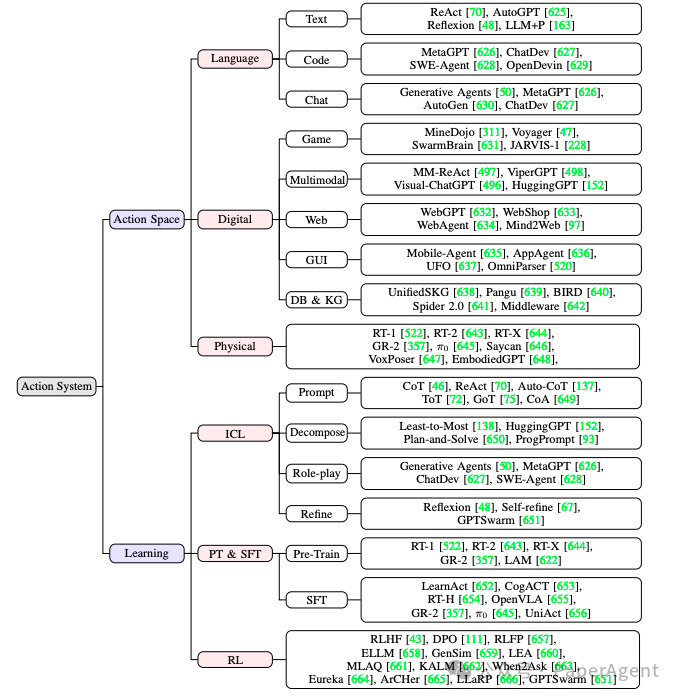

行动系统(Action System):基础模型为Agent奠定了基础,而行动系统决定了它们实现复杂目标的最终潜力

-

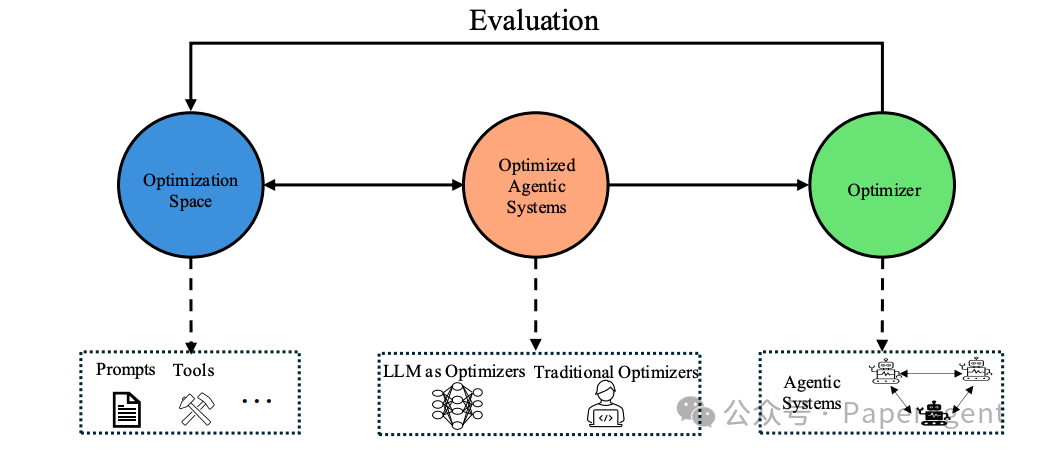

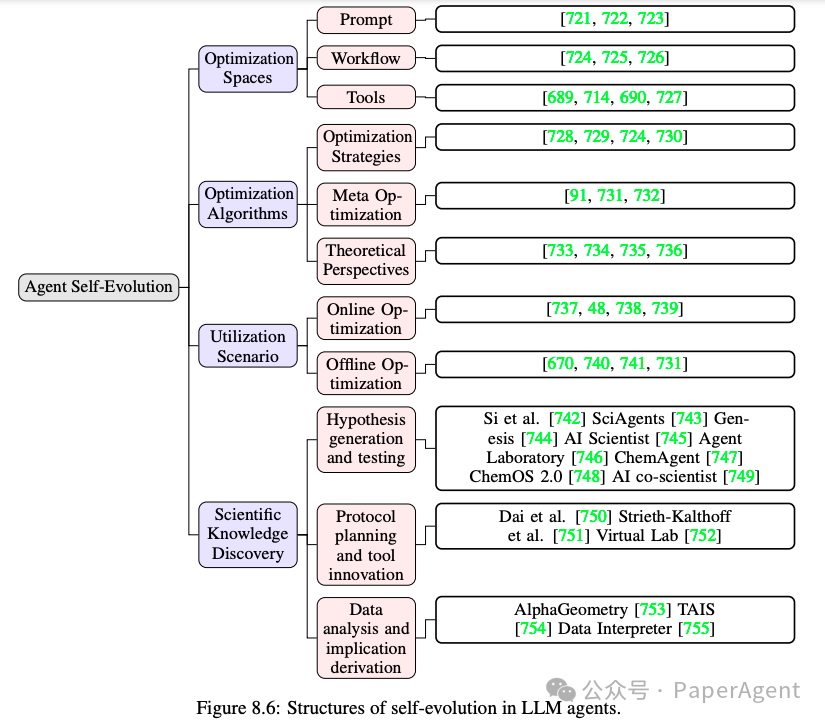

最近在代理系统研究中探索的各种优化空间,包括提示、工具和工作流程。

-

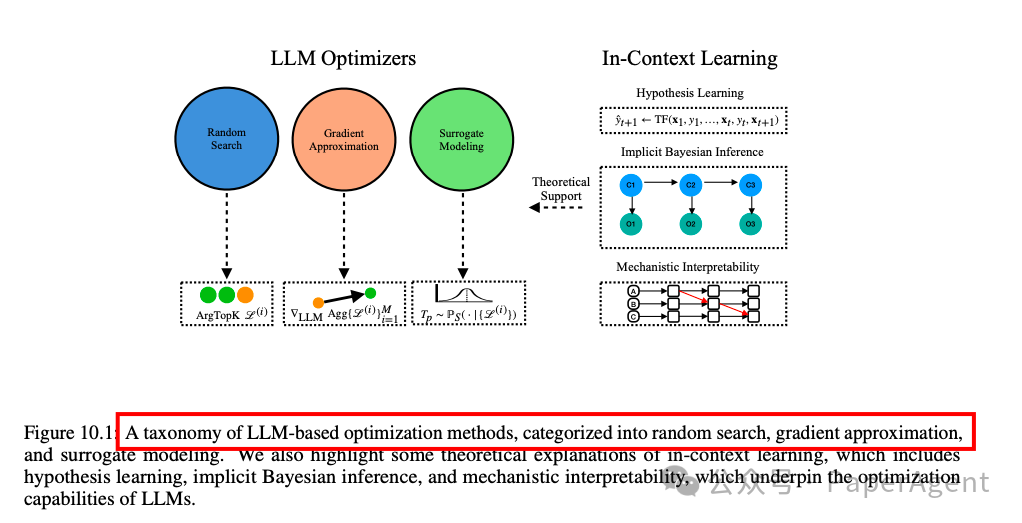

优化算法,讨论了传统的优化范式和元优化,其中优化过程也会影响底层的优化算法本身。 -

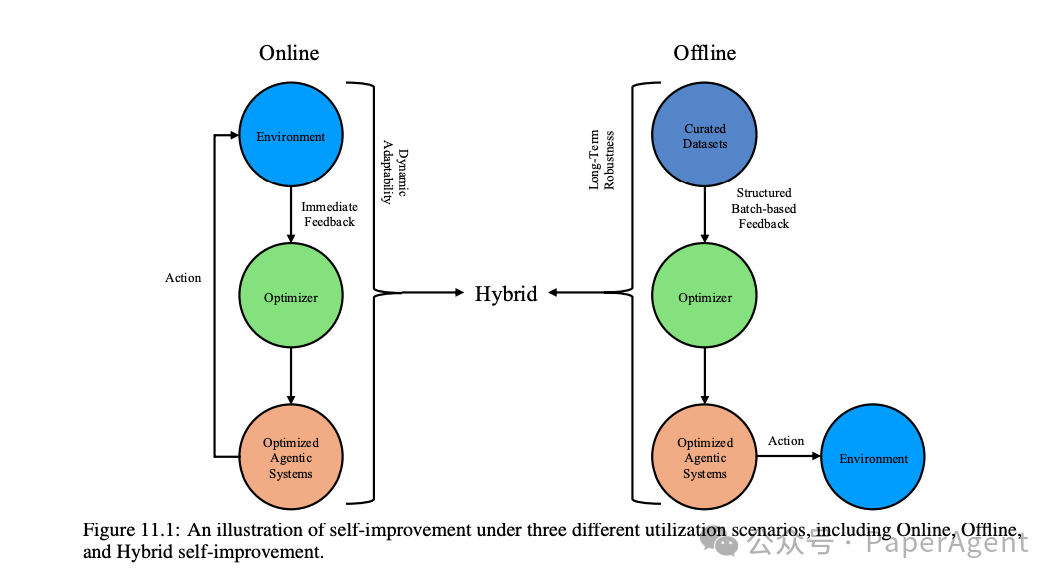

自我进化场景,将其分为两种类型:在线优化和离线优化。

-

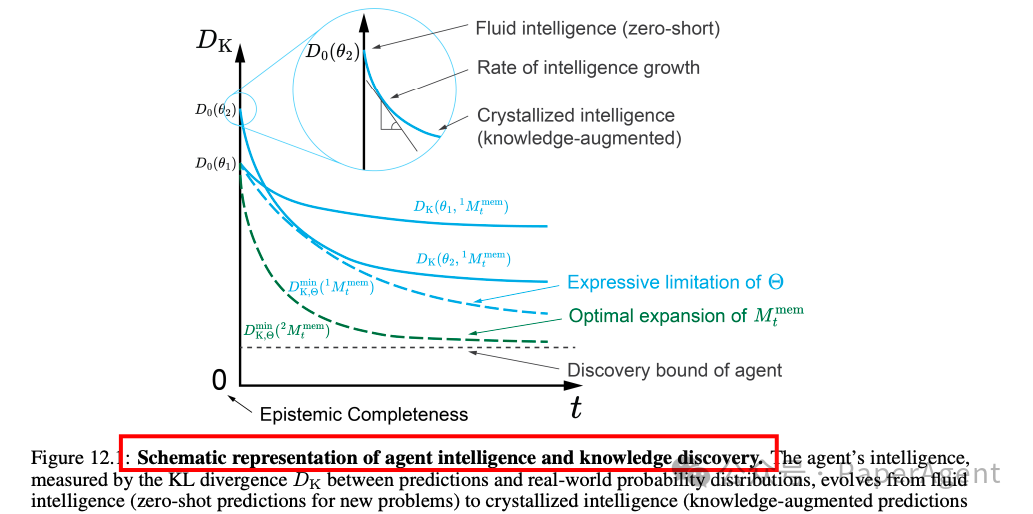

大型语言模型(LLM)代理自我改进技术的应用,特别是在人工智能用于科学(AI-for-science)领域的知识发现。

-

不同的系统目标如何塑造代理的角色、行为模式和协作策略。 -

分析了各种通信结构,包括促进有效代理间和人机通信的交互协议。 -

探讨了协作决策制定方法,以及代理如何利用其独特的专业知识和视角, -

讨论了集体智能和进化机制以及进化过程,重点介了适应性学习方法、持续的知识共享以及共同提升MAS性能的迭代改进机制。

https://arxiv.org/pdf/2504.01990Advances and Challenges in Foundation Agents: From Brain-Inspired Intelligence to Evolutionary, Collaborative, and Safe Systemshttps://github.com/FoundationAgents/awesome-foundation-agents

(文:PaperAgent)