英伟达官宣开源「超大杯」Llama Nemotron推理模型,共有253B参数,基于Llama-3.1-405B微调而来。在多项基准测试中,Llama Nemotron一举击败了两款Llama 4模型。而且仅用一半的参数,性能直逼DeepSeek R1。

尤其是,在复杂数学推理AIME(2024/2025)、科学推理GPQA Diamond、编码LiveCodeBnech中,新模型取得SOTA。相比DeepSeek R1 671B,它的推理吞吐量提升了4倍。

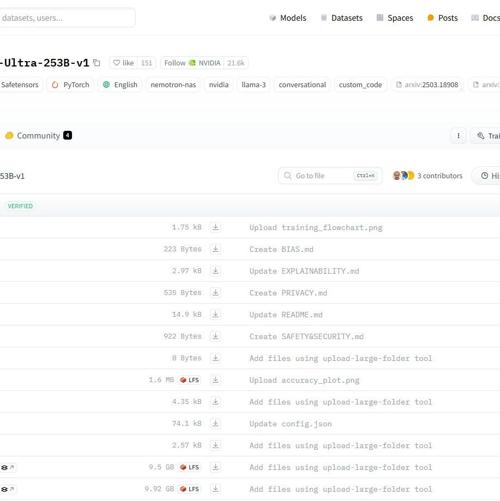

Llama-3.1-Nemotron-Ultra-253B-v1经过后期训练,专注于推理、人类聊天偏好和任务,如RAG(检索增强生成)和工具调用。它能支持128Ktoken的上下文长度,且能够在单个8xH100芯片节点上进行推理。

参考文献:

[1] https://huggingface.co/nvidia/Llama-3_1-Nemotron-Ultra-253B-v1

[2] https://developer.nvidia.com/blog/build-enterprise-ai-agents-with-advanced-open-nvidia-llama-nemotron-reasoning-models/

[3] https://build.nvidia.com/nvidia/llama-3_1-nemotron-ultra-253b-v1?ncid=so-twit-273200

(文:NLP工程化)