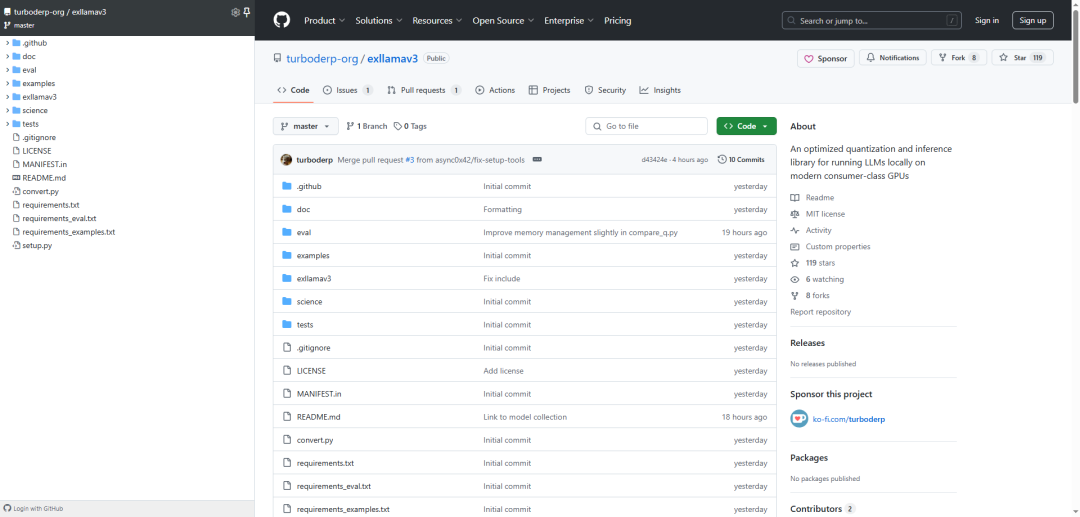

ExlLlamaV3:为现代消费级GPU优化的本地运行LLMs的量化和推理库。亮点:

-

支持多种架构,适配更多模型; -

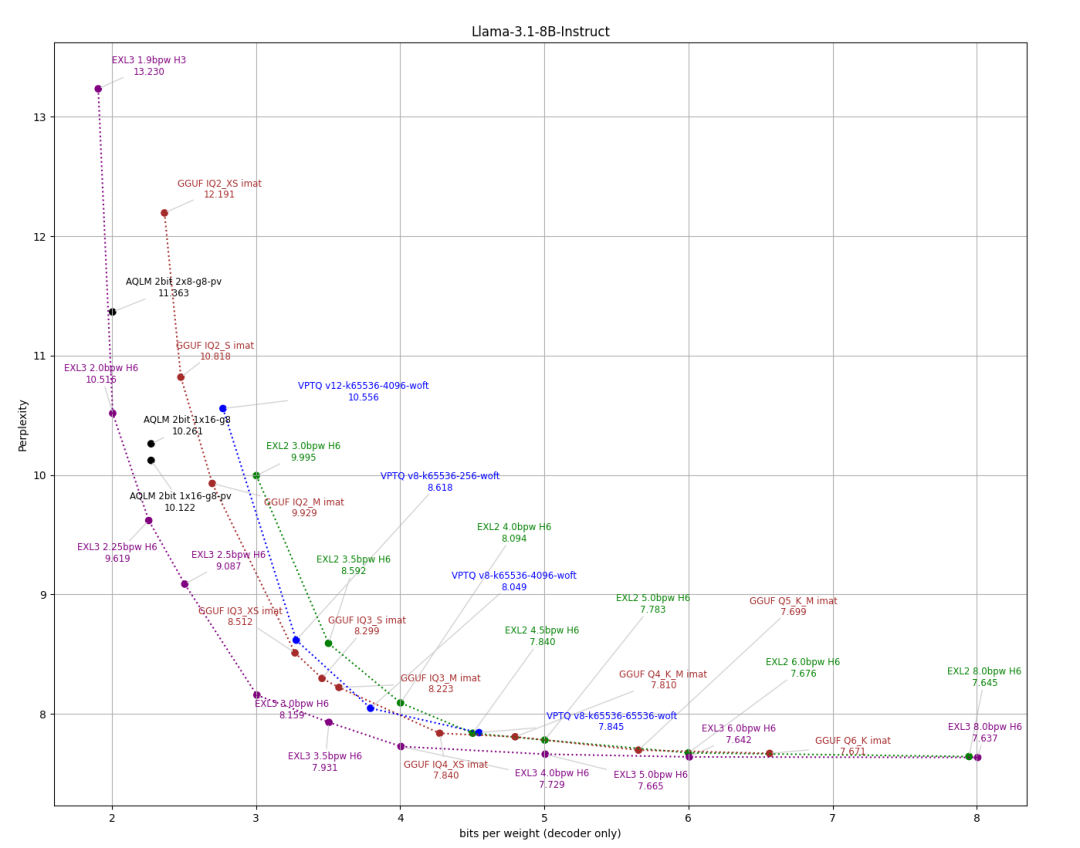

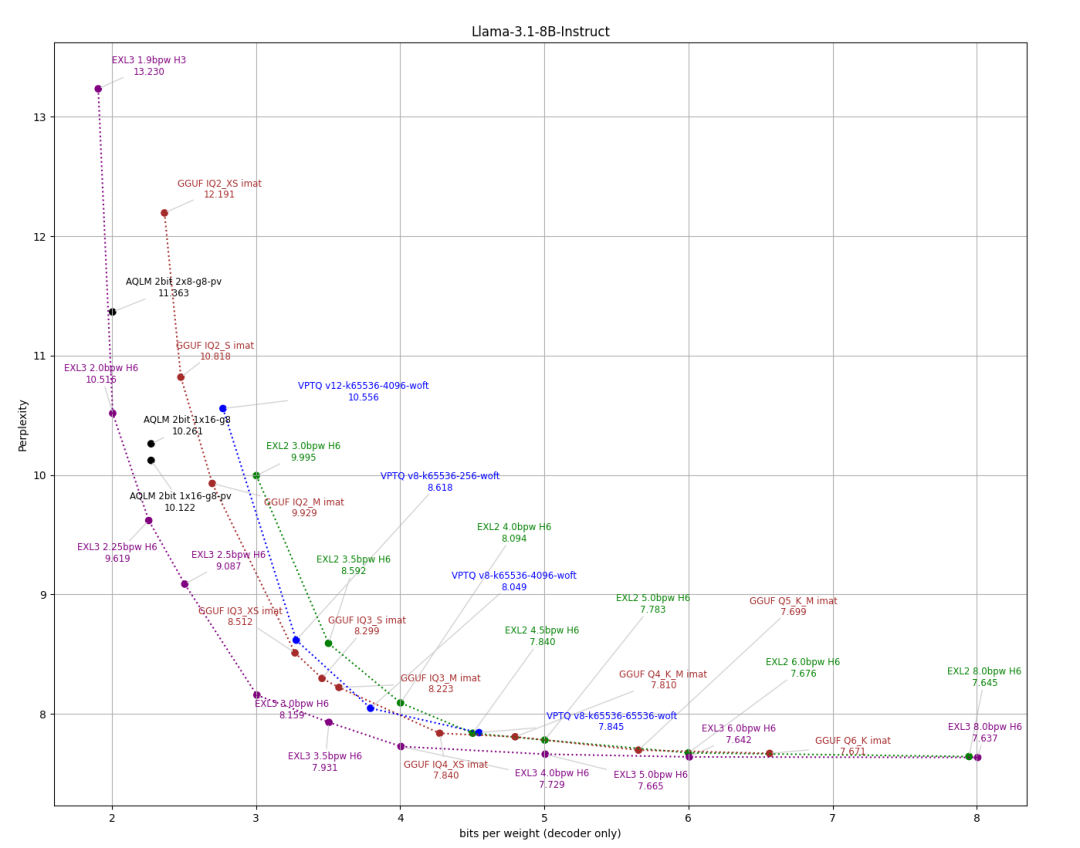

EXL3量化格式,高效转换,仅需几分钟到几小时; -

低内存需求,70B模型仅需16GB显存。

参考文献:

[1] http://github.com/turboderp-org/exllamav3

(文:NLP工程化)

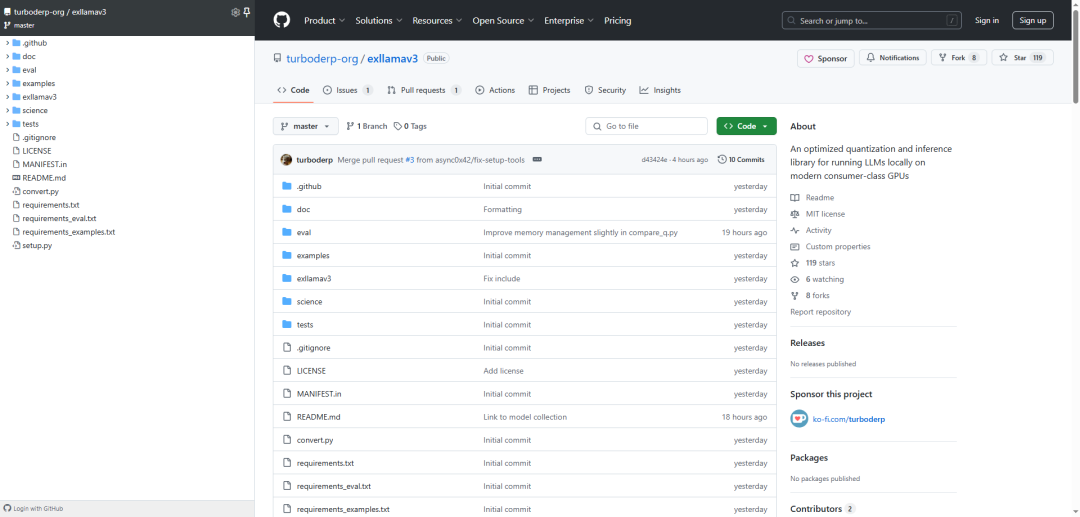

ExlLlamaV3:为现代消费级GPU优化的本地运行LLMs的量化和推理库。亮点:

参考文献:

[1] http://github.com/turboderp-org/exllamav3

(文:NLP工程化)