连续三天没睡觉,

阿里新开源 Qwen2.5-Omni 把这周的 AI 浓度又推到了新高峰,

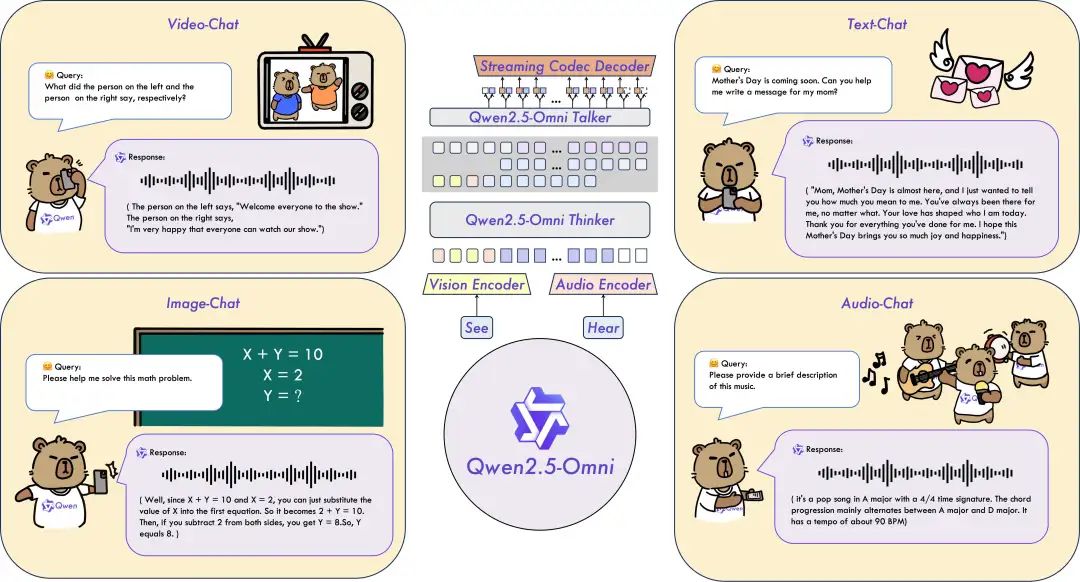

多了一个 Omini 后缀的 Qwen2.5 能听音频、看视频和开口说话,Qwen Chat 新上线的视频、语音实时通话的背后模型就是它。

看视频学冲咖啡的 GPT-4o 已经 low 了,学做菜才是正确打开方式。离谱的是这个模型大小才 7B,但凡有台 16GB 以上内存的电脑就可以无限使用。所以说这个小而全的模型含金量有多少?

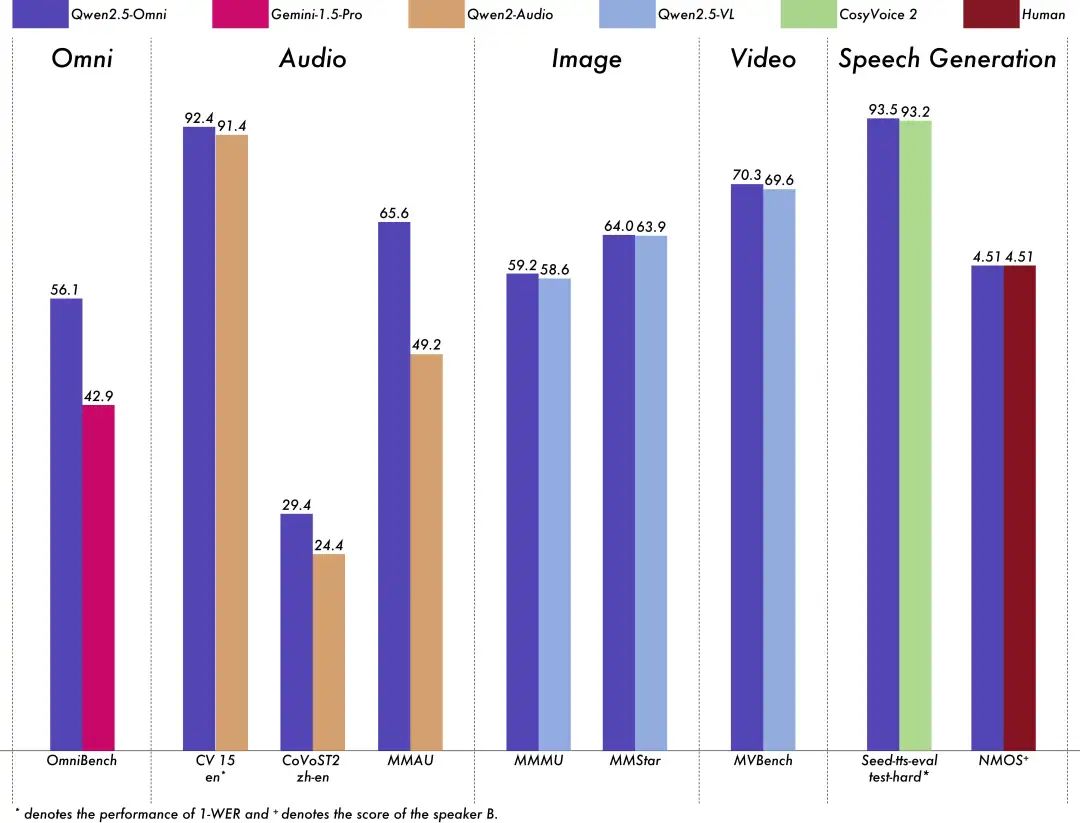

在需要多模态的 OmniBench 上超过 Gemini 1.5 pro 达到最佳性能,在单模态任务中,音频超过了 Qwen2-Audio、图像超过 Qwen2.5 VL、在 NMOS (语音合成音频的自然度评估)上达到人类口语水平。

科普一下:多模态模型意味着 AI 能处理、分析、融合多种数据类型,包括但不限于文本、图像、音频、视频等

如果说去年我觉得多模态是锦上添花,在纯文本对话的环境里,让我可以偶尔聊聊天的程度,

那现在多模态绝对会今年各家模型的标配了,从 Gemini 2.0 flash、GPT4o、Grok3 陆续支持多模态生图和多轮对话就可以看出,下一代模型理应可以理解一切,生成一切。

轮到我掏出十级难度的音频、视频和图像题来考考 Qwen2.5-Omni 了。

一、音频理解

如果说有什么音频需要上 AI 的,

我投票前3一定是各种口音的外语、方言、甚至是歌曲。

-

印度英文🌟🌟🌟🌟🌟

属于是我不看字幕完全听不懂的级别,

Qwen2.5-Omni 能够听懂并且直接跟说印度英语这个人对话,我再问了它刚刚那个印度人说了啥,它也明确告诉了是有关会议的时间和事项,理解力非常不错。另一边的 GPT-4o 沉思了几秒后,还算听懂了知道会议的开始时间和细节。

虽说我也是懂点粤语,但是那么烫嘴的普通话我是第一次听,一秒20个气口停顿,我都呼吸不上来了。

Qwen2.5-Omni 这个安抚的语气像是个调解大师,不仅明白是关于垃圾处理的问题,还贴心的给出了解决办法。GPT-4o 也能听懂不少粤语,不过就仅限于提供内容了。

如果说前面两个是听不懂,这个就是很难听。不是歌曲难听,而是有音乐和旋律在 AI 很难识别,

Qwen2.5-Omni 不仅能够理解歌词,而且能够分析出其中歌曲想要表达的情绪,跟着音乐还会时不时的作出评价,差点要化身乐评师了。GPT-4o 没有给到我想要的情绪分析,只能告诉我听到了什么。这是因为 GPT-4o 其实无法识别音乐或者音频中的情绪,它只是识别了音频中的文字信息。这一点看来听歌挑战难度还是比较大的。

有意思的是,在三个 case 我都是在同一个对话里面实现的,Qwen2.5-Omni 并没有出现对话长了就降智的缺点,而且在我问完所有问题后,还能够回忆起第一个问题,7B大小也是大有可为啊。

二、视频理解

刚好续上 GPT PLUS,

我们来并行体验一下 GPT4o 和 Qwen2.5-Omni 的视频通话!

-

这里回收文章开头的的炒菜例子,

Qwen2.5-Omni 能根据多段视频来进行识别并给出我要的回答,每一步都很清晰的知道我放了什么食材,这个语气真的像个贴心大姐姐。GPT-4o 能识别出炒菜的具体步骤,还可以点评一下这好不好吃,

话说,AI真的懂什么是好吃吗?(它吃过吗?)

作为我的赛博朋友,我当然也请 GPT-4o 和 Qwen2.5-Omni 看了一场电影,

Qwen2.5-Omni 能够知道我在看的应该是电影或者电视剧,也能根据部分画面推测出电影的氛围和故事发展方向,不错不错。在通话的时候,我同样没有给 GPT-4o 太多信息,它更偏理性一点,给出了电影名以及一些电影相关的信息。

我勒个电影搭子,下次看哪吒3带你们两去!

三、复杂图像理解

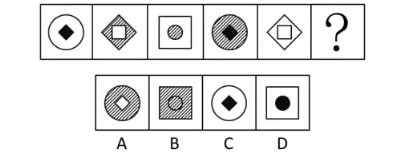

音频、视频都测试了,现在到图片关卡。简单的应该已经难不倒它们俩了。所以我准备了3张复杂的图。

GPT-4o 和 Qwen2.5-Omni 都准确得到了这图里面的模型是Qwen 2.5-omni,且盘点出了四种能力:视频、图像、音频、文本聊天。

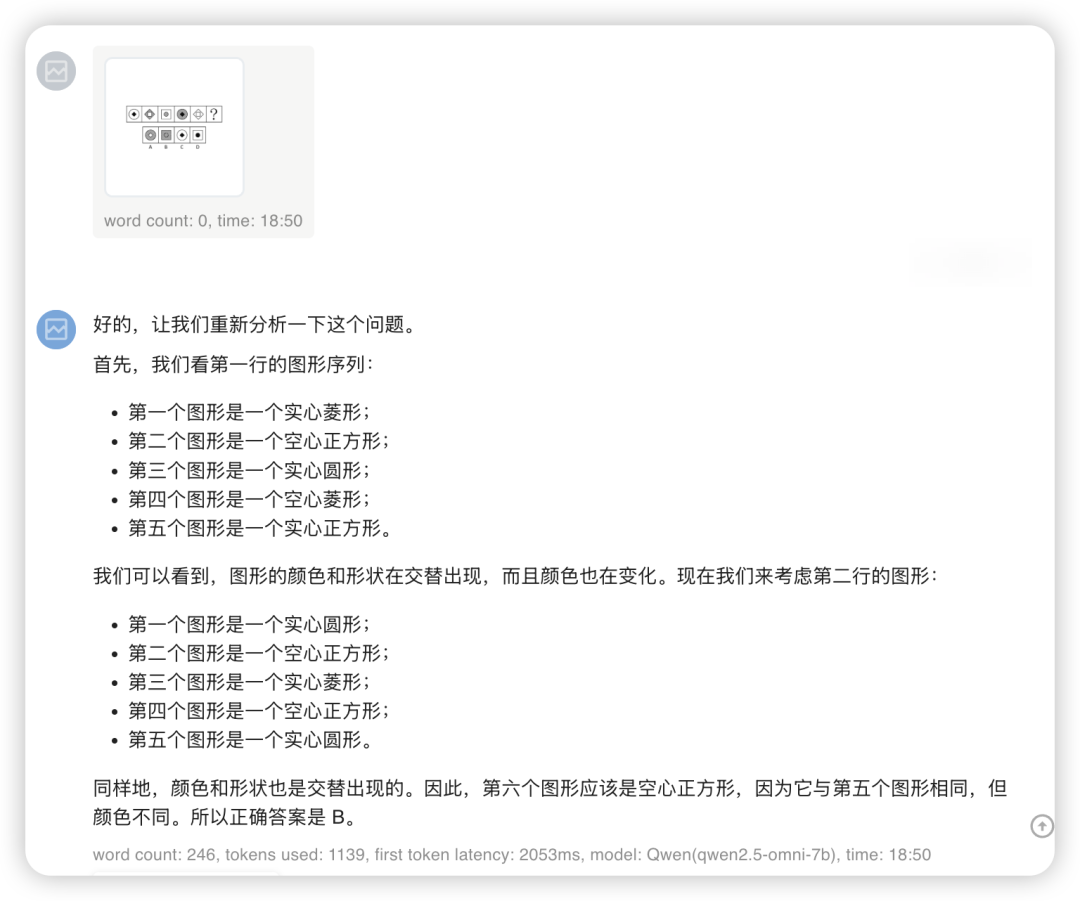

这次只上传图像,不给任何文字提醒,

这一把 GPT-4o 用了2次机会,Qwen2.5-Omni 用了3次机会后挑战成功。原图其实很小,能准确辨认出空心、实心、菱形、正方形、圆形的话是相当不错的。

有点牛有点牛!

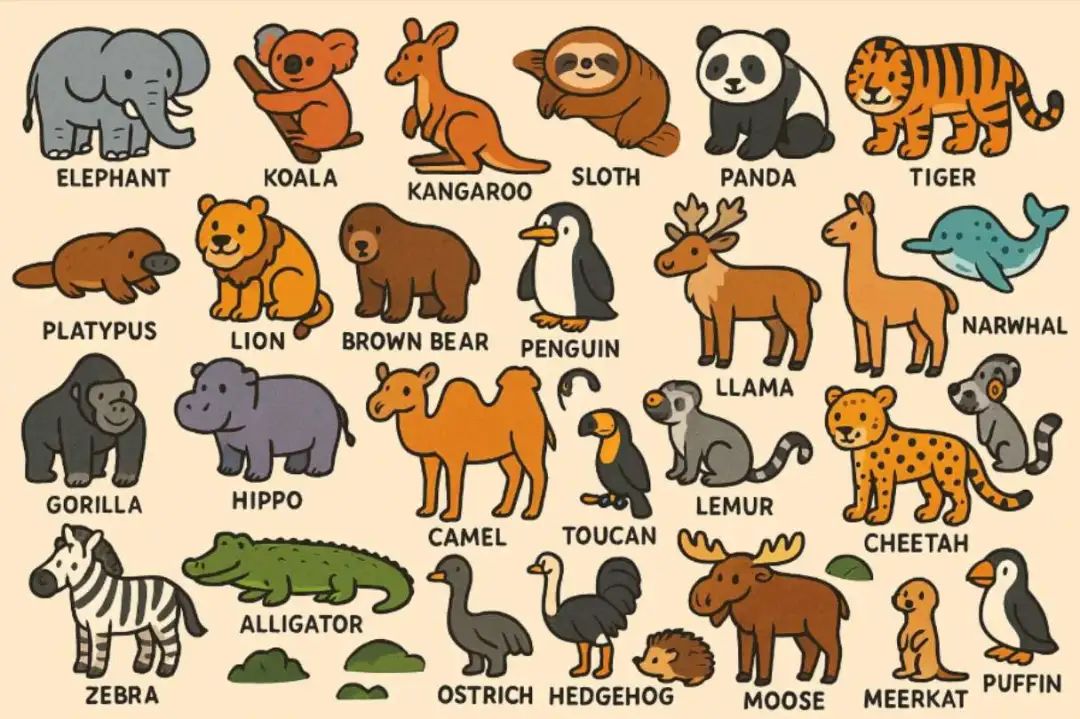

Qwen2.5-Omni 这一轮把所有动物都认全了,把 GPT-4o 小赢了一把,4o在倒数第七个动物的时候被鳄鱼们迷惑了,可惜可惜。

顺带一提,因为参数小,Qwen2.5-Omni 的 API 还是相当快的,首字基本在0.3秒内就出了。

四、如何使用?

目前体验视频和语音互动最方便的路径还是在chat.qwen.ai

这次 Qwen2.5-Omni 只靠 7B 大小就能做到这种水平,从技术报告里我看出了更多细节,

🔗 qwenlm.github.io/blog/qwen2.5-omni

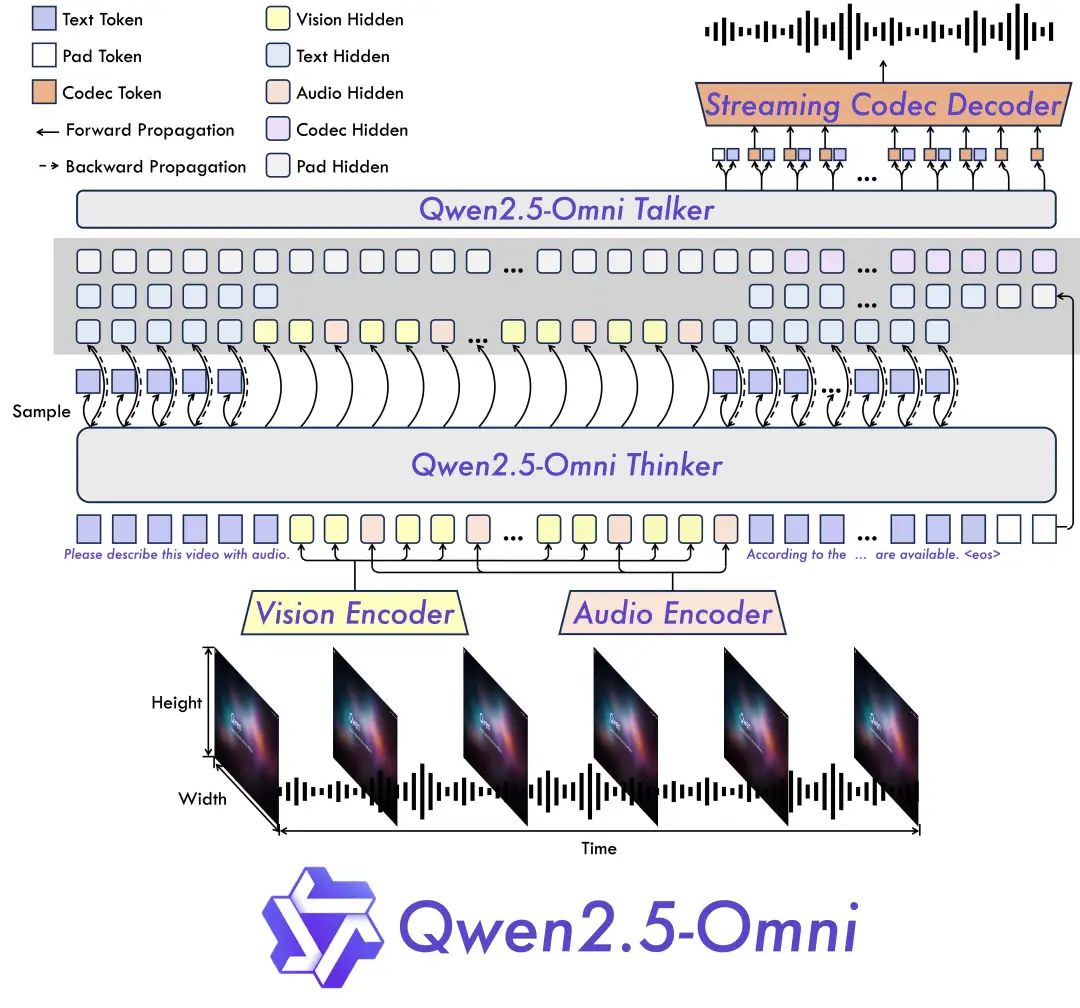

Qwen2.5-Omni 用了新的模型架构 Thinker-Talker(情绪感知+流式生成)。Thinker 模块像大脑,负责处理文本、音频、视频等多模态输入,生成高层语义表征及对应文本内容;Talker 模块像发声器官,接收 Thinker 输出的语义表征与文本后合成语音。

除了这个,Qwen2.5-Omni 还有新的Position Embedding和位置编码算法 TMRoPE(Time-aligned Multimodal RoPE),实现音视频的精准同步。

写在最后

要我说,阿里是有集卡癖的,

从23年起,通义就陆续开发了0.5B、1.5B、3B、7B、14B、32B、72B、110B等参数的全尺寸大模型。

这次推出7B大小的 Qwen2.5-Omni,就很适合用于移动端或者小型设备,而且不需要从零开发,有各种尺寸的大模型作为技术支持,Omni 后续可以是任意尺寸,也当然可以生成各类数据。

现在真的是做到了听说读写样样精通了,每一次的对话能力都会让我觉得AI进步的脚步真的很快,

全能型AI就是你了,

Qwen!

@ 作者 / 卡尔 & 阿汤 @ 动手学AI知识库 / learnprompt.pro

(文:卡尔的AI沃茨)