LLM MOE的进化之路,从普通简化 MOE,到 sparse moe,再到 deepseek 使用的 share_expert sparse moe。本次课一共讲解三个不同版本的 MOE。

-

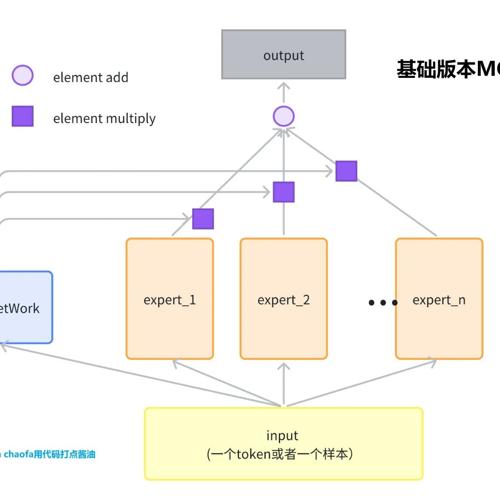

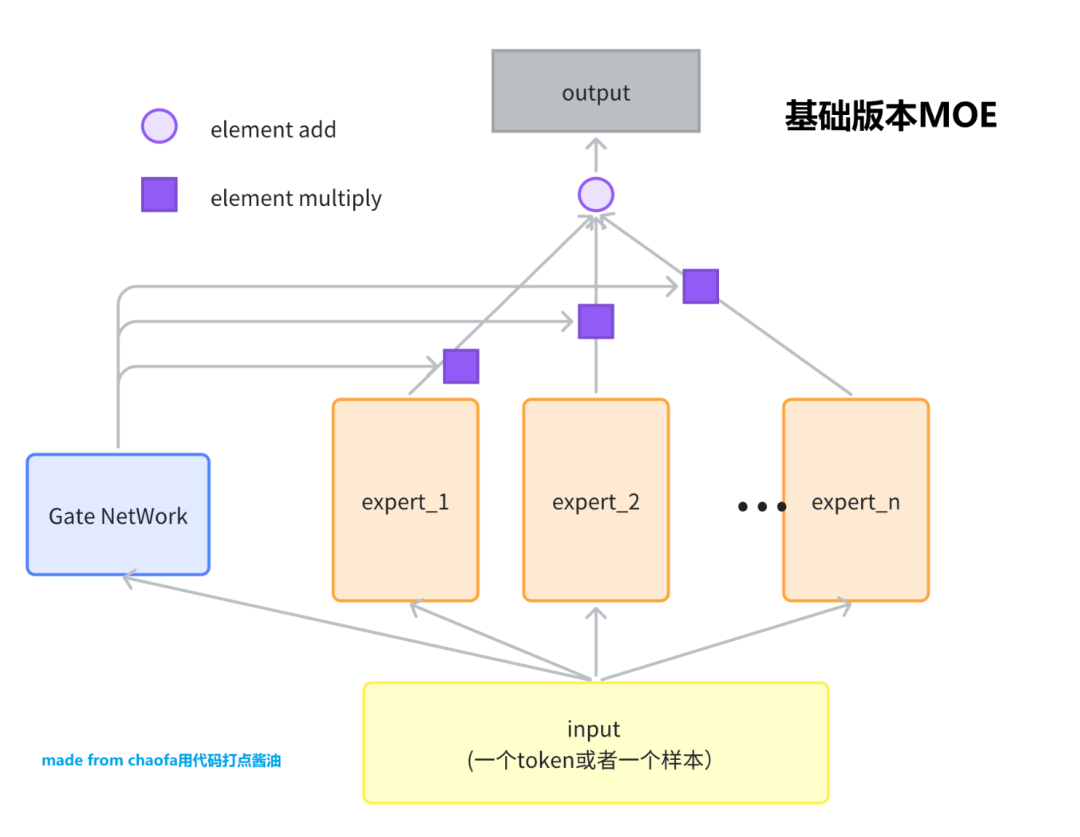

基础版MOE。理解 MOE 在干什么? -

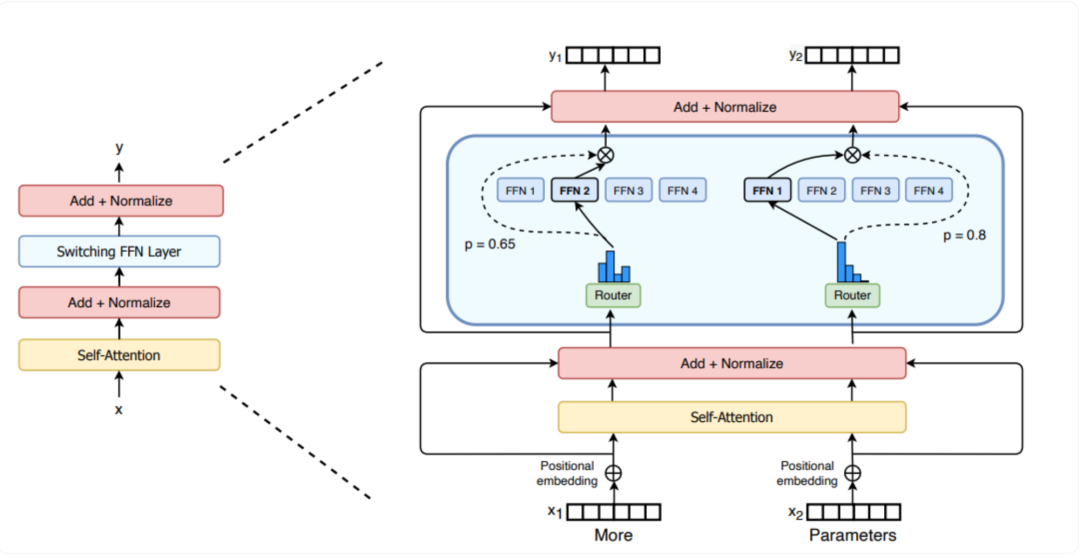

大模型训练用的 SparseMoE。了解大模型怎么做 MOE 训练? -

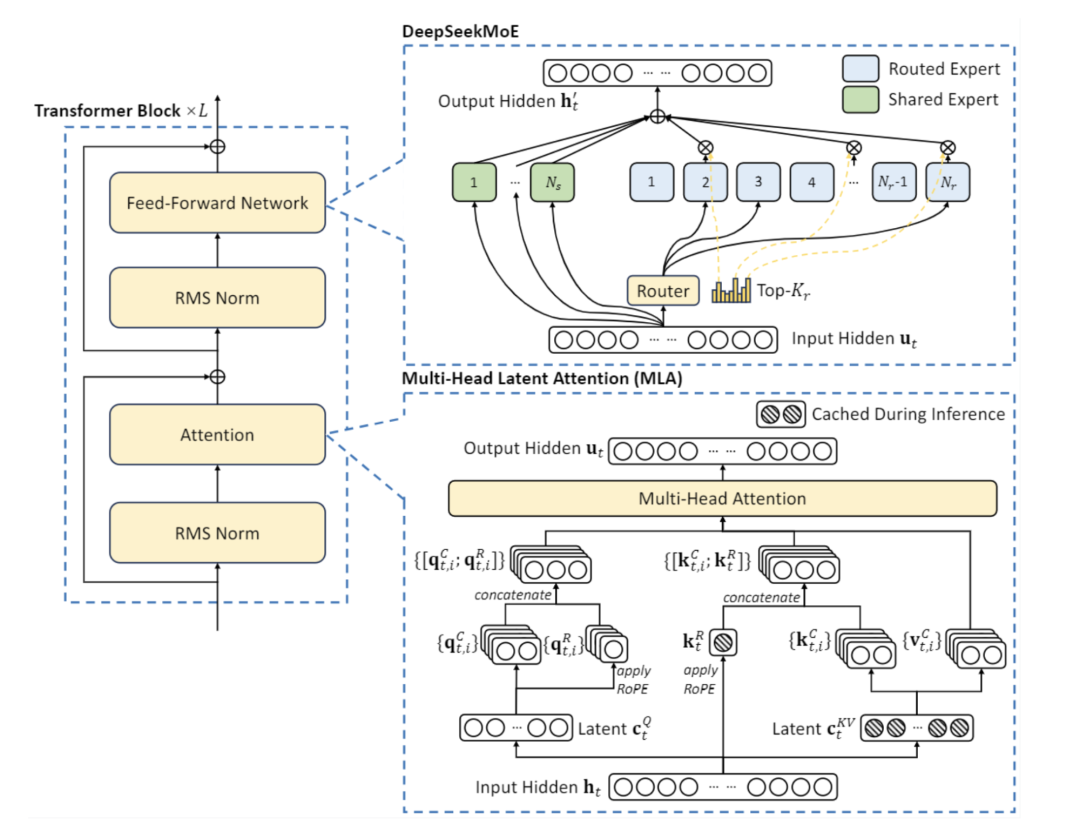

Deepseek 用的 shared_expert SparseMoE。了解 MOE 模型如何进化?

参考文献:

[1] https://bruceyuan.com/llms-zero-to-hero/the-way-of-moe-model-evolution.html

(文:NLP工程化)