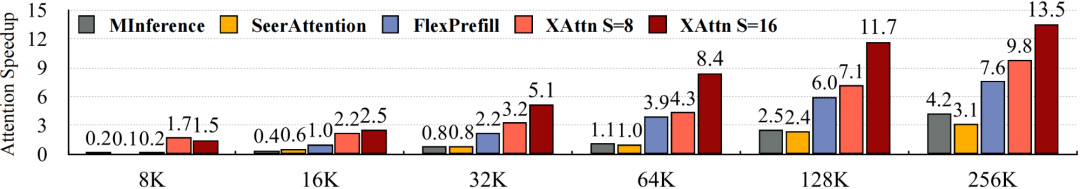

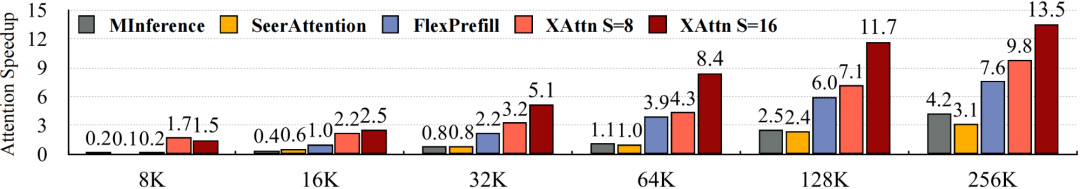

XAttention:一种高效的Transformer注意力机制,让长文本处理速度提升13.5倍!亮点:

-

基于对角线和的轻量级指标,精准识别重要注意力块;

-

在长文本、视频生成和理解等多个场景表现出色;

-

无需牺牲精度即可实现加速。

参考文献:

[1] http://github.com/mit-han-lab/x-attention

[2] https://arxiv.org/abs/2503.16428

(文:NLP工程化)

XAttention:一种高效的Transformer注意力机制,让长文本处理速度提升13.5倍!亮点:

基于对角线和的轻量级指标,精准识别重要注意力块;

在长文本、视频生成和理解等多个场景表现出色;

无需牺牲精度即可实现加速。

参考文献:

[1] http://github.com/mit-han-lab/x-attention

[2] https://arxiv.org/abs/2503.16428

(文:NLP工程化)