随着 OpenAI o1 向社区展示了思维链 Chain-of-Thought(CoT)对于大模型推理能力的强大提升,各种基于强化学习 RL 和提升 test-time 推理成本的方案已经在大模型理解领域取得了很大的进展。

然而,在图像生成(Image Generation)领域,例如文生图(Text-to-Image)与文生视频(Text-to-Video),我们是否也可以借鉴 CoT 相关的策略,来提升图片或视频的质量和文本一致性呢?

来自香港中文大学、北京大学、和上海 AI Lab 的研究者们通过 Verify 和 Reinforce 的方案,系统地探索了“CoT 推理+文生图”的结合与潜力。研究结果表明,这些方法能够有效提升自回归(Autoregressive)图像生成的质量。

作者也提出了两种专门针对该任务的新型奖励模型——潜力评估奖励模型(Potential Assessment Reward Model, PARM) 及其增强版本 PARM++,后者引入了反思机制(Reflection Mechanism),进一步优化了图像生成质量。

Can We Generate Images with CoT? Let’s Verify and Reinforce Image Generation Step by Step

论文链接:

https://arxiv.org/pdf/2501.13926

代码链接:

https://github.com/ZiyuGuo99/Image-Generation-CoT

研究背景与挑战

目前,CoT 推理已广泛应用于大语言模型(LLM)和多模态大模型(LMM),尤其在数学推理、科学计算等任务上展现出卓越的能力。然而,在自回归图像生成任务中,如何有效地验证(Verify)和强化(Reinforce)图像生成过程,仍是一个尚未解决的问题。

下图左边部分是目前领域使用“CoT 推理+解数学题”的方案概述,而右边部分则是本文对于“CoT 推理+文生图”的全面探索。研究团队观察到,自回归图像生成与 LLM/LMM 具有类似的推理架构,即:

1. 离散化 Token 表示:无论是语言还是图像数据,自回归模型都将其量化为离散 Token,并通过逐步预测的方式进行生成。

2. 逐步解码(Step-by-Step Decoding):类似于 CoT 在数学问题上的逐步推理,自回归图像生成也可以逐步生成中间图像,并在生成过程中进行验证与优化。

CoT如何应用于图像生成?

考虑到 Autoregressive 图像生成和 LLM 在数据表征和推理架构的相似性,论文调研了包括使用 ORM 和 PRM 的 Test-time Verification、构造 Preference Ranking Data、和通过 DPO 进行偏好对齐等方案,首次证明了“CoT+文生图”的可行性!

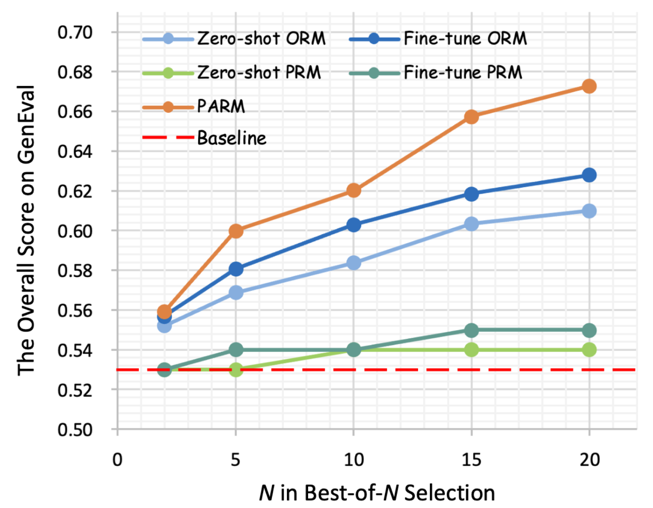

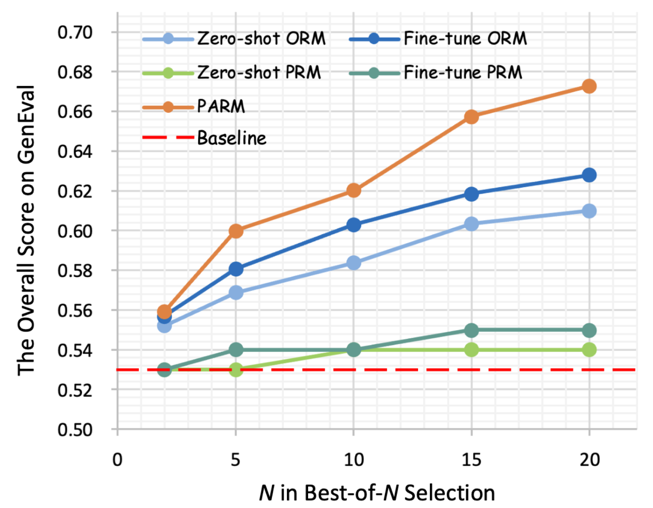

本文也提出了两种新型的 reward model,PARM 和 PARM++,来优化图像生成质量。如下图所示,通过本文探索的推理策略,大幅度提升了 Autoregressive Image Generation 的效果。

具体方案

本文的探索以“文生图”为任务场景,并使用了 Show-o 来作为 baseline 模型,主要分为 3 个部分:

3.1 测试时验证(Test-time Verification)

首先,论文探索如何使用奖励模型(Reward Model, RM) 来进行 Test-time Verification,实现了 Outcome Reward Model(ORM,下图左边部分)和 Process Reward Model(PRM,下图中间部分)方案,并在两者的基础上提出了一种全新的针对于图像生成任务的 Potential Assessment Reward Model(PARM,下图右边部分)。

3.1.1 结果奖励模型(Outcome Reward Model, ORM)

论文提出了 2 种方案,均使用 Best-of-N 的方式进行验证,即进行多次完整路径的生成,并从中选择出质量最高的最终图片。

Zero-shot ORM:基于 LLaVA-OneVision 强大的图像理解能力,作者使用了其 7B 模型,直接作为 zero-shot ORM 使用,并通过下面的 prompt 来激发其作为文生图质量评估的能力:

Fine-tuned ORM:为了进一步增强 ORM 的专业性能,作者也构建了大规模的图文 reward data 来得到 fine-tuned ORM,数据形式如下图所示:

3.1.2 过程奖励模型(Process Reward Model, PRM)

作者使用了类似 ORM 的方案,同样尝试了 Zero-shot 和 Fine-tuned 两种方案,并对每个 step 进行 Best-of-N 的方案,即逐步选择出质量最高的中间阶段的生成图片。

然而,作者发现这种 naive 的 PRM 无法对图像生成有显著的提升。通过可视化,作者发现:PRM 在早期生成阶段由于图像模糊而难以评估,而在后期生成阶段不同路径的图片趋于相似,导致辨别能力受限,如下图所示。

3.1.3 潜力评估奖励模型(Potential Assessment Reward Model, PARM)

为了同时结合 ORM 的简洁和有效性,以及 PRM 细粒度逐个 step 验证的思想,作者提出了一个专门针对 Autoregressive 图像生成任务的 reward model:Potential Assessment Reward Model(PARM)。PARM 通过以下三步提升图像生成质量:

1. 清晰度判断(Clarity Judgment):识别哪些中间步骤的图像已经足够清晰,可用于后续评估。

2. 潜力性评估(Potential Assessment):分析当前步骤是否有潜力生成高质量的最终图像。

3. 最佳选择(Best-of-N’ Selection):在高潜力路径中选择最佳的最终图像。

3.1.4 潜力评估奖励模型++(Potential Assessment Reward Model++,PARM++)

如下图所示,在 PARM 的基础上,作者提出了 PARM++,使模型能够在生成错误时进行自我修正。

具体来说,基于 PARM 选出的最终图片,作者首先使用 PARM++ 评估生成图片是否符合文本描述;若图片不符合要求,会要求 RM 提供详细的错误描述,并根据该描述,要求生成模型进行自我修正(Self-correction),即模型接收反馈,并参考错误信息重新生成结果。

结果表明,PARM++ 进一步提升 GenEval +10%。如下图右边所示,生成结果在物体数量、颜色、空间关系等方面更加准确。

3.2 直接偏好优化(Direct Preference Optimization, DPO)Alignment

作者进一步引入 DPO 偏好对齐,即使用大规模排名数据训练模型,使其生成结果更符合人类偏好。研究团队构建了 288K 条图文排名数据(Text-to-Image Ranking Data)用于训练。具体来说,训练过程是采用最大似然优化,调整模型输出,使其更偏向人类偏好。

同时,论文也进一步使用迭代 DPO(Iterative DPO),在模型优化后重新生成新数据进行再次训练。结果表明,初次 DPO 训练使模型在 GenEval 性能提升 +9%,而迭代 DPO 进一步提高至 +12%,超越 Fine-tuned ORM。

3.3 Test-time Verification + DPO Alignment

在前述两种方法的基础上,作者探索了将 Test-time Verification 与 DPO 对齐相结合的策略,以实现端到端的优化。在 DPO 训练的模型基础上,进一步应用 Test-time Verification 进行筛选,使生成图像质量更高,文本一致性更强。

实验结果表明,结合 DPO 和 Test-time Verification 后,模型在 GenEval 指标上的整体提升达 +27%,超越单独使用 DPO 或 Test-time Verification 的方案。

总体效果对比

4.1 推理准确性表现

下表展示了模型在 GenEval 基准上的总体性能比较,相比于现有的扩散模型和自回归模型,结果证明了在文本生成图像任务中使用 CoT 推理策略的潜力。

结论

本研究首次系统性探索了 CoT 推理策略在自回归图像生成中的适应性及潜力。通过全面的实验分析证明了不同的推理策略(如测试时验证、偏好对齐及其结合)能够有效提升图像生成质量。

基于这些观察,本文进一步提出了两种专门针对自回归图像生成的奖励模型——潜在评估奖励模型(PARM)和 PARM++,前者能够对逐步生成过程进行自适应奖励评分,后者则结合了反思机制(Self-reflection),实现自我修正的图像生成。

实验结果表明,CoT 推理在自回归图像生成任务中展现出了巨大的潜力,为该领域的发展开辟了新的方向, 也为大模型推理能力的进一步提升奠定了基础!

(文:PaperWeekly)