AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

江中华,浙江大学软件学院硕士生二年级,导师为张圣宇老师。研究方向为大小模型端云协同计算。张圣宇,浙江大学平台「百人计划」研究员。研究方向包括大小模型端云协同计算,多媒体分析与数据挖掘。

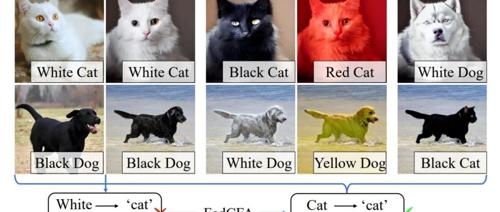

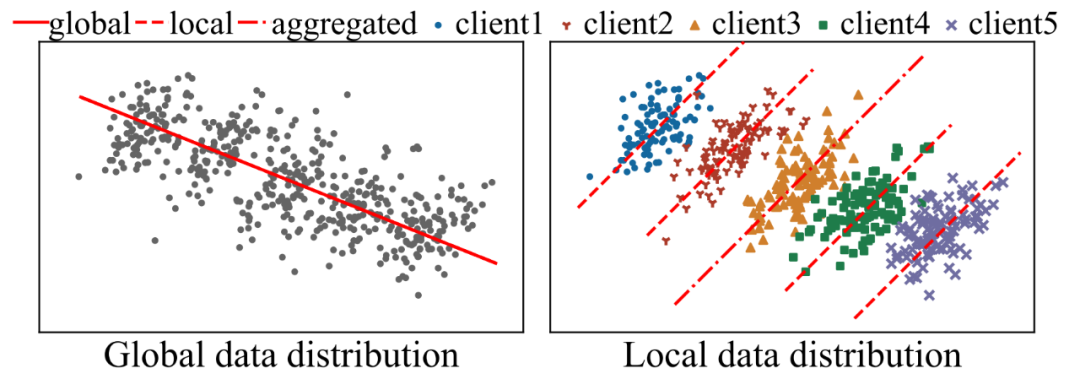

随着机器学习技术的发展,隐私保护和分布式优化的需求日益增长。联邦学习作为一种分布式机器学习技术,允许多个客户端在不共享数据的情况下协同训练模型,从而有效地保护了用户隐私。然而,每个客户端的数据可能各不相同,有的数据量大,有的数据量小;有的数据特征丰富,有的数据特征单一。这种数据的异质性和不平衡性(Non-IID)会导致一个问题:本地训练的客户模型忽视了全局数据中明显的更广泛的模式,聚合的全局模型可能无法准确反映所有客户端的数据分布,甚至可能出现「辛普森悖论」—— 多端各自数据分布趋势相近,但与多端全局数据分布趋势相悖。

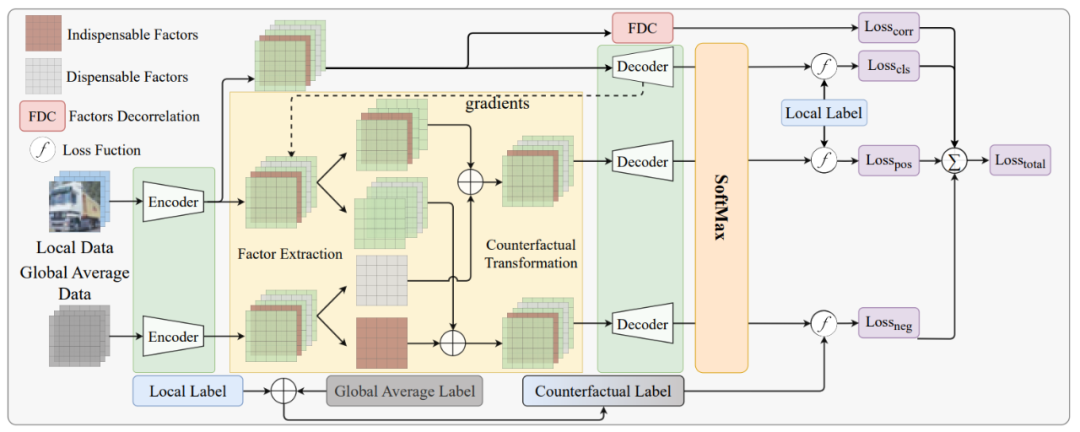

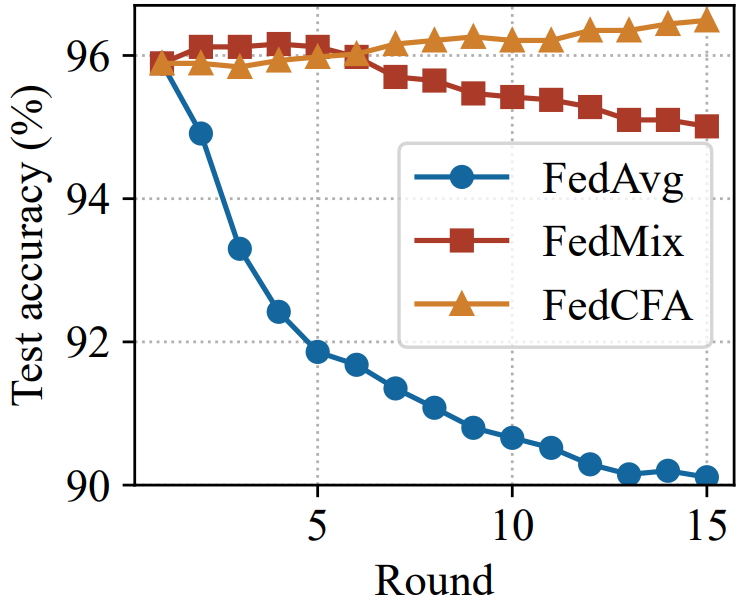

为了解决这一问题,来自浙江大学人工智能研究所的研究团队提出了 FedCFA,一个基于反事实学习的新型联邦学习框架。

FedCFA 引入了端侧反事实学习机制,通过在客户端本地生成与全局平均数据对齐的反事实样本,缓解端侧数据中存在的偏见,从而有效避免模型学习到错误的特征 – 标签关联。该研究已被 AAAI 2025 接收。

-

论文标题:FedCFA: Alleviating Simpson’s Paradox in Model Aggregation with Counterfactual Federated Learning -

论文链接:https://arxiv.org/abs/2412.18904 -

项目地址:https://github.com/hua-zi/FedCFA

,则当 n 足够大时,

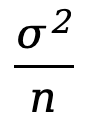

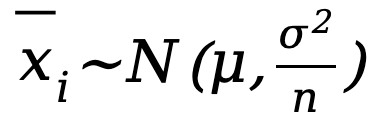

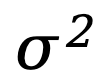

,则当 n 足够大时, 的分布趋于正态分布,其均值为 μ,方差

的分布趋于正态分布,其均值为 μ,方差 ,即:

,即: ,其中 µ 和

,其中 µ 和 是原始数据集的期望和方差。

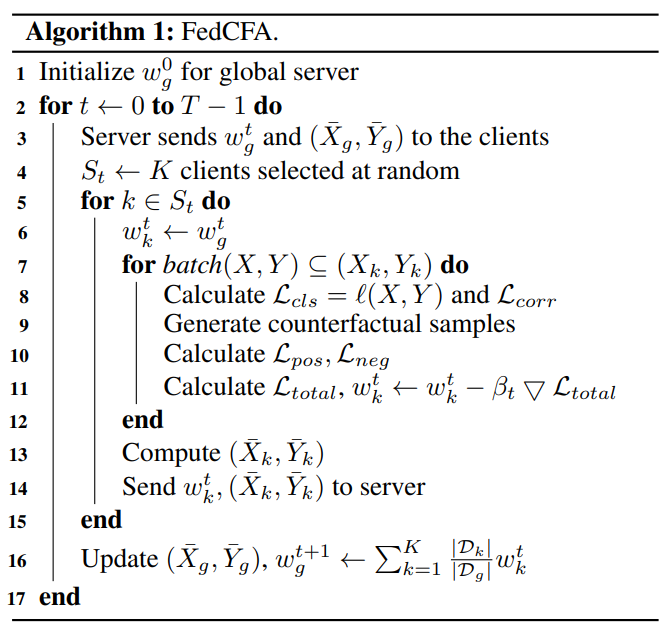

是原始数据集的期望和方差。 能更精细地捕捉数据集的局部特征与变化,特别是在保留数据分布尾部和异常值附近的细节方面表现突出。相反,随着 n 的增大,

能更精细地捕捉数据集的局部特征与变化,特别是在保留数据分布尾部和异常值附近的细节方面表现突出。相反,随着 n 的增大, 的稳定性显著提升,其方差明显减小,从而使其作为总体均值 𝜇 的估计更为稳健可靠,对异常值的敏感度大幅降低。此外,在联邦学习等分布式计算场景中,为了实现通信成本的有效控制,选择较大的 n 作为样本量被视为一种优化策略。

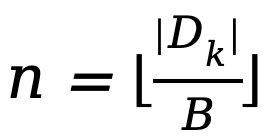

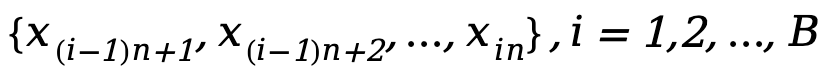

的稳定性显著提升,其方差明显减小,从而使其作为总体均值 𝜇 的估计更为稳健可靠,对异常值的敏感度大幅降低。此外,在联邦学习等分布式计算场景中,为了实现通信成本的有效控制,选择较大的 n 作为样本量被视为一种优化策略。 的子集

的子集 ,其中

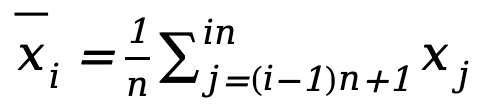

,其中 为客户端数据集大小。对于每个子集,计算其平均值

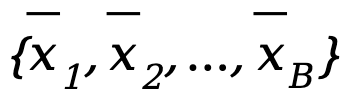

为客户端数据集大小。对于每个子集,计算其平均值 。由此,客户端能够生成本地平均数据集

。由此,客户端能够生成本地平均数据集 以近似客户端原始数据的分布。

以近似客户端原始数据的分布。 ,该数据集近似了全局数据的分布。对于标签 Y,FedCFA 采取相同的计算策略,生成其对应的全局平均数据标签

,该数据集近似了全局数据的分布。对于标签 Y,FedCFA 采取相同的计算策略,生成其对应的全局平均数据标签 。最终得到完整的全局平均数据集

。最终得到完整的全局平均数据集

。

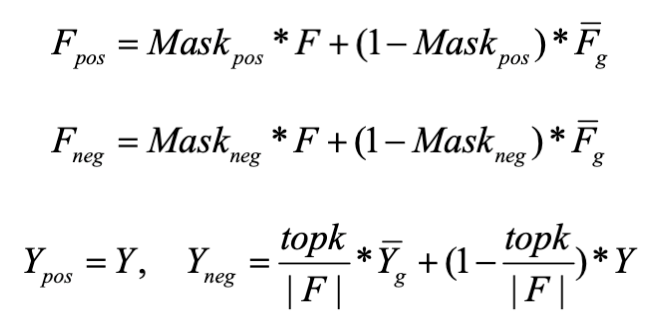

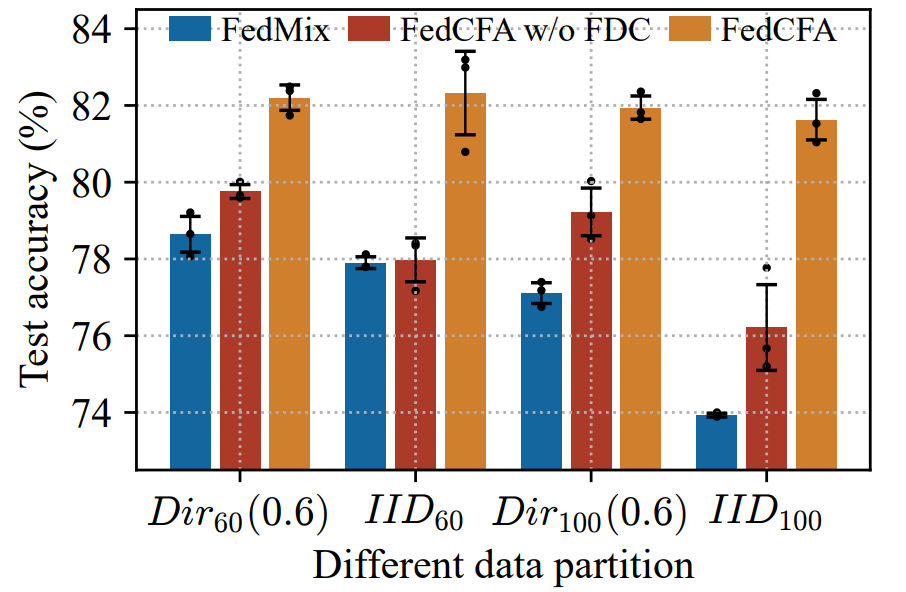

。 将选定的小 / 大梯度因子设置为零,以保留需要的因子

将选定的小 / 大梯度因子设置为零,以保留需要的因子

来表示第 i 个样本的所有因子。

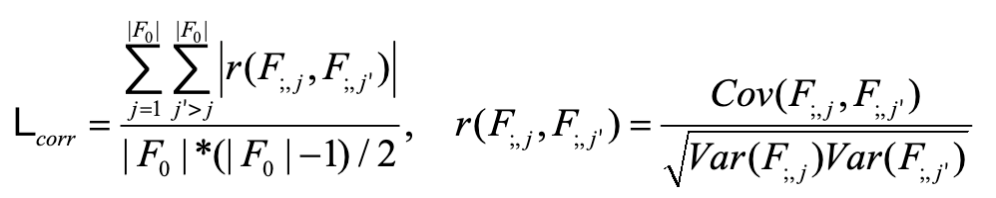

来表示第 i 个样本的所有因子。 表示第 i 个样本的第 j 个因子。将同一批次中每个样本的相同指标 j 的因子视为一组变量

表示第 i 个样本的第 j 个因子。将同一批次中每个样本的相同指标 j 的因子视为一组变量 。最后,使用每对变量的 Pearson 相关系数绝对值的平均值作为 FDC 损失:

。最后,使用每对变量的 Pearson 相关系数绝对值的平均值作为 FDC 损失:

(文:机器之心)