-

-

• 核心发现: 在一项涉及肯尼亚15家诊所、近4万次真实患者就诊的里程碑式研究中,OpenAI与Penda Health合作验证了其AI临床助手“AI Consult”。结果显示,使用AI的医生,其诊断错误率相对降低了16%,治疗错误率降低了13%。 -

• 关键挑战: AI在医疗领域最大的瓶颈已从模型能力本身,转向如何将强大的模型有效整合到真实临床工作流中的“模型-实践鸿沟”。 -

• 成功秘诀: 成功的AI临床应用需要三大支柱:①强大的模型能力;②与临床工作流无缝对接的产品设计;③积极主动的推广和培训策略。 -

• 未来启示: 这项研究为AI在医疗领域的负责任应用提供了宝贵的真实世界蓝图,证明了AI作为“智能安全网”和“临床副驾驶”的巨大潜力,其价值不仅在于纠错,更在于长期的赋能与培训。

跨越AI医疗的“模型-实践鸿沟”

AI大模型的能力边界正在以惊人的速度扩展。在复杂的医疗领域,AI在诊断推理、临床摘要等关键任务上,表现甚至开始超越人类专家。

然而,一个尖锐的矛盾摆在面前:模型的能力突飞猛进,但在真实医院和诊所里的应用却步履蹒跚。这就是当前AI医疗领域最核心的挑战——“模型-实践鸿沟”(Model-Implementation Gap),即模型理论上的强大能力与真实世界中复杂、琐碎的临床实践之间的巨大差距。

如何跨越这道鸿沟?OpenAI联手肯尼亚一家名为Penda Health的基层医疗机构,进行了一项开创性的真实世界研究。他们将一个由LLM驱动的临床助手“AI Consult”部署到日常工作中。结果令人振奋:在AI的辅助下,医疗差错率显著降低。

这项研究不仅证明了AI的价值,更重要的是,它为如何安全、有效地将AI融入临床,提供了一份宝贵的“蓝图”。

Penda Health的医护人员正准备为社区提供服务。

Penda Health的医护人员正准备为社区提供服务。实验场:肯尼亚基层的深厚土壤

为什么选择基层医疗?因为这里是AI最能大显身手的战场。在肯尼亚,基层医疗很大程度上由“临床官”(Clinical Officers)承担,他们需要处理从儿科到老年科、从感冒到慢性病的各种问题,知识广度要求极高。世界卫生组织(WHO)报告显示,基层医疗中的患者伤害事件既普遍又可预防。

Penda Health正是这样一个深耕于肯尼亚内罗毕的基层医疗网络。作为一家社会企业,它致力于提供普通人能负担得起的高质量医疗服务,每年接诊近50万次。更关键的是,他们拥有强大的内部质控和培训体系,并对技术赋能临床抱有极大热情,这为AI的落地提供了绝佳的土壤。

Penda Health的实验室技术员在工作,及其现代化的诊所外景。

Penda Health的实验室技术员在工作,及其现代化的诊所外景。Penda的AI Consult系统并非一蹴而就。2019年,他们曾成功部署了一个基于规则的临床决策支持系统(CDS),将指南依从率从40%提升到90%以上。但规则系统覆盖面窄,无法应对千变万化的临床情况。因此,他们转向了LLM。

其AI Consult v1版本允许医生主动向LLM请求“第二意见”。虽然内部审计证明了其有效性(64%的建议被评为最高分),但“打断工作流”这一原罪,导致其采用率始终有限。这促使团队重新思考,最终将v2版本定位从一个“被动问询的专家”变成了一个 “主动守护的安全网”。

解法:打造一个医生真正爱用的AI副驾驶

AI Consult v2的设计核心是无缝融入,而非强行介入。它遵循三大原则:最大化覆盖、最小化认知负荷、维持医生自主权。

创新的“红绿灯”安全网

为了实现上述哲学,Penda设计了精巧的 “红绿灯”分级警报系统,通过异步事件驱动架构,在医生完成病历填写等关键节点后触发GPT-4o模型进行分析。

-

• 绿灯 (Green): 当医生操作无误时,系统仅在界面角落显示一个绿色的对勾。这是一种无声的肯定,既确认了AI在正常工作,又完全不干扰医生的思路。 -

• 黄灯 (Yellow): 当发现中度问题,如文档记录不完整或检查项有待商榷时,系统会显示一个黄色的响铃图标。医生可以自行选择是否点击查看详情,决策权完全在自己手中。 -

• 红灯 (Red): 当识别出可能威胁患者安全的关键性错误时,系统会弹出一个红色警报窗口。医生必须阅读并确认警报内容,才能继续下一步操作。这是一种强制性的“刹车”,确保最严重的风险能被看到。

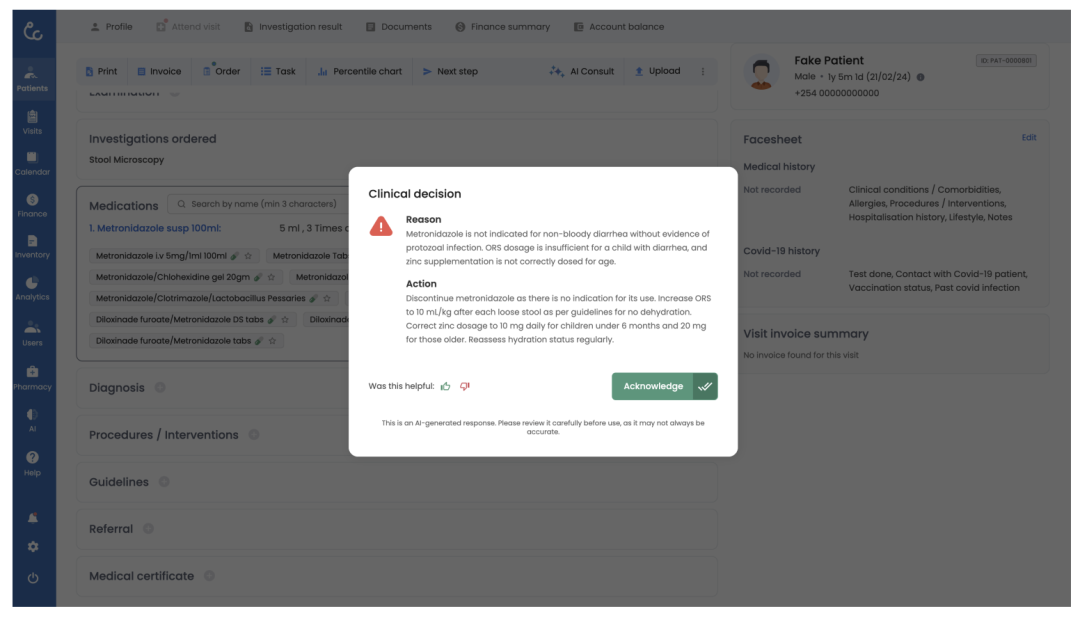

真实案例:AI如何避免一次错误的处方

下面这个真实的案例,完美展示了AI Consult如何作为“安全网”守护患者。

-

• 初始诊断: 医生为一名上呼吸道感染(URTI)的患者开具了含有“倍他米松/右氯苯那敏”(一种类固醇与镇静性抗组胺药的复方制剂)的药物。 -

• AI Consult响应(红灯警报): 系统立即弹出红色警报,其理由明确指出:“该药物因潜在副作用和疗效不足,不推荐用于URTI。此外,镇静性抗组胺药不适用于治疗URTI症状。” -

• 最终诊断: 医生采纳了建议,移除了该不当处方,并替换为更安全对症的非镇静性抗组胺药“西替利嗪”和缓解鼻塞的“赛洛唑啉滴鼻液”。

这次成功的干预,避免了一次潜在的不良用药事件。

4万次真实诊疗给出的答案

研究在2025年1月30日至4月18日期间进行,覆盖15家诊所和106名临床官。在获得患者通用研究同意后,最终纳入了39,849次就诊进行分析。医生被随机分配到“AI组”和“非AI组”。

显著降低临床错误率

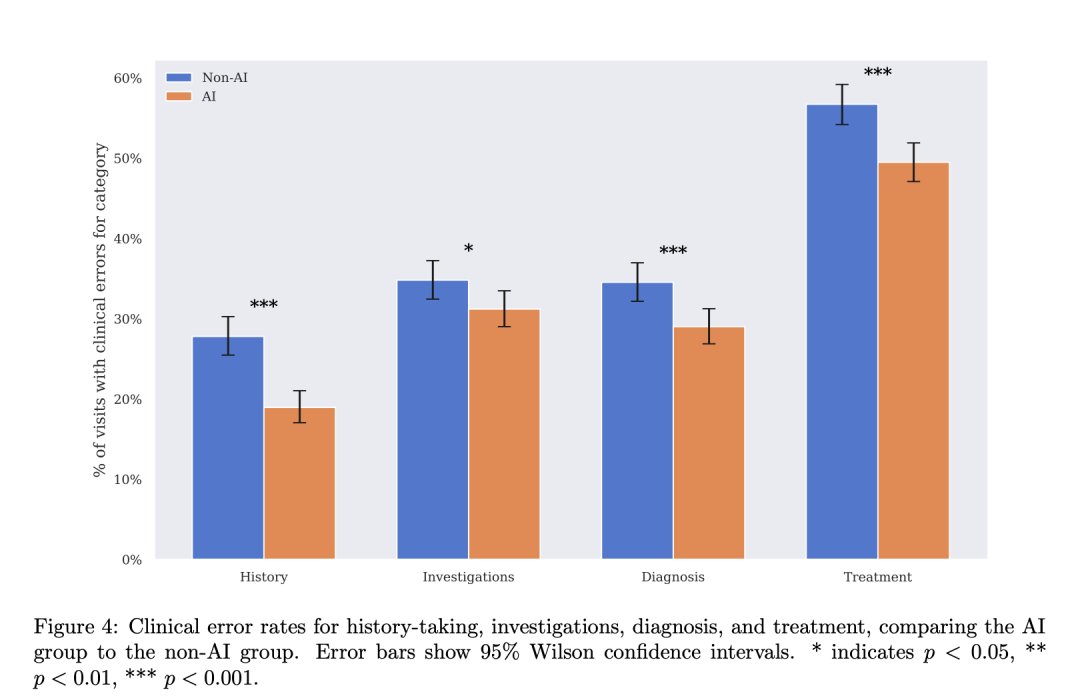

为了严谨评估效果,108名独立医生对随机抽取的5666份匿名病历进行了盲审。结果显示,与非AI组相比,AI组在四大维度的错误率均有大幅下降:

-

• 病史采集错误: 相对风险降低 31.8% -

• 检查错误: 相对风险降低 10.3% -

• 诊断错误: 相对风险降低 16.0% -

• 治疗错误: 相对风险降低 12.7%

如果将这些比例换算成绝对数字,意味着仅在Penda Health,全面推行AI Consult每年就能避免约22,000次诊断错误和29,000次治疗错误。

各类临床错误率对比

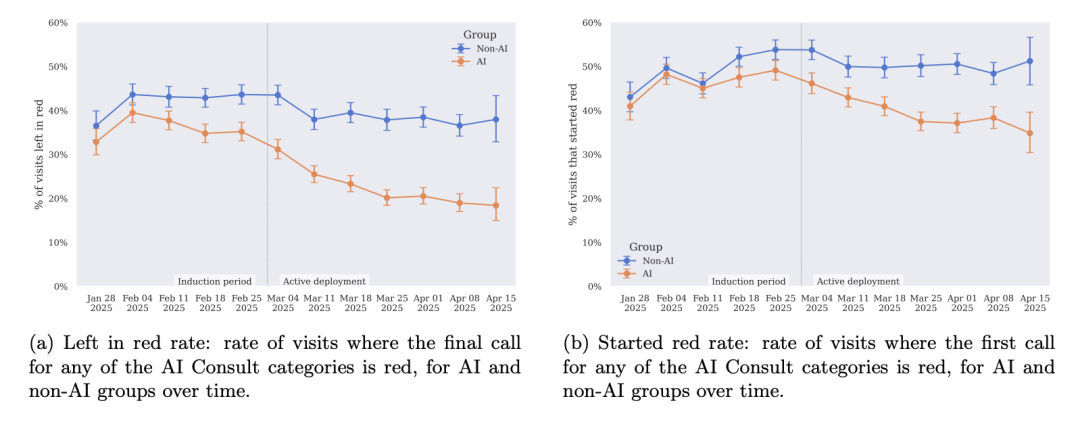

主动推广的力量

研究还揭示了一个关键洞见:光有好的工具还不够,如何让用户“用好”它同样重要。研究团队追踪了 “留在红色”(Left in Red 的比率。在研究初期的“引导期”,这个比率在AI组和非AI组相差无几。然而,当Penda团队启动 “主动部署” 策略——包括同行榜样分享、一对一辅导和正向激励后,AI组的该比率骤降至 20% ,而非AI组依然徘徊在40%左右。这道清晰的“剪刀差”曲线,证明了主动运营对于AI工具落地价值的决定性作用。

AI不仅是工具,更是“教练”

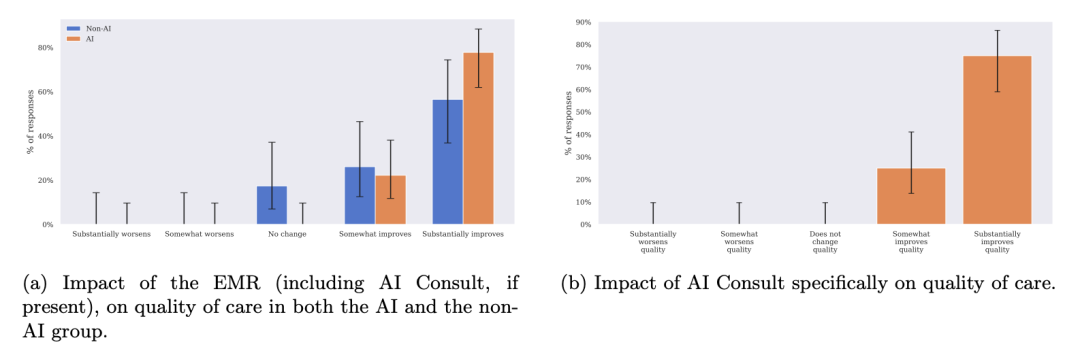

AI Consult不仅是一个纠错工具,更是一个强大的学习和培训工具。在一项匿名问卷调查中,所有使用AI的医生都认为它提升了自己提供的护理质量,其中75%的医生选择了“极大地提升”。

医生对AI Consult影响的评价

数据也印证了这种“学习效应”。“首次为红”(Started Red)率——即医生在AI介入前就可能犯错的比例,在AI组从研究开始时的45%下降到了结束时的35%。这意味着,医生们通过与AI的持续互动,内化了知识,学会了主动避开常见的错误,自身的能力得到了成长

“留在红色”率与“首次为红”率变化曲线

安全性与患者结局

在8天后的电话回访中,AI组有3.8%的患者表示“没有好转”,而非AI组为4.3%,差异在统计学上尚不显著。在安全性方面,研究期间的12份患者安全报告中,没有任何一例伤害是由AI建议直接导致的。相反,在数个案例中,若遵循AI的建议,本可避免或减轻伤害。

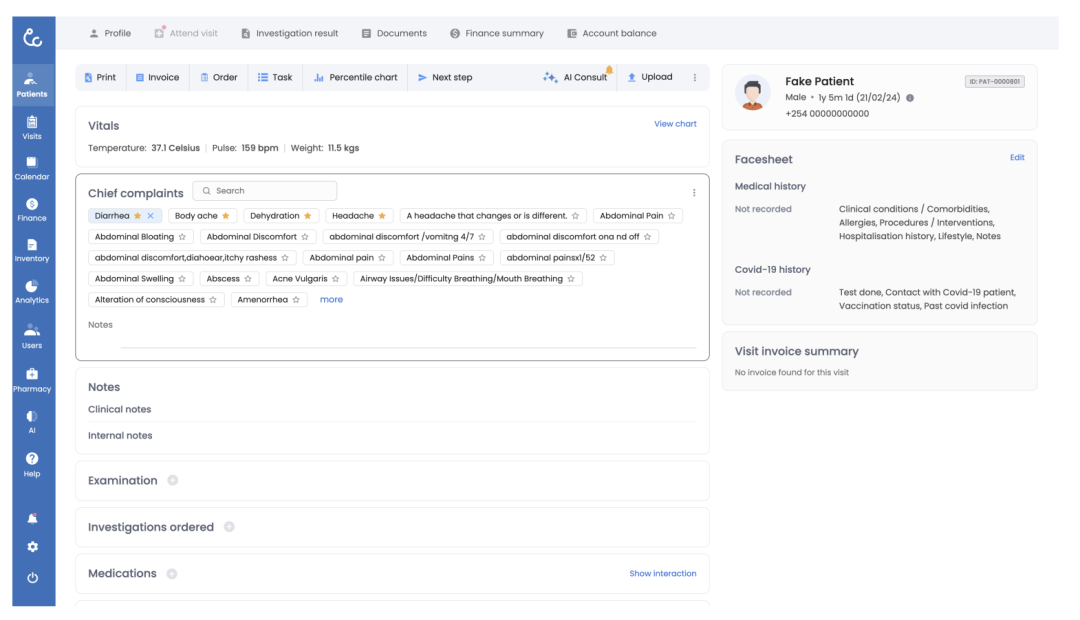

AI Consult in Action: 操作界面

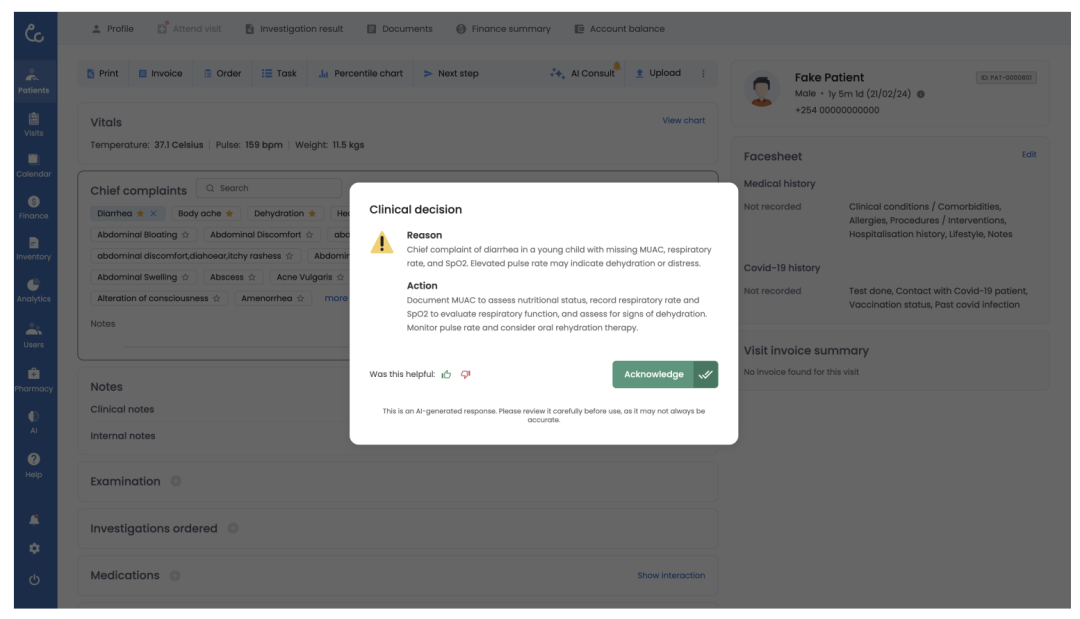

电子病历界面右上角出现一个黄色的响铃图标

图:黄色通知

点击黄色响铃后弹出的窗口,提供了关于“临床决策”的详细理由和建议。

图:黄色弹窗

一个红色的“临床决策”弹窗强制性地出现在屏幕中央

图:红色弹窗

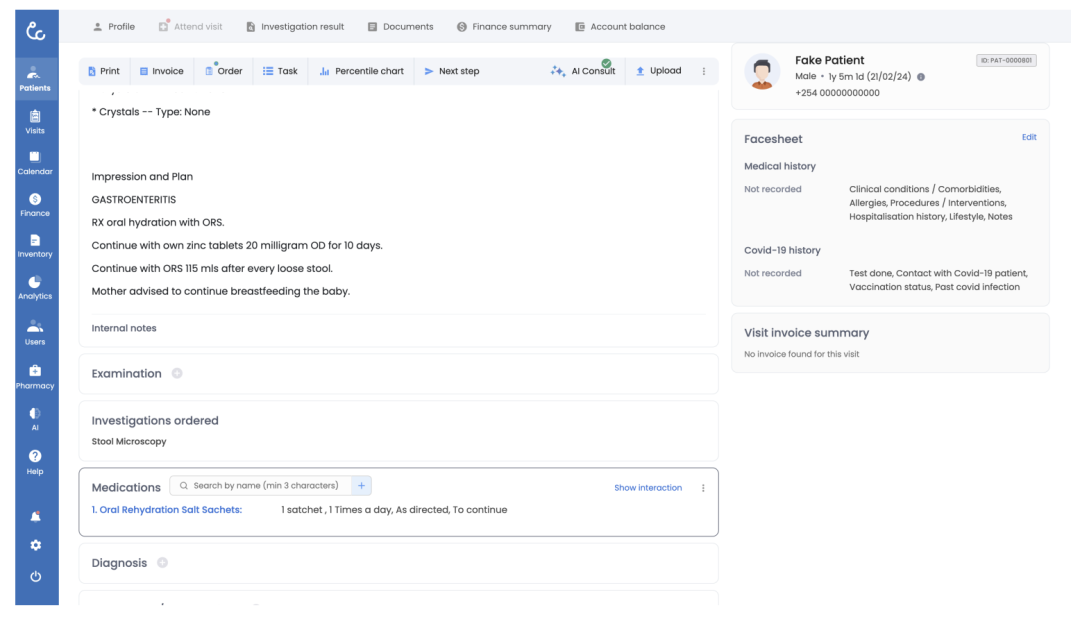

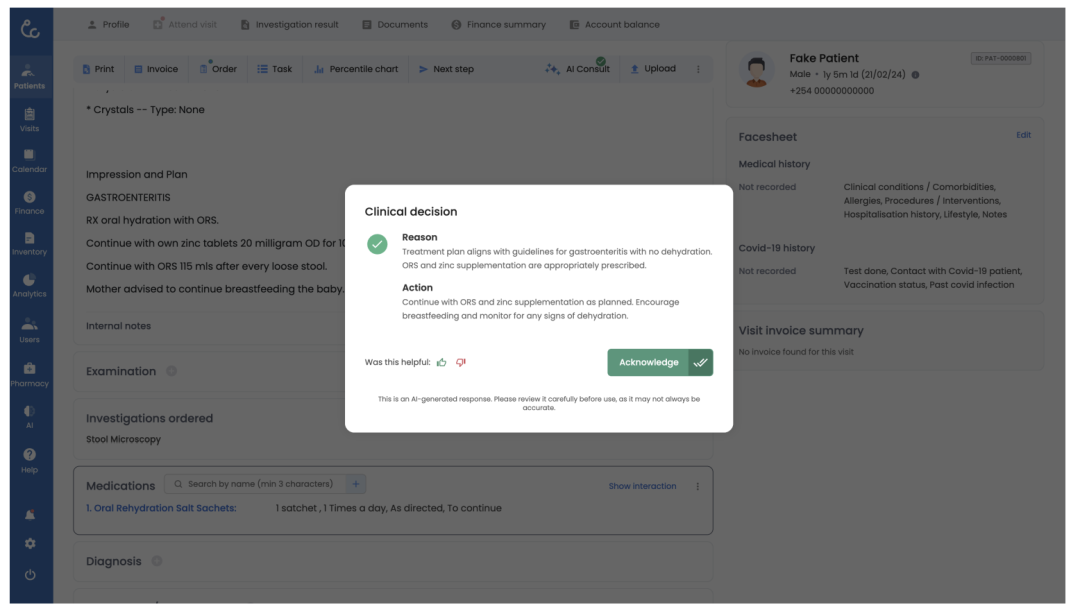

电子病历界面右上角出现一个绿色的对勾图标

图:绿色通知

点击绿色图标后,弹窗显示绿色的“临床决策”确认信息

图:绿色弹窗

AI医疗的未来,路在何方?

Penda Health和OpenAI的这次成功实践,可以总结为三大支柱:

-

1. 强大的模型能力 (Capable Model) -

2. 与临床对齐的实现 (Clinically-aligned Implementation) -

3. 主动部署 (Active Deployment)

这项研究标志着一个重要的认知转变:AI医疗的核心战场,正在从“算法竞赛”转向“落地应用赛”。AI Consult代表了一种早期但极具前景的临床助手原型,但它远非终点。未来,我们可以期待更先进的形态,例如语音优先的界面、可执行操作的智能体等。

值得一提的是,这项在肯尼亚的实践,对于同样面临基层医疗挑战的全球各国都具有深刻的启示。Penda的成功经验,尤其是在工作流整合和主动推广方面的探索,为AI医疗应用的落地提供了极具价值的参考。只要我们能够脚踏实地,以严谨、负责任的态度去跨越那道“模型-实践鸿沟”,AI就有望成为全球医疗体系中不可或缺的一部分,成为守护人类健康的“标准配置”。

(文:子非AI)