近日,百度搜索团队提出面向 AI 搜索范式的论文《Towards AI Search Paradigm》,是第一篇提出完整 AI 搜索概念、详细介绍 AI 搜索算法实现并在亿级日活用户规模的搜索场景落地的技术报告。

该 AI 搜索范式致力于模拟人类的信息处理与决策过程,采用由多个 LLM 驱动的智能体构成的模块化体系,能够动态适应从简单事实查询到复杂多阶段推理任务的各类信息需求。

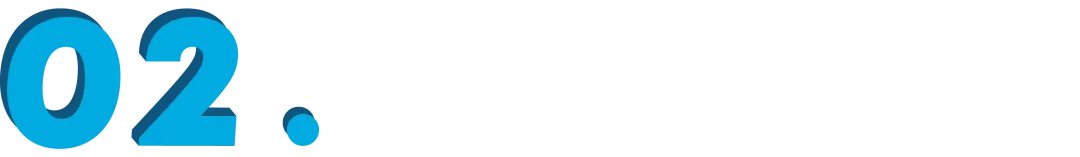

这些智能体通过动态协同的工作流程,评估 Query 复杂性,在 Master 的判断和指导下对应不同任务的特性的智能体动态组合,并针对复杂任务将问题分解为可执行的任务,并协调使用各种工具进行任务执行与内容合成。

其技术细节涵盖多智能体(Multi-Agent)协作、任务规划、通过模型上下文协议(MCP)选择合适的工具、DeepResearch、基于强化学习的优化策略、基于大模型的检索和排序策略、检索增强生成(RAG)的对齐和优化策略以及 LLM 的轻量化和推理加速等详细算法。

论文链接:

https://arxiv.org/pdf/2506.17188

研究问题:当传统搜索遇到复杂推理瓶颈

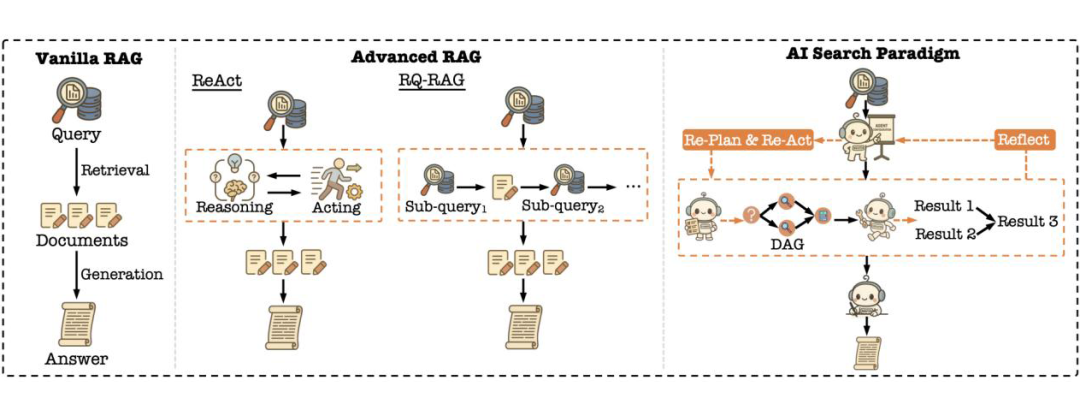

从词法搜索到机器学习时代搜索,再到 RAG,搜索技术一步步突破。尽管当前主流的 RAG 系统尽管能够直接提供自然语言形式的答案,但在面对需要多阶段推理、复杂任务分解或跨工具协同的 Query 时,仍捉襟见肘。

其本质问题在于传统 RAG 系统以线性“检索-生成”为基础,缺乏认知规划、动态工具调用和反思式调整的机制,无法有效应对现实中复杂多样的信息需求。

例如 RAG 可以回答“汉武帝的年龄? ”,但是很难回答“汉武帝和凯撒大帝谁的年龄更大,大几岁?”这种需要复杂推理流程的 Query。

核心原因在于:大多数 RAG 系统本质上仍是“单轮检索 + 单轮生成”的线性流程,缺乏任务拆解规划、调度工具、验证信息、出错后的反思与重试以及综合回答等一系列机制。

针对上述问题,百度搜索团队提出 AI 搜索新范式,旨在模拟人类获取信息的方式,犹如将专家团队装入搜索引擎:它能自动分解任务、调用多种工具、Multi-Agent 协同作业来解决复杂任务。

方法介绍

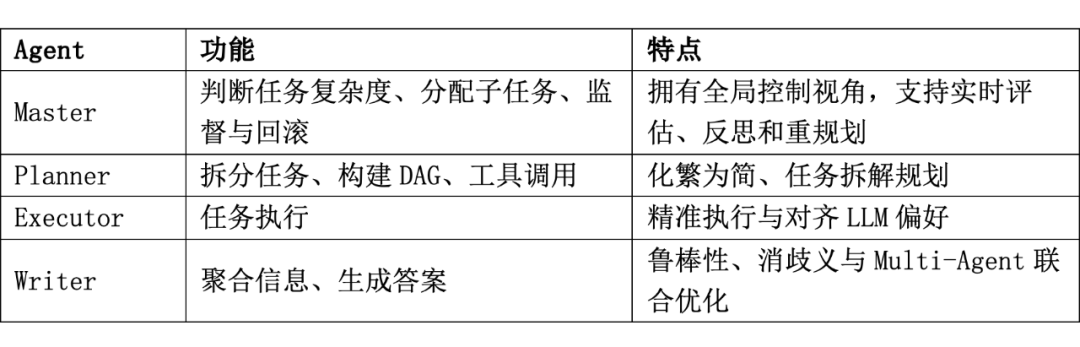

为解决上述问题,文章提出了一种基于多智能体协作的全新搜索范式——AI Search Paradigm,其核心思想是通过多个专职智能体动态协作,实现对复杂查询任务的高效规划、可靠执行与结果整合。具体包括以下四个智能体角色:

-

Master(控制智能体):负责初步分析查询的复杂度,动态组建最佳智能体团队,实时监控任务进展,并根据反馈调整策略。

-

Planner(任务规划智能体):针对复杂查询任务,动态调整 LLM 的能力边界,生成有向无环图(DAG),并动态调用相关工具。

-

Executor(任务执行智能体):负责执行 Planner 指定的子任务,包括调用外部工具,例如:网络搜索(Web Search)、计算器、天气工具、代码解释器等,实时评估执行效果。

-

Writer(答案生成智能体):将 Executor 的各个子任务结果整合,并生成逻辑清晰、语义完整的最终自然语言回答。

该范式突破了传统搜索系统线性、静态的处理模式,引入了显式的任务规划、工具动态调用和实时反思机制,从而显著增强了系统的复杂任务处理能力。

▲ 图1. AI 搜索范式系统架构图

方法设计:从静态检索到动态协作,打造更“类人”的搜索工作流

AI Search Paradigm 不只是简单多加几个模块,而是一次完整的架构重构:

复杂查询如:

“汉武帝与凯撒谁年长?相差几年?”

AI Search 会规划为如下任务图:

Sub-task 1: 检索汉武帝生日

Sub-task 2: 检索凯撒生日

Sub-task 3: 计算二者差值

子任务之间存在依赖关系(计算年龄前需先获得生日),系统构建成 DAG 并分层并行执行。相比“思考-行动”式的线性流程 RAG,AI Search 更稳定、易扩展、可回溯。

▲ 图2. AI 搜索范式与主流 RAG 方法的比较

核心技术亮点汇总

4.1 Master

-

根据查询的复杂性动态选择执行团队

-

实时监控和评估任务执行结果,如果执行失败进行反思(Reflect)、重规划(Replan)和重新执行(Re-Act)等 Deep Research 策略

4.2 Planner

-

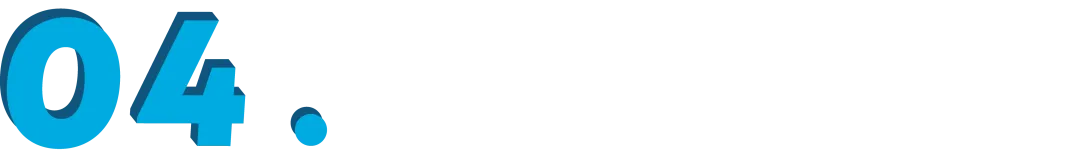

动态能力边界:不同于静态绑定工具列表,文章提出“动态能力边界”,即基于输入查询动态选择合适的工具子集,并结合 LLM 本身能力 + 选择的工具 API 构成有效的能力边界。

▲ 图3. 动态能力边界示意图

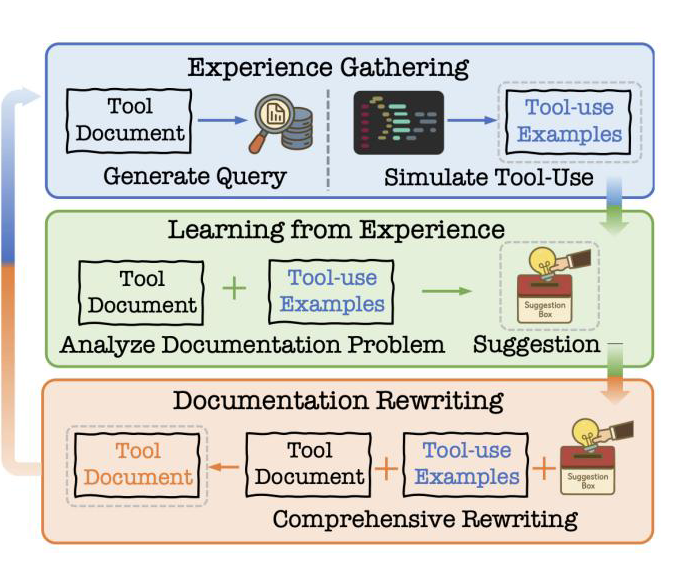

-

构建准确、完整的工具描述文档(DRAFT):文章提出 DRAFT 检索机制,利用 llm 和外部工具之间的交互,在这些交互过程中产生的反馈相互作用,逐步优化工具描述文档。

▲ 图4. 构建准确完整的工具描述文档算法(DRAFT)架构图

-

MCP 中的工具聚类:基于 API 功能相似度,自动聚类形成“工具包”,借助功能冗余提升整体系统韧性。

-

面向查询的工具检索(COLT):文章提出 COLT 检索机制,支持基于语义表示选择相关工具、建图建模工具协同使用关系以及最终用多标签列表排序方式,确保工具组合“完整+合理”。

-

基于 DAG 的任务规划:Planner 将复杂问题拆解为多个子任务并构建 JSON 格式的 DAG,采用思维链→结构化模式,即 LLM 先在内部推理,再一键生成结构化 DAG。

-

Master 指导下的 DeepResearch 机制:每步执行由 Executor 完成并验证;若结果缺失、失败,Master 会启动反思机制;局部回滚 DAG 片段,Planner 重新规划,避免全局重算。

-

基于强化学习(RL)的优化 Planner 策略:提出了基于强化学习的 Planner 优化方法,通过定义明确的奖励机制(涵盖结果准确性、用户反馈、格式规范性与中间任务执行质量),实现 Planner 在复杂任务规划中的性能提升。

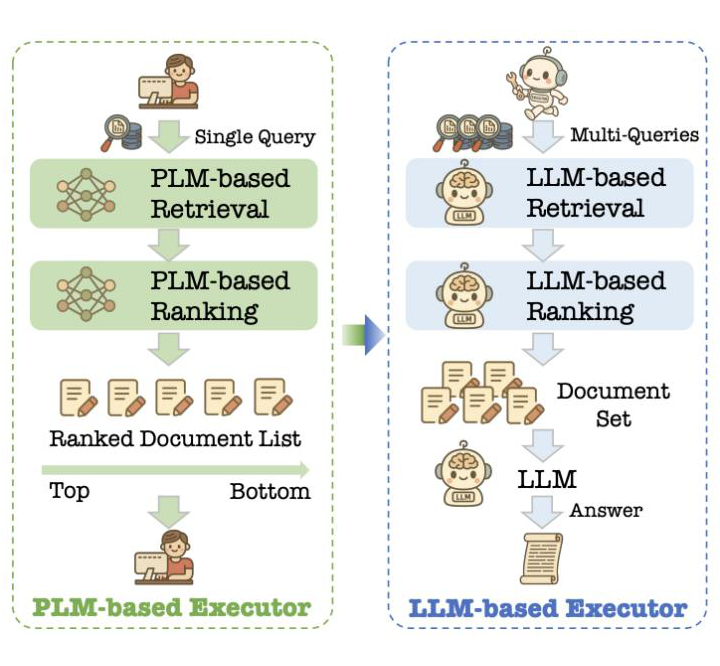

4.3 Executor

-

对齐大模型偏好:传统搜索对齐用户偏好,而 AI 搜索则侧重于对齐大模型的偏好,有利于后续生成高质量答案

▲ 图5. 任务执行器的架构转变示意图

-

LLM 标注(RankGPT 和 TourRank):RankGPT 利用滑动窗口在小批候选文档上重复比对,最终汇总出整组文档的全局排序;TourRank 受锦标赛模式启发,将文档分组并行竞争,多轮晋级打分后汇总,生成更准确的排序结果。

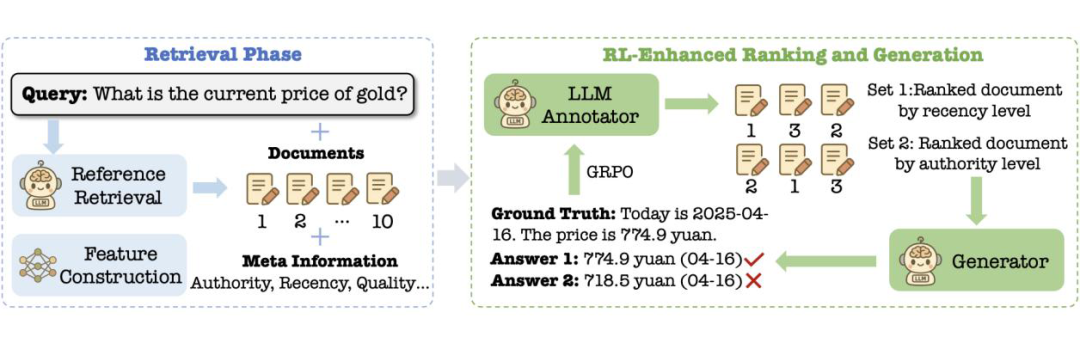

-

参考选择和生成奖励:Executor 从单一维度的排序升级为并行多维度排序策略,例如权威性优先或时效性优先,AI 搜索系统让 Writer 分别基于各策略生成答案,再以更优答案质量对对应策略给予正向激励,借助下游生成效果反向驱动上游排序优化。

▲ 图6. 生成奖励算法示意图

-

LLM 排序蒸馏:将教师 LLM 的深度排序能力蒸馏到更高效的轻量化的学生模型。

-

轻量化检索和排序系统:文章提出轻量化检索系统,即基于 Tiny-LLM 生成查询和文档嵌入,替代传统 BERT 模型。文章同时提出轻量化排序系统,即直接使用 LLM 推理能力对文档打分,减少特征工程依赖。

4.4 Writer

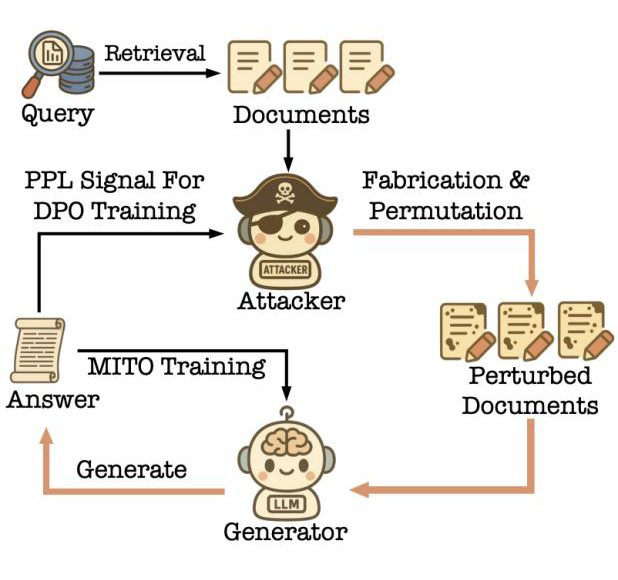

-

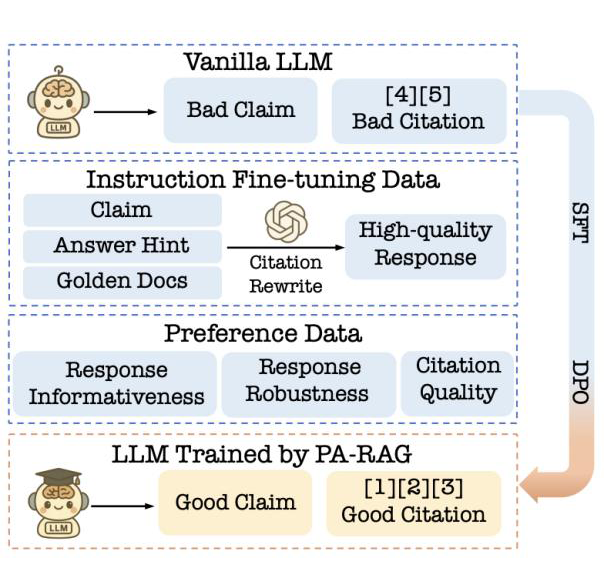

基于 LLM 生成的 “3H 标准”,即有用(Helpfulness)、无害(Harmlessness)和真实(Honesty)文章针对 3H 标准分别提出:鲁棒 RAG 系统(ATM),即通过对抗训练与多智能体迭代训练相结合,显著增强了 Writer 的鲁棒性;RAG 任务对齐系统(PA-RAG),即先通过指令微调获得基础 RAG 能力,再进行多视角偏好优化,确保模型输出信息性强、鲁棒性佳且引用准确;基于用户反馈进行优化(RLHB),即通过显式与隐式用户反馈,利用 RL 直接对齐 LLM,克服了传统对齐成本高且脱离真实在线行为的局限。

▲ 图7. 鲁棒 RAG 算法(ATM)示意图

▲ 图8. RAG 任务对齐算法(PA-RAG)示意图

-

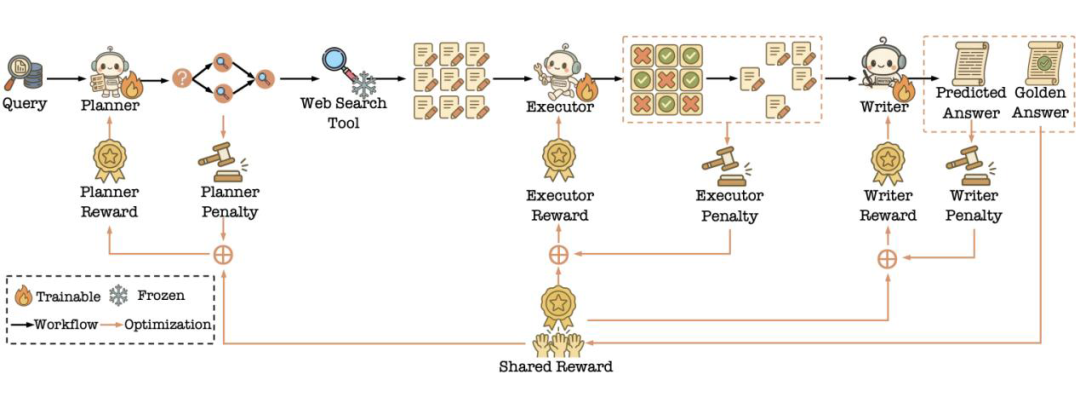

多智能体联合优化(MMOA-RAG):将 Planner、Executor 和 Writer 三个智能体视为协作团体,组成一个 Multi-Agent 系统,整体优化目标采用多智能体 PPO(MAPPO),使得所有 Agent 共同朝着同一个全局奖励方向前进,同时通过惩罚项约束各自的低效行为。

▲ 图9. 多智能体联合优化算法(MMOA-RAG)示意图

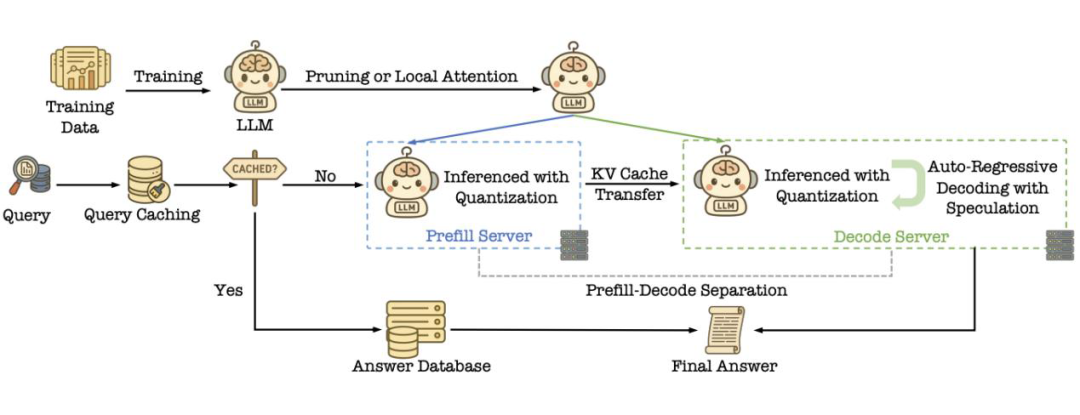

4.5 轻量化 LLM

-

算法层面优化方法:文章提出 Local Attention 方法,即通过 LightTransfer、LoLCATs 等方法,将 Transformer 的全局注意力替换为局部或低秩机制,大幅降低复杂度至近线性,且性能损失极小;文章利用 Layer Collapse、SlimGPT 等结构化剪枝技术,删减冗余层、注意力头或通道,在无需大规模重训练的情况下压缩模型参数,并保持几乎相同的效果。

-

架构层面优化方法:文章提出缩短输出长度(Output Length Reduction)、语义缓存(Semantic Caching)、量化(Quantization)、预填充与解码分离(Prefill-Decode Separation)和投机解码(Speculative Decoding)等方法在架构层面实现轻量化。

▲ 图10. 轻量化 LLM 技术流程图

实验结果:性能全面领先的 AI 搜索系统

文章过严谨的评估方法验证了该 AI 范式的强大性能。

5.1 人工评估

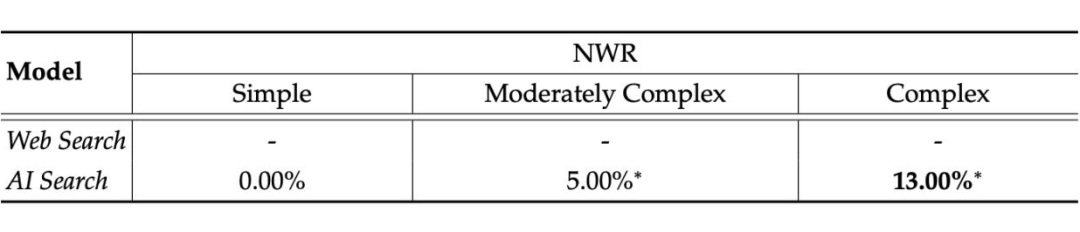

通过对专业标注员的“盲测”对比,结果显示:简单查询阶段,AI 搜索与传统搜索不分伯仲;中等复杂查询时,AI 搜索系统的归一化胜率(NWR)高出 5%;在复杂查询场景下,AI 搜索优势进一步扩大,NWR 提升至 13%。

▲ 表1. AI 搜索与传统网络搜索的在人工评估实验中的比较结果。

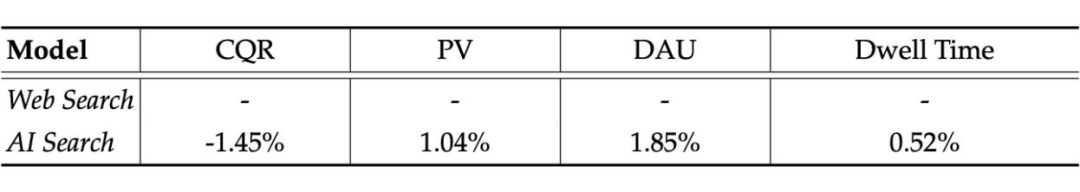

5.2 A/B Test

文章使用百度搜索的真实流量构建 A/B Test,结果表明 AI 搜索在常用用户侧指标上相较于传统网络搜索实现了大幅提升:更改查询率(CQR)降低 1.45%,页面浏览量(PV)增加 1.04%,日活跃用户(DAU)增加 1.85%,停留时间(Dwell Time)增加 0.52%。

▲ 表2. 在线 A/B 测试结果

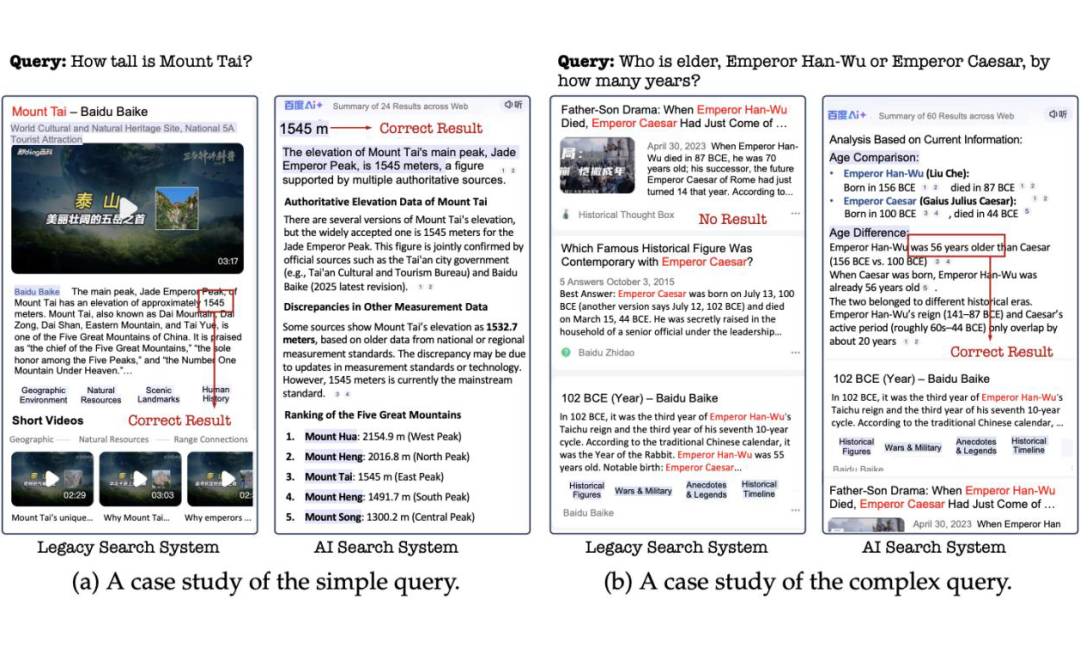

5.3 典型案例分析

文章选取了两个典型案例来直观展示:

-

简单 Query:“泰山有多高? ”在简单查询下 AI 系统和传统网页搜索表现相当。

-

复杂 Query:“汉武帝和凯撒大帝谁的年龄更大,大几岁?”AI 搜索生成准确答案,而传统网络系统无法产生正确结果。

▲ 图11. 案例分析

AI 搜索未来展望

AI Search Paradigm 提供了一种全新的搜索系统框架,使搜索系统从传统的检索生成机制,转型为以多智能体协作、任务规划与工具动态调用为核心的认知智能搜索系统。

文章相信该技术范式将在搜索引擎、智能问答、知识库交互以及决策支持系统等多个领域实现深远的技术进步,真正迈入智能搜索的新阶段。

论文已公开在 Arxiv:

https://arxiv.org/pdf/2506.17188

更多 AI 搜索体验可访问:

https://www.baidu.com/

(文:PaperWeekly)