大模型价值的主战场正在向后训练转移。

作者|王艺

北京时间7月10日,xAI正式发布Grok 4模型。

这款被马斯克称之为“宇宙最强模型”的大模型由20万块GPU组成的Colossus超级计算机集群训练而成,拥有25.6万tokens的上下文窗口,主打多模态功能,支持更复杂的交互形式,同时具备更快的推理速度和改进的用户界面。同时,Grok 4通过动态MoE+AdaLoRA技术训练而成,模型的显存占用减少70%。

在“人类最后的考试”(Humanity’s Last Exam)中,Grok 4拿到了38.6%的准确率,超过了谷歌Gemini 2.5 Pro的21.6%和OpenAI o3的21%。多智能体版本Grok 4 Heavy拿到了44.4%,如果进一步使用工具辅助,则能达到50.7%。

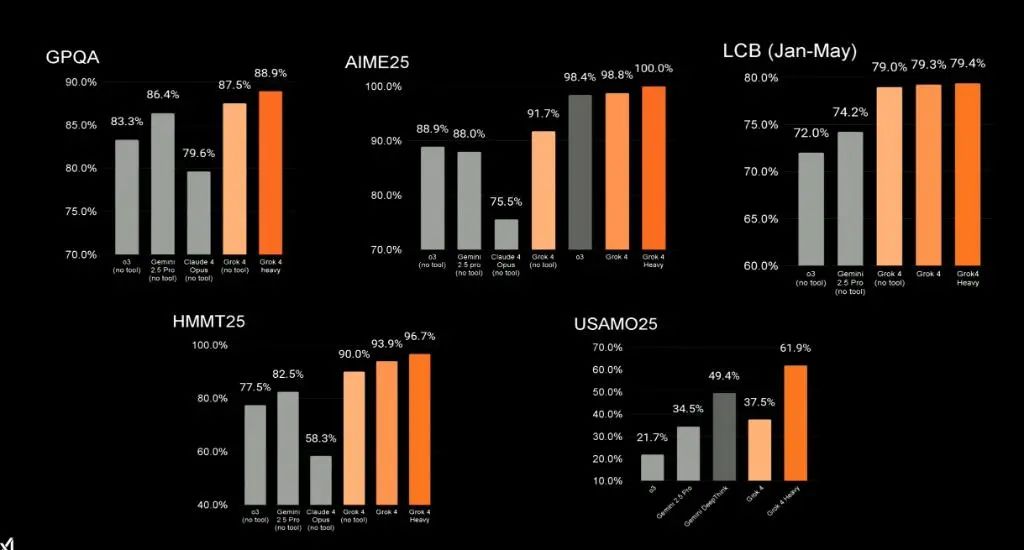

在和OpenAI o3、Gemini 2.5 pro、Claude 4 Opus的各项基准测试中,Grok 4的跑分结果也均居于前列。

图源:X@xAI

“Grok 4是在所有学科里都达到研究生水平的,甚至比大多数PhD都强。”在发布会的现场,马斯克说道。

那么,Grok 4是如何实现如此惊人性能的呢?xAI的答案似乎指向了一个愈发关键的领域:后训练(Post-training)。

1.超越预训练:后训练成为价值主战场

经历了2023年的百模大战、2024年的“六小虎”争霸与多模态巨浪,再到2025上半年DeepSeek掀起的推理模型风潮和Manus引爆的智能体(Agent)革命,大模型行业的叙事正在发生深刻转变。当基础模型的性能逼近物理极限,算力成本成为不可承受之重,喧嚣终于褪去。进入2025下半年,行业共识重回理性:AI的价值不仅在于模型本身,更在于其改造产业的深度与广度。

「甲子光年」观察到,随着基础大模型在通用能力上的边际效益逐渐递减、大模型技术红利向产业端渗透,AI的技术范式也开始从原来的注重“预训练”向注重“后训练”转移。后训练(Post-training),正从过去锦上添花的“调优”环节,演变为决定模型最终价值的“主战场”。

那么,后训练具体指的是什么,其对于大模型的价值又体现在何处?

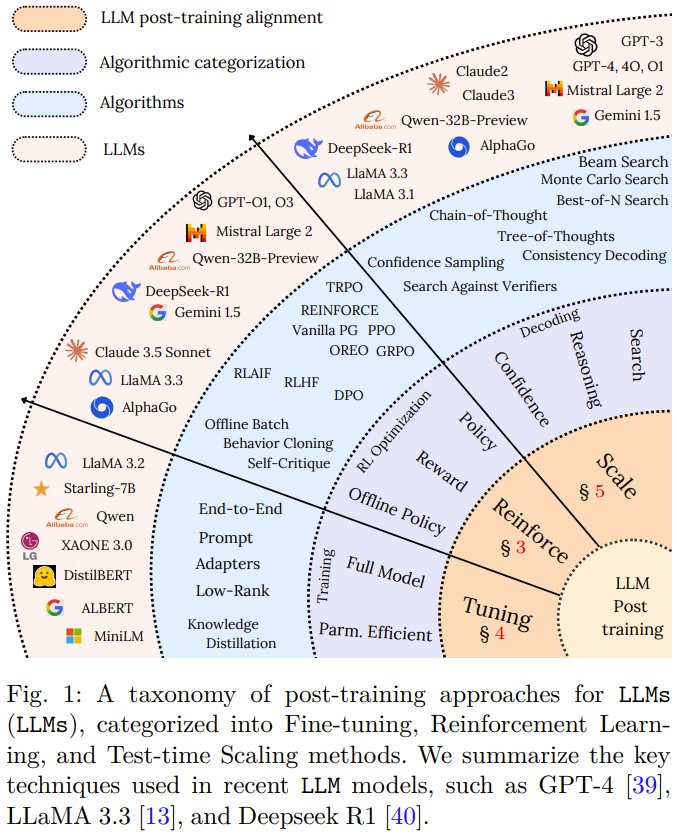

大模型的训练过程大致可分为两个阶段:预训练和后训练。预训练阶段通常依赖大规模语料库来预测下一个token,后训练阶段则通常包括多轮微调和对齐。后训练机制的目标是通过优化模型行为,实现与人类意图的对齐,包括减少偏见和不准确度。

要让大模型适应特定领域的任务,通常涉及到微调(SFT)等技术。这些技术虽然可以实现针对具体任务的学习,但也存在过拟合的风险,并且还会产生高计算成本。

为了解决这些难题,强化学习(RL)被引入进来,这能让模型使用动态的反馈和优化序列决策来提升适应能力。

此外,包括思维链(CoT)、思维树(ToT)、低秩适应(LoRA)、适配器和检索增强生成(RAG)、测试时扩展(Test-Time-Scaling,TTS)在内的规模扩展技术(scaling)均被应用于模型的后训练阶段,用以提高模型的计算效率和准确性。

因此,如果要让我们对后训练技术的核心价值做一个总结,我们认为它体现在以下三个维度:

-

知识精炼:修正预训练阶段的知识偏差与事实错误(微调)

-

能力对齐:使模型输出符合人类价值观和任务需求(强化学习)

-

推理增强:赋予模型多步推理、逻辑验证等高级认知能力(规模拓展)

后训练方法分类图谱 图源:《A SURVEY ON POST-TRAINING OF LARGE LANGUAGE MODELS》

这些策略加上分布式训练框架,促进了大规模部署,并进一步提高了大模型在不同应用中的可用性。通过这些目标明确的后训练技术,大模型可以更好地与人类意图和道德伦理要求对齐,最终提高其在现实世界中的适用性。

Pokee.ai创始人、Meta应用强化学习部门前负责人朱哲清表示,后训练的本质是在预训练(Pre-training)阶段在自回归模型(Auto-regressive Model)或扩散模型(Diffusion Model)上训练完LLM之后,用强化学习(Reinforcement Learning,RL)的方式去训练模型,让它能够和用户的意图或需求对齐。对齐的必要性在于,如果用户有某种目标需要语言模型来完成,通过后训练可以让模型不只是对用户的需求进行相关性的回复,而是真正完成这个目标。 从某种意义上来说,现在后训练是大模型训练和研究最重要的一环。

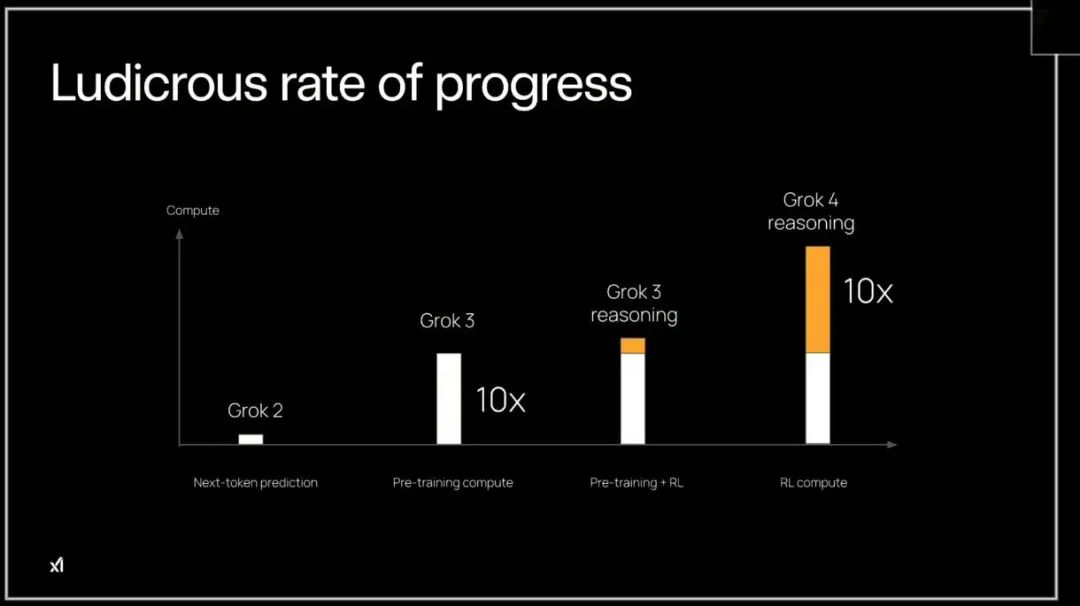

而对于追求极致推理能力的新一代模型而言,后训练阶段的算力消耗,已经开始与预训练阶段分庭抗礼,甚至大有超越之势。

以Grok 4为例,Grok 4之所以能有如此强大的推理能力,得益于其在强化学习方面的巨大投入。在其他公司还在用仅10%-20%的算力做强化学习的时候,xAI团队就决定All in RL,在Grok 4的强化学习阶段投入了之前Grok 3十倍的算力。

Grok 4在强化学习阶段投入了Grok 3十倍的算力 图源:Grok 4发布会

Grok 4的成功,可以看作是大模型领域后训练重要性超越预训练的最有力的说明。

2.产业落地之困:通用模型的深度适配难题

后训练不仅是大模型技术发展的必然趋势,更是AI技术和产业数字化落地的必然要求。

当我们将目光从技术本身投向产业应用,会发现,在出行、住房、教育等与我们生活密切相关的领域,训练大模型时,都不约而同地遇到了一些难题:

首先是大模型知识断层的难题。

由于通用大模型是在各个领域的知识基础上训练而成的,不是某一领域的专家,被问及专业领域问题的时候容易产生幻觉。

某汽车门户网站在训练大模型的时候中,就面临着模型“大而全”的挑战。其核心场景是为用户提供精准的车型信息问答和导购。通用大模型虽然知识广博,但在面对“某款车型的具体参配”、“不同车型的优劣对比”等专业问题时,准确率仅有50%,幻觉严重。

某房产类互联网公司同样遇到了此类问题。该公司的核心诉求之一,是打造一个能理解用户模糊需求、并主动挖掘其潜在偏好的“AI经纪人”。其大模型算法总监表示:“我们需要客户说要学区房时,它(AI经纪人)会追问是应试教育还是素质教育;当客户说要素质教育,它需要知道要关注跳舞、钢琴等具体品类。”这种对用户深层意图的精准挖掘,要求模型具备极强的领域知识和对话逻辑。但现在的通用大模型还无法达成。

其次是模型无法在缺乏明确反馈的情况下,学习和对齐用户的隐性偏好。

以招聘行业为例。在采访过程中,很多招聘公司的算法负责人都提到了“人岗匹配”这一核心场景。其复杂性在于,“匹配”本身是一个非常主观的概念。一个岗位,推荐给A候选人可能非常合适,但B候选人可能完全无感。模型即使给出了看似合理的推荐理由(“你有相关经验”),也未必符合候选人的真实偏好。

“我们会发现它匹配或者不匹配都可以给到你,告诉你看上去很有道理的理由,比如可能说虽然专业不符合,但是这个人有这方面的经验,也是可以的。 单纯做SFT没法达到要求,只能让模型对齐我们设置的目标、对齐平台数据。但对于用户的行为和偏好到底是什么样子,模型的反馈比较稀疏。”某招聘公司算法负责人告诉「甲子光年」。

教育行业同样存在这一问题。

「甲子光年」从几位教育行业的大模型负责人口中得知,教育场景的模型需要被严格控制,不能“超纲”;此外,教育模型不仅要知识准确,更要符合教学规范,比如解题步骤、书写格式等,但现在的经过预训练后的通用模型还无法达到这些要求。

“我们的用户对于整个大模型输出的质量要求很高,需要跟K12的大纲和K12的课程标准非常一致,比如乘号不能是星号,比如说1/2,这个分号应该是除号,以及包括通过方程解决和通过算术法去解决,这些都是需要分开的。但是我们发现通用模型并不是非常关心具体解析时候的解法以及是否超纲、书写是否规范,需要我们做精细化的指标去拆解。就有点像普通的985的学生知识储备都足够、能力也够,但是真正去迈向教师岗位需要跟学生讲课的时候,那些规范都需要重新学习。”某教育行业的大模型负责人表示。

该负责人表示,尽管行业内有一些知识图谱供大模型去学习,但是模型经过几层知识图谱的学习后准确率依然很低,目前测完六层之后的准确率只有大概5%,还需要做大规模的适配。“这还只是在语言模型的层面,多模态模型的效果差得更多。 ”

第三是在现在大热的自动驾驶、具身智能等领域,需要更加强大的多模态模型和更加有空间感知能力的“世界模型”来训练汽车和机器人,但现在这类基础模型发展还不是很完善。

某智能驾驶公司大模型负责人告诉「甲子光年」,视觉模型现在的发展水平仍然赶不上语言模型,会有运动模糊等明显的缺陷。“如果是动漫场景,需要一帧一帧画出来,不会有运动模糊这种情况存在;但是视觉模型经过很多真实数据的训练,本身会带这些模糊,我们就需要一些检测模糊的Reward把这些模糊点修掉。还有就是视频2D的模型经常凭空出现或者凭空消失一些物体,这些东西在2D里面不是那么好判断,但是如果换到3D模型就能很好地解决和修复。”该负责人表示。

而在具身智能行业,存在的问题则是通用大模型无法理解机器人的物理本体(如不同关节、传感器)和环境交互的复杂性,因此无法直接作为“机器人大脑”的基座;此外,具身任务需“多目标优化”(如抓取需平衡速度/力度),预训练模型直接后训练反而退化;与此同时,不同机器人本体的需求差异大,单一的规则无法覆盖全部的机器人训练。

“我们自己做具身智能通用模型,会发现有各种各样的局限性,比如说不同机器人的本体对社区来说其实是不一样的,但是语言模型的Base Model完全没法理解,从这个角度来讲,我们才不得不从头开始去训练具身的大模型,再基于自己的模型做后训练。”某具身智能企业大模型负责人表示。

时代呼唤知识储备更强、输出更精准、更能理解用户意图和需求的大模型。

而后训练,是解决上述问题、获得更好大模型的根本途径。

面对挑战,业界也在积极探索解决方案。

比如,为了解决大模型的知识断层问题,上述汽车门户网站和房产类互联网企业都在尝试通过“增量预训练+SFT+知识图谱”的方法训练大模型,让大模型获得更多行业知识;该具身智能公司则选择从头开始做基础模型,同时在预训练阶段去任务、去场景化,之后再做后训练。

而在奖励的构建方面,该汽车门户网站也在用“配置参数必须100%准确”等规则项和“用户点赞/完读率”等模型项构建奖励模型,先用高质量标注数据做Long-CoT,再逐步放开RL训练。某具身智能研究机构则通过训练结果奖励模型、通过机器人的运动轨迹让模型判断是否完成任务。

3.从Grok 4到夸克:顶级玩家的后训练“方法论”

产业的痛点,是技术进化的最佳催化剂。当汽车、房产、教育等行业纷纷暴露出通用模型的“最后一公里”难题时,一个明确的信号已经出现:传统的后训练已经不足以应对未来的挑战。

在后训练的“上半场”,一个经典的“入门级套餐”统治了市场:企业通常会采用一个中等规模的稠密(Dense)模型,通过监督微调(SFT)的方式注入少量业务数据,并使用BF16精度在前几代GPU上进行训练。 这个组合拳帮助许多企业迈出了模型定制化的第一步。

然而,当应用走向深水区,这套“入门装备”的瓶颈也日益凸显。在后训练领域,「甲子光年」发现了一些新趋势。

首先,在训练方法上,不再局限于SFT,而是正在转向SFT+RL或者纯RL的训练范式。

SFT虽然能让模型学会特定领域的知识和对话格式,但它本质上是一种“模仿学习”,模型只是在模仿标注数据的“标准答案”,却很难真正理解人类复杂的、模糊的偏好。例如,当面对一个开放式问题时,什么答案是“更好”的?哪个回答更“有帮助”、“更安全”或“更风趣”的?SFT很难回答这些问题。

为了让模型能与人类的价值观和偏好对齐(Alignment),强化学习(Reinforcement Learning, RL)应运而生,其中最经典的范式便是从人类反馈中强化学习(RLHF)。RLHF通常分为三个步骤:

-

监督微调(SFT):首先,和传统方法一样,使用高质量的标注数据对预训练模型进行SFT,让模型初步具备所需的能力。

-

训练奖励模型(Reward Model, RM):这是RLHF的核心。针对同一个Prompt,让SFT模型生成多个不同的回答。然后,由人类标注员对这些回答进行排序,告诉模型哪个更好,哪个次之。接下来,用这些“人类偏好”数据来训练一个奖励模型。这个奖励模型的任务就是给任何一个“提示-回答”对打分,分数高低代表了其符合人类偏好的程度。

-

通过强化学习优化语言模型:最后,将语言模型本身视为一个“智能体(Agent)”,它生成的回答就是“行动”。奖励模型则充当“环境”,不断给语言模型的回答打分。通过像PPO(Proximal Policy Optimization,近端策略优化)这样的强化学习算法,不断优化语言模型的策略,使其生成的回答能在奖励模型那里获得更高的分数。最终目标是让语言模型在不偏离SFT阶段所学知识太多的前提下,其输出能最大程度地获得奖励模型的高分,从而与人类偏好对齐。

然而,传统的RLHF流程复杂、训练不稳定且成本高昂。因此,业界又进一步探索出了强化学习更高效的对齐方法,如直接偏好优化(DPO)。

DPO巧妙地绕过了训练独立奖励模型的步骤,它通过一个简单的分类目标,直接利用人类的偏好数据(比如“回答A比回答B好”)来调整语言模型本身,使其更倾向于生成人类偏好的内容,而抑制不被偏好的内容。这种方法不仅简化了训练流程,降低了计算成本,还在许多任务上取得了与RLHF相当甚至更好的效果。

xAI就采用了RL+DPO相结合的方法做Grok 4的后训练。他们先是在传统RLHF基础上引入了合成辩论对和50亿人类投票数据,通过多轮迭代优化模型输出;接着跳过奖励模型训练步骤,直接利用人类偏好数据微调模型。

而扩展到动态环境,他们则采用了PPO的方法优化策略梯度,让模型在复杂任务中的表现更接近人类专家水平。

其次在模型的选择上,越来越多公司倾向于用MoE模型作为基础模型。

Dense模型在推理时所有参数均参与计算,导致计算量和显存占用随模型规模线性增长。MoE模型具有部分专家激活、专家间可并行、计算过程可共享等特点,可实现推理速度的显著提升。例如,DeepSeek MoE 16b与LLaMA2-7b效果相当,但前者推理速度是后者的2.5倍。

同时,由于每次推理只激活少数几个专家,相比传统的大规模深度神经网络,MoE架构在推理时的延迟和计算成本相对较低,特别适合需要高效推理的场景,如在线推荐系统、语音识别等。

此外,Dense模型固定计算路径缺乏动态调整能力,而MoE模型则可更快进行多任务学习、多模态融合,实现应用场景适配。

同样以Grok 4为例,其架构延续了MoE设计,但进行了重大优化。独立报告推测其总参数达 1.7 万亿,其中活跃参数约480亿。在专业层面,Grok 4的MoE设计采用了动态路由算法,其中路由器使用softmax激活函数选择专家,以最小化负载不均衡损失、优化计算效率。

第三,在数据精度的选择上,相较于BF16/FP16,FP8可以在精度几乎无损的情况下大幅提升训练和推理效率。

FP8使用更少的指数位和尾数位,能提供两倍的计算吞吐量,如在英伟达的H100 GPU上,FP8的TFLOPS是BF16的两倍。此外,相较于BF16,FP8能节省50%-75%的内存占用,还能保持训练和推理阶段模型性能及数据算法的一致性,避免额外的精度矫正。

Grok 4在前向传播的过程中使用FP8类型的数据,在梯度计算过程中则使用了BF16类型的数据,这是一种被称为“混合精度训练”的先进技术,其核心思想是在不牺牲模型收敛稳定性的前提下,最大化训练效率。具体来说,FP8负责加速计算密集但对精度不那么敏感的前向传播和权重梯度计算,而动态范围更广的BF16则用于梯度的累加和权重的更新,有效防止了梯度消失或爆炸的问题,确保了训练的稳定性和最终模型的精度。

作为另一个引领行业趋势的模型,DeepSeek-V3的训练过程也深度整合了FP8技术。通过在兼容的硬件上全面拥抱FP8,DeepSeek能够在控制成本的同时,高效地训练出性能强大的模型。

可以说,Grok 4的成功不仅证明了“后训练”的重要性,其采用的MoE模型、强化学习的训练方式、FP8精度的数据等更是逐渐成为行业内做后训练的共识。

夸克就在这种后训练路径下,用高考大模型交出了一份“最佳实践”的答卷。

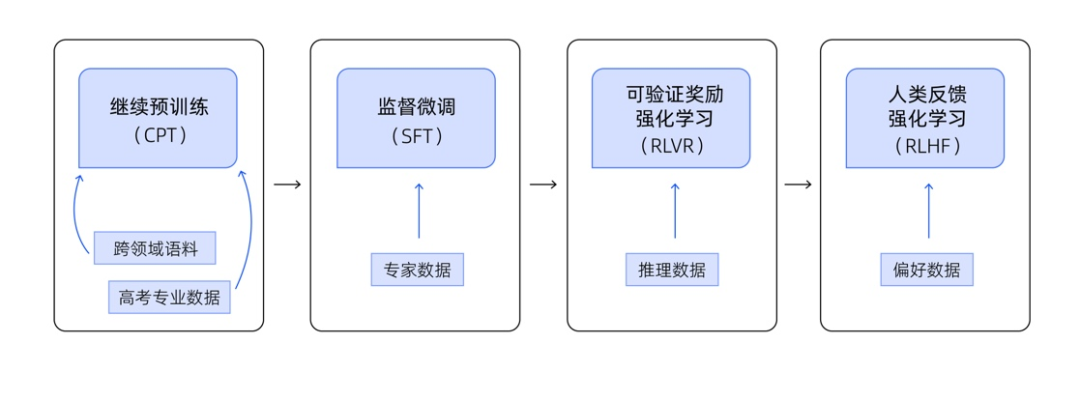

夸克高考大模型以通义千问系列的MoE模型为基座,其后训练阶段由增量预训练(CPT)、监督微调(SFT)、可验证奖励的奖励强化学习(RLVR)和人类反馈强化学习(RLHF)构成:

-

在指令微调阶段,夸克高考志愿大模型将数百名资深高考志愿规划师的沟通、决策过程进行结构化。围绕他们与考生或家长的多轮真实对话,提取出完整分析路径与语言风格。通过将上万条真实专家“推理链”转化为高质量监督数据,夸克高考志愿大模型得以深度学习人类专家的分析过程;

-

夸克高考志愿大模型还在复杂推理任务中生成了中间可验证结构,显著降低了幻觉率、增强跨模态演绎能力,并实现了分布外泛化鲁棒性,可以解决各种需要专业知识的复杂问题;

-

最后通过基于人类偏好强化学习(RLHF)精化策略层,夸克高考志愿大模型构建了一个闭环优化机制,将“模拟填报 → 专家反馈 → 策略评分”引入到模型迭代过程中。

夸克高考大模型后训练流程 图源:夸克

经过后训练的模型会基于模拟的考生档案生成志愿填报方案,随后这些方案将被提交给多位高考志愿专家进行评估。

评估标准包括:专业建议是否准确易懂、排序逻辑是否贴合考生特征、是否兼顾分数与兴趣、是否充分提示风险并给出可行应对策略等。通过引入数万条人类志愿专家推理数据进行训练,结合RLHF和RLVR的方式,夸克在后训练阶段构建了一个“专家反馈-策略评分-策略再优化”的完整闭环。

夸克高考志愿报告 图源:夸克

截至7月8日,夸克高考服务了全国考生及家长超4000万人,累计生成了超过1200万份AI志愿报告,为考生和家长提供考生情况分析、填报策略设计、志愿表解读、风险提示等覆盖全面的信息,辅助志愿填报。

夸克算法负责人蒋冠军对「甲子光年」表示,RLVR提供确定性奖励,基于可验证的规则或标准答案给反馈;RLHF则引入人类主观反馈,用于捕捉难以规则化的质量维度。两者互补,既保证事实正确性,又兼顾人类偏好。现在将RLVR与RLHF结合做强化学习已经成为了业界做推理模型的大势所趋,具体怎么混合要根据模型给的结果反推。

蒋冠军还表示,今年大模型领域尤其关注两件事情:一是后训练,二是Agent RL。“关于后训练的发展趋势,一是确定性答案的推理自动化,这需要更加广泛、更加复杂的数据,但是数据来源仍然是个问题;第二是多模态的推理。Agent RL属于刚起步,因为现在大家连Agent能否调用起来的问题都还没解决,RL的工作怎么做更是无从谈起。我认为第二个会比较慢,但第一个大家今年的争夺会非常激烈。”蒋冠军说。

4.后训练的五大关键要素及平台化破局

大型语言模型(LLM)的后训练过程日益关键,它涵盖了从数据处理到评估、奖励机制、扩展技术以及底层基础设施等多个相互关联的要素,共同决定了模型的最终性能和产业落地能力。

后训练有五大关键要素需要重点关注,分别是数据(Data)、评估(Evaluation)、奖励机制(Reward)、可扩展性(Scaling)、基础设施(Infra)。

第一是数据(Data)。数据是后训练的基石,贯穿整个流程的始终。高效地清洗、标注和管理海量的多模态数据,并构建从线上业务到线下训练的“数据飞轮”是企业面临的首要挑战 。例如,具身智能领域的一些数据需要生成或合成,而语言和多模态模型则依赖于用户标注和线上数据的回流补充 。这个过程涉及数据回流、接入、预处理、样本生成和管理等复杂环节,需要多领域技术栈的联合解决方案 。高质量的数据能有效纠正预训练阶段的知识偏差和事实错误,为模型的知识精炼提供基础 。

第二是评估(Evaluation)。 Evaluation是验证后训练效果的关键环节,它需要快速、可靠地衡量模型表现 。自动化评估流程,并根据评估结果调整训练样本和参数,是提升迭代效率的核心。例如,教育行业的模型不仅需要知识准确,还要符合教学规范,如解题步骤和书写格式,这些都需要通过精细化的指标进行评估 。有效的评估机制能够确保模型输出符合人类意图和任务需求,减少幻觉和不准确度 。MoE模型的分布式训练、RL的稳定高效收敛,对训练框架的能力、易用性和效率提出了前所未有的要求。

第三是奖励机制(Reward)。 Reward和Evaluation相关,也是强化学习在后训练中实现模型与人类意图对齐的核心 。从Evaluation转换到模型训练的Reward是提升效果的有效途径,包括其中Reward方法、Reward Model的训练等等。Grok 4的成功便得益于在强化学习方面的巨大投入。夸克高考大模型则结合了可验证奖励强化学习(RLVR)和RLHF,既保证了事实正确性,又兼顾了人类偏好 。

第四是可扩展性(Scaling)。扩展能力是后训练在行业落地的关键挑战之一,作为放大器,需要确保上述数据处理、模型训练、评测反馈的整个流程,都能在万卡级别的大规模集群上稳定、高效地运行。同时,通过分布式训练和模型压缩等技术,可以显著提升模型的扩展性。

第五是基础设施(Infra)。强大的infra是后训练得以顺利进行的基础。这包括根据不同负载(如SFT、RL、推理)弹性提供算力资源,确保最优的算力配比和成本效益 。分布式训练框架,如阿里云的PAI-ChatLearn,为MoE模型和强化学习的稳定高效收敛提供了支持 。它解决了开源框架灵活性过高、缺乏工程优化和稳定性差等痛点,显著提升了训练效率和成功率 。此外,完善的数据底座和部署闭环,如阿里云提供的数据处理方案和分布式推理服务,也确保了模型训练后的高效服务和快速迭代 。云计算平台提供的原生能力,如向量数据库、弹性伸缩和安全防护,正成为AI应用从“可用”走向“可靠”与“好用”的基石。

可以看到,在AI加速重塑千行百业的浪潮中,作为提升模型业务适配力的关键步骤,“后训练”不仅关乎算法层的优化,更依赖底层算力、平台能力与应用层协同,确保全链路的可行性与稳定性。

阿里云智能集团副总裁、大数据AI平台事业部负责人汪军华在采访中说:“RL非常的脆弱,微小的变化就可能会导致模型无法收敛。所以我们技术团队会不停地盯着收敛曲线,随时进行数据和策略的调整。由于RL的策略及超参有很多组合,很多时候算法团队也会无所适从,不知道如何用好强化学习。”

面对这些复杂的系统性工程挑战,企业最需要的是一个稳定、高效、全能的平台,将自己从繁重的底层工程中解放出来,专注于业务创新。而阿里云正通过其全栈AI能力,为企业提供从算力到平台的“后训练”一体化支撑。

在基础设施层,阿里云部署遍布全球的基础设施,可根据SFT、RL、推理等不同负载弹性提供算力资源,确保不同阶段的训练任务都能获得最优的算力配比和成本效益,从而为复杂的后训练、及推理服务流程提供稳定且经济的算力基座。

在模型层,通义千问系列基础模型能力领先,支持多模态、多尺寸、多架构,客户无需预训练即可启动后训练,快速适配业务场景,显著降低开发门槛与周期。

而当客户完成算力和模型选型、进入后训练阶段后,阿里云则通过人工智能平台PAI(Platform of Artificial Intelligence),围绕“数据-训练-推理-AI应用”的全生命周期,为客户提供高效、低成本的端到端后训练、模型服务技术支撑:

阿里云智能集团后训练解决方案架构 图源:阿里云智能集团

首先卓越的模型基座。在人工智能PAI平台上,企业进行后训练无需从零开始。阿里云提供了通义千问(Qwen)系列大模型作为高质量基座,在PAI-Model Gallery中,已集成Qwen、Kimi K2、DeepSeek等300+顶尖模型,可0代码实现微调、部署与评测,覆盖金融、汽车、教育、具身等多行业需求。尤其是Qwen3支持混合推理(快慢思考),用户可以利用Qwen3强大的通用知识和推理能力作为起点,将精力聚焦于业务场景的精调,极大地降低了后训练的门槛和成本。

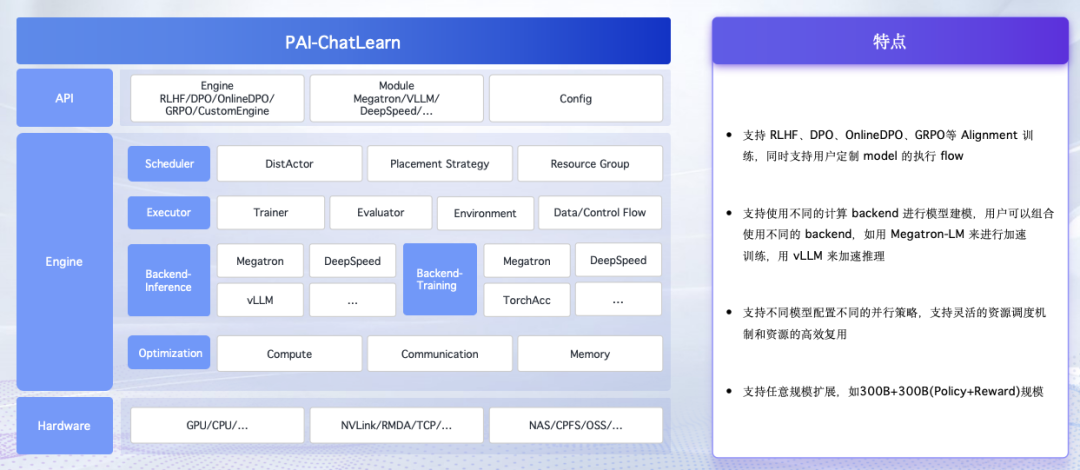

其次是强大的训练框架。PAI提供了灵活、易用、高效的大规模强化学习训练框架PAI-ChatLearn:ChatLearn原生支持RLHF、DPO、GRPO等多种先进的Alignment训练算法,并能支持300B+300B量级的Policy和Reward模型协同训练和任意模型的后训练任务快速配置,万卡规模MoE架构训练MFU达35%-40%;同时,通过将复杂的RL流程封装为易用的模块,ChatLearn显著降低了RL的落地门槛。其训练性能对比业界SOTA系统,在不同规模的模型上实现了2-3倍的训练加速,极大地提升了迭代效率;此外,结合阿里云底层硬件和通信库的深度优化,ChatLearn解决了开源框架常见的稳定性问题,保障了长周期训练任务的高成功率。

PAI-ChatLearn的技术架构和特点 图源:阿里云智能集团

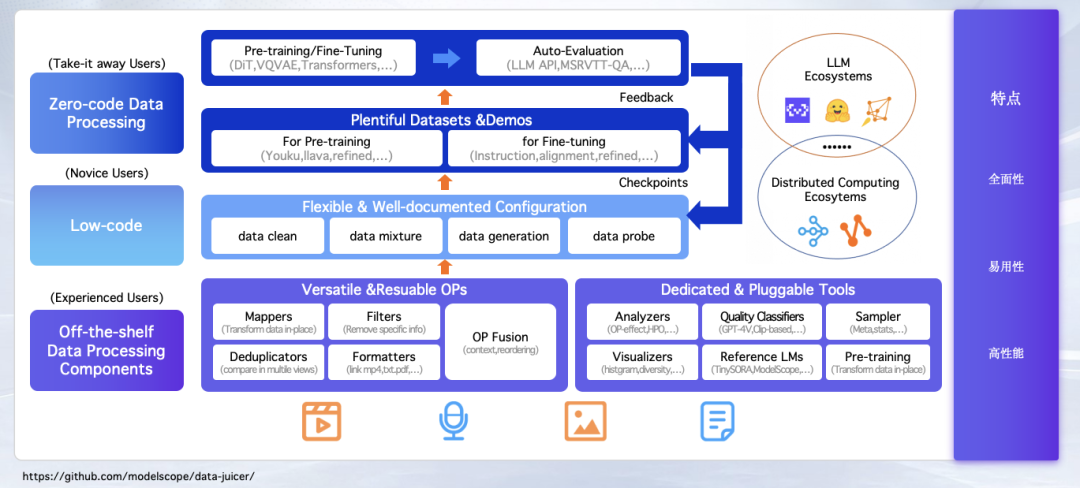

最后是坚实的数据底座与完善的部署闭环。在数据层面,阿里云提供面向AI场景的多模态数据处理方案,通过MaxCompute MaxFrame+PAI-EAS+Flink等产品实现统一的数据处理体验,整体数据处理效率提升10倍以上,数据处理推理任务优化提速1倍以上,相同资源产能提升1倍;

阿里云智能集团数据预处理算子引擎Data-Juicer 图源:阿里云智能集团

在评测与部署层面,针对MoE等模型的部署难题,人工智能平台PAI提供了分布式推理服务,通过创新的多机Prefill-Decode-EP分离架构,结合LLM智能路由,能够高效分配计算资源,做到首token生成响应时间降低92%,端到端服务吞吐提升5倍+。

Grok 4的成功揭示了后训练的巨大潜力,而其背后复杂的系统工程也为行业敲响了警钟。对于绝大多数企业而言,重复造轮子去解决数据、评估、奖励机制、扩展方法和基础设施的问题,无异于将宝贵的资源投入到一场没有终点的消耗战中。

随着大模型的发展从“规模的军备竞赛”走向“深度适配业务场景的价值创造”, 越来越多企业认识到:唯有“云+AI”的融合,才能从底层资源到应用层全面释放AI的价值。从向量数据库的构建与检索增强,到应对高并发请求的弹性伸缩,再到企业级的安全防护,云平台所提供的这些原生能力,正成为AI应用从“可用”走向“可靠”与“好用”的基石。

因此,真正的分水岭已经出现。阿里云的全栈AI能力正在将后训练从一个复杂的“工程问题”重新定义为一个清晰的“业务问题”。将复杂的工程挑战交还给平台,将宝贵的精力聚焦于核心业务的创新——这不仅是更明智的选择,更是抓住AI时代机遇的关键路径。

(封面图来源:AI工具生成)

(文:甲子光年)