一水 闻乐 发自 凹非寺

量子位 | 公众号 QbitAI

一次性揭秘Gemini多模态技术!

就在刚刚,Gemini模型行为产品负责人Ani Baddepudi在谷歌自家的开发者频道开启了爆料模式。

他和OpenAI前员工、现谷歌AI Studio产品负责人(Logan Kilpatrick,右)探讨了诸多众人好奇已久的问题:

-

为啥Gemini一开始就被设计为原生多模态? -

将图像和视频转化为token时,是否会存在压缩损失或信息丢失? -

Gemini 2.5为何在视频理解方面表现出色? -

多模态框架下,一个能力的提升是否会带动其他能力的整体提升? -

……

一言以蔽之,整个谈话几乎都围绕着Gemini多模态展开,包括其背后设计理念、当前应用以及未来发展方向。

之所以这场谈话值得关注,实在是因为Gemini多模态过于响当当和重要了。

2023年12月,谷歌原生多模态Gemini 1.0模型正式上线,一举将AI竞赛由ChatGPT主导的文本领域带入多模态领域。

而最新的Gemini 2.5 Pro(0605),不仅在代码、推理等任务上更上一层楼,而且还拿下视觉能力第一,可以说夯实了谷歌在多模态领域的领先地位。

此时回看Gemini当时的一些设计理念,会发现其前瞻性与创新性不仅为后续的发展奠定了坚实基础,而且对未来仍具有指导意义。

敲黑板,整场谈话干货满满,咱们这就开始~

为啥Gemini一开始就被设计为多模态?

一个智能体的世界如果只有文字,能读懂莎士比亚、能编写代码,甚至可以和你进行深入的哲学对话,但它看不到屏幕上跳动的图标、认不出厨房正在烹饪的食材、不能理解一幅画或者一段视频的意境。

这样的智能体完整吗?

谷歌的Gemini模型给出了一个响亮的答案:不,不完整。

而这,就是Gemini在诞生之初就被设计为多模态的根本原因。

访谈一开始,Logan Kilpatrick就问了这个根源性的问题:

为什么Gemini从一开始就被设计为多模态模型?

Ani Baddepudi强调,如果想要构建通用人工智能(AGI)和强大的AI系统,那么多模态的能力必不可少。

最初的目标是为了让模型能够像人类一样看世界,而视觉是人类感知世界的核心组成部分,许多领域(如医学、金融)的任务都有很大的视觉成分,因此多模态设计至关重要。

Gemini作为一个原生的多模态模型,这意味着它并非将不同的单一模态模型拼凑起来。

而是从零开始,将文本、图像、视频和音频等所有模态都转化为统一的“token表示”,并在这些信息上进行协同训练。

既然提到了信息“token化”,Logan Kilpatrick继续寻求爆料:

将图像、视频转化为token表示时,是否存在信息损失?模型是如何处理的?

在这个问题上,Ani Baddepudi承认,将图像、视频转化为token表示时会有一些固有的信息损失,如何使特征表示的损失更小是一个需要持续研究的问题。

但令人惊讶的是,模型看到足够多的图像和视频后,即使采样率较低,比如以每秒一帧(1FPS)的速度采样,模型依然能呈现良好的泛化能力。

Gemini 2.5在视频理解上“令人惊叹”

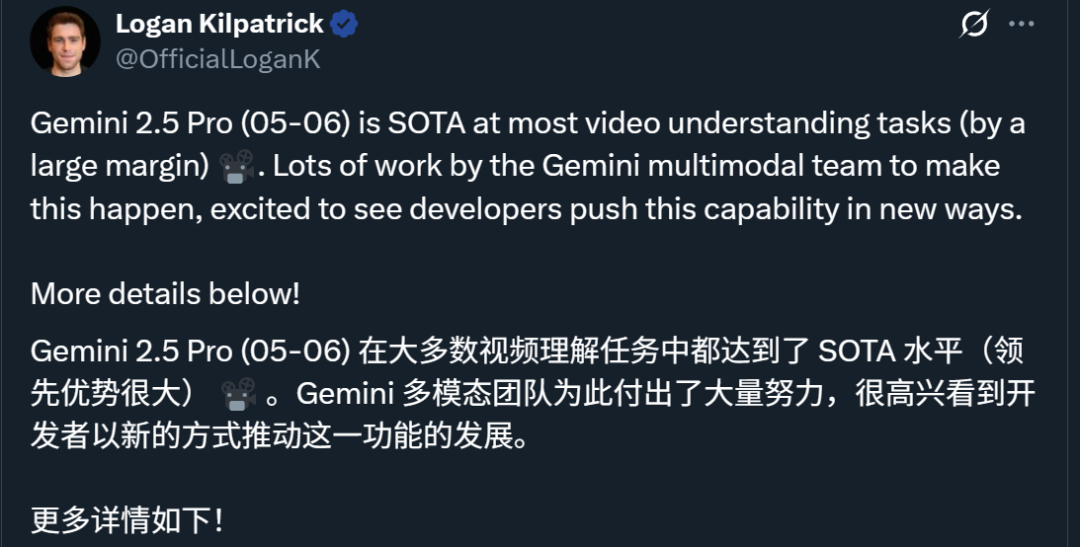

接下来Logan Kilpatrick还特意cue到了Gemini 2.5系列模型。

在他之前的一篇推文中,Gemini 2.5 Pro在视频理解方面的SOTA成绩令人印象深刻。

而对于这一亮点,Ani Baddepudi也补充了更多细节。

不过在展开前,他也再次感叹:

Gemini 2.5在视频理解方面相当令人惊叹!

第一,它解决了之前模型在鲁棒性方面的问题。

举个例子,之前给模型输入1小时视频,通常它只会关注前5~10分钟,然后对视频其余部分的关注就逐渐减弱,所以团队针对长上下文视频进行了改进。

第二,它意味着,团队将核心视觉能力的改进泛化到了视频。

简单而言,Gemini 2.5真正解锁了视频作为信息媒介的能力,能够完成将视频转换为代码(如食谱、讲座笔记)等非常实用的任务。

第三,它让团队看到了多模态能力的正向迁移以及多项视觉能力整合。

Ani Baddepudi表示,拥有一个单一多模态模型的好处在于,能够看到大量的积极能力迁移。

就拿Gemini 2.5“视频转代码”功能来说,这其实是因为模型在代码处理能力方面本身就更强大。

其次,过去需要独立模型处理的OCR、检测、分割等能力,现在都整合进了Gemini中,从而带来了许多新的用例。

例如转录视频时,既需要强大的OCR能力,也需要强大的时间理解能力,才能让模型理解视频中发生了什么然后进行转录。

还包括让Ani Baddepudi等人感到兴奋的一个用例——结对程序员,即通过流式传输IDE视频,然后询问代码库问题。这需要模型具备强大的编码、核心视觉(空间理解、OCR)以及对视频中信息随时间变化的理解能力。

总之,按照Ani Baddepudi的说法,Gemini是少数能够进行视频输入和最先进视频理解的基础模型之一。

当然,这背后也离不开一些关键技术。

据Ani Baddepudi透露,要让Gemini理解视频,它需要同时理解音频和视觉部分。

这是一个相当棘手的问题,因为你需要这些东西对齐。

目前的解决方案是,在视频的每个给定时间块(或小片段)内,将该时间块的音频信息和与该音频对应的视频帧(即图像)交错在一起进行处理。

所谓“交错”是指,将同时发生的音频和视觉信息捆绑或混合起来,供模型共同学习和理解。

这一方法在泛化方面非常出色,能让模型很好地理解视频,表现非常自然。

此外,尽管当前主要以1FPS(每秒帧数)采样进行训练,但通过更高效的token化方式(每帧用64个token表示,而非之前的256个),模型能够在较低细节下实现令人惊讶的高性能。

通过这一方式,Gemini现在可以处理长达6小时的视频,拥有200万上下文token。

而且Ani Baddepudi表示,团队正在努力支持更高帧率的视频理解,以应对如高尔夫挥杆分析、舞蹈动作评判等需要更精细时间细节的用例。

“万物皆视觉”的产品理念

Ani Baddepudi还提到了Gemini“万物皆视觉”的产品理念。

他将视觉用例分为三类,这些分类指导着产品开发的方向。

第一种是现有模型能做到的。

比如传统的OCR(光学字符识别)、翻译、图像检索(例如Google Lens用于购物)、以及分类(例如识别植物或动物)等。

第二种是人类专家能够做到的。

比如文档分析、内容整理与视频理解与推理等,这些任务通过Gemini的视觉能力能够更高效、无损地完成。

第三种是超越人类或在可行时间内无法完成的任务。

比如将讲座视频转换为可交互式学习的应用程序、在烹饪时主动提醒何时加入食材。

再比如,当你在城市中行走时,可以通过视觉向Gemini提问关于周围事物的问题,而不需要费力地将问题转化为文本。

这就需要模型不仅能够看到屏幕上的内容,还能看到真实的物理世界。

关于未来产品的体验,Ani Baddepudi给出了极具吸引力的回答:

想象你有一个专家人类在你的肩膀上,看到你所能看到的一切,并帮助你完成事情。

关于Gemini多模态团队

聊天最后, Ani Baddepudi分享了Gemini多模态团队的协作方式和工作重心。

在他看来,要想实现多模态能力,这离不开一支庞大的研究队伍。

多模态之所以令人惊叹,是因为它拥有如此多的能力,而要实现这些能力,一个非常困难的问题是需要将这些能力整合到一个单一模型中,并确保每种能力都能表现出色。

就是说,每整合一种能力都需要相关方向的大量人才。

然后,他进一步解释了团队如何将研究转化为产品。

首先,团队深入思考开发者和消费者将如何使用这些视觉能力,并努力将这种直觉融入到模型中,形成了紧密的产品-模型反馈循环。

一年后、两年后、五年后人们将如何与这些模型互动?

因为在Ani Baddepudi看来,今天开发的许多能力都是构建未来愿景的基石。

而且他认为接下来的重点是,如何让这些模型感觉更自然、更具交互性。

目前许多AI产品都是“回合制”系统(即你查询模型,它返回答案,然后你再次查询),这感觉“不自然”且“有点过时”。

至于具体如何实现,Ani Baddepudi从模型行为角度出发归纳了以下几点:

-

赋予模型同理心(empathy); -

让模型不仅能够理解用户,还要能理解用户的隐含意图; -

在平衡Gemini现有强大原生能力的同时,赋予模型“个性”(personality)。

同时他还提到,鉴于目前许多AI用例只返回大量文本,他正在思考是否能用有趣的视觉形式来以更信息密集或“高热量”(high-calorie)的方式传达信息。

这也许是让Gemini变得“友好”且“易于交流”的关键突破点。

(文:量子位)