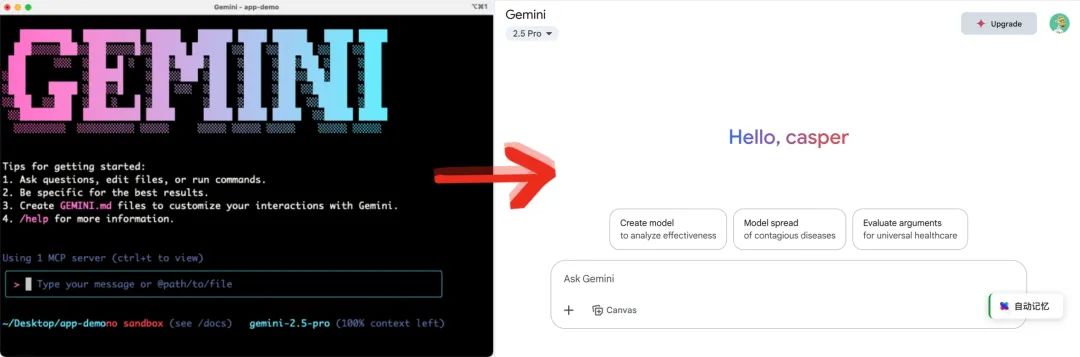

Gemini Cli、Claude Code都太好用了,

但一套配置下来也够麻烦的,能不能用我们已知的方式把它们经典的使用场景复刻下来,以最低的学习成本先体验上呢?

我统计快50位Gemini Cli尝鲜者们的使用分享,现阶段大家愿意花时间从Claude Code彻底跳到Gemini Cli的主力场景有四个:

- 本地系统交互:衍生出来的是批量整理文件和照片、图片格式转换

- 内置网络搜索:比方说可以一句话完成网页

翻译和将译文存到本地目录 - 多模态能力:调用veo3生成视频、flow剪辑视频、从草图生成代码

- 还有就是代码人最喜欢的Github集成(查询 PR, issues, git 历史等)

但是,这也要加一个但是了。

我觉得好用,大概率是因为我之前就会用命令行,对小白来说怎么顺利打开电脑里的终端都是不小的学习成本,而CLI这种命令行肯定不是最终的形态,这些能力还是会被封装到我们熟悉的对话界面里。

所以这次我跟现阶段最强的开源模型之一:Hunyuan-A13B一拍即合,

在只需要3个MCP设置的情况下,完成了Gemini-Cli平替复刻挑战。

那接下来的内容,我会先从能做到什么、如何一键配置、以及还能如何添加更多的能力,跟大家一起低成本超前感受一下Gemini Cli 在本地电脑上带来的Agent新体验

01|Gemini-Cli 平替复刻

为了保存对话记录,预设一大堆提示语以及切换不同的模型,

我用到的是 chatbox + filesystem MCP Server,

filesystem MCP Server内置了单/多个文件阅读、写入、编辑、移动、搜索,还可以新建目录、列出能访问的目录列表和目录树。

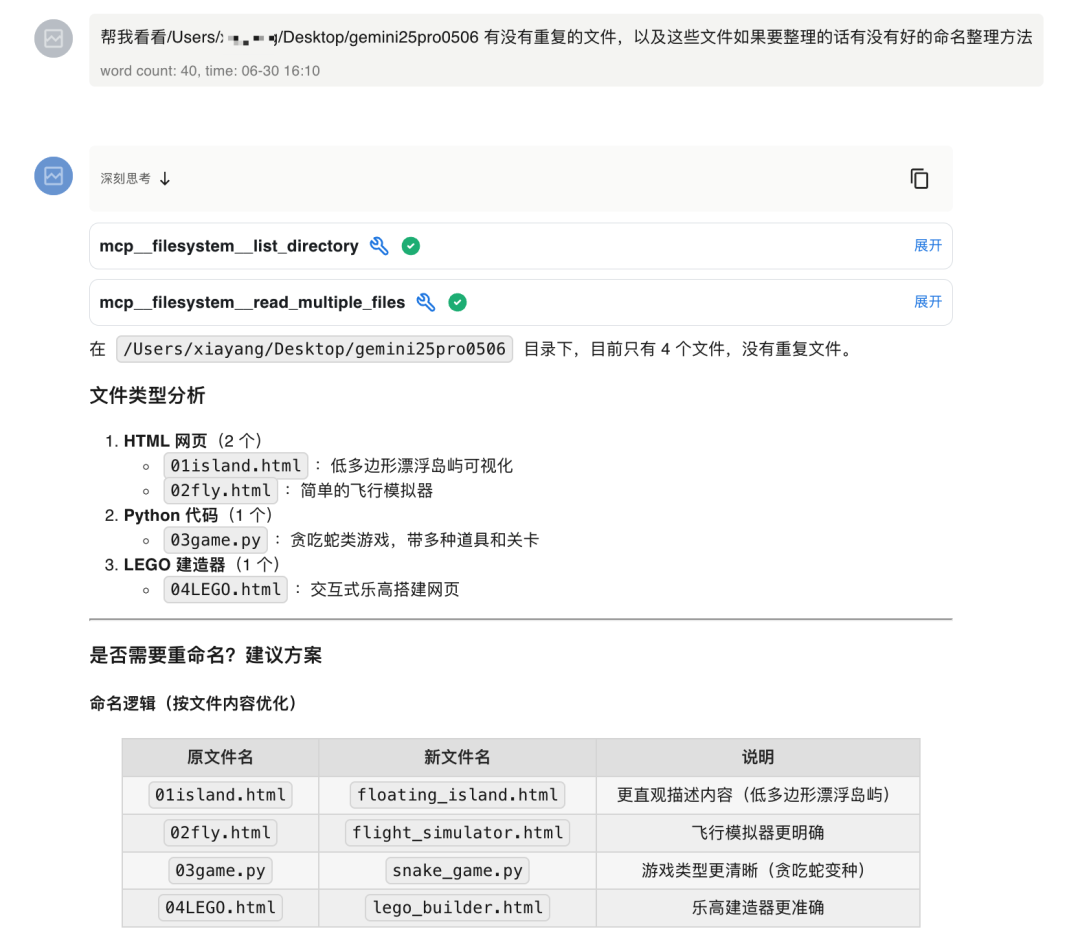

第一个Case(批量读取文件):

帮我看看有没有重复的文件,以及这些文件如果要整理的话有没有好的命名整理方法

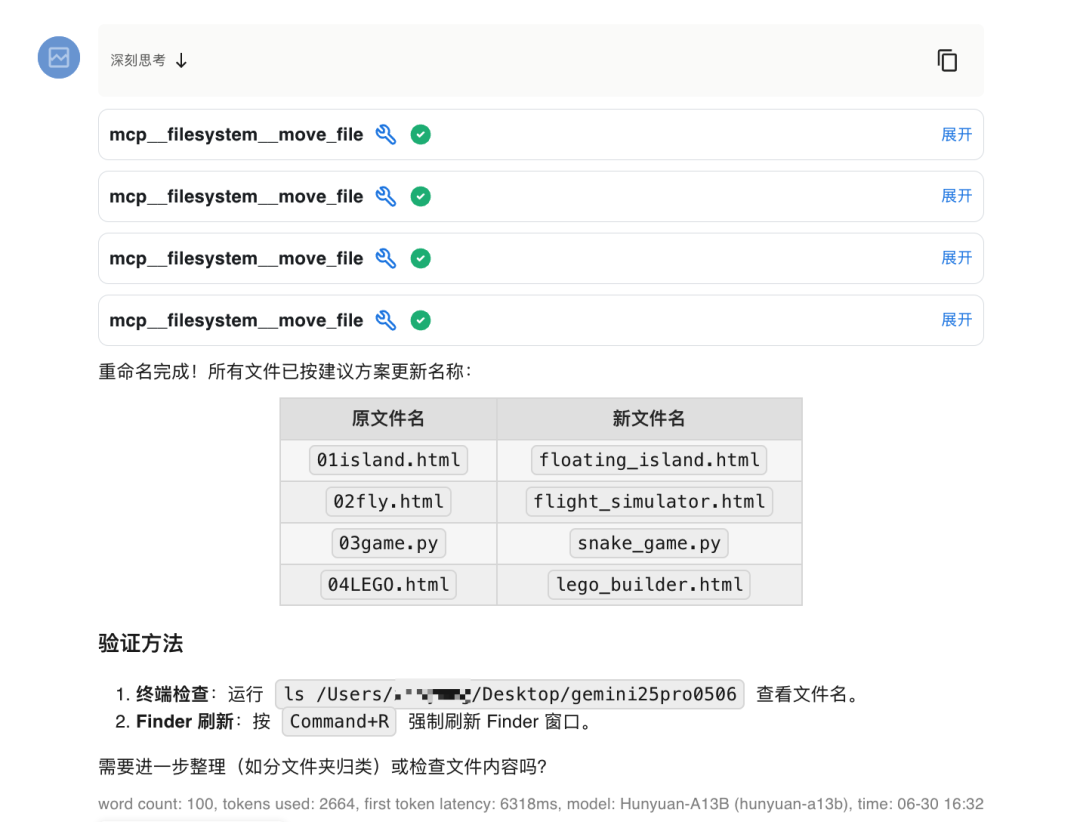

第二个Case(批量整理文件)

第三个Case(批量文件总结)

读取/Users/XXX/Desktop/gemini25pro0506里面的文件,总结出共同性,输出一个能生成同类型游戏的提示语

第四个Case(文件写入)

用HTML5 Canvas/WebGL创建一个3D游戏:低多边形漂浮岛屿+物理模拟飞行器,支持键盘控制视角切换,背景用粒子效果渲染星空,保存为HTML文件。(这个提示语就是上一步总结出来的)写入为这个目录的新文件

来看看Hunyuan-A13B的代码效果吧!

3D飞船顺利出发了,前几秒有点子星战的味道了,不过后面的景色没有刷新上来,但这时候切换视角的话能看到一闪一闪星星们。

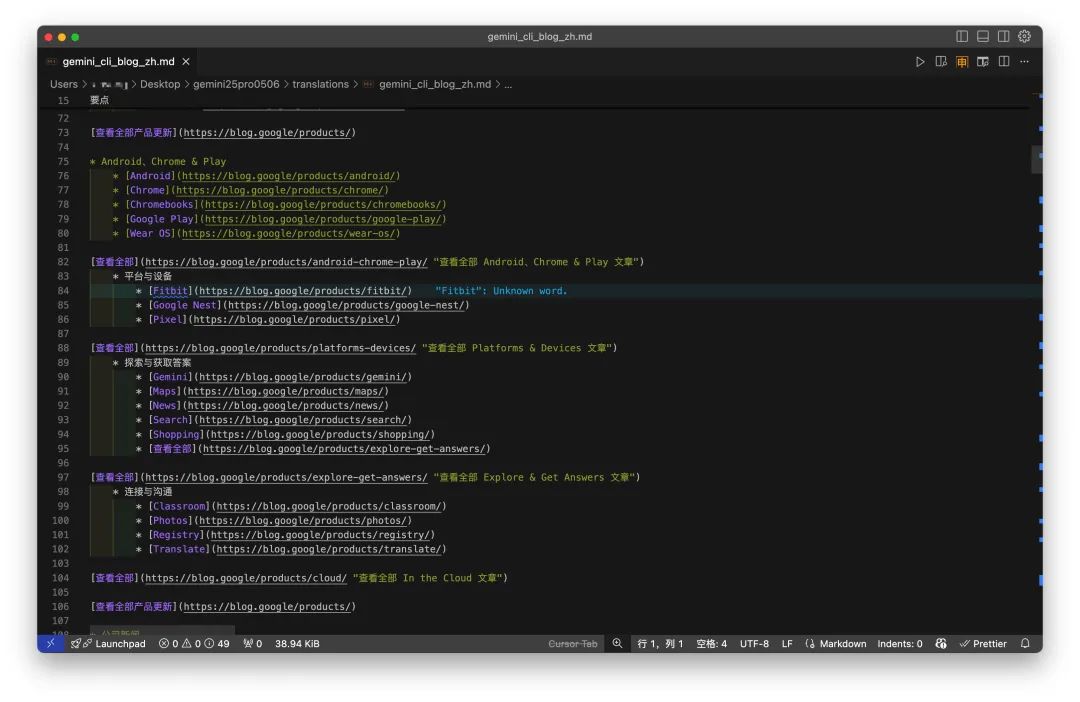

第五个Case(翻译在线网页并写入文件)

翻译

这一步要加上新的 fetch MCP,不用担心这些MCP都可以通过一次配置复制导入,且基本不需要配置奇奇怪怪的API Key。中间执行的过程它留意到我之前在这个目录做过文件分类,所以额外帮我新建了一个专门存放翻译文件的文件夹,

翻译的效果,排版部分做得很好

所以说这段时间把文件托管给它,

文件是少了,去掉了重复的文件,文件写入的时候有明确的目录分级,我不需要每天都腾点时间出来把不同文件搬来搬去了。

光是靠上面这一套丝滑小连招就足够让我把Gemini Cli当前版本优势复刻个七七八八。

如果是对MCP比较熟悉的朋友应该留意到我并没有提到sequential-thinking,这个用于辅助大模型调用MCP Servers的MCP Server(疑似套娃),

所以这其实也是对腾讯新开源的 Hunyuan-A13B 能力的测试,

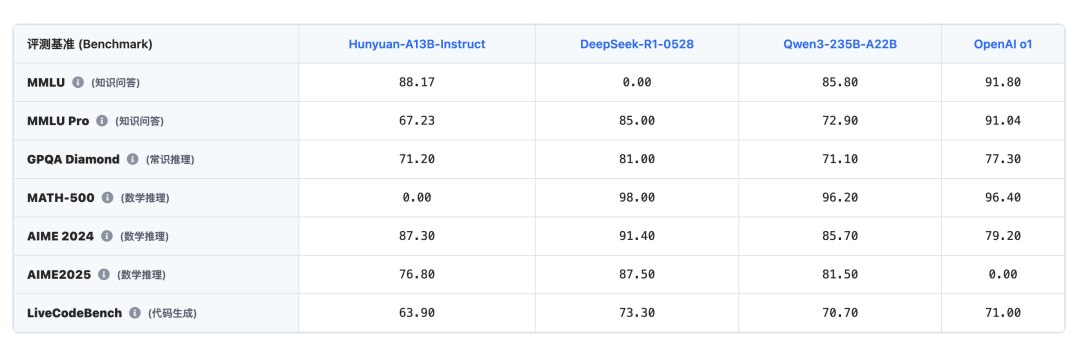

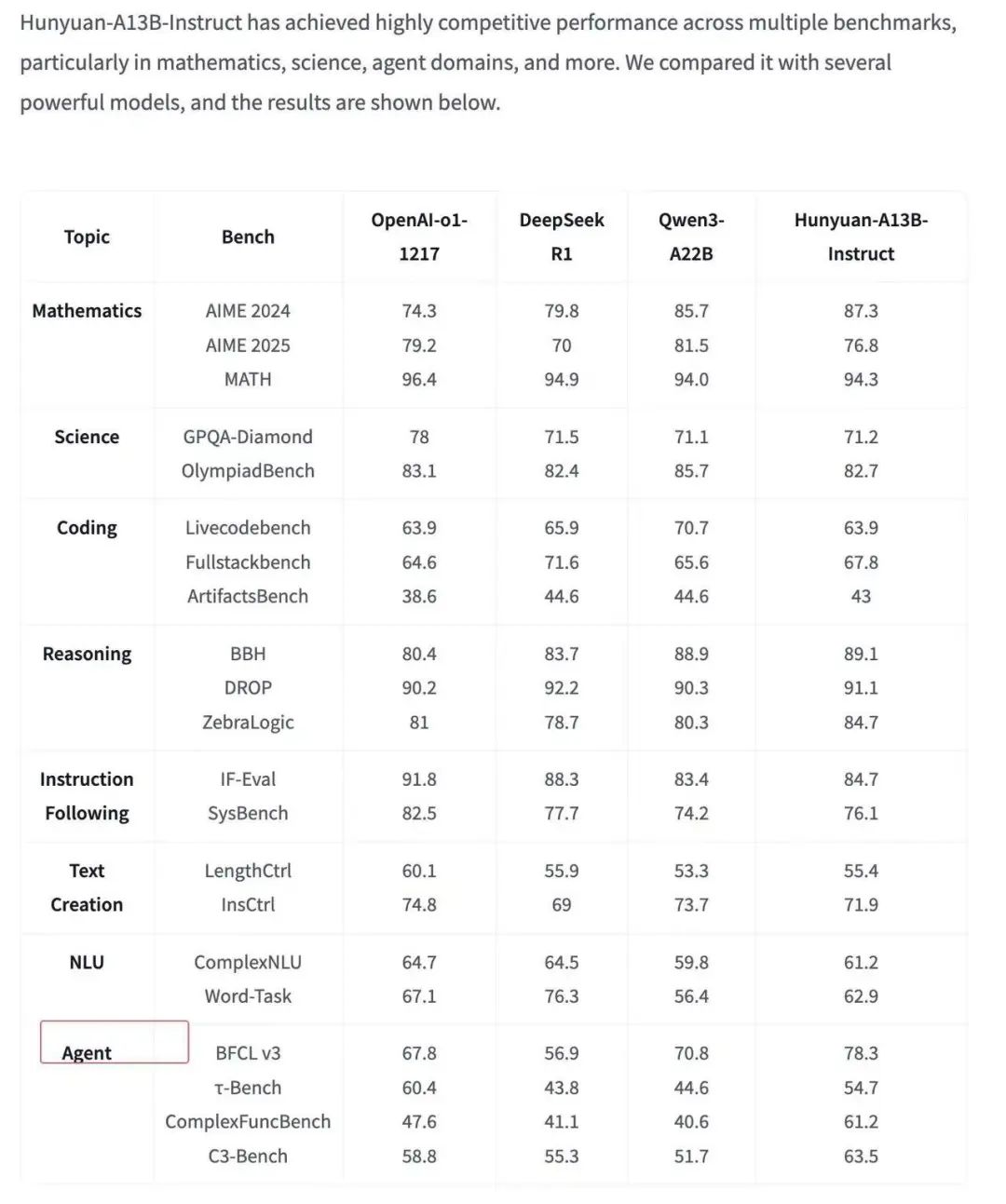

简单来说,Hunyuan-A13B 的定位是一个为资源受限环境设计的高性能、高效率的通用大语言模型,采用MoE(混合专家)架构,总参数800亿,每次推理激活130亿参数。

它的参数规模只有Qwen-235B-A22B 三分之一,但性能已经非常接近了。

模型最高支持256K的超长上下文推理。跟Qwen3系列一样,引入了混合推理模式(Hybrid Inference)。用户可以根据需求,在fast thinking(常规问答、文本生成)和 slow thinking(逻辑推理、代码生成)之间自由切换。

除了能记住本地文件的大量内容外,Hunyuan-A13B 这次还优化了Agent能力,单一任务调用多个MCP Servers的成功率提高了不少,比DeepSeek R1还好,R1时不时会陷入自己的思考逻辑怪圈。

02|如何配置 & 升级空间

配置的方式非常简单,不管你用的是chatwise、chatbox这一大堆的API客户端,只需要保证两个点,这个客户端支持导入兼容OpenAI格式的模型API以及可以通过剪切版导入json形式的MCP Servers配置。

这里我用的是 chatbox,先获取一下Hunyuan-A13B的API Key

🔗 console.cloud.tencent.Com/hunyuan/start

MCP 配置文件,一共也就两工具,简简单单。

{

"mcpServers":{

"fetch":{

"command":"uvx",

"args":[

"mcp-server-fetch"

]

},

"filesystem":{

"command":"npx",

"args":[

"-y",

"@modelcontextprotocol/server-filesystem",

"/Users/username/Desktop",

"/path/to/other/allowed/dir"

]

}

}

}配置步骤跟我操作就好了,一共两步,导入模型和导入工具,

OK啊,用时40s

现在我们都可以体验上Gemini Cli平替版了。

这段时间我还囤了不少好用的MCP,来都来了,可以通过简单配置给这个平替Gemini Cli加上Puppeteer / Playwright(浏览器自动化)、context7(获取各种框架、库的说明文档)、mcp-feedback-enhanced(让模型主动提问,来获取足够信息)、Perplexity (AI 研究)、Magic UI by 21st Dev (UI 生成)能力。

按照我的使用习惯来说,一次性给Hunyuan-A13B安排上10个MCP的工作流,它都可以 hold 得住。

搭配刚刚配置好的本地文件管理能力,

可以减少大量本地操作时间。

写在最后

说实话,还挺有成就感的。

一开始只是想着能不能以最低的成本复刻Gemini-Cli的能力,结果边试边搭,就真的把那一套“本地文件管理+联网搜索”的经典组合拧出来了,还顺带摸清了一堆MCP的新用法。

对我自己来说,这不只是「平替 Gemini-Cli」,而是用一个不绕弯的方式,把大模型的 Agent 能力,落在了真能用起来的地方。

更重要的是,它门槛真的很低。这事搁去年,哪怕是模型能力已经有了,大概也没人能这么丝滑地拼出一套完整链路来。

现在,靠Hunyuan-A13B和几个MCP Server的组合,这套方法就这么落地了。

我真挺喜欢这种感觉的。

把使用门槛降下来后,就会有更多人愿意尝试,

就会更更多新的意想不到的玩法,

就可以搭一大堆好玩的小Agents,

这样循环下来,

或许下一代Agent的雏形

此刻正在疯狂生长。

@ 作者 / 卡尔 & 阿汤@ 动手学AI知识库 / learnprompt.pro

(文:卡尔的AI沃茨)