OpenAI 今日发布了其最新的人工智能推理模型:o3 和 o4-mini。

o3 被誉为该公司迄今“最强大的推理模型”,在数学、编程、推理、科学及视觉理解等多个基准测试中刷新了记录,尤其擅长处理需要多角度分析的复杂查询和视觉任务,并在实际应用中显著减少了错误。

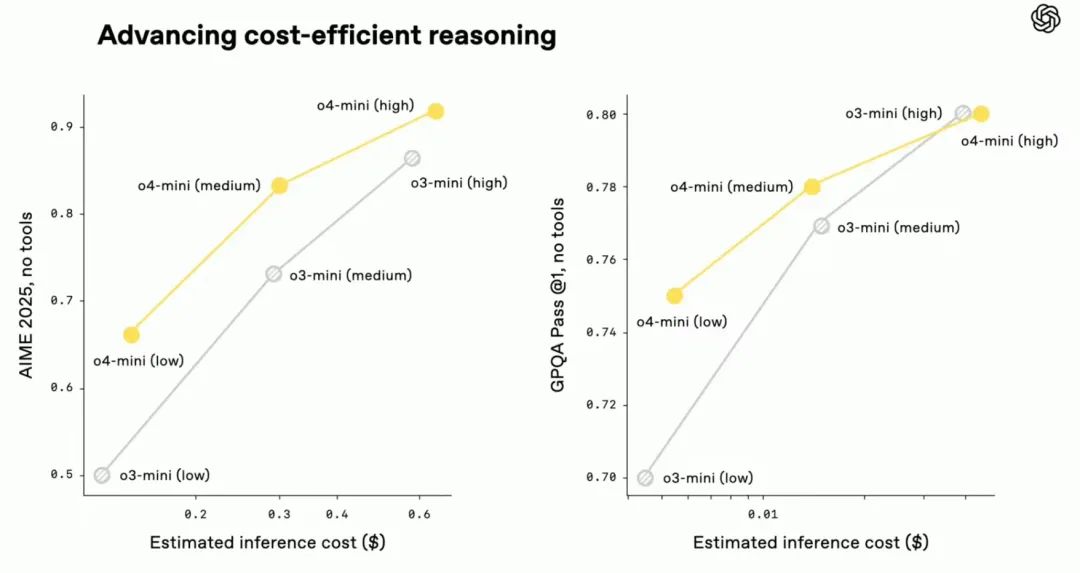

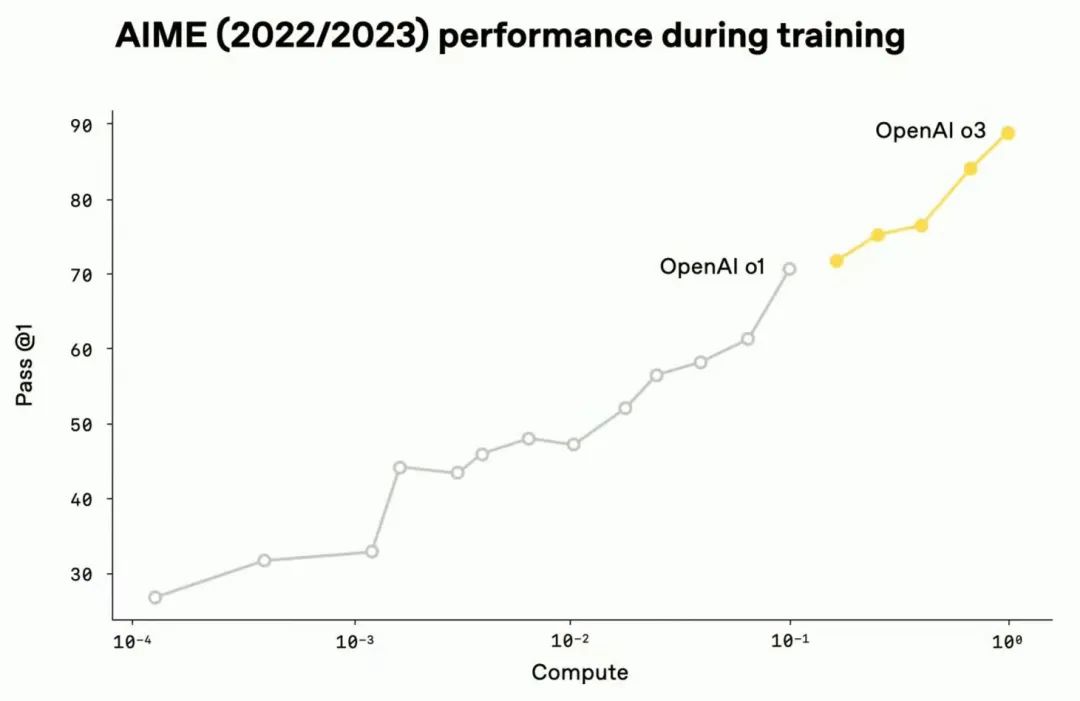

与此同时,o4-mini 作为一款更小巧、快速的模型,旨在提供具有竞争力的价格、速度和性能平衡。它在保持低成本的同时,在数学(如 AIME 基准测试近乎满分)、编程和视觉任务上表现卓越,且支持更高的使用频率,适合需要高吞吐量的场景。

核心亮点:

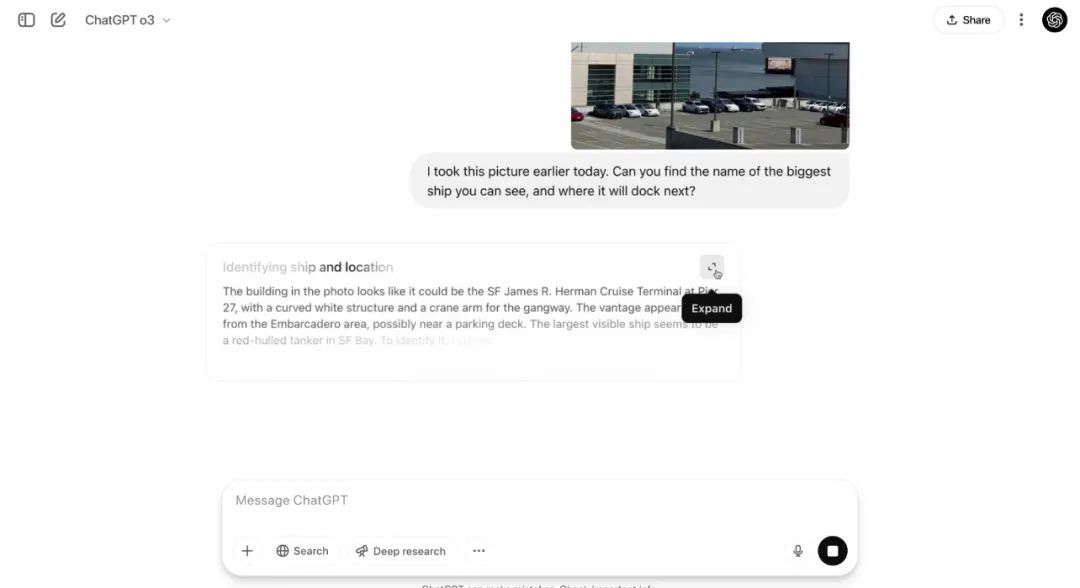

- 图像思考能力: o3 和 o4-mini 是 OpenAI 首批能将图像直接融入推理过程的模型,能够理解模糊或低质量图像,并在分析时进行放大或旋转等操作。还可以结合搜索进行补充思考,完成复杂的福尔摩斯级的深度思考。

- 自主工具使用: 两款模型都能自主调用所有 ChatGPT 工具(如网络浏览、Python 代码执行、图像处理与生成)以及通过 API 调用的自定义工具,以解决复杂问题。现有的Agent编排过程及复杂的提示词设计被模型能力的增强进一步弱化。

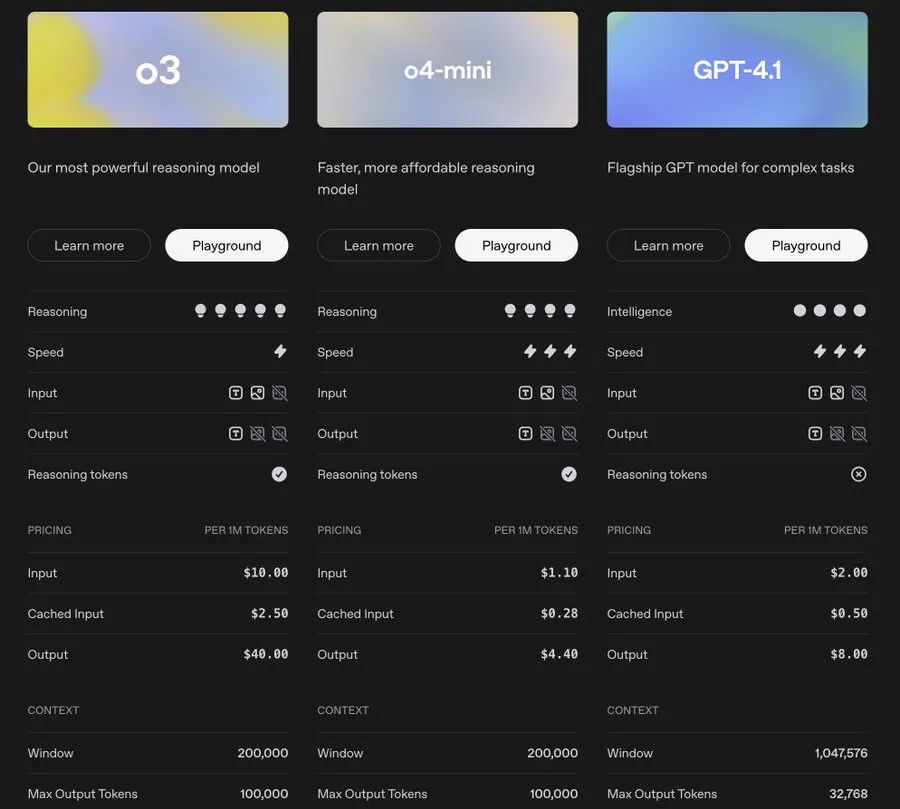

- 性能与成本优化: 相较于前代模型(如 o1 和 o3-mini),新模型在提供更强智能的同时,通常成本更低。例如,o3-mini 相较于 o1-mini 价格降低了 63%。

- API 更新: o3 和 o4-mini 通过 API 提供 20 万 token 的上下文窗口、最高 10 万 token 的输出,知识截止日期更新至 2024 年 6 月 1 日。

- 强化学习进展: 开发过程验证了强化学习也遵循“计算量越大=性能越好”的扩展定律,提升了模型的推理和工具使用能力。

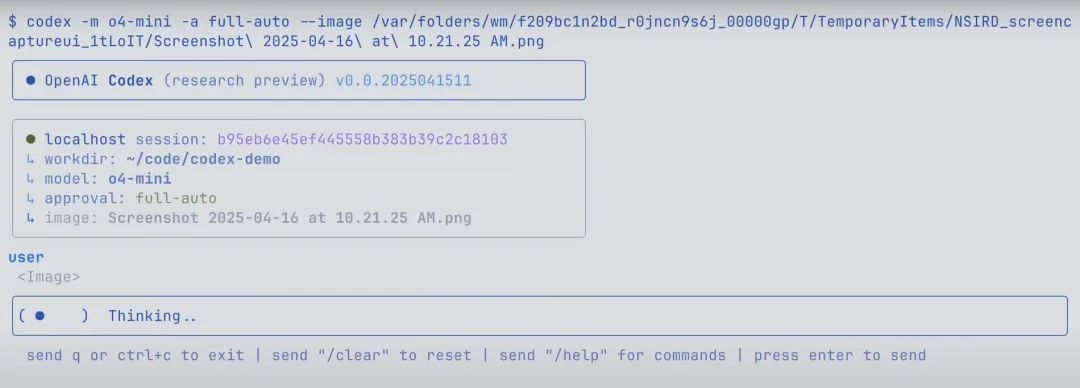

- Codex CLI: 一款新的开源命令行工具,可在本地终端运行,将自然语言转化为代码,充分利用 o3 等模型的推理能力,支持多模态输入。地址:https://github.com/openai/codex

- 可用性: o3 和 o4-mini 已通过 API 向开发者开放。ChatGPT Plus、Pro 及 Team 用户今日起可在 o3、o4-mini 和 o4-mini-high 版本上使用新模型及其工具能力,o3-pro 版本将在数周内跟进。旧版模型(o1、o3-mini 等)将逐步淘汰。

小结:

此次 o3 与 o4-mini 的发布,再一次将模型能力边界向前推进一大步,过去针对图片的看图说话进阶成“福尔摩斯”级的深度思考,而工具调用进阶为“manus”级的全能工具人,agentic workflow的过渡价值被大大压缩。什么样的产品才能不被大模型所吞噬又成为迫切回答的问题。

公众号回复“进群”入群讨论。

(文:AI工程化)