月度归档: 2025 年 4 月

开源推理大模型全面开花的一周:多模态、RAG、Agent、编码

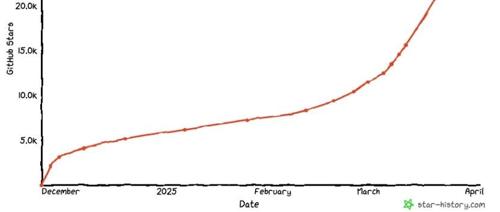

热门模型排行榜Top10中出现多款推理大模型,包括代码推理、混合专家视觉-语言模型等。DeepCoder-14B-Preview在LiveCodeBench v5上的准确率提升了8%,仅用140亿参数实现相似性能;Llama-3.1-Nemotron-Ultra-253B-v1基于Meta Llama-3.1-405B-Instruct训练,支持长达128K标记上下文长度。OpenCodeReasoning是最大推理编程合成数据集,用于监督式微调;Kimi-VL-A3B-Thinking在多模态推理和视觉理解方面表现出色;Seed-Thinking-v1.5采用强化学习算法提升模型训练效率。

264页最强 Agents 发展与挑战综述,微软&谷歌&MetaGPT联合出品!

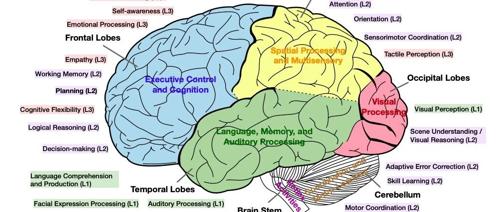

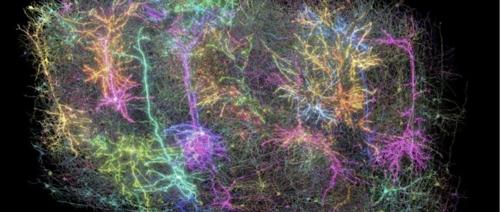

MetaGPT联合多家机构发布《Foundation Agents》报告,概述智能代理的发展与挑战,涵盖模块化架构、脑区功能映射、自我进化机制、协作与进化multi-Agent系统等多方面内容。

Kimi-VL 开源

MLNLP社区介绍其致力于促进国内外机器学习与自然语言处理的交流与发展,近期开源了Kimi-VL-A3B-Instruct等视觉理解大模型。该模型参数规模较大且上下文长度长。社区还提供了技术交流群邀请函和简介。

折翼的翅膀,Illustrious写实风格

推荐IllustriousXL_MMMix v8.0,增强写实风格,分辨率1024×1536,使用Euler采样器,步骤25、CFG 5,融合四个模型,包含多个角色如驾驶员、御姐、机械天使等,支持下载。

ChatGPT正转型为伴侣AI!

ChatGPT即将转型为伴侣AI,接近OpenAI秘密野心。多位科技界人士指出,随着技术进步和用户需求变化,未来可能人人都拥有个人AI伙伴。这一趋势引发广泛关注与讨论。

熵与优雅:GPT正在解压的宇宙分形密码

在Sam Altman与Daniel Selsam的对话中,讨论了GPT-4.5实验背后的扩展法则。Daniel提出智能源于压缩,而宇宙的知识是一个可以不断挖掘的分形。这引发了一个问题:为什么训练更大的模型需要更长的时间却能得到更好的结果?通过压缩原理,AI能发现隐藏在数据中的稀有而有意义的模式,揭示出现实是递归可压缩的本质。