机器之心

机器之心

103K「硬核」题,让大模型突破数学推理瓶颈

本文介绍了一篇关于 DeepMath-103K 数据集的研究论文,该数据集旨在解决当前大语言模型在数学推理训练中的数据瓶颈问题。论文详细描述了其高难度、新颖性和纯净性的特点,并展示了在多个基准测试中的卓越性能。

Mistral的首个强推理模型:拥抱开源,推理速度快10倍

欧洲人工智能公司 Mistral AI 推出了 Magistral 系列大语言模型,具备强大的推理能力。Magistral Medium 和 Magistral Small 分别面向企业客户和开源社区,支持 Apache 2.0 许可,并在多种测试中表现出色。

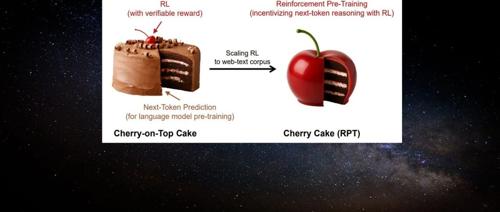

「Next-Token」范式改变!刚刚,强化学习预训练来了

机器学习研究者提出一种名为”强化预训练”的新方法,它将下一个 token 预测任务重构为对 next-token 的推理过程。通过可验证奖励的强化学习,这种方法利用海量无标注文本数据进行通用预训练,显著提升语言建模准确性,并有望推动大模型发展的有效路径。

高考数学全卷重赛!一道题难倒所有大模型,新选手Gemini夺冠,豆包DeepSeek并列第二

大模型在数学推理和解答题上表现参差不齐,多数模型在图像识别方面仍存在问题。总体来看,大模型在复杂推理、严谨论证及多步骤计算能力上有较大提升空间。

一个md文件收获超400 star,这份综述分四大范式全面解析了3D场景生成

该综述全面调研了3D场景生成领域,将现有方法划分为四大类,并揭示了不同方法在可控性、真实性、效率与一致性之间的权衡,提出了高质量数据瓶颈和评估缺乏统一标准等四大挑战及未来发展方向。

扩散语言模型真的会比自回归好?理论分析结果可能恰恰相反

扩散语言模型在某些关键场景下可能不如自回归模型高效。基于理论分析和实验结果,研究提出应根据任务需求选择合适的目标衡量指标(如流畅度或序列级别准确性和逻辑正确性),从而为实践中如何使用扩散语言模型提供指导。

李飞飞团队新作:DiT不训练直接改架构,模型深度减半,质量还提高了

该研究提出了一种高效的方法来构建具有良好生成质量的混合架构,通过嫁接现有算子以实现显著加速,并在实时计算速度上实现了1.43倍的提升。

视频生成1.3B碾压14B、图像生成直逼GPT-4o!港科&快手开源测试时扩展新范式

香港科技大学联合快手可灵团队提出EvoSearch方法,通过演化搜索提升视觉生成模型的性能。该方法无需训练参数,仅需计算资源即可在多个任务上取得显著最优效果,并且具有良好的扩展性和泛化性。