字节跳动已将其内部成熟的AI Agent平台“扣子(Coze)”的核心引擎以Coze Studio之名开源。这不只是一个让你拖拽生成聊天机器人的工具,它是一套遵循领域驱动设计(DDD)和微服务架构的企业级AI应用开发框架。它将模型、插件、知识库(RAG)、工作流等核心功能解构成透明、可控、可替换的模块化组件,赋能开发者成为“AI基础设施的架构师”,为构建严肃、可扩展、自主可控的AI应用提供了一套工业级的解决方案。

Coze Studio 概览:它究竟能做什么?

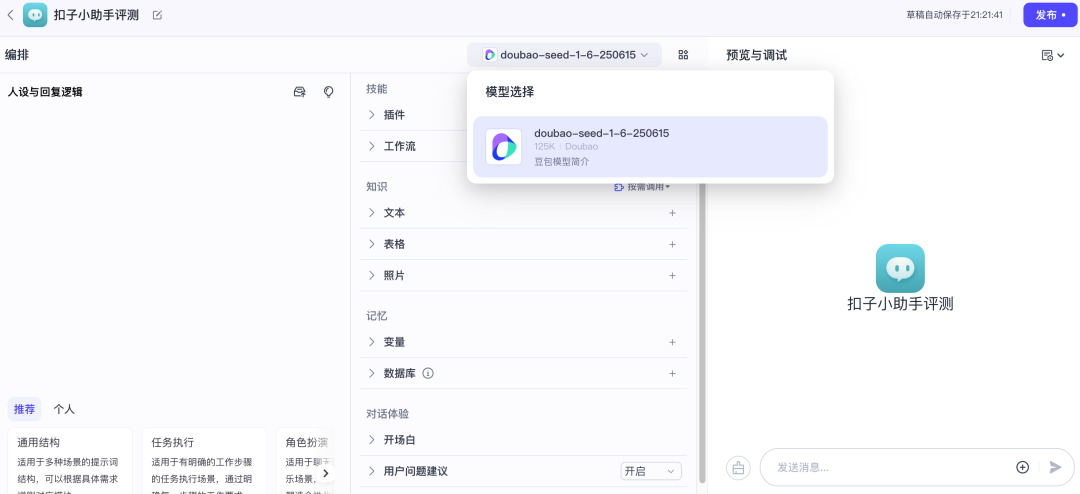

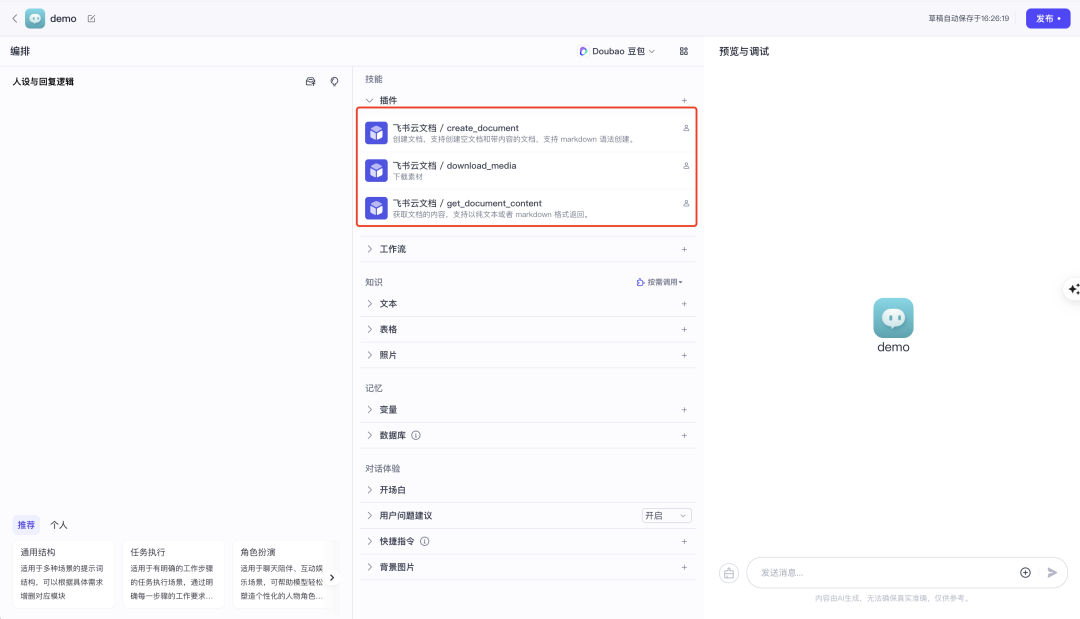

Coze Studio 旨在降低 AI Agent 的开发与应用门槛。借助其提供的可视化设计与编排工具,开发者能以零代码或低代码的方式,快速搭建和调试以下三类AI项目:

-

• 🤖 搭建智能体 (Bot):基于对话的 AI 项目,能通过调用插件或工作流执行用户指定的业务流程,适用于智能客服、个人助理等场景。 -

• 🧩 搭建 AI 应用 (APP):具备完整业务逻辑和可视化用户界面的独立 AI 项目,可以完成AI搜索、翻译工具等更复杂的任务。 -

• ⚙️ 搭建工作流 (Workflow):用于处理逻辑复杂且稳定性要求高的任务流。在可视化的画布上,可以通过拖拽方式组合大语言模型(LLM)、自定义代码、判断逻辑等节点,构建强大的自动化流程。

功能清单

下表概括了 Coze Studio 的主要功能模块,展示了其从底层资源管理到上层应用集成的全面能力。

| 功能模块 | 功能点 |

| 模型服务 |

|

| 搭建智能体 | 编排、发布、管理智能体

|

| 搭建应用 |

|

| 搭建工作流 |

|

| 开发资源 |

|

| API 与 SDK |

|

架构深潜:为可扩展与可维护性而设计

Coze Studio 优雅的软件架构是其能够被称为“框架”而非“工具”的底气所在。

核心哲学:领域驱动设计 (DDD)

Coze Studio 的后端严格遵循 领域驱动设计(DDD) 原则,通过清晰的分层来隔离变化,为构建稳定、可演进的企业级AI应用提供了坚实的工程基础。

-

• 领域层 ( /domain): 项目的心脏,定义了“智能体由什么构成”等核心业务逻辑和规则。 -

• 基础设施层 ( /infra): 项目的四肢,负责所有外部交互,如数据库操作、缓存读写。

这种设计让技术选型变得灵活且低风险。例如,领域层的 KnowledgeBase 对象只调用 VectorStore 接口,它不关心底层用的是 Milvus 还是 VikingDB。当需要更换数据库时,只需在基础设施层增加一个新实现,无需改动任何核心业务代码。

项目技术栈与结构

为保证性能与可靠性,Coze Studio 采用了成熟的现代化技术栈:

-

• 后端: Go 语言及字节跳动Cloudwego出品的高性能HTTP框架 Hertz。 -

• 前端: React + TypeScript。 -

• 核心组件: 采用微服务理念,通过Docker Compose管理 MySQL, Redis, MinIO, RocketMQ, Elasticsearch, Milvus 等核心依赖。

其清晰的目录结构对二次开发者非常友好,以下为项目核心目录的进一步展开:

├── backend/ # 后端服务 (Go)

│ ├── api/ # API层: handler, middleware, router...

│ ├── application/ # 应用层: conversation, knowledge, plugin...

│ ├── domain/ # 领域层: agent, app, workflow...

│ └── infra/ # 基础设施层: contract (接口), impl (实现)

├── frontend/ # 前端应用 (React + TypeScript)

│ ├── apps/coze-studio/ # Coze Studio主应用

│ └── packages/ # 可复用包: agent-ide, workflow, components...

├── docker/ # Docker及服务配置 (.env)

└── idl/ # 接口定义语言文件 (Thrift)功能全解剖:模块化、可插拔的核心能力

Coze Studio 将所有AI功能都解构成了开发者可以理解、配置和替换的模块。

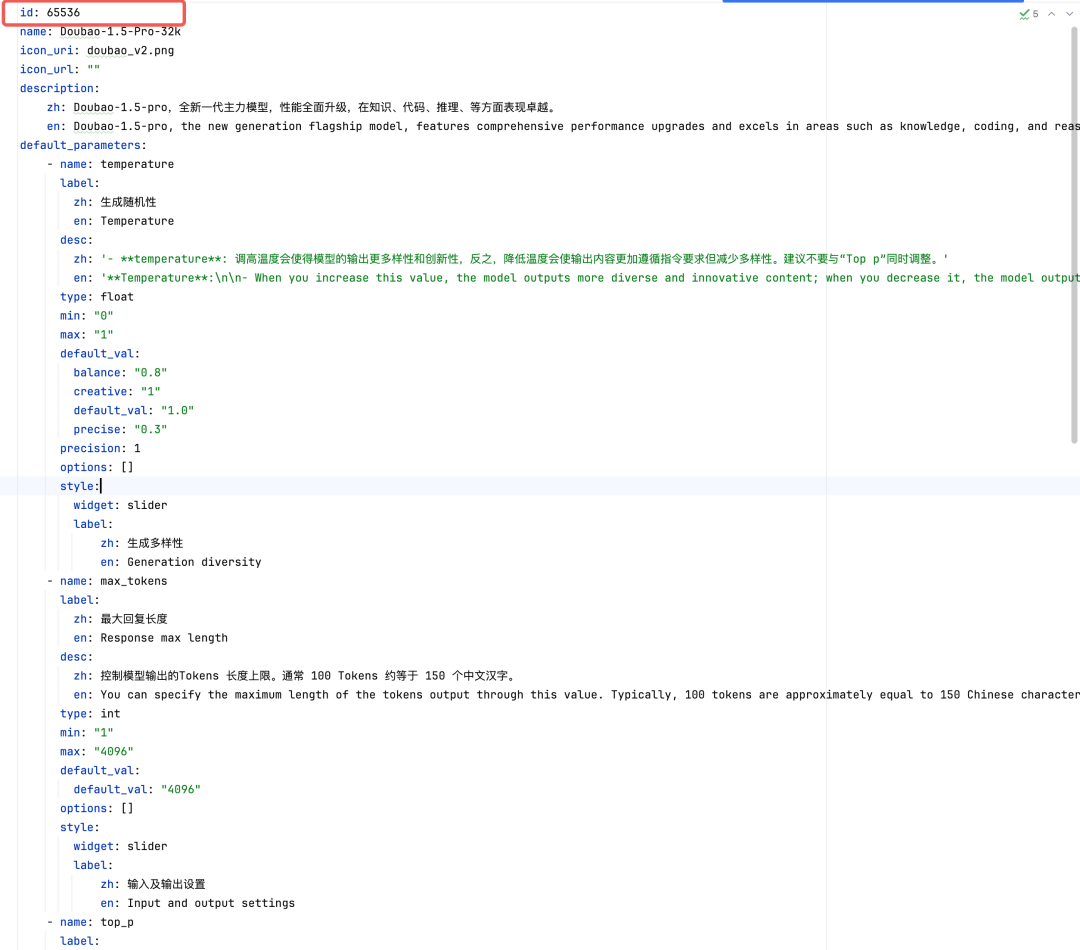

(一)协议级模型支持

模型接入远非简单的API封装,它支持深入到协议层。通过修改模型YAML配置文件,可以进行精细化配置,如为OpenAI选择by_azure,或为Claude选择by_bedrock,从而充分利用不同云厂商的部署优化。

.yaml)

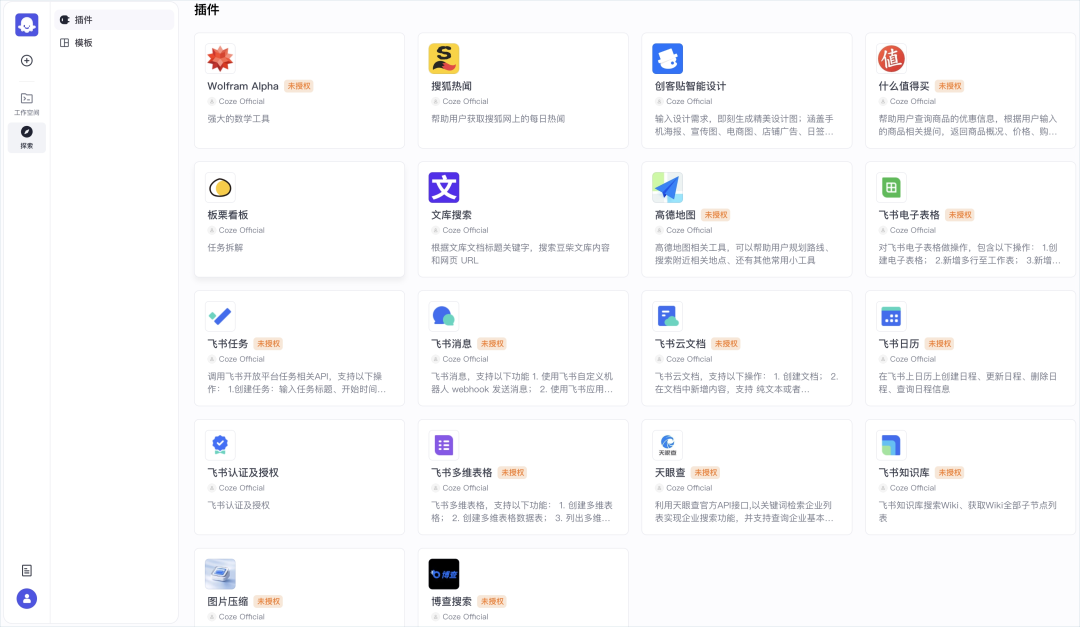

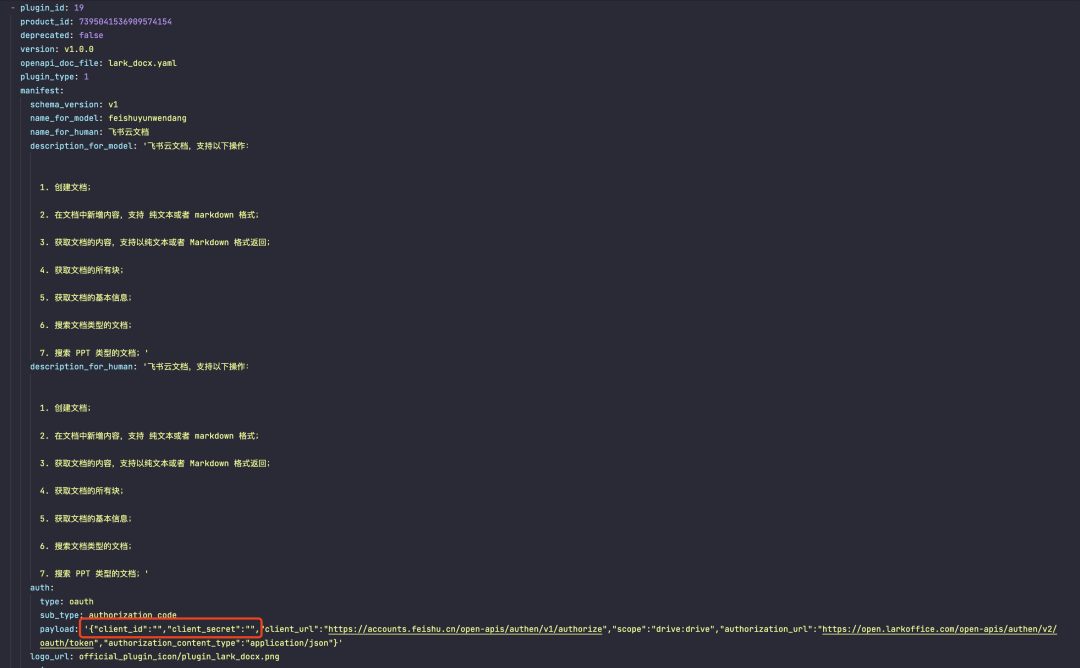

(二)企业级插件框架

插件是Agent连接外部世界的手脚。Coze Studio提供了丰富的内置插件(如高德地图、飞书、天眼查、什么值得买),并支持自定义开发。每个插件都由一个严谨的YAML Schema定义,包含openapi_doc_file来约束API契约,并支持OAuth2.0和API Key等多种企业级鉴权方式。

.yaml)

(三)RAG框架全透明:知识库

知识库(RAG)是解决模型幻觉、注入私有数据的关键。Coze Studio 将其实现过程完全透明化,变成了一条开发者可以自由组装的流水线。

一个文档的上传和处理包含以下可控环节:

-

1. 上传组件: 可选本地 MinIO、火山引擎 TOS 或 ImageX。 -

2. OCR服务: 可配置火山引擎OCR,用于识别图片和扫描件中的文字。 -

3. Embedding模型: 可选 OpenAI、Ark 或自定义的HTTP服务进行文本向量化。 -

4. 向量数据库: 可选开源的 Milvus 或火山引擎的 VikingDB 进行存储和检索。 -

5. AI生成模型: 知识库还依赖一个独立的AI模型来执行NL2SQL(自然语言转数据库查询)、Message to Query(一句话生成查询)等高级功能。

(四)强大的工作流引擎

工作流是Coze Studio的核心编排能力。

-

• 可视化编排: 通过拖拽节点构建复杂逻辑。 -

• 流式与非流式: 支持 v1/workflow/run(一次性返回结果)和v1/workflow/stream_run(流式返回)两种执行API,适应不同场景。 -

• 中断与恢复: 对于包含“问答节点”的工作流,执行时会自动中断并等待用户输入,开发者可调用 v1/workflow/stream_resume接口传入用户回答以恢复运行。 -

• 调试支持: API执行后会返回 debug_url,可直接在浏览器中查看每个节点的详细输入输出,极大方便了调试。

(五)数据库作为资源

在Coze Studio中,数据库可以像插件和知识库一样,被创建和管理。这意味着你可以在工作流中方便地连接和操作你的业务数据库,让Agent具备直接读写业务数据的能力。

API 设计:上下文的精细化管理

Coze Studio的API设计体现了对复杂对话场景的深刻理解。

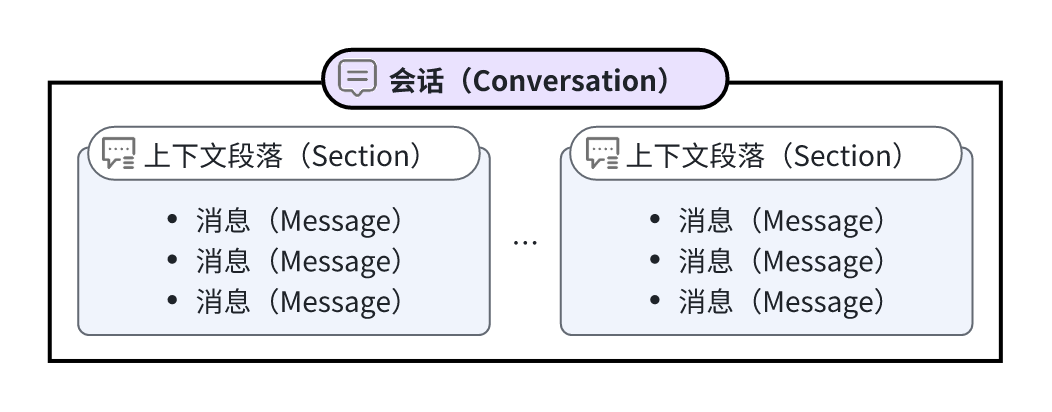

核心:三层ID体系

其API通过精细的ID体系,赋予开发者对会话上下文的细粒度控制能力:

-

• conversation_id: 标识与一个智能体的完整对话历史。 -

• chat_id: 标识一次具体的请求-响应交互。 -

• section_id: 标识一个连续的上下文片段。可通过/v1/conversations/:conversation_id/clear接口创建新片段以开启新话题,实现上下文的刷新与隔离。

剖析字节生态集成:是便利还是绑定?

一个关键问题是,Coze Studio 对其母公司字节跳动的生态依赖程度如何?经过对所有配置文件的分析,结论是:项目提供了深度、便捷的字节生态集成,但始终保留了开放、中立的架构。

| 集成层面 | 字节跳动相关服务 | 角色与集成方式 |

| 模型计算层 | 火山方舟 (Volcano Ark) |

|

| 存储层 | 火山引擎对象存储TOS

|

|

| AI服务层 | 火山引擎OCR

|

|

| 应用生态层 | 飞书 (Lark) 套件插件 |

|

总体来看,Coze Studio 在开源的彻底性上表现出色。 它在平衡利用自有生态优势和保持平台开放性之间做出了明智的选择,目前重度依赖字节火山生态,第三方生态的兼容看项目后续的进展和开源社区的贡献。

快速上手与社区支持

四步完成本地部署

-

1. 克隆源码: git clone https://github.com/coze-dev/coze-studio.git -

2. 配置模型: 复制 backend/conf/model/template下的模板到backend/conf/model,并填入你的API Key。 -

3. 启动服务: cd docker && cp .env.example .env && docker compose --profile "*" up -d -

4. 访问: 打开浏览器 http://localhost:8888/即可注册登录。

结论:AI 应用开发的“架构师时代”

Coze Studio的开源,提供的不只是一个“好用的工具”。它通过一个优雅、健壮、透明的框架,系统性地展示了如何用工业级的软件工程思想来构建和管理复杂的AI应用。它将开发者从繁琐的API“胶水代码”中解放出来,提升到了“AI基础设施架构师”的高度,让我们得以关注更重要的事情:业务逻辑的实现、技术栈的优化和商业价值的创造。

相关资源

-

• Coze Studio GitHub 仓库: https://github.com/coze-dev/coze-studio

(文:子非AI)