「具备更深层次理解能力的视觉领域基础模型(可能带来视觉的“GPT-3时刻”),有望在未来 1-2 年内出现。」

-

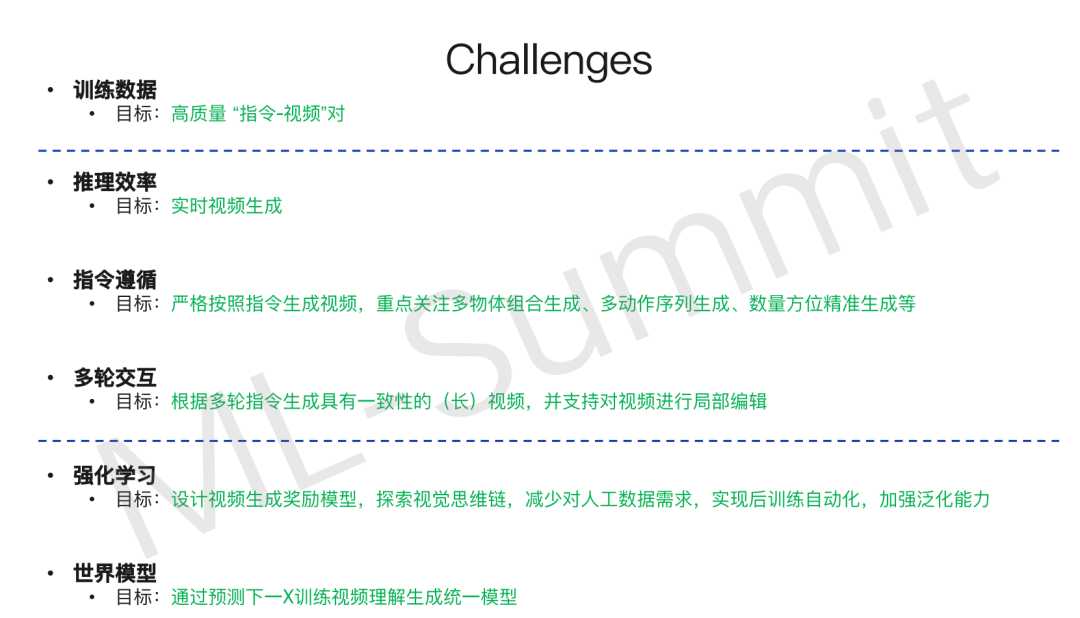

视频 Scaling Law 的独特性: 与语言模型不同,当前 Diffusion 视频模型(即便达到 30B 参数)在泛化能力上的 Scaling Law 表现并不显著,但其记忆能力很强。中等规模参数(如 15B)可能在效率与性能间取得更好平衡。 -

超越“生成”到“理解”: 目前主流视频生成类似“文本到视觉的翻译”,存在上限。真正的突破在于模型需具备深度视觉理解能力,而非仅仅像素生成,这需要学习范式的转变,从“映射学习”到类似语言模型的“因果预测学习”。 -

AR 与 Diffusion 融合: 未来的模型架构趋势可能是自回归(Autoregressive)与扩散(Diffusion)模型的融合,以期结合两者优势,更好地服务于视频乃至多模态内容的理解与生成。 -

数据仍是基石与瓶颈: 高质量、大规模、多样化的自然数据(而非过度依赖合成数据进行基础训练)对构建强大的基础模型至关重要。数据处理、标注的复杂性与成本是巨大挑战。 -

视觉的“Few-Shot Learning”时刻: 下一代视觉基础模型的关键能力将是强大的少样本学习(Few-Shot Learning)能力,使其能快速适应并解决新的视觉任务,类似 GPT-3 为 NLP 带来的变革。 -

可用性与影响力并重: 技术创新固然重要,但模型的易用性、能否被广大开发者和创作者实际使用起来,是衡量其影响力的关键,也是研究需要兼顾的目标。 -

AI 与具身智能的未来: 视频理解能力的进步,将为具身智能、机器人等需要与物理世界交互的 AI 应用提供核心的感知能力。

-

BERT 模型:它极大地提升了自然语言的表征能力。之后 NLP 领域形成了编码器(如 BERT)、编码器-解码器(如 T5)和纯解码器(如 GPT)三足鼎立的局面。 -

GPT-3 模型:当数据和参数规模达到一定程度后,展现出的少样本学习(few-shot learning)能力是一个里程碑,基本确立了模型架构的方向。 -

InstructGPT/ChatGPT:通过指令对齐和强化学习(RLHF),使得模型能极好地遵循指令,这是又一个重大里程碑,基本奠定了 NLP 的范式。 -

DeepSeek 系列模型:在国内,DeepSeek 做出了一系列非常出色的模型(如Math、Code、V 系列及 R1),不仅性能优异,且能让大家实际用起来,非常了不起。 -

Sora 模型:在多模态生成领域,Sora 的出现真正让视频生成成为焦点。 -

GPT-4o/Gemini 2.5:这类模型真正将图像和文字的统一理解推向了新的高度,非常关键。

-

Full Attention:早期尝试过时空分离再堆叠的结构,后来发现 Full Attention 机制能让信息在模型内部充分交互,对运动幅度提升很大,这已是共识。 -

架构选择(DIT + Cross Attention vs MMDIT):我们选择了 DIT 加 Cross Attention,而像 Meta 的 Movie Gen 和阿里的万相(Wan)也是类似架构。一些闭源模型或大厂可能倾向于 MMDIT(尽早融合文本和视觉信息)。理论上 MMDIT 对指令控制可能更好,但我们选择前者也考虑了模型未来向视觉基础模型演进的兼容性。这并非最优选择,各有优劣。 -

模型规模(30B):选择 30B 是为了探索模型规模与效果的关系。结论是,Diffusion 模型的 Scaling Law 在 4B 到 30B 区间,泛化能力提升不如语言模型明显,但记忆能力很强。对于追求效率和性能平衡,15B 左右可能是个不错的选择。若要探索 AGI 或模型上限且资源充足,可以继续调优或尝试更大模型。

-

数据处理至关重要。包括视频切分、水印字幕处理、内容描述、美感度、运动性、清晰度、镜头抖动、镜头语言标注等,都需要投入巨大精力,并且要亲力亲为。

-

拥有强大的系统团队支持非常关键。在此也感谢阶跃星辰的系统团队,他们非常强大,我从他们身上学到很多,对项目的支持至关重要。

-

文生视频模型 Step-Video-T2(30B):在视频运动性上做了加强,主要通过数据和训练策略实现。在体育运动、物理规律遵循方面表现不错。今年 1 月底 2 月初发布时,与国内外主流模型对比,在开源模型中应属 SOTA,在某些维度上也很有特色。 -

图生视频模型 Step-Video-TI2V(30B):由于训练初期接触了大量二次元动漫数据,因此在这类风格上质量很好。我们也与万兴等产品做过对比。

-

视频生成长度变长,增强叙事性; -

编辑能力不断提升,增强可控性; -

基于参考的图像/视频生成发展迅速,未来人人都可以当主角。

-

模型结构范式变化:从纯 Diffusion 模型向 Autoregressive 与 Diffusion 融合的方向发展。 -

学习范式变化:从文本到视频的映射学习,转变为像语言模型那样对因果关系进行预测的学习。 -

能力变化:AIGC 角度是生成能力,但其泛化性不如语言模型。基础模型最强的能力应是 few-shot learning,即在少量新任务样本下快速解决该类问题。类比视觉,未来可能给模型看几个特效(如物体捏爆)的例子,它就能直接输出类似效果,无需额外训练。

-

技能栈拓展:过去我可能过多关注算法和所谓创新本身,忽视了数据和系统在大型项目中的重要性。这一年在这方面积累了经验。 -

可用性:项目不仅要追求学术上限,还要考虑可用性,尤其是在不同环境下。一个有影响力的研究,在这个时代一定要能被人用起来。 -

认知变化:更深刻理解了技术创新与广泛应用之间的关系。 -

不变的:对技术本身的追求始终没有变过。大的方向上,我相信一些事情终究会发生,向这个大方向努力的目标没有变。

-

应用层面:AI新型应用目前还不确定,未来可能会有发展。 -

模型层面:多模态模型会向物理世界发展,更好地感知视觉,比如动作理解等。这方面成果会越来越多、越来越扎实。

(文:AI科技大本营)