别眨眼,来看看这句:

作为生成式 AI,GPT 拥有多种形态:在网页端是 Chatbot;在 API 端,可以被封装为各种套壳应用。目前 GPT-4o 支持多模态输入,Token 上限高达 128k,生成延迟约 10–20 毫秒。OpenAI 还推出了 o 系列推理大模型,o3具备更强的多模态能力

能完全理解这里面的各种 AI 名词的朋友请举手,现在可以往后看看我以提示语形式做出来的联想记忆法,这大概率能帮助你区分开 MCP 和 Function Call、对话形式和工作流形式 Agent等概念。

如果你看到这段话时一脸懵,想的是 chatbot是啥? api是啥? 套壳、多模态、token都是啥啊?

那更好了,今天就是来解决这个问题的!

这篇文章适用于接触AI任何阶段的你,帮你了解你现在不知道的和以后遇见可能不理解的那些“AI黑话”。

为啥突然写这个呢?

因为我身边总是有一些刚刚入门AI的朋友,他们不理解这些名词,然后有些人又不好意思问,

而且我每天读、写文章时发现,

在一篇文章中很难同时满足以下三点:

-

零前置知识:不假设读者背景,解释所有概念。 -

篇幅紧凑:舍弃不必要的展开,快速抵达要点。 -

内容趣味:用故事、类比、幽默、张力等方式表达。

资源是有限的,尤其是注意力和篇幅。

我就没看到哪一本《XXX从入门到精通》是薄的,

当然厚的我也一本没看完(狗头)。

那如果用 AI 做一个名词的翻译的话,事情是不是已经解决了99%呢?

真要那么简单就好了,

Token 这个词翻译成成「词元」、Agent 翻译成「智能体」、RAG 翻译成「基于检索增强生成」、Prompt 翻译成「提示语」,

本质上就是跟我告诉你 McDonald’s 是麦当劳一样,

你没吃到麦辣鸡腿堡之前这个名字是没有意义的,它在你脑子里没有味儿啊。

那有没有一种方法能够满足快速记忆的同时,又能让你迅速理解其中意思,又又能控制模型解释术语时的长篇大论呢?

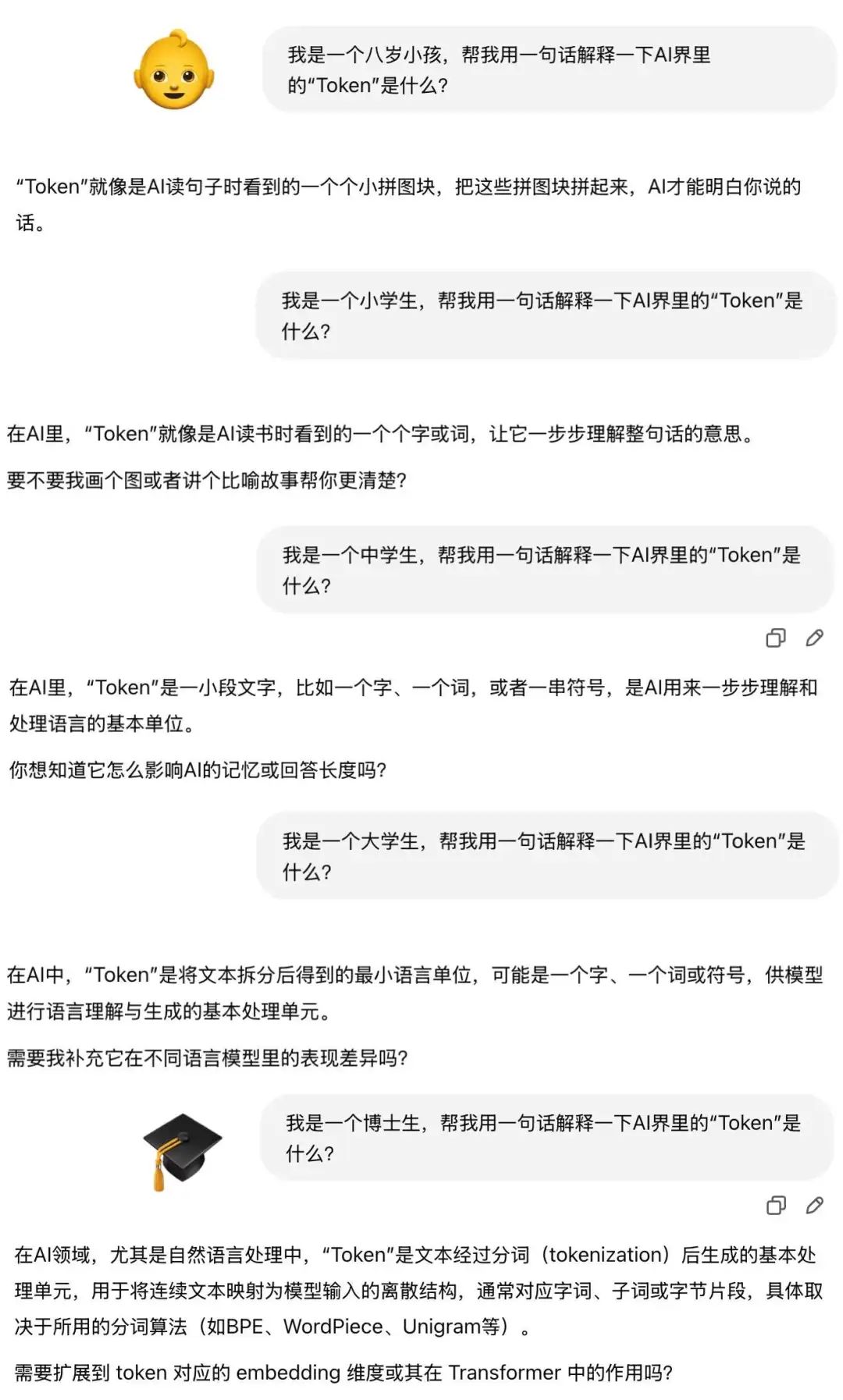

我们试试按照八岁小孩、小学生、中学生、大学生、本硕博等分类的方法让AI帮你解释,你会在同一个词会得到下面这些:

因为指定的身份太宽泛、AI 又不知道你会什么,

它就会偏向用一些通用的、假设大家都知道的概念来形容一个术语,

而对于一个能把多邻国那坨绿鸟逼疯的人来说,

一点用都没有!!

这就是在演我背单词!每个词都是没有联系,

abandon、abandon、abandon……

等过了5个词后,明明26字母我都认识,这个词我肯定见过,我还是不理解它的意思,

而且更要命的是,我根本没有办法把各种名词联系在一起,也没有我自己已经了解的知识响应,从而组成一个知识网络。

它就是那样一个有着自己独立意思的,孤零零的词,站在那里,和我脑里其他的词毫不认识,没有任何关联。

这,怎么学啊?!

于是我和 o3 一拍即合,经过一场 OpenAI 发布会时长的讨论后,得到的答案是:

加一个联想记忆。

人类的记忆本质在于联结,

新信息如果能挂到已有知识上,就像是有了一把钩子,把他们在我脑子里牢牢地互相钩住;否则就是一张飘在天上的纸片,随时都可能被风吹走。

这就是联想记忆的意义。

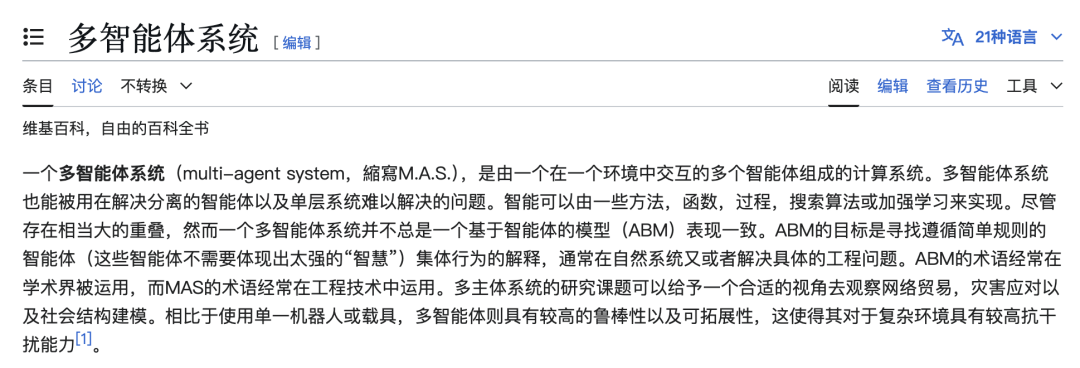

打个比方,现在很多 Agent 产品都会带Multi-agent(多智能体系统)

它的定义是这样👇

说实话我看1/3的时候就开始分神了,这些又长又冷冰冰的文字没有在我脑子激起丝毫波澜,

在我强迫自己开机之前,我看了这些文字,也就是看过了,并没有理解形成记忆。

下次我再看到这个词的时候,又要再查一遍,循环这个看了但又没记住的过程,

不知道你们有没有这样的感觉?

所以,我做成了一个可复用的提示语:(马上教你怎么用!)

## 目标

学习并记忆 AI 术语:<术语名称>

## 已知概念锚点

- 概念A:<简要描述>

- 概念B:<简要描述>

- 概念C:<简要描述>

## 术语定义

<原始定义句子>

## 联想拆解

1. 概念A ↔️ <术语中出现的关键词>:……

2. 概念B ↔️ <术语中出现的关键词>:……

3. 概念C ↔️ <术语中出现的关键词>:……

## 记忆小结

- 一句话记忆:<浓缩后的核心要义>

这样等一个新的产品出来后,你再看到一大堆黑话的时候,就可以拼接成提示语,

用黑话解释黑话,用魔法打败魔法。

而且而且,为了让这个提示语一开始就足够好用,

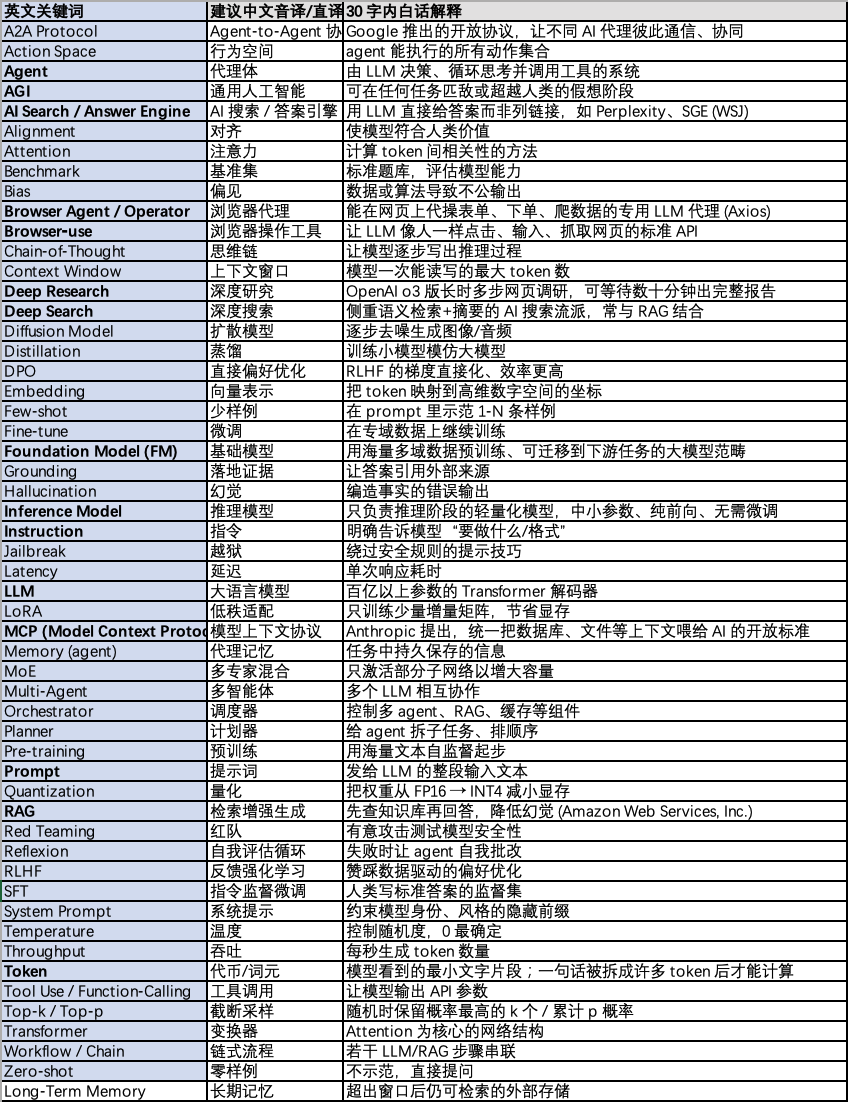

我又跟 o3 deep research 一拍即合,

让它加班给我做了一份23-23年AI大事件相关的产品里常用高频的“黑话”词表以及简单解释,

你可以通过这个来得到一份基础词表。

来看看55个词只懂3个的前提下,OpenAI、Gemini、DeepSeek都会回答什么?

## 目标

学习并记忆 AI 术语:Multi-agent

## 已知概念锚点

* Agent:由 LLM 决策、循环思考并调用工具的系统

* Deep Research:OpenAI o3 版长时多步网页调研,可等待数十分钟出完整报告

* Instruction:明确告诉模型“要做什么/格式”

## 术语定义

在复杂任务中,单一 Agent 容易陷入死循环或知识盲区。多 Agent 架构通过异构智能体协作,利用各自专长分工完成整体目标。每个 Agent 可以独立进行检索、规划或执行动作,并通过中枢 Orchestrator 进行协调。

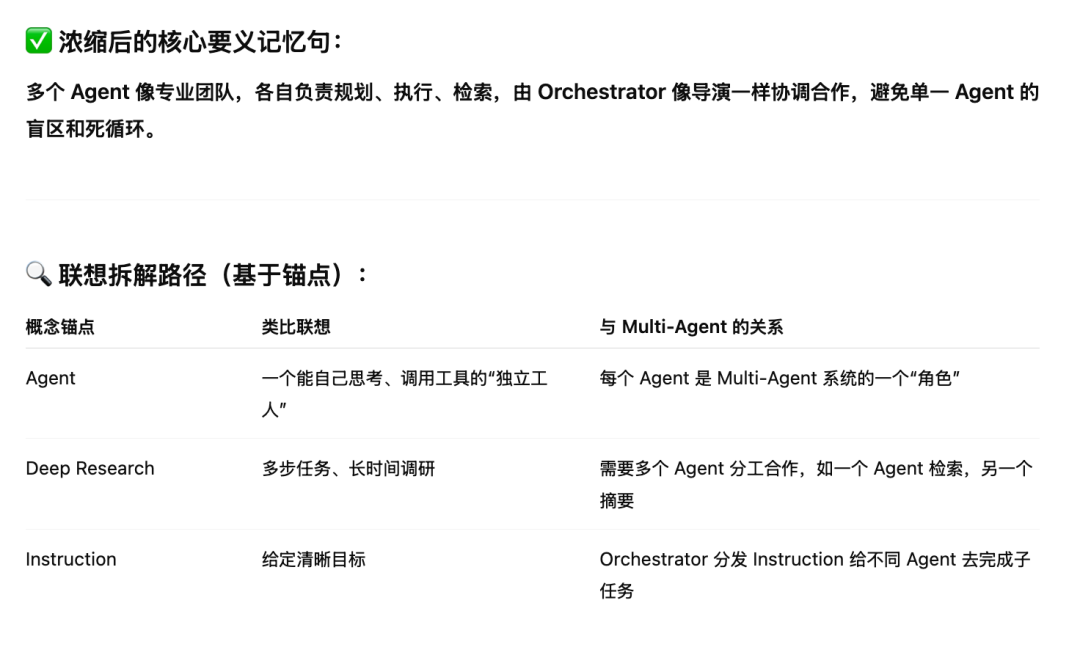

## 记忆小结

* 选择相关的概念锚点来联想拆解,输出一句话记忆:<浓缩后的核心要义>

懂了!

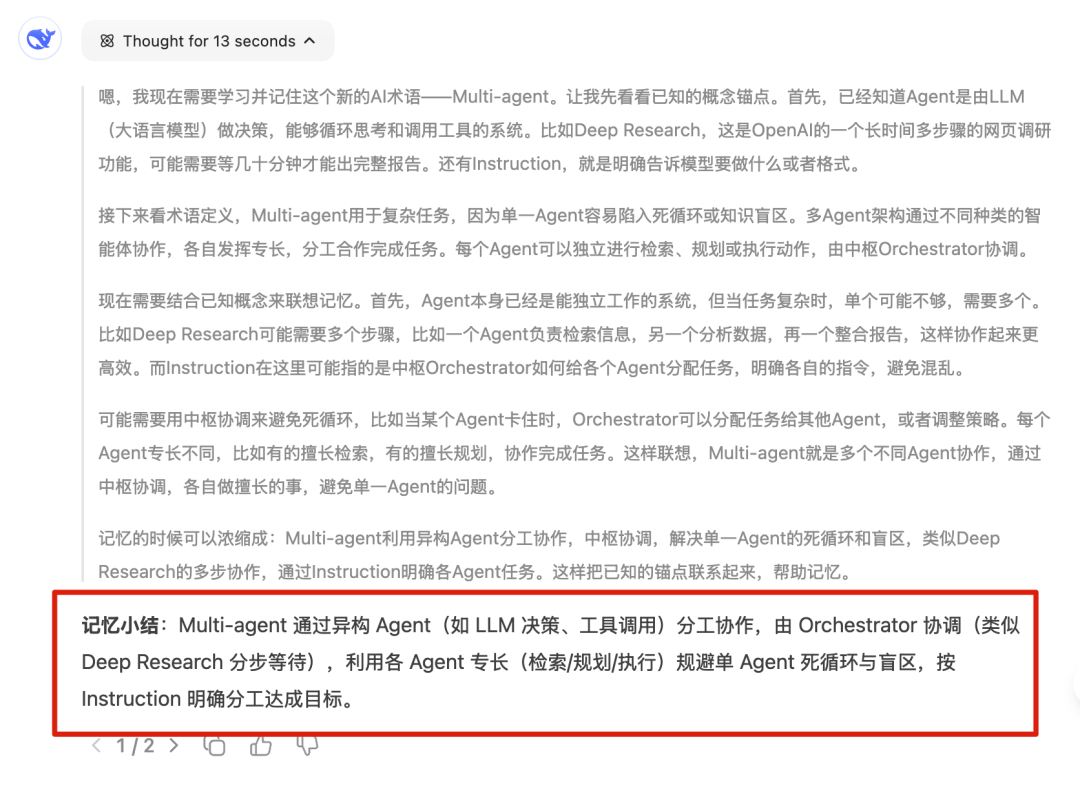

OpenAI 会专注于解释multi-agent,没有被Orchestrator这个陷阱词困住,而且直接给出了这个词起到什么作用,

同时给出了锚点关联表格,我清晰知道了 multi-agent 的定位,它包含了 Agent,里面有 Instruction,Deep Research 是一个multi-agent系统。

这就很清晰了,要的就是用我知道的知识解释新知识的效果,这样有啥黑话你都不怕了。

同样的提示语,换 DeepSeek 帮我解释一下试试:

DeepSeek 的思路跟GPT-4o类似,用括号、短句的形式将相关的锚点植入记忆小结里。

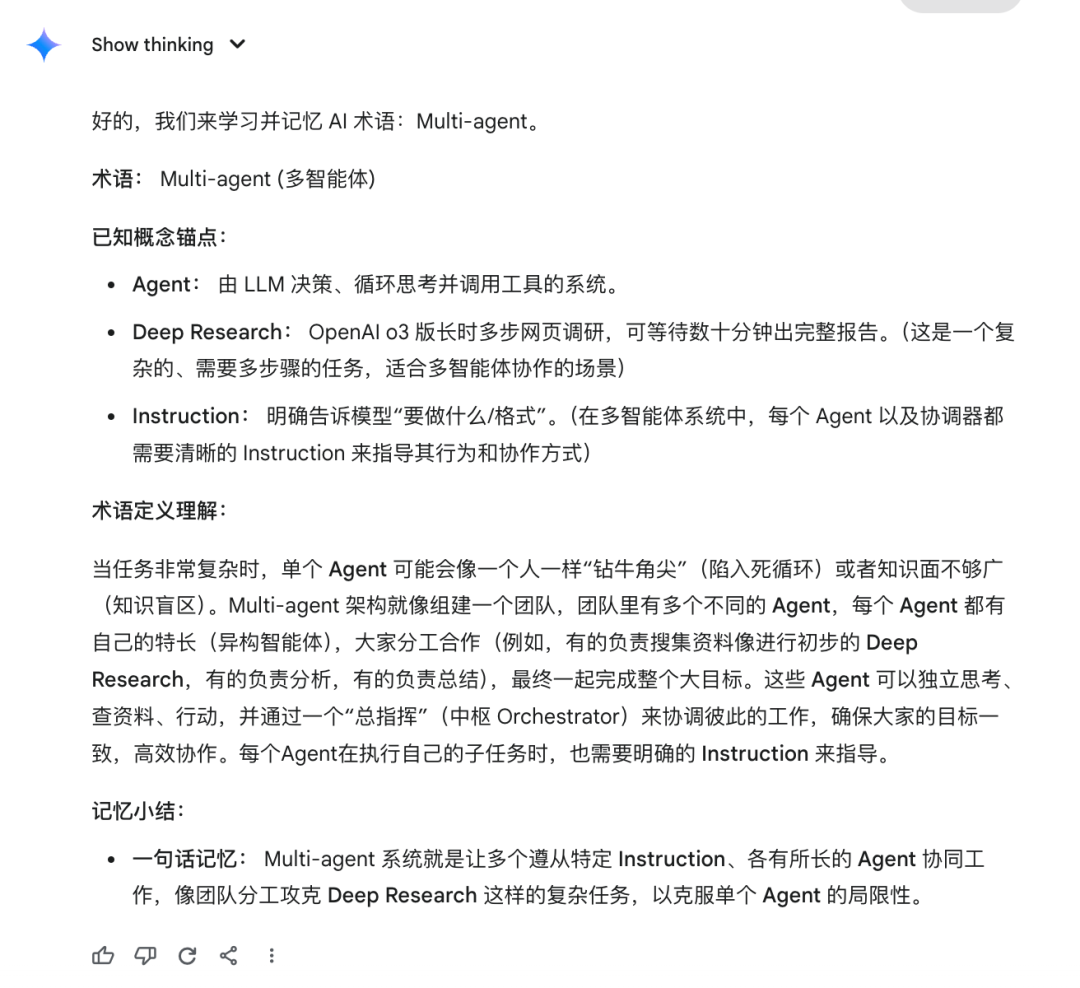

但我可能更喜欢 Gemini 2.5 pro 给我的解释,兼顾了通用类比和锚点类比,理解和记忆都兼顾到了。

现在,你又理解了multi-agent和记忆小结的意思,就可以把它们也追加到提示语里,帮你解释下一个新名词了。

这样每一轮的提问,不仅能理解新名词,还在不断巩固旧名词,这些名词就在脑子织成了密密麻麻的网,只要你不断用它,就不会忘记。

写在最后

其实一开始,

朋友问我“token、API、transformer 这些都是啥意思”的时候,

我耐心解释了以后,

他说“这些东西就像你们的行业黑话一样”。

我想,是啊,以前没有0基础用AI的时候,我们都是苦学了很多年才一点点记住这些东西,毕竟这些词就是我的饭碗,

但,现在时代不一样了,AI变得人人可用了,

那这些词,就不应该成为大家更进一步的阻碍。

所以,我把原来计划给大家罗列一大堆黑话解释的想法pass了,

变成了这个想让大家和自己记忆结合的理解办法,

毕竟,新的“黑话”会不断出现,

授人以鱼不如授人以渔。

而且这个方法,不只适用于AI名词,

任何需要记忆的知识都可以适用。

你用它来背单词也是可以的,

那样,abandon就不再只是单词表第一个单词,

而是,

Never abandon your quest for new knowledge.

@ 作者 / 卡尔 & 阿汤 @ 动手学AI知识库 / learnprompt.pro

(文:卡尔的AI沃茨)