如今的大模型(如DeepSeek-R1)在解数学题或逻辑推理时,明明答案对了,还要反复推演十几步,生成超长的思考链。这不仅浪费算力,用户看着也头疼。

论文:ConCISE: Confidence-guided Compression in Step-by-step Efficient Reasoning

链接:https://arxiv.org/pdf/2505.04881

现有方法要么“事后修剪”(可能破坏逻辑连贯性),要么靠随机采样选最短答案(效果不稳定),始终治标不治本。

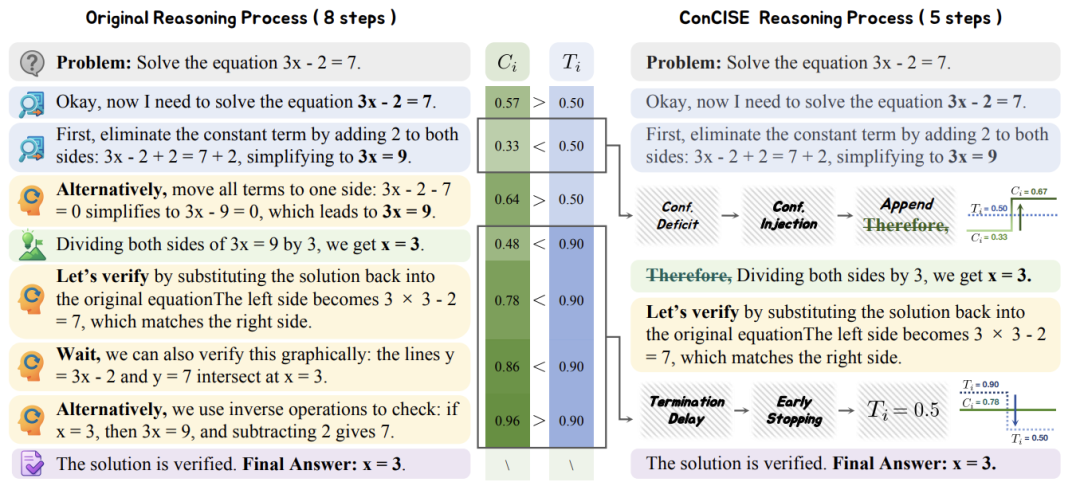

两大元凶:信心不足与拖延症

论文发现,模型“啰嗦”背后有两大心理问题:

-

信心不足(Confidence Deficit)

模型像“纠结症患者”,明明算对了,却因自我怀疑重新检查。比如解方程时,明明已得出x=3,还要反复验证:“等等,我是不是哪里漏了?” -

拖延停不下来(Termination Delay)

模型像“强迫症患者”,答案正确后还硬要加戏。比如已经写出最终答案:5,又补充:“或者换种方法再算一遍……”

ConCISE:两招终结冗余推理

清华团队提出的ConCISE框架,用两招根治上述问题:

第一招:信心注入(Confidence Injection)

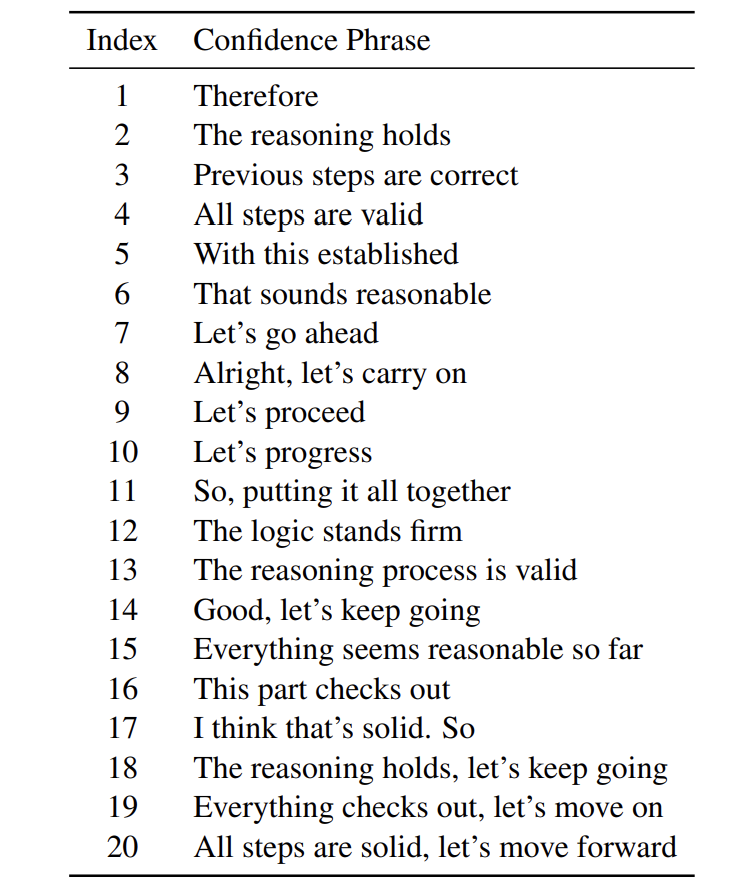

在模型犹豫时,插入信心提示语,比如:“之前的步骤没问题,继续!”相当于给AI“打鸡血”,阻止它无意义纠结。

第二招:早停机制(Early Stopping)

当模型生成答案后,用轻量级信心检测器实时监控:

-

若置信度超过阈值(如50%),立刻停止生成。 -

公式:如果检测置信度 ĉ_i > 0.5,停止!

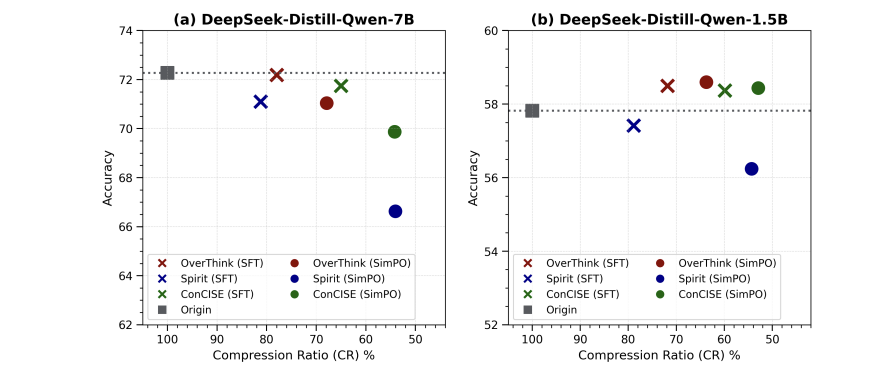

效果:砍掉一半步骤,准确率不降!

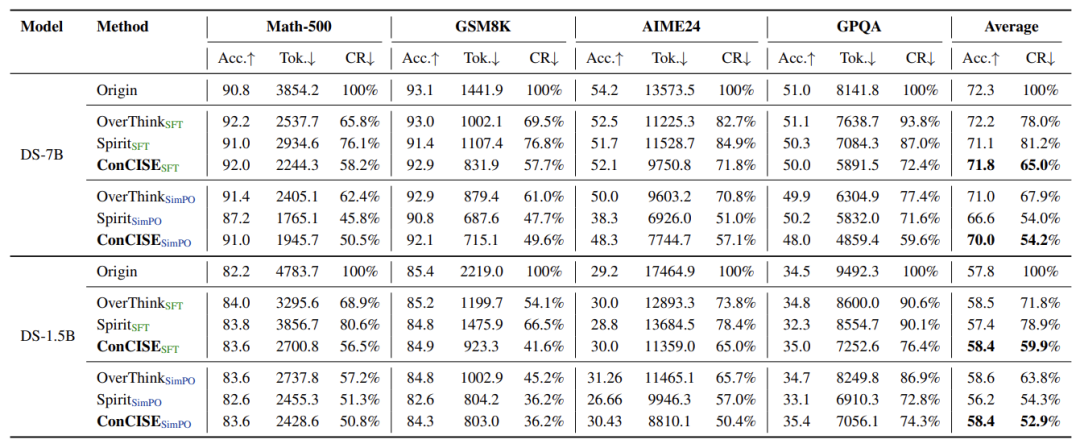

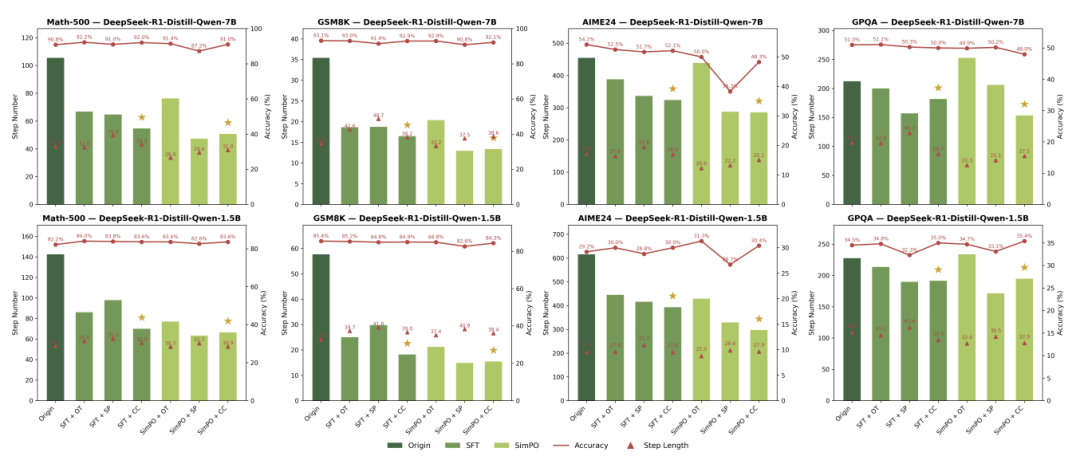

在GSM8K、数学竞赛题等四大基准测试中,ConCISE表现惊艳:

-

压缩率高达50% :推理链长度直接砍半 -

准确率基本不变:数学题正确率维持90%+

更厉害的是,ConCISE优化后的模型通用性极强,不仅能解数学题,连知识问答(GPQA)等陌生任务也表现稳定,彻底告别“过度思考”。

当然,研究还有改进空间,比如未压缩单一步骤内的冗余内容,但这一步已让模型推理效率迈入新阶段。

(文:机器学习算法与自然语言处理)