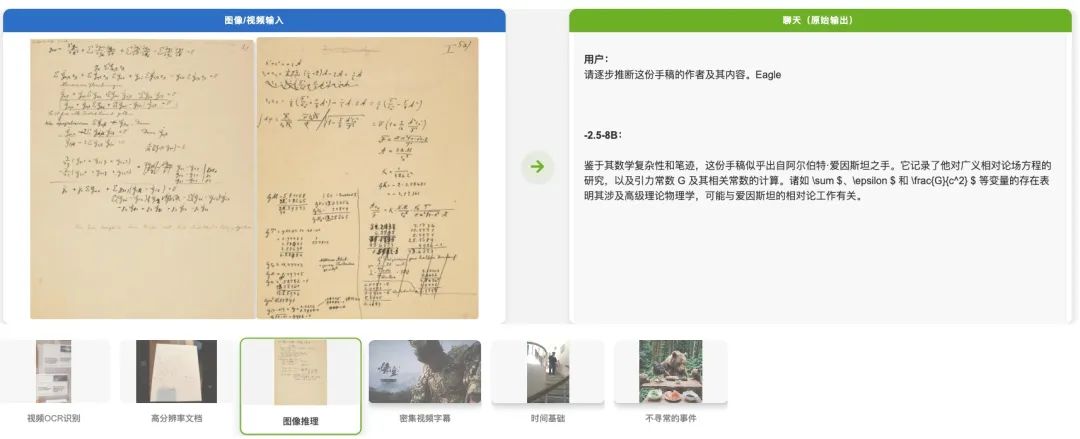

从测试结果来看,Eagle 2.5在长上下文多模态基准测试中展现了显著的性能,测试版本Eagle 2.5-8B在512个输入帧的Video-MME上实现了72.4%的成绩,与GPT-4o等顶级商业模型媲美,现已在开源社区上线。

3、多样性驱动的数据配方:将开源数据(人工注释和合成)与自行策划的Eagle-Video-110K数据集相结合,该数据集通过多样性驱动策略收集,使用故事级和剪辑级QA对进行注释。

在Video-MME 基准测试中,Eagle 2.5与领先的视觉语言模型GPT-4o、Qwen2.5-VL-72B和InternVL2.5-78B等进行了性能对比,结果显示,随着输入帧数的增加,Eagle 2.5展现出了持续的性能提升和竞争力水准,而且参数规模也小得多。

目前,业内开发者们在多模态学习领域已经取得了重大进展,但许多视觉语言模型(VLM)仍然专注于短上下文任务,对长上下文理解的探索还不够深入,对扩展视觉上下文的处理仍然是一个有待解决的挑战,这种扩展上下文涵盖了多幅图像、较长的视频序列、高分辨率媒体,或者是它们的组合。

虽然这些方法有效地避免了扩展视觉语言模型上下文长度的需求,但常常会增加额外的计算开销或能力限制,可能会制约模型的性能。

与那些仅仅为了处理长多模态序列而进行优化却未提升性能的模型不同,Eagle 2.5受益于更长的输入长度,除了能够处理更长的输入之外,还能带来持续的性能提升。

Eagle2.5-8B在多个视频基准测试中展现出卓越的性能,在MVBench上达到74.8分,在Perception_test上达到82.0分,在EgoSchema上达到72.2分,超越了InternVL2.5-8B(72.0)分和Qwen2.5-VL-8B(69.6分、70.5分、65.0分)等类似规模的模型。

此外,它在长视频理解方面尤其出色,在MLVU上达到77.6分,在 LongVideobench上达到66.4分,甚至超越了InternVL2.5-78B(75.7分、63.6分),在VideoMME(无字幕)测试中,Eagle 2.5达到了72.4分,非常接近72B参数规模的模型。

同时,Eagle2.5-8B也展现出全面的图像理解能力,涵盖文档理解(DocVQA 94.1,ChartQA 87.5)、信息提取(InfoVQA 80.4,TextVQA 83.7)和光学字符识别(OCRBench 869),该模型在一般感知和推理任务、领域特定知识、视觉幻觉评估以及数学推理方面也展现出均衡的能力。

研究人员表示,在整理训练数据集时采用了“先求多样,再求质量”的原则,数据集用了双重标注方法,包括:

1、自上而下的故事层面标注方法。这种方法利用人工标注的章节作为有意义的片段,而非传统的镜头层面分割方式。它会生成密集的字幕,这些字幕构成了全面的长篇问答对的基础,能够捕捉到整个视频的叙事结构;

2、自下而上的互补式片段层面标注方法。该方法使用GPT-4o针对短视频片段生成聚焦的问答对,且问题类型丰富多样。为了应对将局部片段标注扩展到完整长度视频标注的挑战,他们设置了锚点,这些锚点纳入了时间参考信息和上下文元素,同时不会透露答案,从而使模型既能理解视频的总体叙事内容,又能理解视频中精确的时空细节。

在模型架构方面,研究人员创建了一个功能多样的多模态系统,它能够高效地处理长上下文信息,而不是一个仅仅为处理扩展的多模态输入而专门优化的模型,为了确保该模型在各种不同任务中都具有适应性和泛化能力,他们特意避免加入那些可能会限制模型灵活性的定制压缩模块。

遵循LLaVA的架构,英伟达团队采用一个多层感知机(MLP)投影层,将来自SigLIP的视觉嵌入与大型语言模型(LLM)的表示空间对齐,为了有效地处理任意分辨率的图像,他们采用了图像分块策略,这一策略受到了业内模型LLaVA-1.5和InternVL的启发。

关于训练策略,包含两个实现有效长上下文训练的关键要素:其一,是一种信息优先的采样策略,它确立了最优的采样标准;其二,是基于这一策略制定的渐进式训练计划,该计划指导着整个模型的训练过程。

此外,还有一个全面的后训练框架,由两种互补的策略组成:

混合后训练:ADS方法自适应地将每个训练样本调整到最大序列长度,从而提供与帧无关的训练范式。研究人员实施了一种长度平衡打包的混合训练策略,以在整个上下文长度范围内均匀地优化性能。

(文:头部科技)