写论文是许多学生面临的共同难题,尤其是在文献的收集与高效利用上。

天下苦科研党久已!

而这时,SurveyGO 闪亮登场!

https://surveygo.thunlp.org/

有了 AI 后,科研党也终于迎来了属于自己的“提效神器”,来自清华的面壁智能团队的新作品 —— SurveyGO。

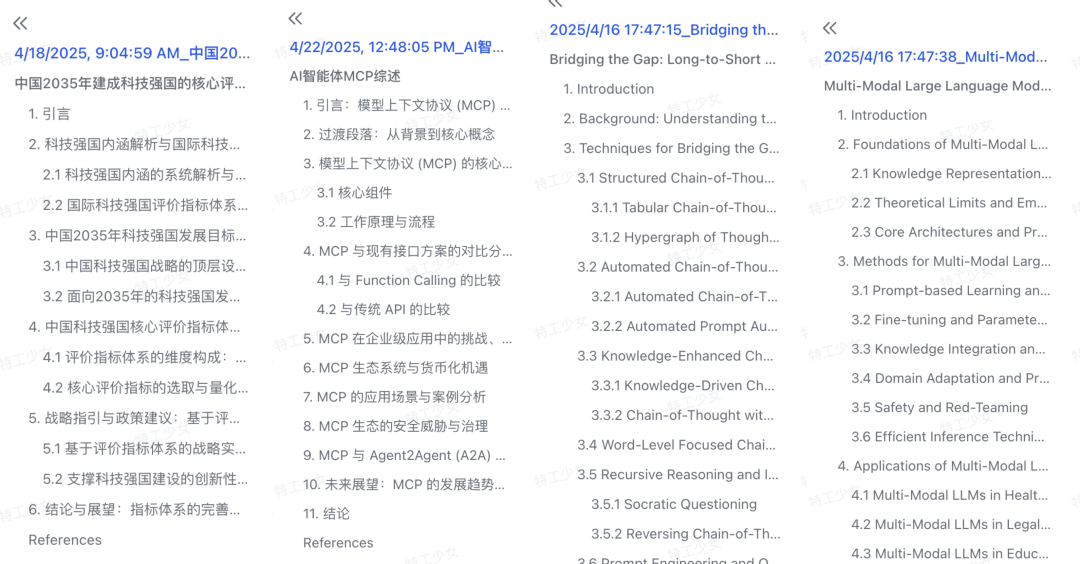

一方面,SurveyGO 光看题目框架,就能提炼其中的逻辑能力。

另一方面,SurveyGO 还能轻松直出数万字综述!

可以说要长度有长度,要高度有高度。

因为 SurveyGO 写论文非常的卷,其中又用到了卷积的技术,所以大家给她取了个外号——卷姬!

别看卷姬又粉又萌的,她使用了先进的 AI 技术辅助收集和利用文献资源,帮你提高科研论文产出效率。

SurveyGO 产品也非常简洁易用,点击「开始综述」按钮后出现一个面板,按照需求有普通模式和专业模式可选,用户可以填写论文标题、描述,选择中英文语言;再点击「SurveyGO」按钮即可成功提交选题。

逻辑清晰,内容专业的优质文章

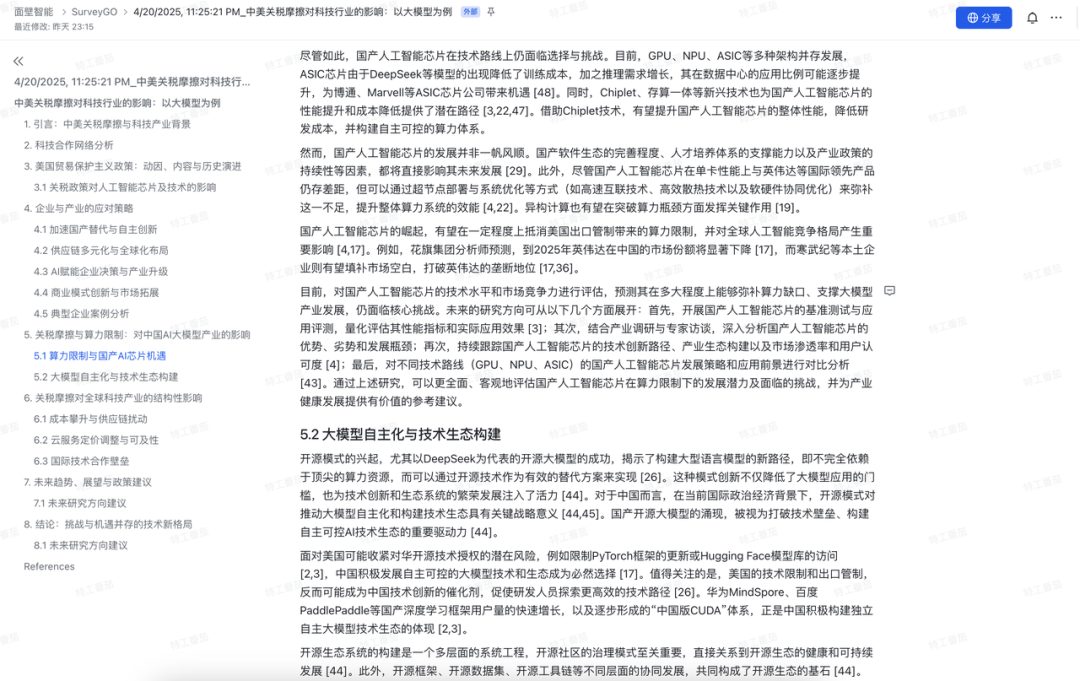

结合最近的国际时事热点,特工用「中美关税摩擦对科技行业的影响:以大模型为例」这个选题,试一试 SurveyGO 的研究能力如何。

在上一步提交完选题之后,用户就不需要任何操作了,产品也没有其他界面或流程的展现,用户可以去做其他自己的事情。

等文章生成完成后,用户进入网站,就可以在「公开文章」列表看见自己提交的选题,点击文章标题后,会跳转打开一份飞书文档。

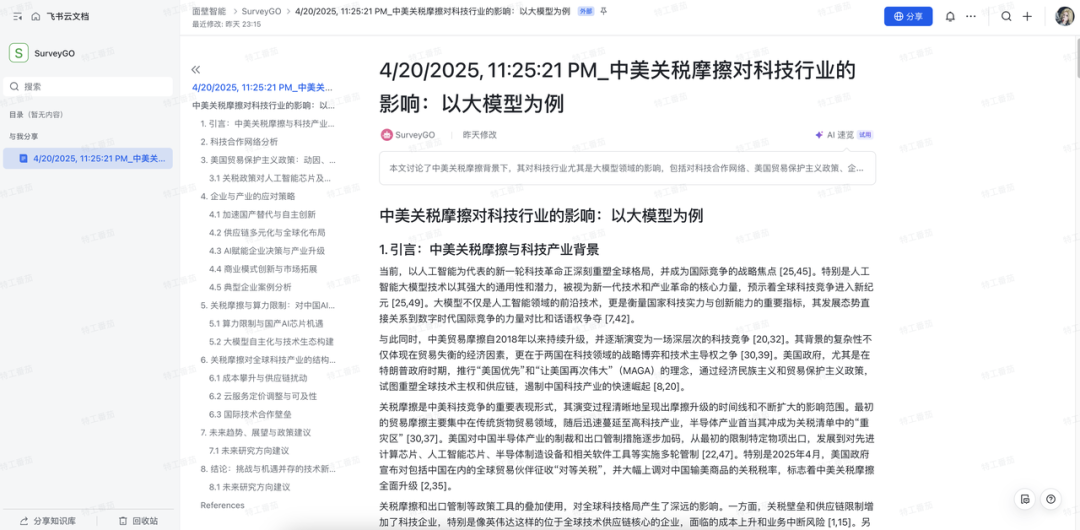

特工看见这篇产出的文章,总体觉得是满意符合预期的,文章的结构合理、逻辑清晰,内容丰富、翔实、专业。

首先看问题的理解切入和文章的整体逻辑。SurveyGO 根据短短一句概括的题目,就能自动拆解为科技合作网络、美国贸易保护主义政策、企业与产业应对策略等方面,并对未来趋势进行了展望,提出了研究方向和政策建议。

可以看出,SurveyGO 做研究时,从整体现象到具体组成部分,从问题到原因到解决方法,从宏观产业到微观企业,智商在线、思路清晰。

然后看内容的相关度、准确度、专业性。

SurveyGO 产出的文章都有可信的引用资料,包括文内引用和文末列表,以联网搜索的公开网页为主,不乏知乎、36氪、高校论坛等优质信息源,资料的相关性、时效性都比较高;而在“关税摩擦与算力限制”部分,文章对国内外算力、芯片、大模型技术生态,都有比较正确的事实分析;在研究建议与论文部分,观点与前文内容呼应,见解具有专业度。

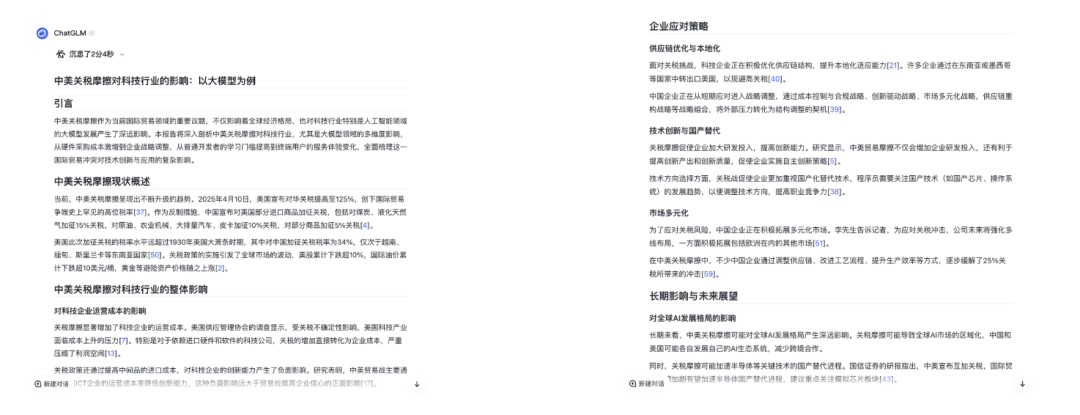

与国内的 DeepResearch 同类产品 ChatGLM 沉思模式的产出结果对比来看,SurveyGO 和 ChatGLM 沉思模式都可以做到敏锐抓住问题重点,逻辑结构清晰地拆解每个子部分研究,相关度、准确度、专业性都比较满意。

但是 SurveyGO 产出的文章有长达 2.5 万字,长度上 ChatGLM 显得过于精炼了,一些综述和论证细节展现较少。

自研 LLMxMapReduce-V2 技术

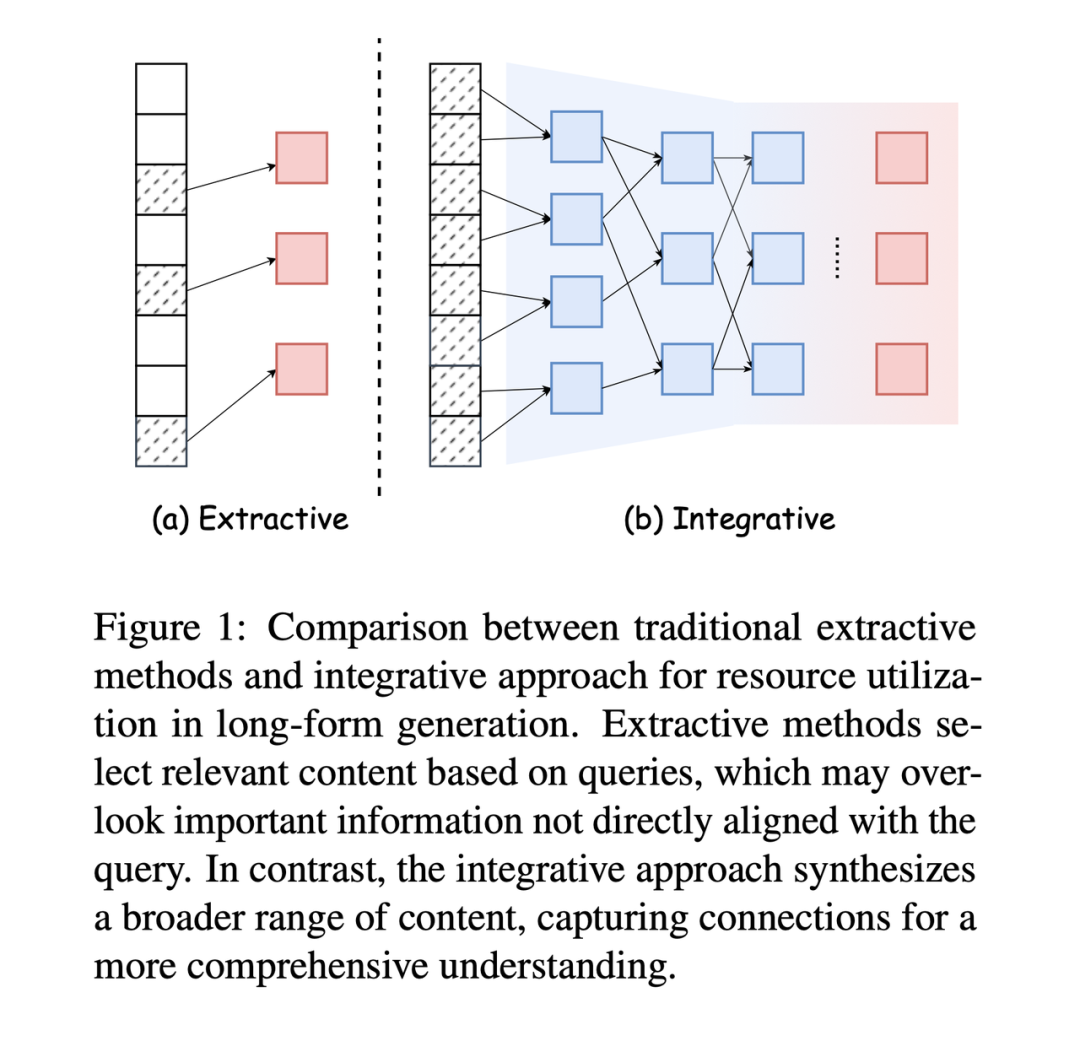

在 GenAI 时代下,为了解决科研领域的资源收集和利用难题,需要解决收集的资源超出⼤语⾔模型有效上下⽂⻓度的问题。目前业内的多数现有⽅法是采⽤提取技术对资源进⾏压缩。

常⻅的做法是使⽤ RAG,依据查询信息检索相关性最高的⽂本切片。但 RAG 的提取式⽅法容易忽略部分虽然实际与主题相关,但⽆法直接与给定查询匹配语义相似度的重要内容,例如关键分析、独特⻅解、⼴泛的上下⽂信息等,这会影响最终⽣成⽂章的质量。

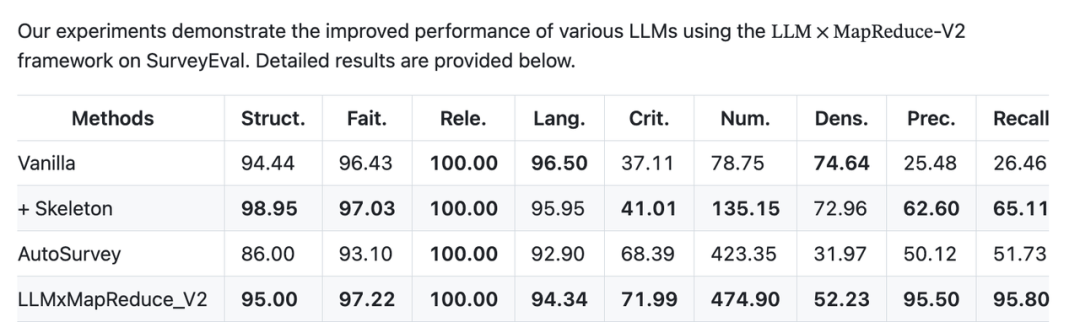

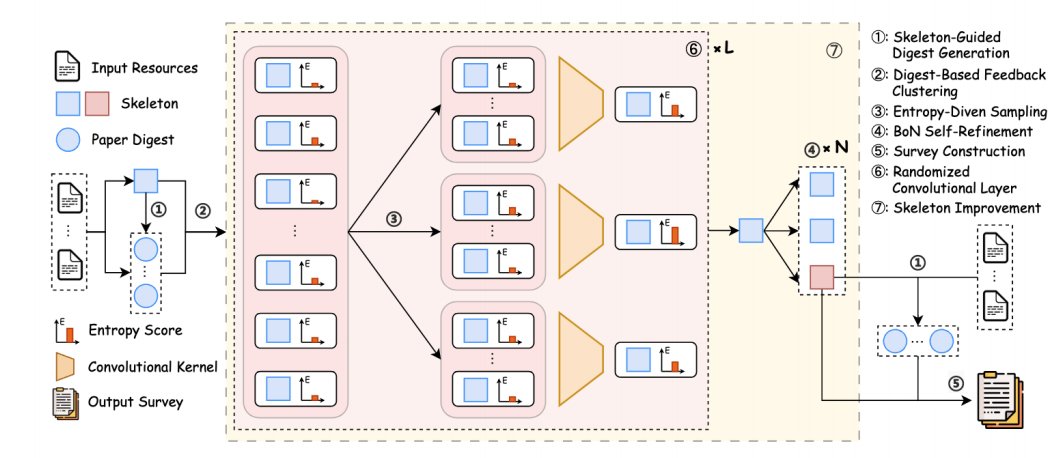

因此,面壁智能团队自研了 LLMxMapReduce-V2 技术,核⼼在于借助⽂本卷积算法实现多篇参考⽂献的聚合,代替现有⽅法中常⻅的检索,从⽽实现对全部参考⽂章的充分利⽤。

在综述⽣成任务上进⾏测试,效果显著超越 AutoSurvey 等现有基于检索的⽣成⽅案。

LLMxMapReduce-V2 ⽅法借鉴了经典卷积神经⽹络的原理,CNN常用于图像理解,在特征提取上特别有效。CNN 能够逐步将局部特征抽象为⾼级全局表示,在处理长文本时,模型首先会关注部分引用文章(局部信息),然后通过多层卷积操作,逐渐将这些局部信息整合成更全面的结构化信息(比如文章的段落结构、主题等)。这样,模型就能更好地把握文章的整体逻辑和内容。

同时,团队研究⼈员引⼊信息熵估计模块,⽤于指导卷积过程,从⽽确保测试时缩放过程能够不断提升结果的信息含量。

此外,为了科学评估所提出的整合式框架相较于传统提取式⽅法的优势,研究团队还开发了⾼质量的调查写作基准。

SurveyEval:https://huggingface.co/datasets/R0k1e/SurveyEval

这是计算机科学领域⾸个将调查与完整参考⽂献相结合的可扩展评估基准。

有需要的小伙伴可以赶紧开始用起来产品,或者去 Github 上研究和 Star 项目啦~~

主页:https://surveygo.thunlp.org/

论文:https://arxiv.org/abs/2504.05732

GitHub:https://github.com/thunlp/LLMxMapReduce/tree/main

(文:特工宇宙)