本文为大家介绍上海科技大学 YesAI Lab 在 CVPR 2025 上入选 Highlight 的工作。本研究针对视觉语言模型提示学习中的带噪标签问题,提出了一种新的鲁棒提示学习方法 NLPrompt。

该研究发现在提示学习场景中使用平均绝对误差(MAE)损失能显著提高模型在噪声数据集上的鲁棒性。利用特征学习理论,本文从理论上证明了 PromptMAE 策略能够有效减少噪声样本的影响,增强模型的鲁棒性。

此外,该研究还提出了基于提示的最优传输数据净化方法 PromptOT,通过优化传输矩阵,精确地将数据集划分为干净和带噪的子集。

NLPrompt 使用 PromptMAE 和 PromptOT 来处理噪声标签,融合了 CE 损失和 MAE 损失的优势。NLPrompt 充分利用了视觉语言基础模型的丰富表达能力和精准对齐能力,为存在噪声标签的鲁棒提示学习提供了一种简单有效的解决方案。

上海科技大学信息学院 2023 级博士生潘比康和 2024 级硕士生李群为论文共同第一作者,石野教授为通讯作者。

论文标题:

NLPrompt: Noise-Label Prompt Learning for Vision-Language Models

论文链接:

https://arxiv.org/abs/2412.01256

代码链接:

https://github.com/qunovo/NLPrompt

研究背景

视觉语言基础模型的出现,如CLIP,彻底改变了图像及其文本描述的表示方式,使得两种模态在同一潜在空间内实现精准对齐。

由于手工提示的敏感性,提示学习已成为微调视觉语言模型的关键方法。提示学习通过反向传播更新可学习的文本提示,由于涉及的参数数量相对较少,通常只有几千个,因此提供了一种轻量级的解决方案,使模型能够迅速适配特定任务。

然而,在实际应用中,数据集的标签并非准确无误的。标签错误是常见的问题。在大规模数据采集过程中,由于人工标注的失误、自动标注工具的不准确、或者数据本身的模糊性,都会导致部分标签错误。例如,一张“猫”的图像被标注为”狗“。而错误的标签会严重干扰模型的性能。

先前的研究表明提示学习对带噪的标签具有一定的弹性。尽管如此,在噪声条件下采用交叉熵(CE)损失训练时,模型仍容易过拟合错误标签,从而影响模型最终的预测效果。因此,增强噪声环境中提示学习的鲁棒性仍然是一个关键问题。

研究方法

本文提出的 NLPrompt 主要由两大模块构成——PromptMAE 和 PromptOT。

PromptMAE:鲁棒损失的创新应用与理论分析

在噪声标签学习领域,平均绝对误差(MAE)已被确定为传统训练范式中的一种鲁棒损失函数。然而,MAE 在训练过程中往往存在收敛速度慢和性能差的问题,这使得它很少被用作噪声标签学习中的分类损失。

然而,我们的研究发现了一个有趣的现象:在提示学习中,相比于传统的交叉熵(CE)损失,采用 MAE 损失(PromptMAE)能显著提高模型的鲁棒性,保证模型在高噪声环境下依然保持较高的准确率。

如图 1 所示,我们在不同的噪声水平下比较了 CE 损失和 MAE 损失对 CoOp 方法性能的影响。

实验结果表明,随着数据集噪声水平的增加,使用CE损失的模型性能显著下降,而MAE损失在噪声数据集上更具鲁棒性。即使在大量噪声存在的情况下,MAE 损失也能保持出色的准确性和较快的收敛性。

为了深入理解 PromptMAE 的鲁棒性,我们引入了特征学习理论,该理论将潜在特征分为任务相关和任务无关两部分。通过对基于梯度下降训练过程中这两类特征的动态优化进行分析,我们可以获得关于模型收敛和泛化的重要见解。

结果表明,当任务相关特征占主导地位时,可以实现鲁棒的提示学习。我们的分析表明,PromptMAE可以有效抑制噪声样本的影响,从而增强视觉语言模型提示学习的鲁棒性。

PromptOT:基于最优传输的数据净化

在噪声标签学习领域,一种常见的策略是利用样本选择技术对数据集进行清洗,以提升模型在噪声条件下的表现。例如,传统的基于最优传输(OT)的样本选择方法利用随机初始化的原型来计算从图像特征到这些原型的最优传输矩阵,将特征和原型之间的相似性作为成本矩阵。

然而,由于这些方法最初并非为提示学习而设计的,因此它们的直接适用性可能会受到限制。为此,我们的目标是充分利用视觉语言基础模型中的丰富表达能力和精确对齐特性,从而改进数据净化过程。

本文提出了一种基于提示的最优传输数据净化方法 PromptOT,PromptOT 利用文本特征作为传输矩阵的原型,旨在增强视觉语言基础模型中提示学习的鲁棒性。NLPrompt 算法通过 PromptOT 将带噪数据集划分为“干净”和“带噪”的子集来促进稳健的提示学习。

考虑到交叉熵(CE)损失在干净数据集上通常优于 MAE,我们应用 CE 损失来训练干净子集以保证高精度,应用 MAE 损失来训练带噪子集以增强鲁棒性。

这种双重策略在 PromptOT 的支持下,有效融合了 CE 损失和 MAE 损失的优势,在不同的噪声条件下协调了 CE 和 MAE 损失的强度,从而提升了模型的整体性能。

传统的基于 OT 的伪标签方法从随机初始化原型开始,然后根据图像和这些原型之间的相似性推导出伪标签。然而,在视觉语言模型的提示学习中,潜在空间是对齐的,PromptOT 利用提示输入文本编码器生成的文本特征替换随机初始化的原型。这些文本特征中嵌入的丰富语义信息为原型初始化提供了坚实的基础。

具体来说,OT 问题涉及基于给定的成本矩阵求解传输矩阵,同时保持边缘分布不变。计算原型和图像特征之间的相似性,并将得到的相似性矩阵的负对数用作成本矩阵。由于边缘分布约束,OT 矩阵的每一列被归一化后得到图像的伪标签。

NLPrompt 中的具体计算过程为:

对于图像数量为 的数据集,我们首先使用 CLIP 的预训练图像编码器来生成图像特征矩阵 ,其中 表示潜在空间的维度。

此外,给定数据集的类别集合,我们生成与这些类别相对应的提示,并将提示传递给 CLIP 的预训练文本编码器,以创建文本特征矩阵 ,其中 是类别的数量。

接下来,我们计算相似度矩阵 。将该相似性矩阵的负对数用作 OT 问题中的成本矩阵,样本和类别均为均匀的边缘分布。要解决的 OT 问题如下:

其中 表示一个维度为 的全为 1 的向量。根据该公式利用 Sinkhorn 算法求解出最优传输矩阵 ,然后我们对 的每一列采用 Argmax 运算以找到最大值求解出伪标签:

利用 PromptOT 生成的伪标签 和数据集的带噪标签 将数据集净化为两个子集:干净数据集 和有噪声数据集 ,定义如下:

在数据划分后,NLPrompt 分别对两个子集采用不同的损失函数进行训练,对干净子集采用 CE 损失以实现高性能,对噪声子集采用 MAE 损失以增强鲁棒性,以综合利用 CE 损失 MAE 损失的优势。NLPrompt 的综合损失为:

其中 表示目标标签, 表示第 个样本的输出相似度。

NLPrompt 利用 OT 巧妙地协调了 CE 和 MAE 损失的优势,同时充分利用了视觉语言基础模型在提示学习方面的潜力。首先,我们利用提示学习的文本表示作为强大的初始原型,从而保持全局标签的一致性,区别于其它基于预测的方法。

此外,NLPrompt 通过对数据集进行净化,使得在对噪声样本训练时能够充分利用 MAE 的鲁棒性,而不是对所有样本统一采用相同的损失函数。这种灵活的策略不仅大大增强了模型在噪声环境下的鲁棒性,也使得我们能够更好地整合 CE 和 MAE 的优势,从而整体提升模型性能。

实验结果

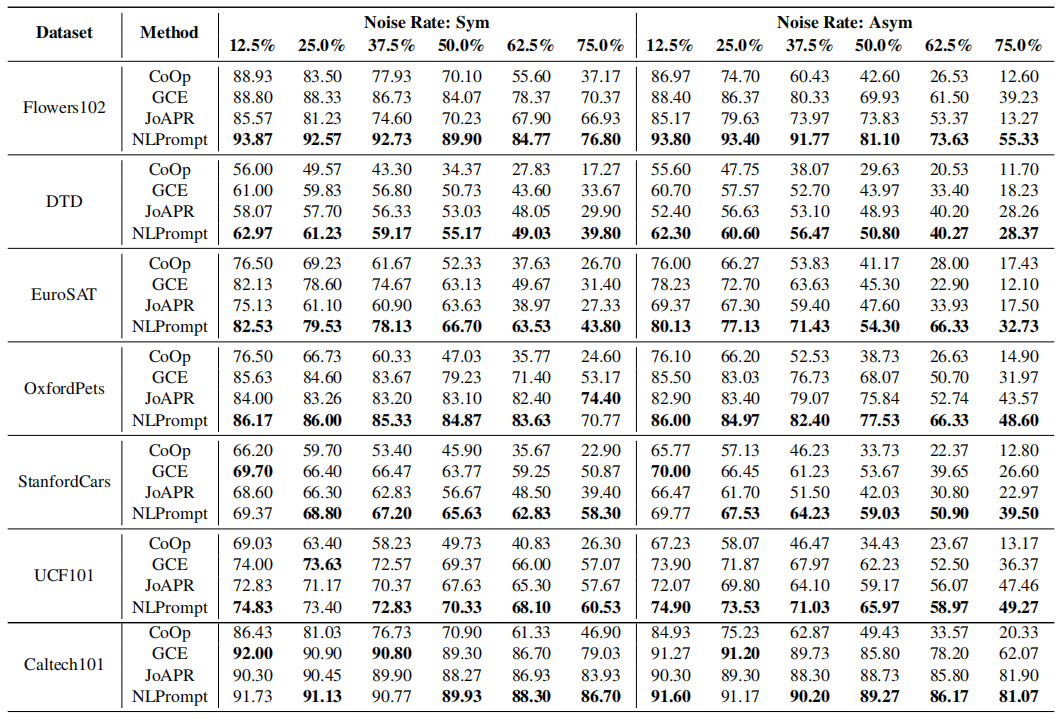

对于合成的带噪数据集,在不同的噪声强度下,图像分类任务的准确率如下表所示,验证了 NLPrompt 在处理提示学习中的噪声标签问题上具有有效性和优越性。

在真实世界的带噪数据集 Food101N 上的结果如下表所示,NLPrompt 优于所有的基准方法。

NLPrompt 的泛化性

NLPrompt 不仅对 CoOp 有效,还可以扩展到其它提示调优方法上,如 VPT,MaPLe,PromptSRC,这些方法都是 CoOp 的后续方法。在 EuroSAT 数据集上的实验结果如下表所示,NLPrompt 显著提升了各种提示学习方法在面对噪声标签问题时的鲁棒性,验证了 NLPrompt 具有强大的泛化能力。

消融实验

为了评估 NLPrompt 各个组成部分的有效性,我们在 Flowers102 数据集上进行了消融实验。为了验证 OT 的有效性,我们设计了两组实验:一组不使用 OT 进行数据净化,另一组使用 OT 进行数据净化。具体的实验设计如下:

(a)对所有数据采用交叉熵损失;

(b)对所有数据采用平均绝对误差损失;

(c)使用随机初始化的原型代替 CLIP 文本特征作为初始化原型;

(d)去除噪声数据,仅对干净数据采用交叉熵损失;

(e)去除干净数据,仅对噪声数据采用平均绝对误差损失。

实验结果如下表所示,其中平均结果表明(b)优于(a),验证了我们的 PromptMAE 的有效性。此外,平均结果表明(d)优于(a),(e)优于(b),进一步验证了 PromptOT 在数据净化过程中的有效性。

此外,(c)和 NLPrompt 之间的比较突出了文本特征初始化在我们的方法中的重要性。在所有方法中,NLPrompt 实现了最佳性能,与其他基线方法相比有了显著改进,进一步验证了 NLPrompt 各个组成部分的有效性。

结论

在这项研究中,我们通过引入 PromptMAE 和 PromptOT,有效解决了视觉语言基础模型提示学习中噪声标签这一关键挑战。

尽管在传统的噪声标签场景中采用 MAE 损失较为少见,但我们的研究发现,将 MAE 损失应用于提示学习,能够显著增强模型的鲁棒性并保持高精度。通过特征学习理论,我们阐明了MAE损失如何有效抑制噪声样本的影响,从而提升整体鲁棒性。

此外,本文引入了基于提示的 OT 数据净化方法 PromptOT,能够将带噪数据集准确地划分为干净数据和噪声数据子集。在 NLPrompt 中,我们对干净数据采用交叉熵损失,对噪声数据采用 MAE 损失,这种差异化的策略展示了一种简单且强大的鲁棒提示学习方法。

在各种噪声场景下进行的大量实验证实了该方法在性能上的显著提升。NLPrompt 充分利用了视觉语言模型的丰富表达能力和精准对齐能力,为提升现实场景中提示学习的鲁棒性提供了一个前景广阔的解决方案。

(文:PaperWeekly)