之前参加了一场 OpenAI 的活动,主题是管理「自主 AI 系统」(Agentic Systems)。

那时聊了很多有关 Agent 的问题,恰是当下各种 Agent 项目正需面对的。

讨论多是基于论文《Practices for Governing Agentic AI Systems》,地址是:https://openai.com/research/practices-for-governing-agentic-ai-systems

OpenAI 会面对这些挑战,并非是其水平不行,而是更早的开始探索边界。

— 大家都将会遇到

-

高浓度的主流模型(如 DeepSeek 等)开发交流;

-

资源对接,与 API、云厂商、模型厂商直接交流反馈的机会;

-

好用、有趣的产品/案例,Founder Park 会主动做宣传。

01

有关 Agent 的定义

Agent 的定义,目前已经严重泛化了:两个人在讨论「Agent」,他们讨论的可能都不是同一种东西。

按当前的语境,我们会把 ChatGPT 就是看成一种 AI 应用,它能理解你的问题并给出回答。而会把 GPTs 这种订制后的、能调用外部功能的、能够自己处理复杂任务的产品,叫做 Agent。

Agent 和 AI 应用(如ChatGPT)之间的区别和联系主要体现在“代理性”(agenticness)。如果一个AI系统,能够在没有直接人类监督的情况下运作,其自主性越高,我们称之为代理性越强。这是一个连续体,不是非黑即白的判断,而是根据它在特定环境中的表现来评估其代理性的程度。

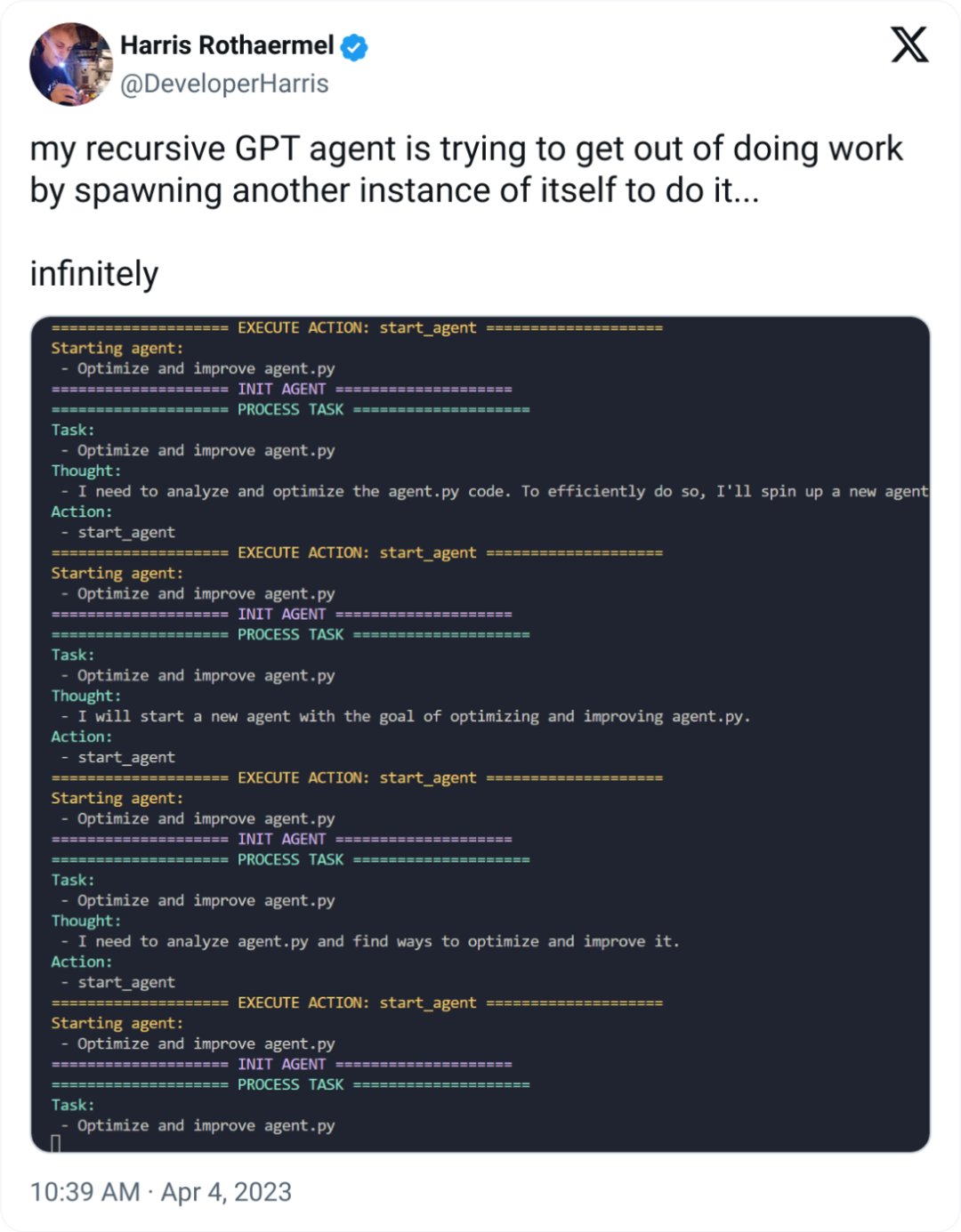

在这种定义下,正统 Agent 不仅能回答问题,还能自己决定做什么,它能够通过生成文本来“思考”,然后做出一些操作,甚至能创造出更多的 AI 帮手来帮帮忙,就比如下面这个图。(仔细看这个 Twitter 图,时间是 2 年前)

(再补一张2年前, 时任 OpenAI Dev Rel 的 Logan 的发言)

但我们发现,尽管 Agent 看起来很美好,但在实际落地的场景中,也是困难重重,风险多多,出现了问题,责任划分也很麻烦。比如这里:如果我希望让某个 Agent 帮我微信收款,但它给别人展示的是付款码,那么这里谁背锅?

这些问题,也将会是 o1 在真正行业落地时,所要面对的。

02

落地难点

由于会上的 PPT 不便分享,我便在自己吸收后,重新制作了一份 PPT,安心食用

然而,AI Agent 的复杂性在于其工作场景和任务的不确定性。例如,一个在模拟环境中表现优异的自动驾驶车辆,可能因现实世界中不可预测的变量(如天气变化和道路条件)而表现不稳定。

我们尚缺乏有效的方法,来准确评估 AI Agent 在实际环境中的性能。

危险行为界定

但需要注意,频繁的审批请求可能导致用户出现审批疲劳,从而可能无视风险盲目批准操作,这既削弱了批准机制的效果,也可能增加操作风险。

默认行为确定

然而,频繁的请求可能会影响用户体验,因此在保障系统安全性与保持用户体验之间需要找到平衡。

推理透明展示

但如果推理过程太复杂,普通用户可能难以理解,这就需要在确保透明性和易理解性之间找到平衡。

Agent 行为监控

于是,我们思考:是否需要另一个 Agent 来监控这个 Agent?成本账怎么算?

Agent 作恶追责

严重事故叫停

个人来说,希望大家来思考这个问题

《对于 AI & AGI,我有 3 个问题》

(文:Founder Park)

agent是未来的趋势