论文标题:

RPN 2: On Interdependence Function Learning Towards Unifying and Advancing CNN, RNN, GNN, and Transformer

https://arxiv.org/abs/2411.11162

https://www.tinybig.org/

https://github.com/jwzhanggy/tinyBIG

https://pypi.org/project/tinybig/

背景介绍

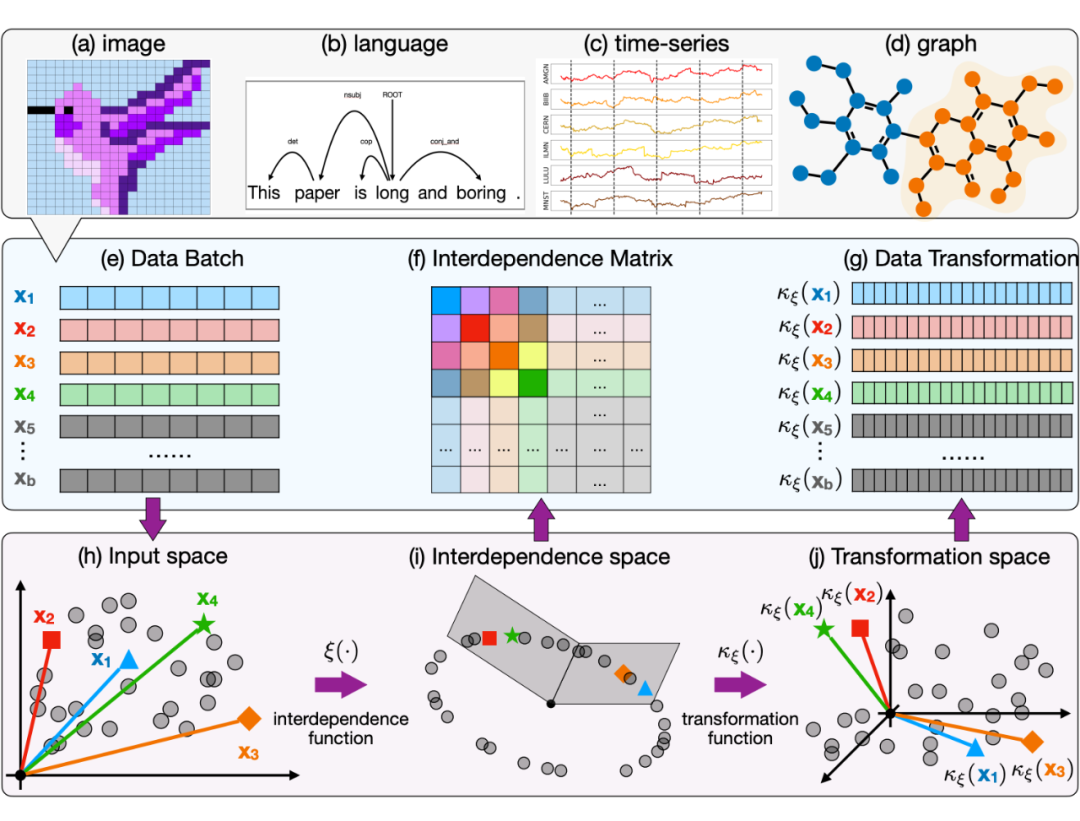

本文是基于我们之前的 RPN(Reconciled Polynomial Network)研究的后续工作。在此前的研究中,我们提出了 RPN 这一通用模型架构,其包含三个组件函数:数据扩展函数、参数调和函数和剩余函数。

我们先前的研究表明,RPN 在构建不同复杂性、容量和完整性水平的模型方面具有很强的通用性,同时可以作为统一多种基础模型(包括 PGM、核 SVM、MLP 和 KAN)的框架。

然而,先前的 RPN 模型基于以下假设:训练批次中的数据实例是独立同分布的。此外,在每个数据实例内部,RPN 还假定所涉及的数据特征彼此独立,并在扩展函数中分别处理这些数据特征。

不过,现实数据往往存在比较强的相互依赖关系,这种依赖关系既存在于样本之间,也存在样本内部各个数据特征之间。

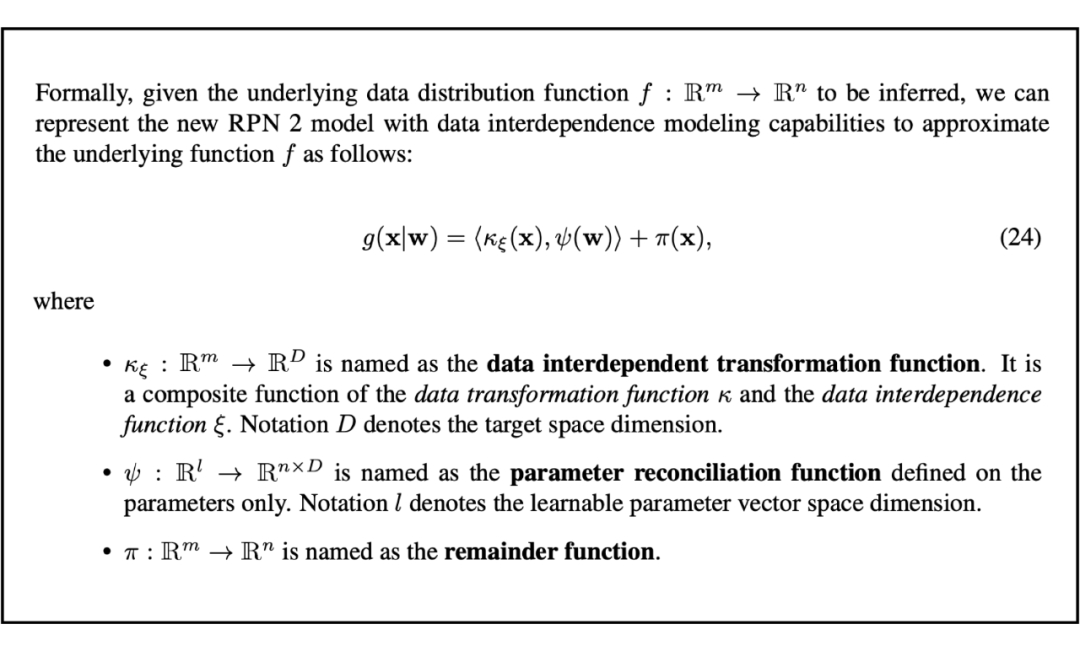

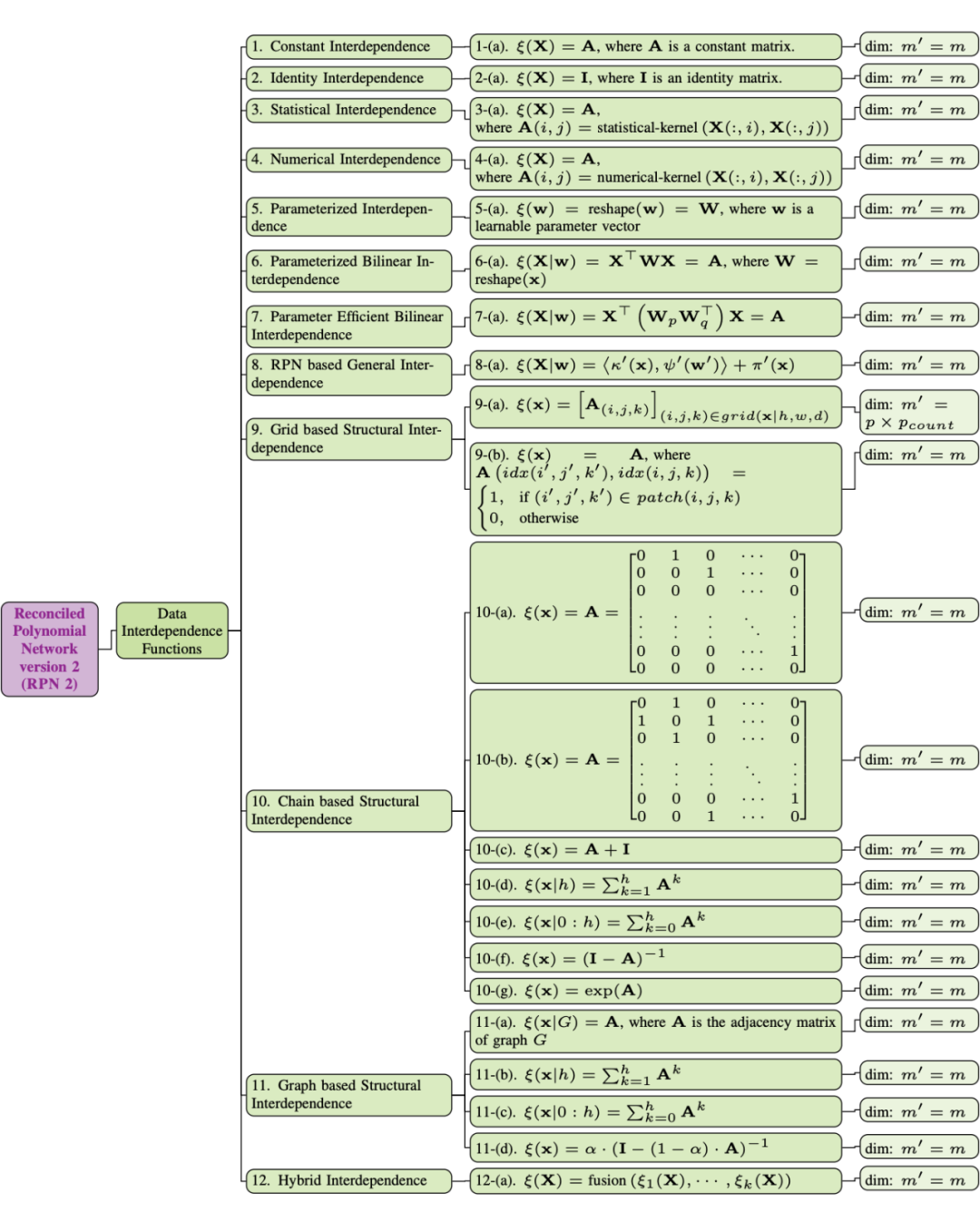

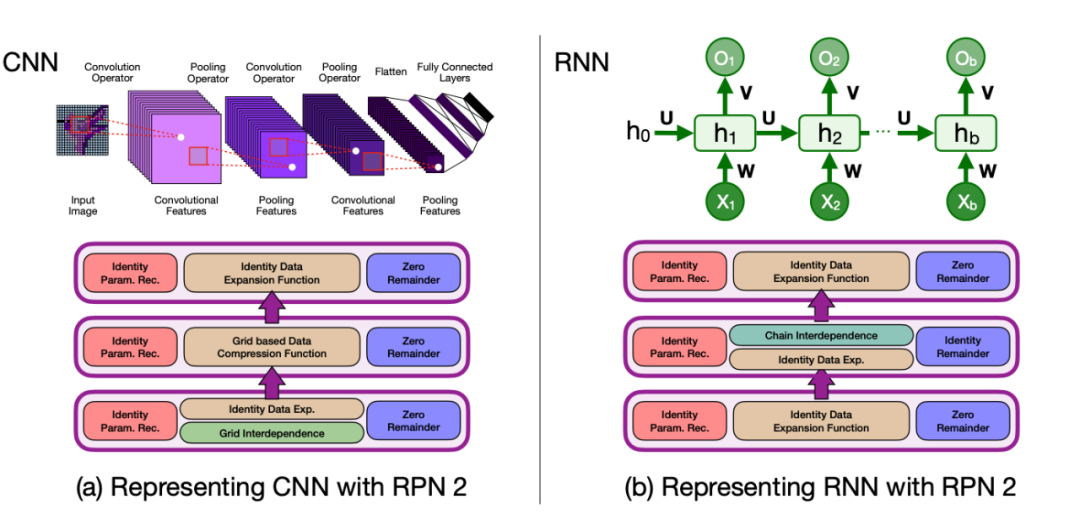

为了解决上面提到的问题,在本文中,我们重新设计了 RPN 架构,提出了新的 RPN 2(即 Reconciled Polynomial Network 2.0)模型。如上图中所示,RPN 2 引入了一个全新的组件——数据依赖函数,用于显式建模数据实例和数据特征之间的多种依赖关系。

这里需要解释一下,虽然我们在本文中将该组件称为“依赖函数(interdependence function)”,但实际上,该函数捕获了输入数据中的多种关系,包括结构性依赖、逻辑因果关系、统计相关性以及数值相似性或差异性等。

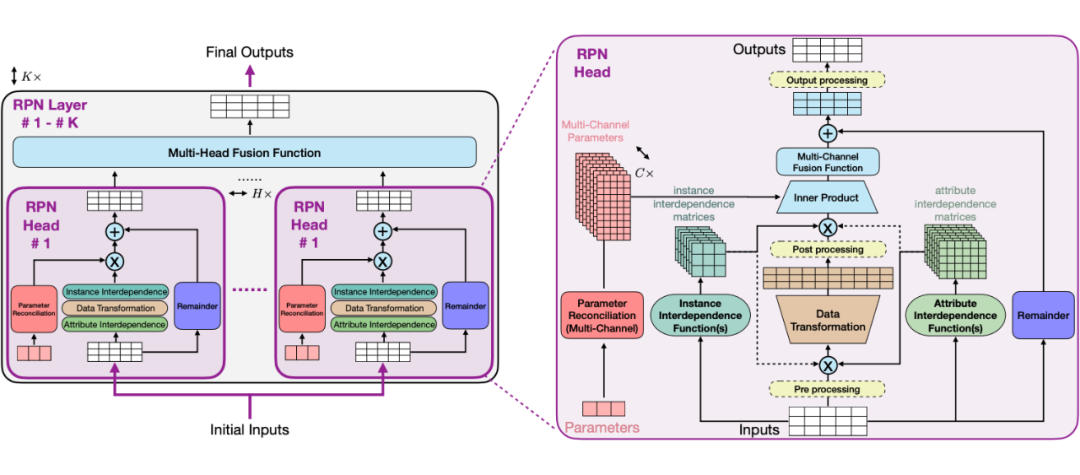

RPN 2 深度和广度的模型结构

RPN 2 提供了灵活的模型设计和结构,并且允许用户搭建不同深度和广度的模型结构。

上图展示了 RPN 2 的多层(K层)架构,每一层包含多个头部(multi-head)用于函数学习,这些头部的输出将被融合在一起。右侧子图展示了 RPN 2 头部的详细架构,包括数据变换函数、多通道参数调和函数、余项函数及其内部操作。

-

grid:图像和点云表示为网格结构数据,其中节点表示像素和体素,连边表示空间位置关系; -

chain:语言和时间序列数据表示为链式结构数据,其中节点表示词元和数值,连边表示顺序关系; -

graph:分子化合物和在线社交网络表示为图结构数据,其中节点表示原子和用户,连边表示化学键和社交连接。

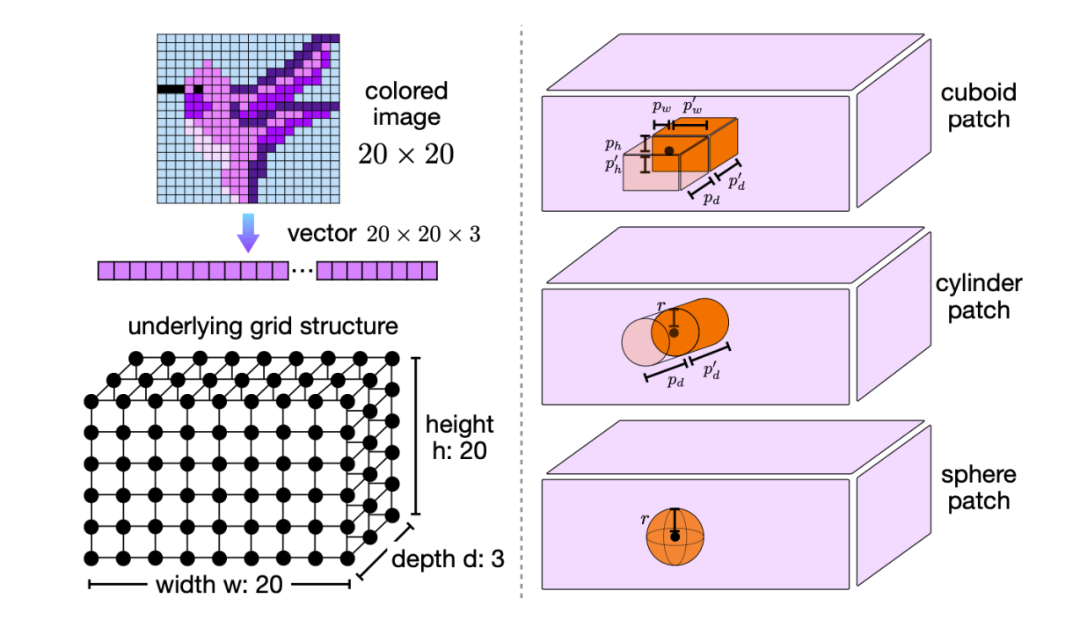

4.1 图像和点云数据几何依赖函数

对于图像和点云,每个 pixel (或者 voxel)之间的依赖关系往往存在于图像和点云数据的局部。换而言之,我们可以从输入的图像和点云数据中划分出局部的 patch 结构,用来描述 pixel 和 voxel 之间的依赖范围。

在传统模型中,这种 patch 的形状往往需要认为定义,其形状可以是 cuboid shape, cylinder shape,sphere shape。而从 grid 中定义 pixel (或者 voxel)依赖范围的过程可以表示为 patch packing 这一经典几何学问题。

除了基于 grid 的几何依赖函数之外,本文还介绍了基于 chain 和 graph 的拓扑依赖函数。链式结构依赖函数和多跳链式依赖函数主要用于建模数据中的顺序依赖关系,这种关系广泛存在于自然语言、基因序列、音频记录和股票价格等数据中。

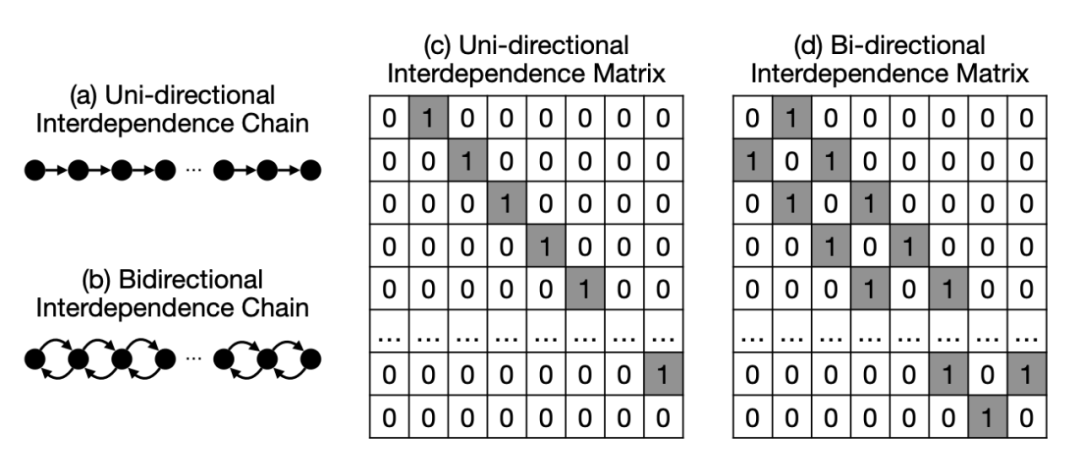

基于序列数据,本文定义了多种基于 chain 结构的拓扑 single-hop 和 multi-hop 的依赖函数。其中 single-hop chain 结构的拓扑依赖函数分为单向和双向两种。如下图所示,单向依赖强调元素仅依赖于前一个,而双向依赖则考虑元素同时依赖于前后邻居,从而捕捉更全面的上下文信息。

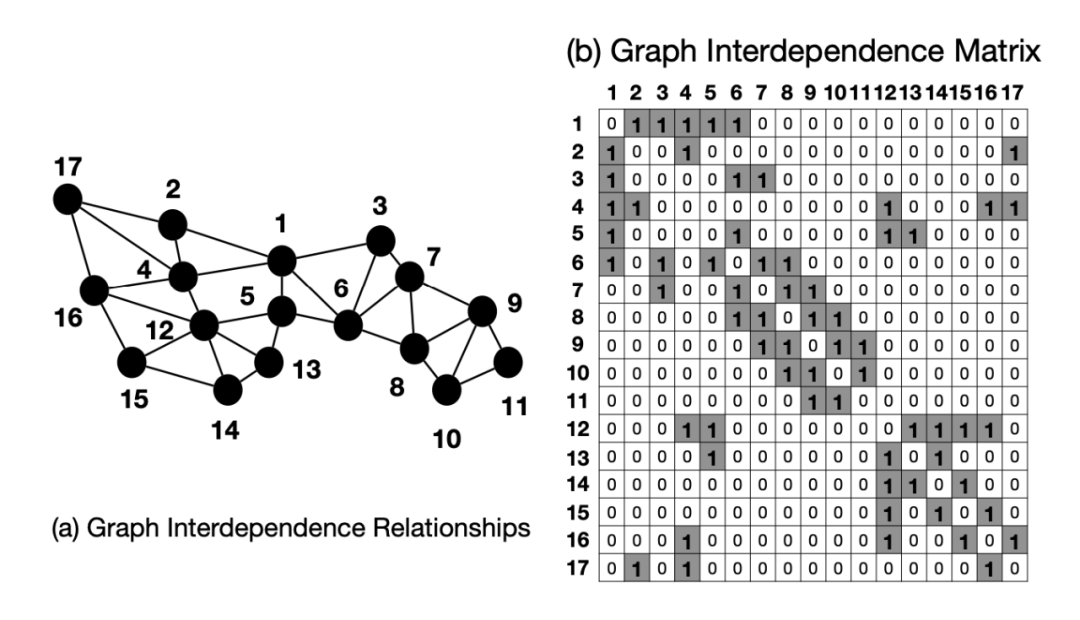

不仅如此,如下图所示,本文还提出了基于 graph 结构的拓扑依赖函数。图结构依赖函数和基于 PageRank 的图结构依赖函数旨在建模复杂数据之间的广泛依赖关系,特别是以图为基础的数据,如社交网络、基因互动网络等。

在图结构依赖函数中,数据的依赖关系被表示为一个图 G=(V,E),其中节点表示属性或数据实例,边表示它们之间的依赖关系,对应的依赖矩阵 A 则是图的邻接矩阵。基于该图结构,函数通过矩阵运算建模节点之间的多跳依赖关系,并引入累积多跳函数以整合多层次的信息交互。

除了上述提到的依赖函数之外,本文还提出了多中依赖函数用来建模多种类型数据之间的依赖关系。通过有效地使用这些依赖函数和其他函数,我们可以构建更加有效的模型架构,使 RPN 2 能够应对广泛的学习挑战。

深度学习模型的统一表示:CNN, RNN, GNN 和 Transformer

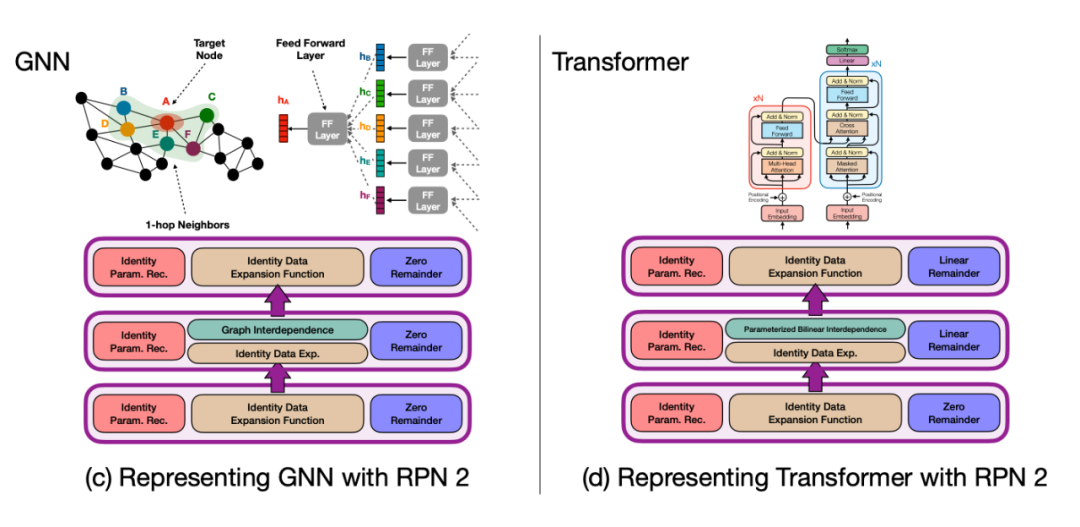

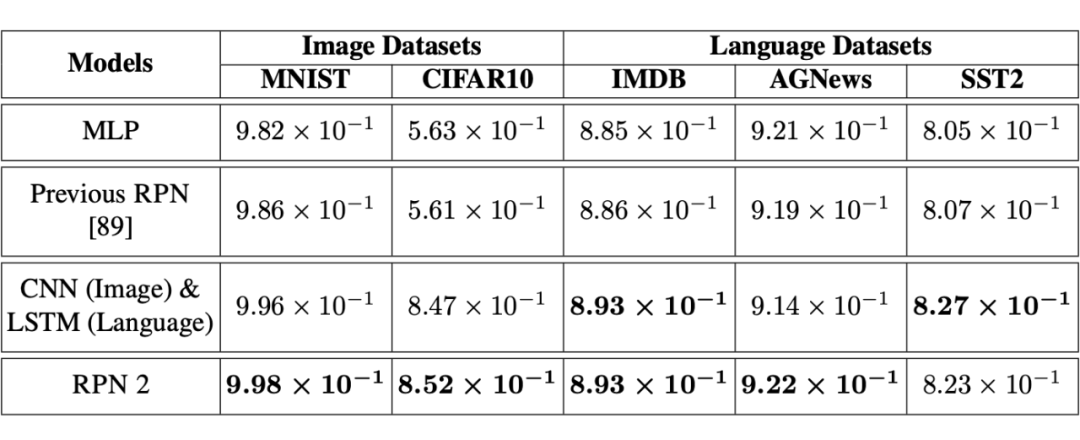

为了验证提出的 RPN 2 模型的有效性,本文通过大量的实验结果和分析,证明了 RPN 2 在多种 Function Learning Task 上的有效性。

-

MNIST 图片数据集

-

CIFAR10 图片数据集

-

IMDB 文本数据集

-

SST2 文本数据集

-

AGNews 文本数据集

7.2 图片数据依赖扩展

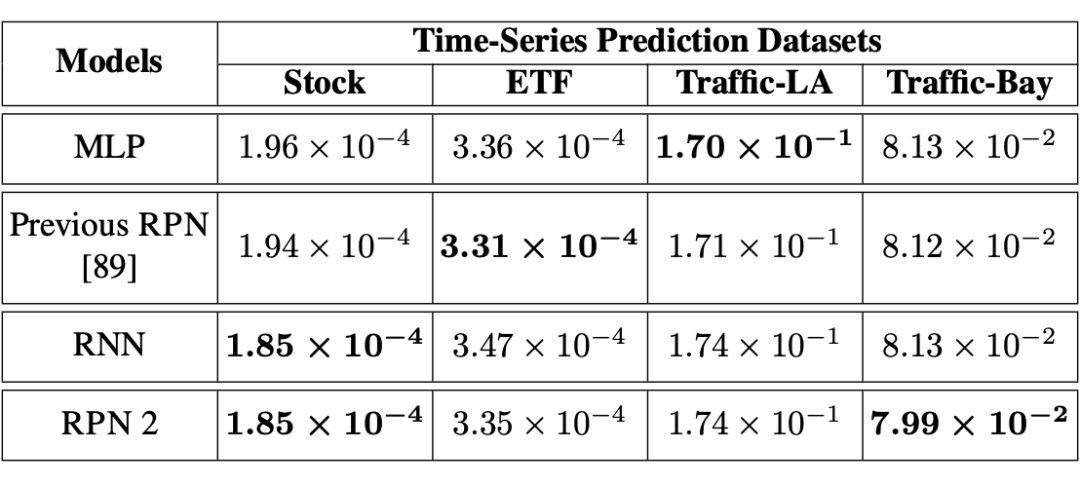

RPN 2 也可以有效地拟合时序数据,本文使用了四个时序数据集来验证 RPN 2 在时序数据拟合和预测的有效性,包括:

-

Stock market dataset -

ETF market dataset -

LA traffic record -

Bay traffic record

如下表所示,通过使用 chain 结构的依赖函数,RPN 2 可以有效的获取时序数据之间的依赖关系,并且在各个数据集上都获得有效的学习结果。

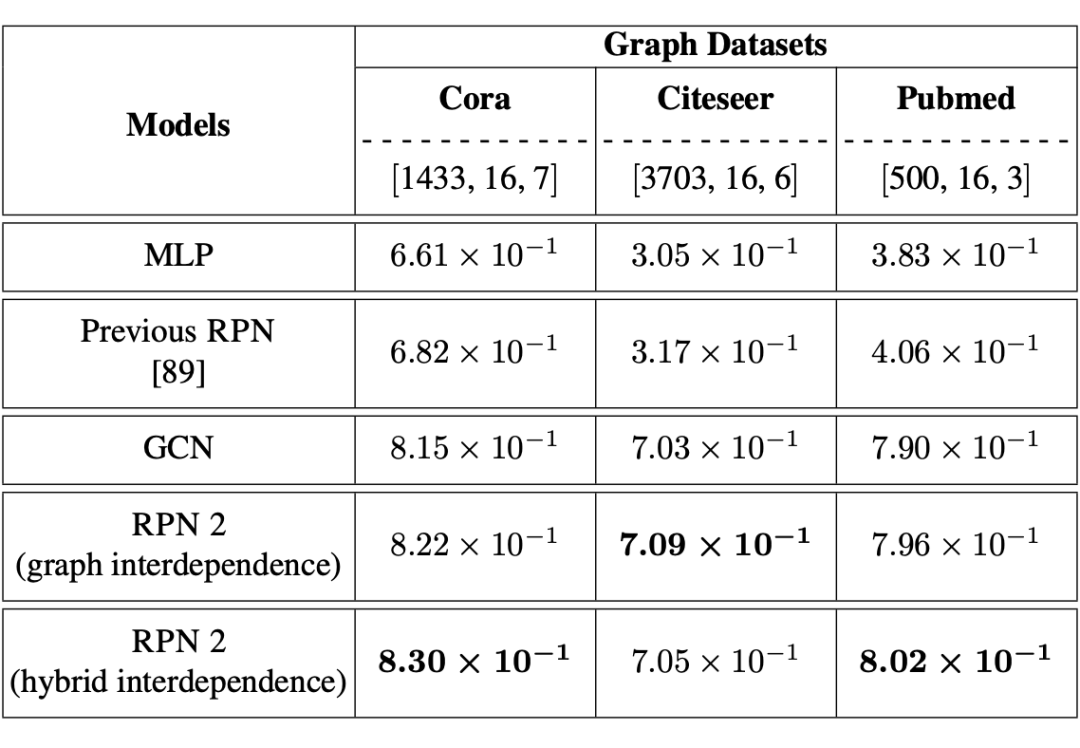

为了验证 RPN 2 在图结构数据上的有效性,本文也提供了各个方法在 graph 结构数据上的学习结果,包括:

-

Cora graph -

Citeseer graph -

Pubmed graph

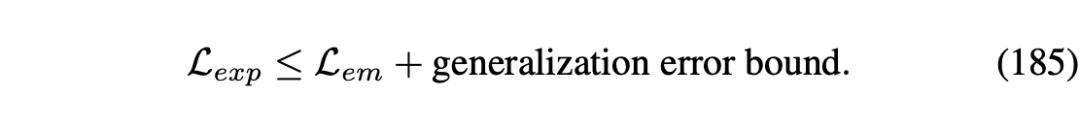

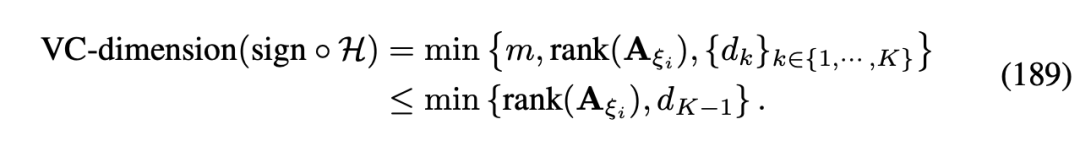

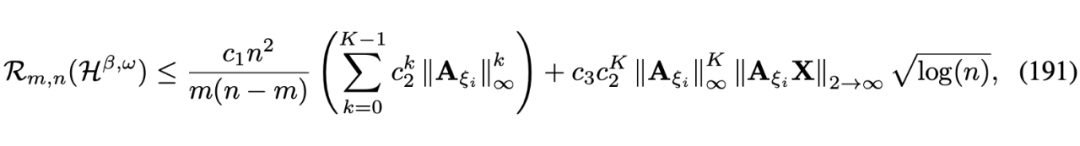

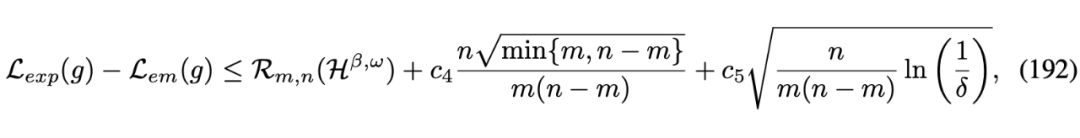

除了实验验证之外, 本文还提供了基于 RPN 2 的模型泛化误差的理论分析,其分析结果对目前主流的深度模型(例如 CNN, RNN, GNN 和 Transformer)都适用。

9.2 基于Rademacher Complexity泛化误差分析

除了 VC-dimension 之外,我们还基于 Rademacher Complexity 理论分析了模型的泛化误差。相比 VC-dimension,Rademacher Complexity 不仅仅考虑了 RPN 2 模型结构,还考虑了输入数据对泛化误差的影响。

本文通过引入建模属性和实例间关系的数据依赖函数,对 RPN 2 模型架构进行了重新设计。基于实验结果和理论分析,所提出的依赖函数显著提升了 RPN 2 模型在处理复杂依赖数据时的学习能力,具体贡献包括以下三方面:

理论贡献:与假设数据独立同分布的旧版模型不同,新设计的 RPN 2 模型通过一组基于输入数据批次的依赖函数,能够有效捕捉属性与实例之间的依赖关系,从而大幅扩展模型的建模能力。

此外,本文提供的理论分析(基于 VC 维和 Rademacher 复杂度)展示了如何定义最优依赖函数以减少泛化误差。这些依赖函数还从生物神经科学角度模拟了神经系统的某些补偿功能,为功能学习任务提供新的启发。

技术贡献:RPN 2 模型引入了一组多样化的依赖函数,从多个维度(包括输入数据批次、拓扑与几何结构等)捕捉属性和实例间的关系。这些函数实现了对多种主流模型(如 CNN、RNN、GNN 和 Transformer)的统一建模,并揭示它们的架构相似性——关键差异在于依赖函数的定义方式。这些发现为设计下一代 “Transformer-Next” 骨干模型提供了重要的理论指导。

10.2 RPN 2局限性

在实现 RPN 2 架构及其组件模块的过程中,我们发现了一些局限性,主要体现在动态数据建模能力、学习算法适配性以及大规模智能系统的潜在部署方面。

学习局限性:RPN 2 模型在适配损失函数、优化器和基于误差反向传播的学习算法方面面临一定挑战。尽管传统的表征学习损失函数和优化方法适用于当前的函数学习任务,但它们与以函数为导向的学习模型存在一定不一致性。

RPN 2 模型需要通过基于感知机的层(如身份数据变换、身份融合、零余项函数)将输入数据压缩至输出空间。尽管这些层对传统表征学习模型是必要的,但在函数学习模型中,它们仅进行最小的数据变换,显著降低了数据压缩后的表示能力。

建模局限性:本文虽然成功将多种主流骨干模型统一于 RPN 2 的范式中,但在表示 RNN 模型时仍面临挑战。当前模型缺乏动态处理能力,需要将 RNN 的时间依赖转换为空间依赖,这限制了 RPN 2 对“时间动态”的建模能力。这是构建具备空间智能的未来世界模型的关键因素之一。

为此,我们计划重新设计 RPN 2 中的模块,使其能够支持“时间动态”建模,这也将成为未来研究的重点方向。

大规模智能系统:为了验证所提技术的有效性,我们计划基于 RPN 2 构建一个大规模智能系统,以展示其多模态建模能力、学习性能优势以及高效的参数使用。

10.3 RPN 2后续工作

在即将到来的 2025 年,我们计划着力解决 RPN 2 模型和 tinyBIG 库的当前局限性,重点放在完善 RPN 2 模型框架以及开发利用增强版 RPN 2 模型和 tinyBIG 工具库的应用项目。

框架增强项目:按照目前的开发进度,我们预计将用六个月的时间解决 RPN 2 模型在学习方面的局限性,具体包括探索面向函数学习的损失函数、优化目标函数以及模型学习算法。一个包含这些学习优化功能的新版本 RPN 2 预计将在 2025 年年中发布。

此外,我们计划将“时间”及相关功能引入 RPN 2 模型,从而支持动态学习场景。对“时间动态”的建模将需要对现有功能和组件进行大幅度重新设计,这将是一个耗时的过程。在完成学习局限性的解决后,我们预计还需六个月将“时间动态”整合到模型架构中,目标是在 2025 年底发布支持该功能的版本。

本文重新设计了调和多项式网络(Reconciled Polynomial Network),引入了新模型 RPN 2,其核心创新是数据依赖函数,用于显式建模数据实例和属性之间的多样化关系。

这些函数显著提升了 RPN 2 在图像、语言、时间序列和图数据等复杂任务中的学习能力。在多模态基准数据集上的实验表明,RPN 2 在深度函数学习任务中始终优于现有的骨干模型。

此外,RPN 2 扩展了其统一潜力,将 CNN、RNN、GNN 和 Transformer 等主流架构纳入其范式,同时为设计下一代 “Transformer-Next” 模型提供了新的见解。

此外,为了促进新 RPN 2 的采用、实现和实验,我们更新了先前论文中提出的 tinybig 工具包至新版本tinybig v0.2.0。

此外,tinybig v0.2.0 还引入了一组新的数据压缩和多输入函数,用于将数据向量嵌入到低维空间中。

RPN 2 还更新了现有的数据扩展和参数调和函数库,以便更好地支持基于 RPN 2 模型的实现。该更新的工具包使研究人员能够快速设计、定制和部署新的 RPN 2 模型,适用于各种相互依赖数据集上的广泛功能学习任务。

tinybig v0.2.0 的具体信息,欢迎查看官方网站和项目在 github 的主页。Github Repository:

https://github.com/jwzhanggy/tinyBIG

https://pypi.org/project/tinybig/

除此之外,我们还问这个项目搭建了完整的项目网站,网站中包含了完整的项目文档,代码示例,和入门教程。

Official Website:

https://www.tinybig.org/

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

(文:PaperWeekly)