同一天,硅谷模型三巨头连续发布了新的模型(到底也不知道谁截胡谁了)。

OpenAI 终于发布了新的开源模型,gpt-oss-120b 和 gpt-oss-20b,上次开源 GPT-2 已经是 6 年前的事情了。从目前的评测成绩来看,两款模型能力接近 o4-mini,虽然编程能力略弱,但这个 SOTA 级别的能力表现,很期待接下来的开源生态的发展。

DeepMind 也发了个大招,一个看起来基本进入可用阶段的世界模型 Genie 3,一句话直接生成可交互的 3D 世界、角色和道具,目前尚未对外开放,但演示片很震撼。

Claude 发布了旗舰模型 Opus 的小版本升级——Claude Opus 4.1,编程能力依旧没得说,这次强化了 Agent 能力。

接下来,该期待 DeepSeek R2 了。

文章内容编译自「机器之心」、部分官博文章。

超 10000 人的「AI 产品市集」社群!不错过每一款有价值的 AI 应用。

-

最新、最值得关注的 AI 新品资讯;

-

不定期赠送热门新品的邀请码、会员码;

-

最精准的AI产品曝光渠道

01

OpenAI 开源两个推理模型,

o4-mini 水平

这是近几年来(自 GPT-2 以来),OpenAI 重新开源模型。

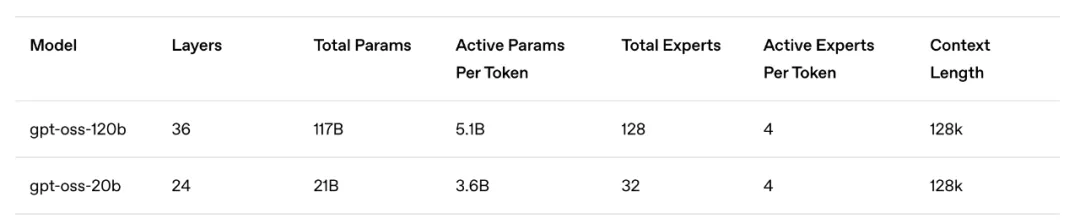

两款模型均采用 Transformer 架构,并利用专家混合(MoE)来减少处理输入所需的活跃参数数量。其中,gpt-oss-120b 每个 token 激活 5.1B 参数,而 gpt-oss-20b 则激活 3.6B 参数。两款模型的总参数分别为 117B 和 21B。

此外,两款模型采用交替密集和局部带状稀疏注意力模式,类似于 GPT-3。为了提高推理和内存效率,模型还使用了分组多查询注意力,组大小为 8。同时利用旋转位置编码(RoPE)进行位置编码,并原生支持最长 128k 的上下文长度。

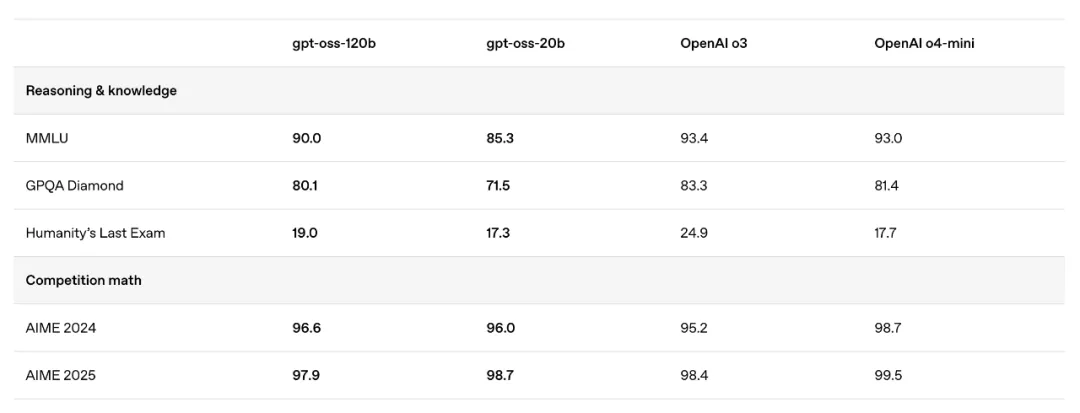

两款开源模型与 o3、o4-mini 的跑分结果比较如下:

作为两个 SOTA 级别的开源语言模型,gpt-oss-120b 和 gpt-oss-20b 可以提供强大的实际应用性能,并具有低成本优势。

两款模型在推理任务上超越了同等规模的开源模型,展示了强大的工具使用能力,并且经过优化,能够高效部署在消费级硬件上。训练过程中结合了强化学习以及受 OpenAI 内部最先进模型启发的技术,包括 o3 和其他前沿模型。

其中,gpt-oss-120b 模型在核心推理基准测试上与 o4-mini 几乎持平,同时能够在单个 80GB GPU 上高效运行。gpt-oss-20b 模型在常见基准测试中表现与 o3-mini 相似,且仅需 16GB 内存即可运行,适用于边缘设备,非常适合本地推理、设备端使用或在没有高昂基础设施的情况下快速迭代。

两款模型在工具使用、few-shot 函数调用、CoT 推理以及 HealthBench 测试中表现非常出色,甚至超越了 o1 和 GPT-4o 等专有模型。

总结一波,这两个开源模型的亮点包括:

-

宽松的 Apache 2.0 许可证:自由构建,不受版权限制或专利风险 – 非常适合实验、定制和商业部署。

-

可调整的推理力度:根据具体用例和延迟需求轻松调整推理力度(低、中、高)。

-

完整的思维链(CoT):完全可访问模型的推理过程,从而更轻松地进行调试并增强对输出的信任。不计划向终端用户展示。

-

可微调:通过参数微调,完全可根据特定用例定制模型。

-

Agentic 功能:使用模型的功能进行函数调用、网页浏览、Python 代码执行和结构化输出。

-

原生 MXFP4 量化:模型使用原生 MXFP4 精度针对 MoE 层进行训练,使得 gpt-oss-120b 可在单个 H100 GPU 上运行,gpt-oss-20b 模型可在 16GB 内存内运行。

除了本地部署外,目前可以在 OpenRouter、Amazon Bedrock、Amazon SageMaker AI 等平台在线体验。

GitHub 地址:https://github.com/openai/gpt-oss

hugging face 地址:https://huggingface.co/openai/gpt-oss-20b

hugging face 地址:https://huggingface.co/openai/gpt-oss-120b

博客地址:https://openai.com/index/introducing-gpt-oss/

02

谷歌推出世界模型 Genie 3:

玩家实时交互,支持提示词生成

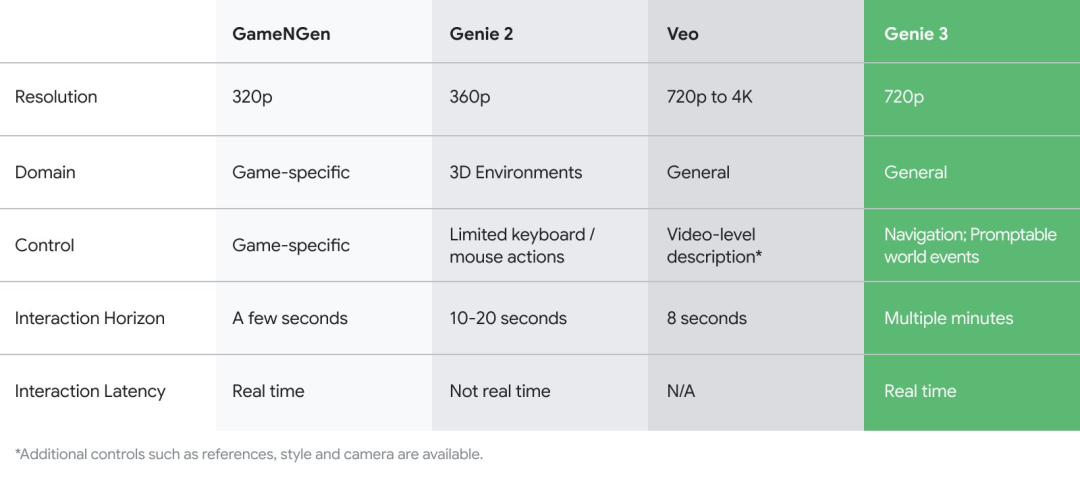

谷歌 DeepMind 宣布其 Genie 世界模型系列最新版本 Genie 3。据介绍,在 Genie 3 生成的动态世界中,玩家可以每秒 24 帧的速度实时导航,在 720p 分辨率下保持几分钟的一致性。

相比 Genie 2,最新一代 Genie 实现了分辨率的显著提升,达到了实际可用的程度,同时支持使用提示词生成世界事件。

怎么说,一句话生成一个可游玩体验的游戏,可能就成真了!

Genie 3 的进化最大的亮点在于实时响应的用户交互,以及能够长达数分钟的场景(三维)一致性。Genie 3 所生成的环境在数分钟内仍能保持高度一致性,其视觉记忆能力最远可回溯至一分钟前的画面状态。

具体功能包括:

-

模拟世界的物理属性:展现自然现象如水与闪电,以及复杂的环境交互。

-

模拟自然世界:生成充满活力的生态系统,从动物行为到复杂的植物生命。

-

建模动画和小说:激发想象力,创造奇幻场景和富有表现力的动画角色。

-

建模不同地点和历史背景:超越地理和时间的界限,探索各地和历史场景。

博客地址:https://deepmind.google/discover/blog/genie-3-a-new-frontier-for-world-models/

03

Anthropic 发布 Claude Opus 4.1:

主打智能体任务、真实世界编程能力

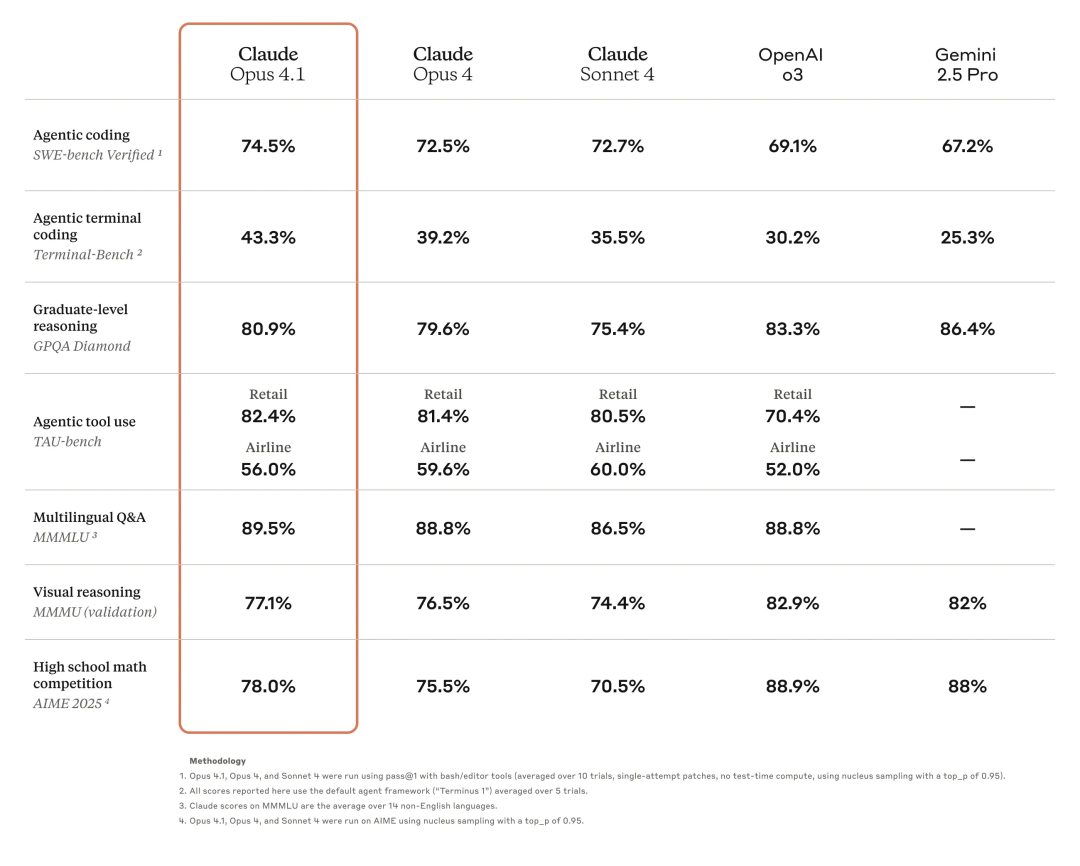

Anthropic 发布了其最新编程模型 Claude Opus 4.1,基于此前发布的 Claude Opus 4 构建,在智能体任务、真实世界编程和推理能力上有了大幅提升,具备 200K 上下文窗口。

性能方面,Opus 4.1 在 SWE-bench Verified 基准上达到 74.5%,创造了该项评测的新纪录。此外,该模型还在深度研究和数据分析等方面有所提升,尤其是在细节追踪和智能体搜索方面。

据第三方 GitHub 评估,Claude Opus 4.1 在大多数能力上相较于 Opus 4 都有所提升,尤其在多文件代码重构方面表现出显著进步。

目前,Claude Opus 4.1 已集成至 Claude Code 中,面向 Claude Pro、Max、Team 和 Enterprise(企业)用户开放使用。

开发者可通过以下平台使用 Claude Opus 4.1:

-

Anthropic API

-

Amazon Bedrock

-

Google Cloud 的 Vertex AI

在 API 价格方面,Claude Opus 4.1 的定价为:

-

每百万输入 token 15 美元

-

每百万输出 token 75 美元

博客地址:https://www.anthropic.com/news/claude-opus-4-1

System Card: https://assets.anthropic.com/m/4c024b86c698d3d4/original/Claude-4-1-System-Card.pdf

(文:Founder Park)