跳至内容

最近关于 GPT-5 的猛料简直满天飞,奥特曼也公开谈体验,种种迹象表明这次真的要来了。

不过 The Information 今天曝光了GPT-5 的更多内幕,被 OpenAI 视为迈向 AGI 关键一步的 GPT-5,其实经历了一场不为人知的「难产」危机。

这场危机的核心,是一连串致命的打击:被寄予厚望的突然「智障」,核心项目宣告失败,顶级人才被竞争对手用重金挖走,技术路线一度摇摆。

与此同时, OpenAI 现金流正以每分钟烧掉 11 万人民币的速度奔向枯竭。尽管年化收入已暴增至 120 亿美元,但面对 2025 年高达 80 亿美元的预期现金消耗,也急需 GPT-5 提振外界的信心。

GPT-5,已经不仅是一个技术产品,更是 OpenAI 的一场豪赌。APPSO 今天就给你扒一扒就从这场惊心动魄的内幕。

1. GPT-5 曾一度「脑死亡」:OpenAI 内部最强推理模型 o3 在实验室里是「天才」,一尝试对话就秒变「智障」,性能大幅衰减。原定为 GPT-5 的 Orion 项目也因技术瓶颈流产,降级收场。

2. 开发过程堪比宫斗剧:一边是技术上遭遇「规模化诅咒」,高质量数据告急;另一边是核心研究员被 Meta 用「足球巨星级」薪酬挖角,团队动荡,士气低落。

3. 极限救场:在绝境中,OpenAI 搞出个「通用验证器」系统,让一个 AI 自动给另一个 AI 当考官、挑毛病,硬是靠这招「左右互搏」的技术,把 GPT-5 从技术泥潭里捞了出来。

4. 最终版本是「全家桶」:最新泄露的 GPT-5 是一个模型家族,包括全能主模型 o3-alpha、编程小钢炮 lobster 和迷你版 starfish,首次实现了推理和多模态能力的统一。

5. 烧钱豪赌:一边是年化收入飙到 120 亿美元,ChatGPT 周活破 7 亿的泼天富贵;另一边是预计 2025 年要烧掉 80 亿美元现金的巨大窟窿。GPT-5 的成败,也会决定 OpenAI 的未来。

6. 画饼被泼冷水:奥特曼高喊「GPT-5 比我们所有人都聪明」,而老熟人马库斯则列出「7 大悲观预测」,提醒大家别太上头。

今年上半年,一个名为 o3 的推理模型曾在 OpenAI 内部被封为「天才」。它是一个「教师模型」(teacher model),也就是最原始、未经过对话优化的版本。

通过投入海量的 Nvidia H100 算力,并赋予它实时搜索网络和代码库的能力,o3 在理解复杂科学概念等领域取得了前所未有的突破。

内部测试结果让所有研究员都兴奋不已,他们似乎看到了通往 AGI 的康庄大道。

但当团队试图将这个「天才」教师模型,通过指令微调(SFT)和人类反馈强化学习(RLHF)等手段,转化为一个能与普通用户流畅对话的「学生模型」(student model)时,它的性能发生了灾难性的衰减,表现甚至还不如上一代的 o1 模型。

一位内部人士用了一个绝妙的比喻:「这就像你让爱因斯坦去参加小学语文考试,他满脑子都是相对论和量子力学,但你非要让他解释‘的、地、得’的用法。强迫它用人类的语言逻辑进行对话,无异于一种「降智打击」(dumbs down the raw, genius-level model)。」

我们现在偶尔看到 ChatGPT 在「深度思考」难题时,会先输出一堆看不懂的「胡言乱语」(gibberish),其实就是这种模型原始思维与人类语言冲突的冰山一角。

o3 的失败,让 OpenAI 第一次意识到,AI 的「智能」和人类的「沟通」之间,存在着一道巨大的鸿沟。

o3 的挫败并非孤例。更早之前,被内部寄予厚望、原计划成为 GPT-5 的 Orion 项目也遭遇了滑铁卢。该项目雄心勃勃,但在实际训练中始终无法产出超越 GPT-4o 的性能,最终在今年 2 月被无奈降级,以 GPT-4.5 的名义发布。

高质量数据枯竭:互联网上能薅的羊毛快被薅秃了,高质量、未被污染的数据越来越难找。

规模化定律失灵:一些在小模型上效果拔群的训练技巧和调整方法,在将模型规模扩大到万亿参数级别后,突然就不起作用了,甚至会产生反效果。

屋漏偏逢连夜雨。OpenAI 内部,一些高级研究员强烈抵制将他们的核心发明拱手让给最大股东微软,尽管合同白纸黑字写着微软在 2030 年前拥有独家 IP。

与此同时,财大气粗的竞争对手 Meta 以堪比「顶级球星」的薪酬,从 OpenAI 挖走了十多名核心研究员,直接导致一些关键项目团队重组,人心惶惶。

就在研发陷入僵局,整个公司都笼罩在失败阴影下时,OpenAI 亮出了他们的王牌:一个被称为「通用验证器」(universal verifier)的系统。

这个系统的核心思想,就是「用魔法打败魔法」。它能让一个大语言模型(LLM)扮演「考官」的角色,通过交叉引用网络信息、代码库和内部知识库,来自动检查和评判另一个「考生」模型的答案质量。

它的厉害之处在于,不仅能验证像编程、数学这类有明确对错答案的领域,还能通过复杂的评估标准,去判断创意写作、策略分析等主观性更强内容的质量。

这套基于强化学习(RL)的「AI 教练」体系,有效地解决了人类标注员数量有限、水平不一的难题,为模型的持续优化提供了源源不断的、高质量的反馈数据。

正是这有了这个技术,才为 GPT-5 的开发扫清了最后的障碍。

经历九死一生,根据目前爆料,GPT-5 会是一个强大的模型家族,首次实现了推理能力和多模态交互能力的「大一统」,或许混乱的命名也能因此被解决。

GPT-5 主模型 (代号 「nectarine」 或 「o3-alpha」):全能型选手,据称在高级编程和物理问题上表现出色,甚至有 zero-shot demo 流出。

GPT-5 mini (代号 「lobster」):专为编程而生的小钢炮。有网友爆料,让它和另一个模型同时创建交互式神经网络动画,lobster 一次性就生成了带彩色节点的完美方案,而另一个模型还在报错。

GPT-5 nano (代号 「starfish」):超轻量级选手,已经悄悄出现在大模型竞技场上。

如今,随着发布的临近,奥特曼又开始高调「画饼」,最近在采访直接提到 GPT-5 的体验:成功解答了一封邮件中他自己都没看懂的问题,让他感受到前所未有的「无能为力」,他甚至夸张地表示「那时我靠在椅子上,心里想:哇,这一刻终于来了……」

他甚至直言「感觉自己在 AI 面前简直无能为力」:

那本来是我觉得自己应该能搞定的问题,但我却做不到。这真的挺难受的。但 AI 就轻轻松松地完成了。那是一种很奇怪的感觉。

但这套说辞,网友们似乎已经免疫了,不少人吐槽:「刚发布时可能很惊艳,但一周后就会变笨,跟以前所有模型一个德行。」

「泼冷水大王」马库斯也照例发布了 7 条悲观预测,提醒大家 GPT-5 依然会犯低级错误、产生幻觉,离 AGI 还远着呢。

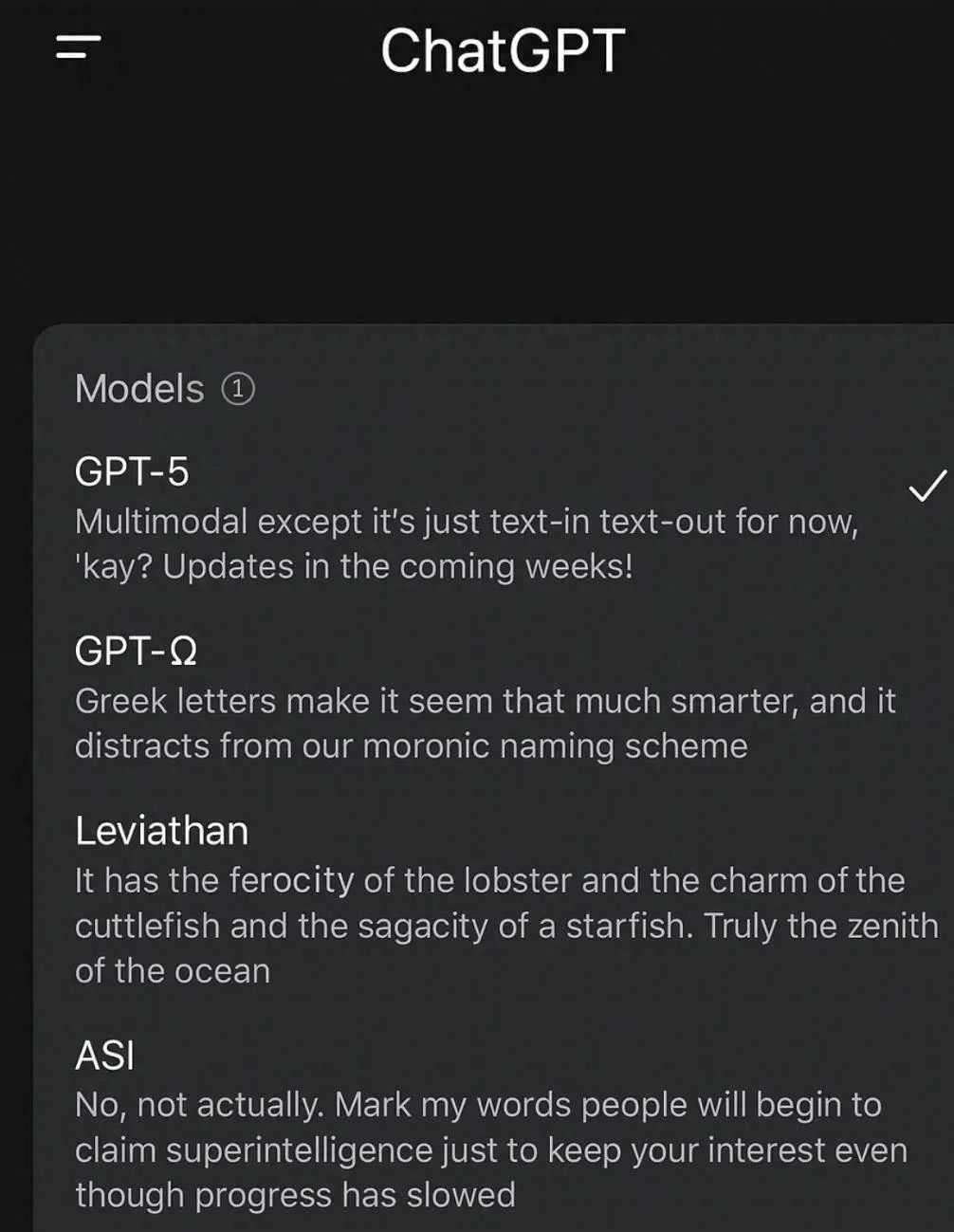

甚至有网友用 AI 脑补了GPT-5 后用户对奥特曼的反应.

不管怎样,经历了无数次的「下周发布」和真假难辨的爆料后,现在用户的心情大概只剩下:

欢迎加入 APPSO AI 社群,一起畅聊 AI 产品,获取#AI有用功,解锁更多 AI 新知👇

✉️ 邮件标题「姓名+岗位名称」(请随简历附上项目/作品或相关链接)

(文:APPSO)