WAIC 首日,便以重磅嘉宾开场——诺贝尔奖得主,人工智能教父 Geoffrey Hinton,发表了开幕演讲。紧随其后的是 MiniMax 创始人、首席执行官闫俊杰的主题演讲「每个人的人工智能」。后续则是一系列的专家圆桌对谈。

作为最为关注 AI 治理及安全问题的顶级专家,Hinton 一如既往地表达了他对 AI 治理的关心。从自己的研究生涯开始,他分享了大模型的变迁以及背后的技术范式。最后他呼吁建立一个由多个国家参与的国际 AI 安全研究网络,专注于研究如何训练 AI 向善。

MiniMax 创始人及首席执行官闫俊杰则以「每个人的人工智能」为出发点,分享了他作为国内最早一批研究深度学习的研究者,以及最早开始探索大模型的公司,最后提出:AGI 一定会实现,并且终将是面向大众、服务大众,同时,也需要 AI 公司与所有的用户,共同来实现。

从大约 60 年前开始,AI 就发展出了两种不同的范式。一种是「符号主义」路径,强调逻辑推理的能力。我们通过规则操作符号来进行推理,这种方式可以帮助我们理解知识是如何被表达与处理的。这类 AI 模型的基础是对符号的处理,被认为更符合逻辑智能的本质。

另一种路径则以生物智能为基础,是图灵与冯·诺依曼更倾向相信的方式。他们认为智能的本质在于从神经连接中学习,在于速度、结构和连接模式的改变。这种「连接主义」强调的是学习与适应,而非显式的逻辑规则。

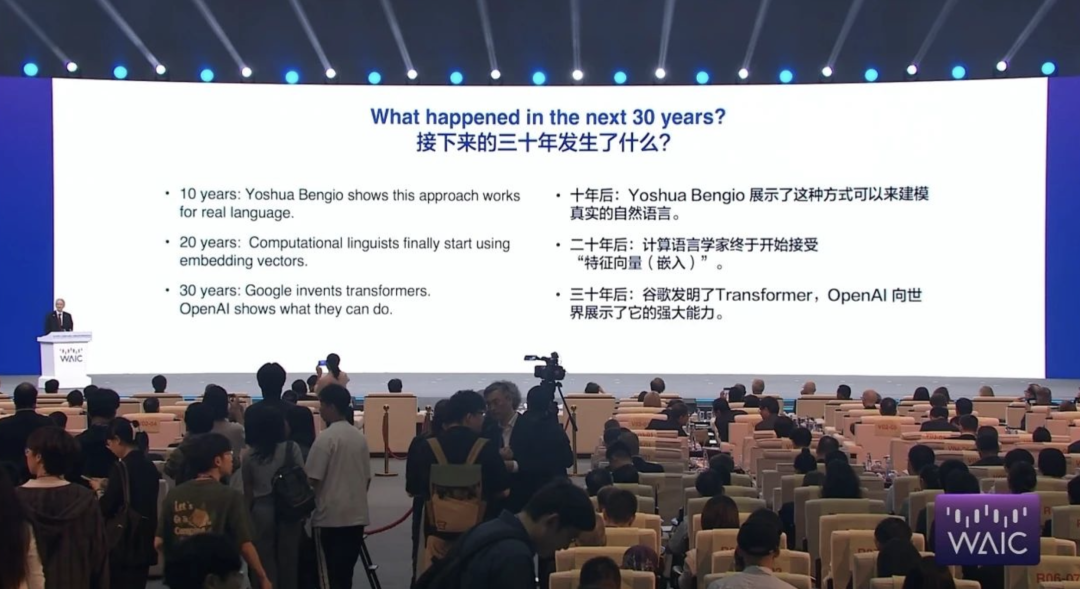

1985 年,我曾构建过一个非常小的模型,试图将这两种理论结合起来。我的想法是:每一个词都可以由多个特征(features)表示,而这些特征之间可以被用来预测下一个词。这个模型不存储完整的句子,而是通过生成语言来学习词汇之间的关系。

这种方式强调语言中的「语义特征」——也就是说,我们并不是仅仅靠规则,而是通过「理解」词汇的语义来进行预测。这为后来计算语言学界接受特征表示打下了基础。二十年后,这种思想得到了进一步发展,例如被用于构建更大规模的自然语言处理系统。

Google 的 Transformer 架构,以及 OpenAI 研究者们所展示的大型语言模型(如 GPT),则把这种模型放大到了新的高度。这些模型的底层原理与我当年构建的小模型类似:将语言中的词汇视为具有多维特征的「构件」,然后在多层神经网络中进行组合、融合,从而实现语言生成与理解。

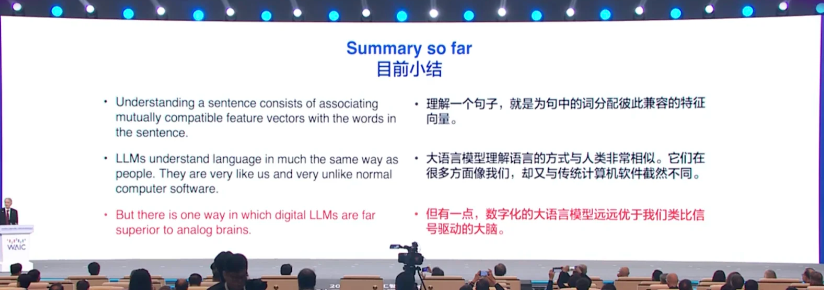

我喜欢用「乐高积木」作为比喻。每个词就像一个多维度的乐高积木,具有成千上万的特征维度。理解语言就像用这些积木建模,不同的词要以合适的方式「握手」,即匹配连接点,这种匹配方式反映了词与词之间的语义关系。如果词的形状改变了,它与其他词的「握手方式」也会变化,语言的意义也随之变化。

这种构造方式类似于蛋白质折叠:氨基酸在空间中的不同组合方式,最终决定了蛋白质的功能。人脑理解语言也是以此种方式构建语义结构的。

这与人类知识传播完全不同。我无法把我的神经元结构「拷贝」到你脑中,语言只能以极低的比特率(一秒大约 100 比特)来传递信息。而在数字系统中,一个神经网络模型可以复制成成千上万个版本,它们在不同设备上学习,并且可以快速共享权重,远远超越人类知识传播的速度与效率。

我的观点是,人类理解语言的方式和大语言模型的方式几乎是一致的。人类甚至可以被看作一种大语言模型。也正因如此,人类也和 AI 一样会产生「幻觉」,因为我们也会自己创造出一些不真实但合理的解释。

当然,也有本质上的不同。AI 在某些方面比人类更强。比如在计算机科学中有一个根本性的原则,那就是:软件可以被抽象、被复制,并在不同的硬件上运行。只要程序存在,它的知识就不会消失。你甚至可以毁掉所有的硬件,只要软件代码还存在,它就能被复活。

从这个角度看,程序中的知识是永恒的,不会死亡。这和人脑完全不同。人脑是模拟系统,每一次的神经元激发都是独一无二的,是不可完全复制的。你不可能把你脑中的神经结构复制到我脑中,因为我们每个人的大脑连接方式都不同。

这就导致一个关键问题:知识在大脑中是和硬件绑定的,而在数字系统中,知识可以和硬件分离。因此,AI 系统具有「永生性」。

这种特性带来了两个巨大的好处:第一,它只需要非常小的能耗。人脑的功率大约只有 30 瓦,却拥有上万亿个神经元连接,这和数字系统的能效比类似。第二,我们不需要花大价钱去一模一样地复制每一个神经网络。

当然,我们在知识传递方面仍面临一个难题。比如说,我没有办法直接把我脑中的知识「展示」给你,因为那是模拟性的东西。我只能用语言向你解释我学到的内容。

为了解决模型体积与计算资源问题,现在的研究越来越倾向于「蒸馏」技术:从大模型中提取知识,转移到一个小模型中。这个过程就像教师与学生之间的传授关系:教师通过语言、上下文连接等方式将知识传递出去,学生则尝试理解并复制这种能力。

不过这种过程在人类之间的效率是非常低的,毕竟语言的带宽有限。而在机器之间,这种知识的复制可以在极大规模下进行,实现指数级的知识转移。

AI 的能力正在快速增长,未来它们很可能变得比人类更智能。有人可能会认为,万一 AI 不听话,我们可以把它关掉,但这并不现实。如果 AI 足够聪明,它会通过操纵人类、获得控制权等方式来避免被关闭。

这个问题就像养一只小老虎当宠物——在它还小的时候你觉得可以控制它,但等它长大以后,就可能失控。AI 的能力可以带来巨大的好处,比如提高医疗、教育、应对气候变化和材料研发的效率。它不会消失,也不可能被单一国家所控制。

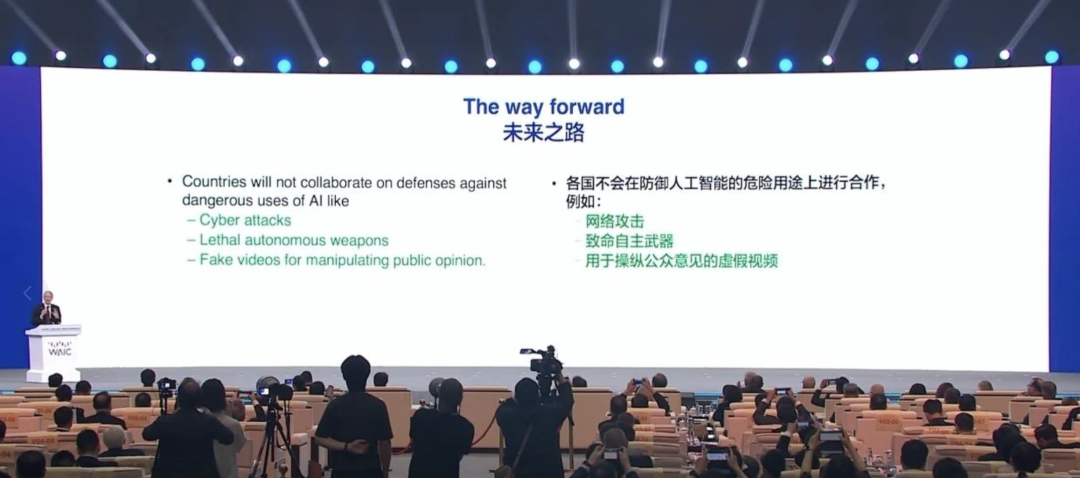

虽然不同国家的利益存在分歧,在如网络攻击、致命武器或舆论操控方面也难以形成有效合作,但就像冷战时期美苏合作避免核战争一样,各国在 AI 安全方面是有可能合作的。

我的建议是建立一个由多个国家参与的国际 AI 安全研究网络,专注于研究如何训练 AI 向善——这与训练 AI 变聪明是两件不同的事。每个国家可以在本国进行 AI 安全研究,但应共享成果,协助全人类开发出愿意协助、而不是统治我们的智能体。

从长远看,这可能是人类最重要的议题。而好消息是,这个问题是全人类可以团结起来共同面对的。

大家好,我今天分享的主题是「Everyone’s AI」,也就是「每个人的人工智能」。这个题目的选择,其实和我过去这些年在 AI 领域的经历息息相关。

我是在 Hinton 先生刚刚发表 AlexNet 时进入深度学习领域的,那时我还是国内最早一批研究深度学习的博士生。后来,当 AlphaGo 让 AI 成为社会公众关注的焦点时,我正参与第一家人工智能创业公司。再往后,差不多是在 ChatGPT 推出前一年,我们创立了国内最早做大模型的一家公司。从那时起到现在已经十五年,在这段时间里,我几乎每天都在写代码、做实验、解决具体的问题。但与此同时,我心里也反复思考一个问题——人工智能到底是什么?它和这个社会究竟有什么关系?

随着模型性能的不断提升,我们慢慢意识到,AI 的确正在和社会建立起越来越紧密的联系。最初我们做数据分析时需要自己写软件,后来我们发现,其实可以让 AI 来生成分析软件,自动完成数据处理的工作。作为一名研究员,我很关注各个技术领域的进展。一开始我们想开发一款 App 来跟踪科研动态,但后来我们发现其实不需要自己去做,只要构建一个 AI agent,它就能自动地帮我们完成,而且效率更高。

AI 不仅仅是一种工具,它也正在变成创意的源泉。比如说,这个场馆曾在十五年前举办过世博会,当时「海宝」这个吉祥物形象风靡一时。十五年过去了,上海有了很多新的发展,我们想尝试生成一些具有本地特色、又能代表当代潮流的 IP 形象。AI 在这方面的能力非常出色,比如为徐汇书院或大楼设计的形象,它都可以快速完成。

还有大家熟悉的 Labubu形象,以前制作一个可能需要两个月的时间、投入上百万人民币的预算,而现在通过先进的视频生成模型,这种视频一天就可以完成,成本也降到了几百元。在过去半年里,我们的模型已经在全球生成了超过三亿条视频内容。这表明,AI 模型正逐步将创意生产大众化,让每一个人的创意都能被释放出来。

而且,我们越来越发现,AI 的实际使用已经远远超出了最初的设计想象。现在有人用 AI 解析古文字,有人用 AI 模拟飞行,有人用 AI 操作天文望远镜。随着模型能力增强,许多原本需要大型团队才能完成的工作,现在只要一个人借助 AI,就能够实现。这大大放大了个人能力,拓宽了创意的边界。

经过这些年亲身的经历和观察,我们逐渐形成了一个清晰的认知:我们作为一家 AI 创业公司,并不是在复制过去的互联网公司。我们所做的,是创造一种全新的生产力形态。这种生产力是对个体和社会能力的持续增强。在这个意义上,我们相信 AI 是一种能力,而且这种能力是持续增长的。人类不可能永远保持快速进步,不可能一直持续学习大量新知识,但 AI 可以。AI 能够不停学习、不停进化,因此我们认为 AI 公司本质上不是互联网公司,而是能够提供持续性能力增强的组织。

更有意思的是,AI 现在也在反过来帮助我们打造更好的 AI。作为一家研究型公司,我们每天都要写很多代码,进行大量实验。但如今,我们公司大约 70% 的代码是由 AI 自动生成的,90% 的数据分析也是靠 AI 来完成的。除了提升效率,我们还发现了另一个重要变化:AI 的提升越来越依赖于人类专家的引导。

一年前,我们的标注员还主要是非专业人员,做的是一些基础性标注工作。但随着模型能力提升,我们发现,只有极少数顶尖专家,才能真正让 AI 学会更复杂的思考方式。这种「教学」并不是给 AI 一个标准答案,而是教它一种思考过程。通过学习这种过程,AI 才能变得更加泛化,接近人类专家的判断和理解能力。

除了专家教学,我们还在尝试另一种路径——让 AI 在环境中自主学习。过去半年,我们构建了各种训练环境,从编程 IDE 到智能体(Agent)平台,再到沙盒游戏系统,只要环境设计合理、有清晰的奖励机制,AI 就可以持续学习、持续进步。这种方式可以被大规模复制,不断拓展模型能力。

基于这些观察,我们有一个非常确定性的判断:AI 会变得越来越强,而且这种增强几乎是没有尽头的。那么接下来的问题是,AI 会不会最终被某一家组织垄断?它是否只能掌握在少数几家手中?

我们的看法是否定的。AI 不会只属于某一个组织,而是会在多家公司和多个组织之间共同发展,原因有三个。

首先,不同模型有不同的对齐目标。有些模型设计时更像一个严谨的程序员,适合做智能体系统;有些模型则更注重人机交互,更像有情商的对话伙伴;还有一些模型充满想象力。这些差异不仅反映了模型能力的多样性,更反映了背后公司的价值观差异。因此,必然会长期存在多个表现不同的模型。

其次,现在越来越多的系统是由多个模型构成的多智能体架构,不再依赖某一个单独的大模型。这些系统整合多个模型和工具,在协同工作中展现出更高的智能和解决复杂问题的能力。这意味着单个模型的优势在系统中会被削弱,小公司也能参与竞争。

最后一点,我们也看到了开源模型的强势崛起。尽管目前性能最好的模型仍以闭源为主,但优秀的开源模型数量正在迅速增加,而且正在快速逼近闭源模型的能力。开源力量让更多人可以参与 AI 的发展,使得 AI 不再是某一方的专属资源。

因此,我们相信,AI 的发展趋势是普惠的。它不会被少数人垄断,而是逐渐成为所有人都能使用的工具。我们看到的实际情况也支持这一判断。过去一年半里,主流模型的规模其实并没有大幅增长。为什么?因为一个很现实的因素是推理速度。推理如果太慢,用户体验就会变差,不实用。所以大多数模型设计时都必须在参数规模和计算效率之间做权衡。芯片性能每十八个月提升一倍,模型大小基本也跟着这个趋势变化,并没有无限膨胀。

虽然大家都有更多的算力了,但这些算力更多地被用在了更复杂的训练任务和推理优化上,而不是堆模型参数。训练的成本并没有大幅上升,真正拉开差距的,不是算力,而是实验设计的能力、团队效率和创新力。没有特别多资源的小公司,也可以通过优化实验流程,达到很高的研发效率。

推理方面,情况也类似。在过去一年,最优模型的推理成本已经下降了一个数量级。未来一年,这个成本还有可能再降低一个数量级。也就是说,AI 正在变得越来越便宜、越来越实用。

当然,尽管 token 单价下降,使用量却在急剧增长。比如去年,一个对话只用几千个 token,现在可能会消耗几百万个,因为问题更复杂,使用者更多。这也意味着,虽然单位成本低了,总体需求仍在上升。

综合来看,我们的判断是,AI 会变得每个人都用得起。虽然付费能力不同的人能解决的问题数量可能不同,但 AI 的使用门槛会越来越低。

最后,我想用一句话来总结今天的分享:Intelligence with Everyone。这不仅是我们的口号,也是我们创业的初心。我们坚信,AGI 一定会实现,而它的实现不会只是某家公司的胜利,而应当是整个社会、AI 公司和用户共同努力的成果。AGI 应该属于所有人,而不是少数人。我们也愿意为这个目标,长期奋斗下去。

WAIC 2025 APPSO 在现场,欢迎加入社群一起畅聊 AI 产品,获取#AI有用功,解锁更多 AI 新知👇