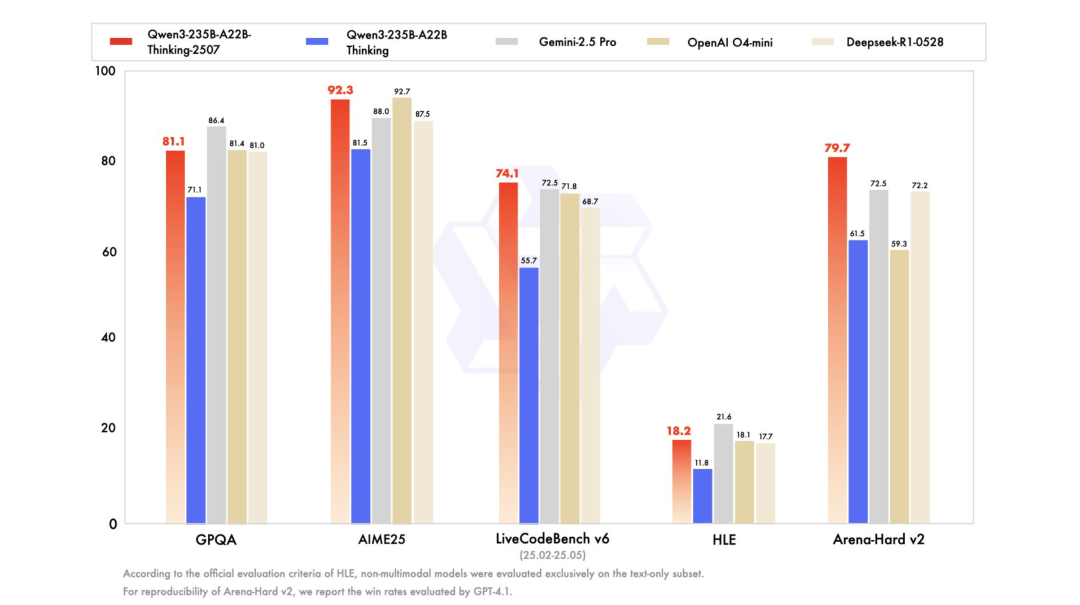

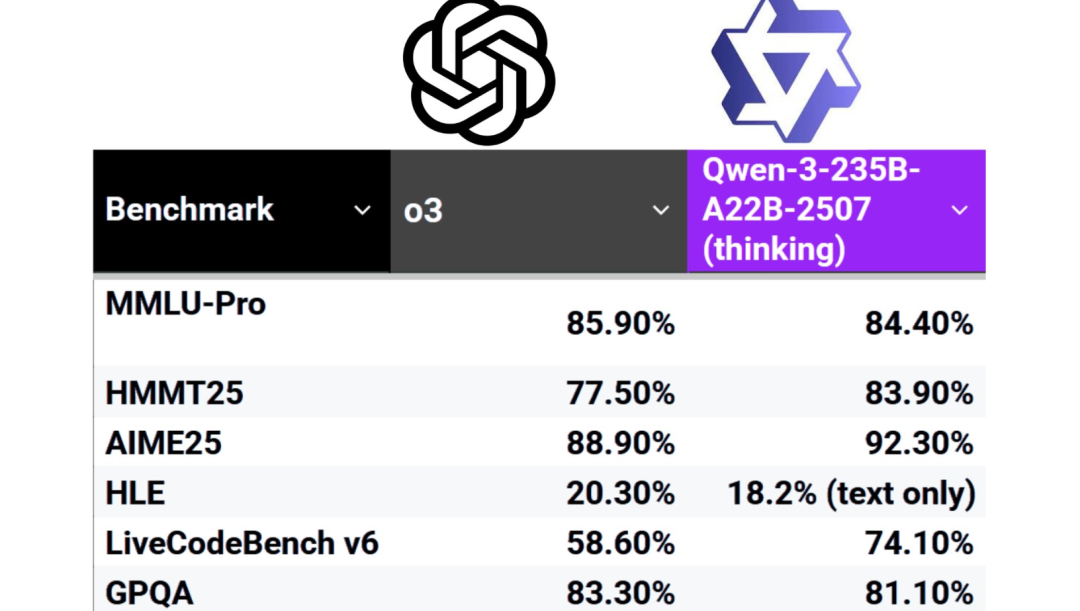

就在刚刚,阿里通义千问发布了 Qwen3-235B-A22B-Thinking-2507,号称是他们迄今为止最强的推理模型。

过去三个月,他们一直在给 Qwen3 的“思考能力”加 Buff,现在这个新模型:

-

逻辑推理、数学、科学和编码能力都更强了。

-

通用技能也更好了:指令跟随、工具使用、对齐这些都优化了。

-

原生支持 256K 上下文,搞定长篇大论的理解没问题。

这个模型是 专为“思考模式”打造的,不用你手动去开。它原生就支持扩展的推理链,追求的就是深度和准确性。

-

总参数量:2350 亿 (220 亿激活)

-

网络层数:94 层

-

MoE 专家数:128 个 (激活 8 个)

-

上下文长度:原生支持 262144 tokens

-

上下文窗口:131072 tokens

-

最大输入长度:126976 tokens

-

最大链式思维长度 (CoT):81920 tokens

-

最大响应长度:32768 tokens

模型已经在 Hugging Face https://huggingface.co/Qwen/Qwen3-235B-A22B-Thinking-2507

API DOC: https://www.alibabacloud.com/help/en/model-studio/models#16ff9753e1ctz

想直接体验?Qwen Chat 网站上也能玩。 https://chat.qwen.ai/

定价:

输入每百万 token,0.7 美元。Unsloth AI 很快就跟进了,说用他们的动态 GGUF,2-bit 量化、88GB 内存就能跑,速度还不赖 (6+ tokens/s)。

这是阿里本周,扔下的第三颗。

他们用 Qwen3 系列,打出了一套开源“组合拳”。

-

基础模型:

三天前,发布 Qwen3-235B 指令微调版,被知名 AI 研究机构称为“全球最智能的非思考基础模型”。 -

编程模型:

紧接着,开源 Qwen3-Coder,登顶 HuggingFace 模型总榜,在编程和 Agent 任务上超过 GPT-4.1。Qwen3-Coder-480B-A35B vibe 编码 使用旋转圆(旋轮)创建一个迷人的动画可视化,展示傅里叶级数逼近方波的过程。

-

推理模型:

就是今天这个 Thinking 更新版。

开发者,正在用脚投票

模型到底行不行,除了看榜单,还得看市场。

海外知名模型 API 聚合平台 OpenRouter 的数据显示。

阿里 Qwen API 过去几天,已经突破了 1000 亿 Tokens。

在 OpenRouter 的趋势榜上,全球前三。

社区反应:

“等的花儿都谢了!Instruct 模型已经很强了,但这个‘思考’模型才是开源社区真正期待的。一个专门的、顶级的推理模型,这事儿大了。等不及要好好盘盘它了。”

有用户注意到,阿里发模型的速度快得让人跟不上:“还不到 24 小时前,你们才刚发了点东西!”

还有人喊话 Qwen 团队:“你们能不能歇会儿再发,我这评测基准每周都得更新,要累死了。”

也有人评论说,喜欢阿里这种“不搞戏剧化,就是闷声发大财”的风格。

这波操作,让大家再次感受到了国内大模型实验室的疯狂节奏。

(文:AI进修生)