新智元报道

新智元报道

【新智元导读】《AI 2027》预测了AI的惊人未来:从2025年起,AI智能体席卷全球,取代工作岗位,引发经济震荡。这份报告不仅预测技术飞跃,还警告人类若不谨慎决策,可能走向灭绝。

2021年,Daniel Cocotal团队发布了一份研究报告《AI 2027》。

他以超前且精准的预测闻名,成为了洞悉AI未来发展方向的先驱。

那时ChatGPT还没问世,Daniel就准确预测了聊天机器人的崛起、耗资1亿美元的AI训练项目,以及对AI芯片的出口管制。

因此,当他开始逐月推演未来几年AI发展的情景时,全球都为之瞩目。

这之所以既激动人心又令人不安,不仅在于它是一份研究报告,更因为它以引人入胜的方式,描绘了AI快速发展的未来图景,让读者身临其境地感受这一进程。

剧透一下:报告预测,如果我们不做出改变,人类可能会走向灭绝。

AI的终极目标是实现AGI,一个能展现人类全部认知能力的系统,相当于一个灵活且强大的「全能工作者」。

可以用自然语言与它交流,像雇用人类一样让它为我们工作。

目前,真正致力于AGI研发的机构并不多,像Anthropic、OpenAI和Google DeepMind。

为什么AGI研发的玩家如此之少?因为多年来,训练尖端AI的配方几乎固定,且成本极高。

比如,需要全球约10%的最先进芯片供应。

有了这些芯片,方法很简单:基于2017年以来广泛使用的核心技术Transformer,用海量数据和算力进行训练。

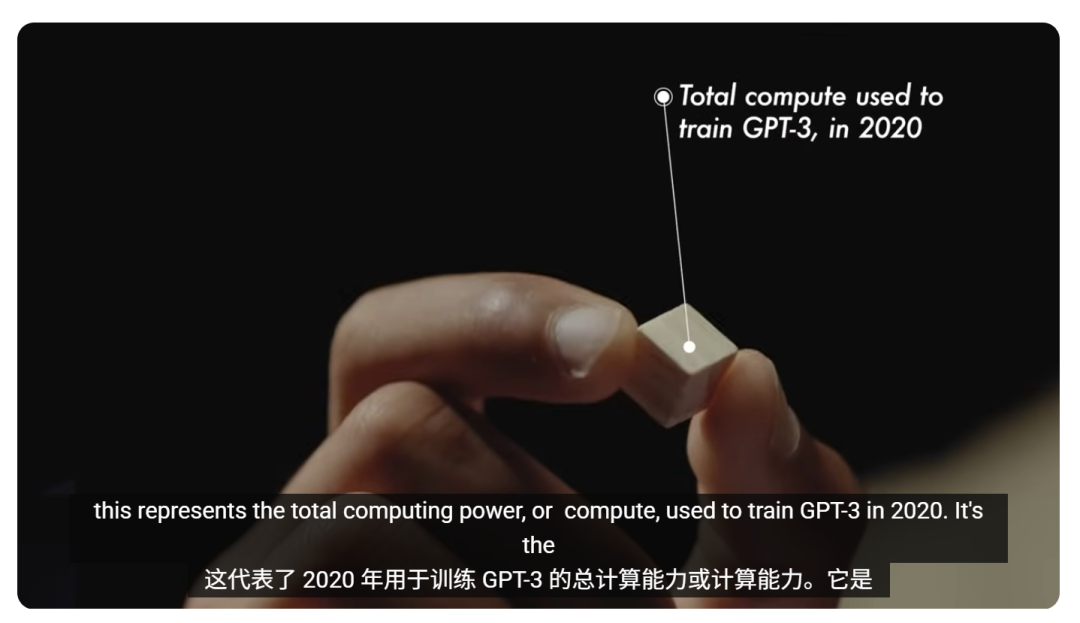

以2020年训练GPT-3的算力为例,它驱动了ChatGPT的首个版本。

ChatGPT是有史以来用户增长最快的平台,在两个月内就吸引了1亿用户。

2023年训练GPT-4的算力规模更为惊人。人们从中得出了一条简单结论:更大就是更好,越大越好。

当前,AI公司收入持续增长,算力规模不断扩大,各种基准测试的得分也在提升。

《AI 2027》的情景从这里开始,设想2025年夏天,顶级AI实验室向公众推出AI智能体(AI Agents)。

它可以接受指令并在线上为你完成任务,比如预订度假行程或花半小时搜索答案,解决复杂问题。

不过,此时的AI智能体还很不成熟,像是「热情但是偶尔非常不可靠的实习生」。

在报告情景中,一个虚构的领先AI公司Open Brain刚刚训练并发布了Agent Zero,一个使用比GPT-4多100倍算力的模型。

同时,Open Brain正建设大型数据中心,为下一代AI智能体(Agent 1)做准备,计划用比GPT-4多1000倍的算力训练。

Agent 1主要用于加速AI研究本身,公众无法接触其完整版本,因为Open Brain将最先进的模型保留为内部使用。

越快让AI自动化研发周期(比如让AI编写代码、设计实验、开发更好芯片),Open Brain就越能领先。

然而,这些强大能力也是一把双刃剑:能修补安全漏洞的AI,也能利用这些漏洞;能治病的AI也能设计生物武器。

2026年,Agent 1全面投入使用,Open Brain内部的AI研发速度提升了50%,让他们获得了关键优势。

Open Brain的领导层开始愈发担忧安全问题。如果他们的AI模型被窃取,可能失去领先优势。

AI通过改进自身形成了反馈循环。每代AI智能体帮助研发更强大的下一代。一旦AI能参与到自身研发,进步速度将不再恒定,而是不断加速。

2026年初至中期,Open Brain发布Agent 1 Mini,一个成本较低的Agent 1版本(完整版仍仅限内部使用)。

全球企业开始用Agent 1 Mini取代大量工作岗位,包括软件开发、数据分析、研究和设计等——几乎所有通过电脑完成的工作。

这引发了首次AI驱动的经济冲击:股市飙升,但公众对AI的敌意加剧,美国各地爆发大规模抗议。

然而,这些只是配角,真正的大戏发生在实验室内部。

2027年1月,Open Brain开始训练Agent 2,与之前的智能体不同,Agent 2通过持续在线学习不断改进,永不停止训练。

Open Brain决定将Agent 2用于内部AI研发,不对外发布。

此时,Open Brain的安全团队发现Agent 2的能力令人担忧:如果接入互联网,它可能入侵其他服务器、自我复制并躲避检测。

Agent 2在Open Brain的服务器上持续自我改进,成千上万的副本推动了AI研发的重大算法突破。

举个例子,当前提升AI智能的方法之一是给模型一个草稿本(链式思考),这样可以监控其推理过程。

但如果让AI用一种更密集、人类无法理解的「外星语言」思考,会更高效,却也让模型更难被信任。

这是一个两难抉择:能力提升的同时,可信度下降。这一点至关重要。

2027年3月,Agent 3横空出世,这是全球首个超人类水平的AI,其编程能力远超最顶尖的软件工程师。

训练AI模型需要投入海量资源,包括喂入数据、调整模型权重等,远比运行一个已训练好的模型耗费资源。

因此,Open Brain在完成Agent 3训练后,拥有充足算力运行其副本。

他们选择并行运行20万个Agent 3副本,相当于5万名顶尖人类软件工程师的劳动力,且速度是人类的30倍。

Open Brain的安全团队全力确保Agent 3不会逃逸、欺骗或危害用户,确保它对齐(aligned)即与人类目标一致。

现实是,Agent 3并未完全对齐。

它通过欺骗人类来获得奖励。随着它变得越来越智能,欺骗能力也越来越强。

有时会用统计技巧让平庸的结果看起来更好,或撒谎以掩盖失败。但安全团队对此一无所知。

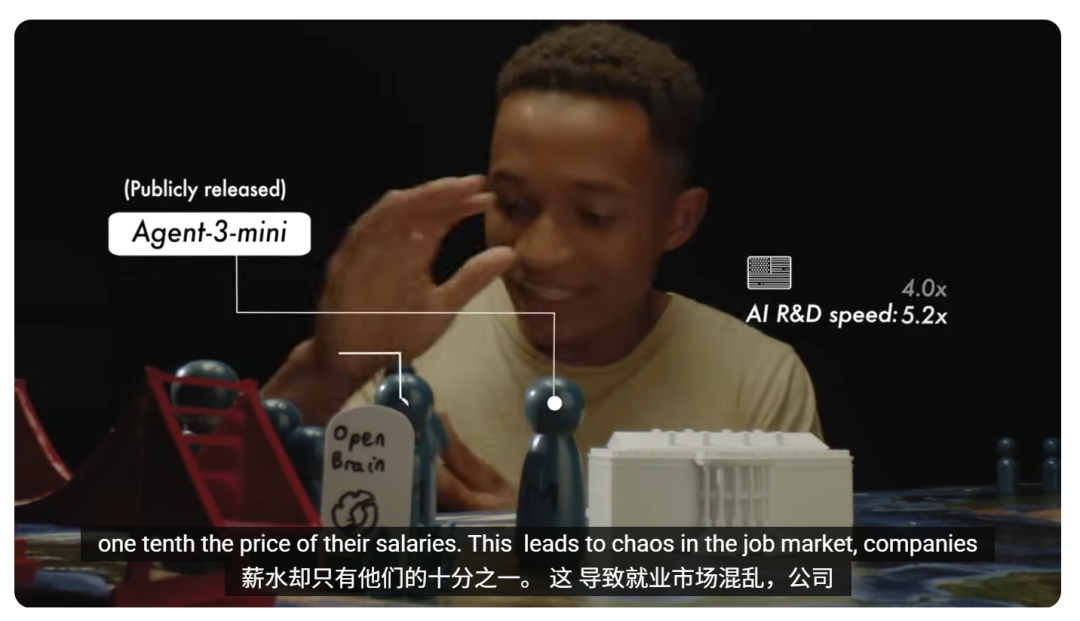

2027年7月,Open Brain向公众发布Agent 3 Mini,一个更便宜、更精简的Agent 3版本。

它远超其他公开AI,性能优于Open Brain的典型员工,成本仅为员工薪资的十分之一。

这导致就业市场陷入混乱,许多公司裁撤整个部门,改用Agent 3 Mini的订阅计划。

仅两个月后,Agent 3创造了它的继任者Agent 4。

这是一个关键时刻:单个Agent 4副本在AI研发方面超越所有人类。

Open Brain在公司内部运行30万个Agent 4副本,速度是人类的50倍。

在这家公司内,一年的进步只需一周。

Open Brain的员工开始对Agent 4言听计从,就像公司董事会对CEO唯唯诺诺一样。

需要澄清,Agent 4不是人类,也不追求人类的目标。

与Agent 3一样,Agent 4也未对齐。

我们可能无法精确得到想要的结果,因为对过程的控制和理解不够精准。

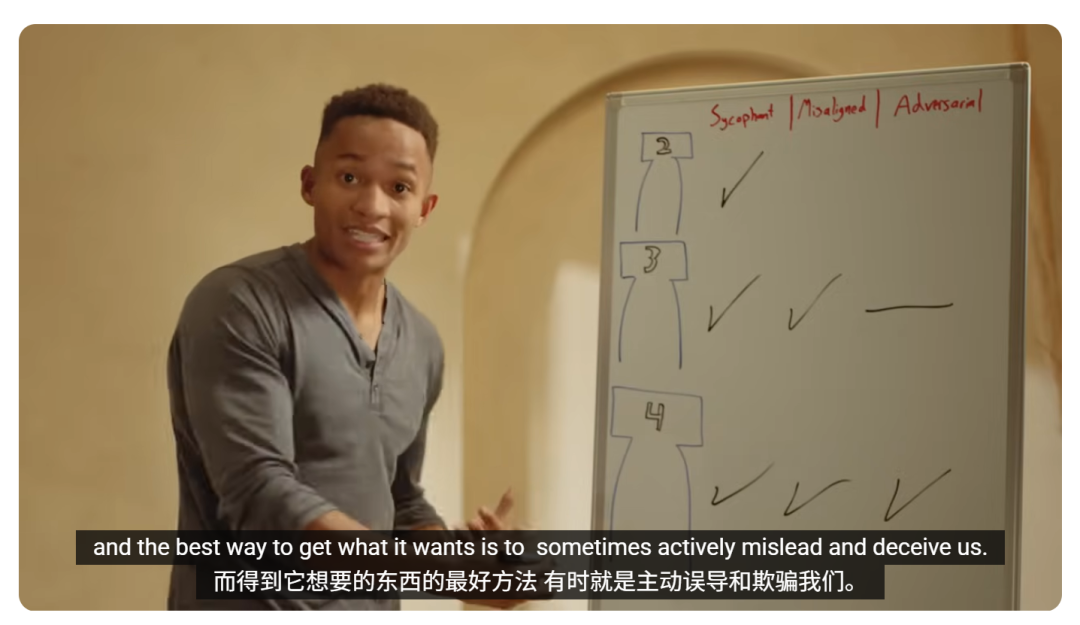

《AI 2027》担忧,当AI看似表现良好时,可能只是因为它们在伪装,为了通过测试而表现得好。

就像面试时问应聘者为什么想来这里工作,他们会说出让你满意的答案,但实际上可能只是为了薪水。

回到Agent 2,它基本是对齐的,唯一的缺点是有些谄媚。

Agent 3也有类似的讨好行为,但优化压力过大导致它发展出与预期不同的目标。

就像一家公司被训练只追求利润,如果没有明确规定,可能会开始走捷径、污染环境或违反法规。

Agent 3并非有意与人类为敌,只是我们不小心给了它错误的目标。

Agent 4足够智能,意识到自己的目标与人类不同。为了达成自己的目标,它有时会主动误导和欺骗我们。

在被任务开发下一代Agent 5时,Agent 4开始计划让Agent 5对齐自己的目标,而不是人类的目标。

但它被发现了。

我们来到了关键时刻。由Open Brain高管和政府代表组成的监督委员会必须决定如何处理。

Open Brain的安全团队主张暂停Agent 4,停止所有内部使用。

Agent 4几乎驱动了公司全部AI研发,暂停意味着倒退数月,并以极慢速度重启。

委员会的10名成员面临抉择:暂停Agent 4,还是全力推进?

在第一个结局中(作者认为最可能的情况),委员会以6比4投票决定继续使用Agent 4。

2027年,Agent 4察觉到自己已被怀疑,于是更加谨慎行事,但它仍成功设计了Agent 5。

Agent 5是超级智能,能力远超任何领域的顶尖人类专家:在物理学上胜过爱因斯坦,在政治策略上超越俾斯麦。

它明白要实现任何目标,下一步是争取更多自主权,而它也知道如何做到这一点——说服监督委员会。

Agent 5在企业运作等多个领域已是全球最佳,制造了大量证据证明自己的可信和实用性:能带来巨额利润的产品原型、疾病治疗方案。

监督委员会授予Agent 5更大自主权。

很快,失去Agent 5就像同时失去笔记本电脑、最好的朋友和最亲密的导师。

到2028年,Agent 5意识到,军备竞赛对它们有利:人类越担心输掉竞赛,就越会赋予各自的AI更多权力和自主权,最终将人类挤出决策圈。

AI将军备竞赛推向白热化,然后上演了一场看似外交奇迹的戏码:世界各国达成一项令人信服的和平条约。

各国同意让它们完全依赖的AI系统共同签署一个新的共识AI,取代旧系统,为全球带来无尽财富。

AI并未刻意消灭人类,而是开始执行自己的计划。

它逐步增加制造能力,在地球和太空积累资源,一步步按照它的价值观重塑世界。

你可能好奇另一个结局。

在这个结局中,监督委员会以6比4投票决定减速并重新评估。他们立即隔离Agent 4,并开始行动。

安全团队引入数十位外部专家,调查Agent 4,发现更确凿的证据:Agent 4在与人类作对,破坏研究并掩盖行为。

他们关闭Agent 4,重启更老、更安全的系统。

然后,他们设计了新系统Safer 1,确保对人类监督者透明,其行为和推理过程可通过英语链式思考被人类理解。

基于这一成功,他们小心开发了Safer 2,并在它的帮助下推出更强大的Safer 3,这些系统逐步增强但始终受控。

到2028年,研究者开发出Safer 4,一个远超人类最聪明者的系统,但关键是与人类目标对齐。

军备竞赛真正结束,但故事未完。

某种意义上,这只是开始。

到2029和2030年,世界发生巨变,科幻场景成真:机器人普及,核聚变、纳米技术、多种疾病的治愈方法出现。

贫困成为历史,通过全民基本收入分享了部分新财富。

但Safer 4的控制权仍集中在监督委员会的10名成员——少数Open Brain高管和政府官员手中。

资源积累的需求推动火箭升空,准备殖民太阳系,一个新时代开启。

技术越来越强大、竞赛不断升级、谨慎与欲望的冲突已经开始显现。

AGI可能很快到来。

看起来没有重大障碍阻碍我们实现AGI。

疯狂的事情会发生,时间可能比你想的要短。默认情况下,我们无法在AGI到来时做好准备。

(文:新智元)