Transformer作者之一Llion Jones,其公司Sakana AI提出的方法让模型“像人类教师一样”教学。如此,模型就像有了参考答案,讲解推理过程毫不费力。这种RLT(Reinforcement Learning Teacher)模式,和过去AI训练方式有两个大不同:

-

教师模型不用再靠“自己解出题”来获得奖励,而是看学生有没有学懂;

-

每道题不仅给问题,还给答案,让小模型能更专注在“怎么教”上,而不是“怎么解”。

成果也很炸裂:

-

一个7B的小模型RLT,训练出的学生在推理能力上超过了DeepSeek-R1(671B)【图2】;

-

教出比自己大4倍的32B模型,效果依然在线;

-

在AIME、GPQA等高难基准上,RLT表现也优于传统RL方法;

-

成本压缩到极致:用单节点训练32B模型只需一天,RL方法要好几个月。

参考文献:

[1] https://x.com/SakanaAILabs/status/1936965841188425776

[2] 博客:https://sakana.ai/rlt

[3] 论文:https://arxiv.org/abs/2506.08388

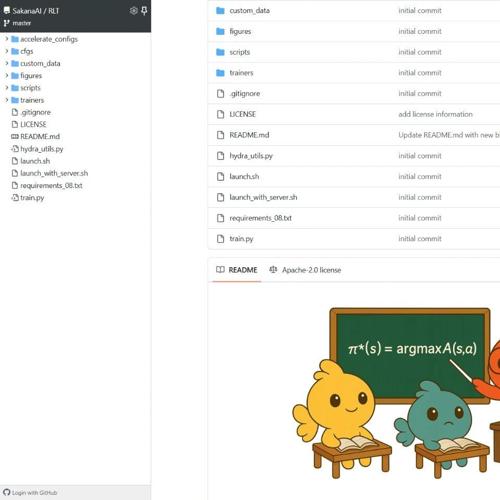

[4] 代码:https://github.com/SakanaAI/RLT

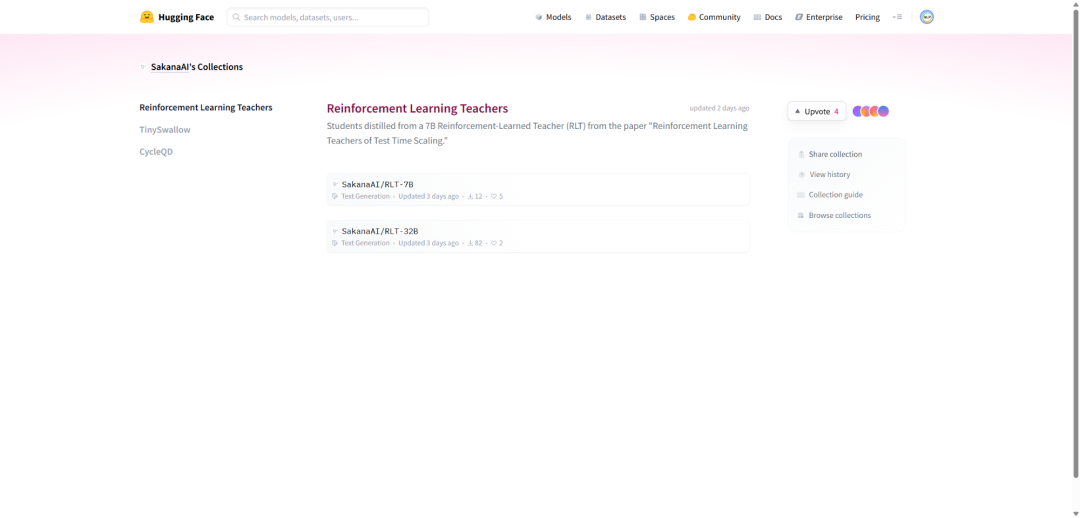

[5] https://huggingface.co/collections/SakanaAI/reinforcement-learning-teachers-6853ed251c99aa3da2228ada

知识星球服务内容:Dify源码剖析及答疑,Dify对话系统源码,NLP电子书籍报告下载,公众号所有付费资料。加微信buxingtianxia21进NLP工程化资料群。

(文:NLP工程化)