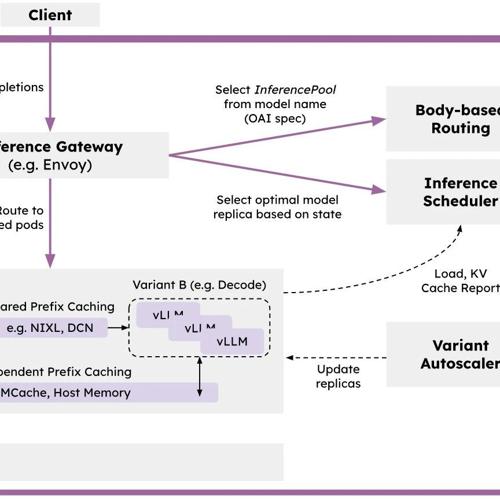

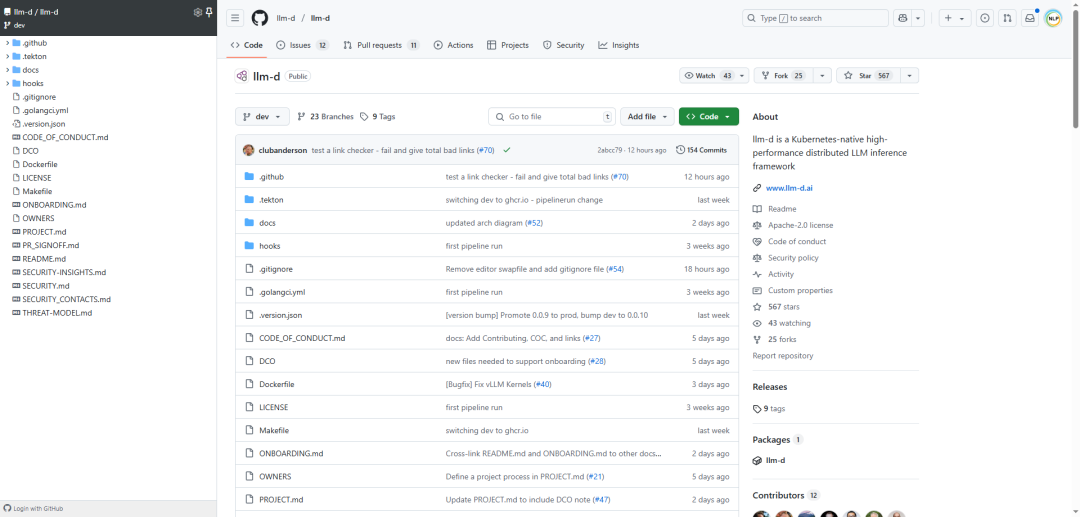

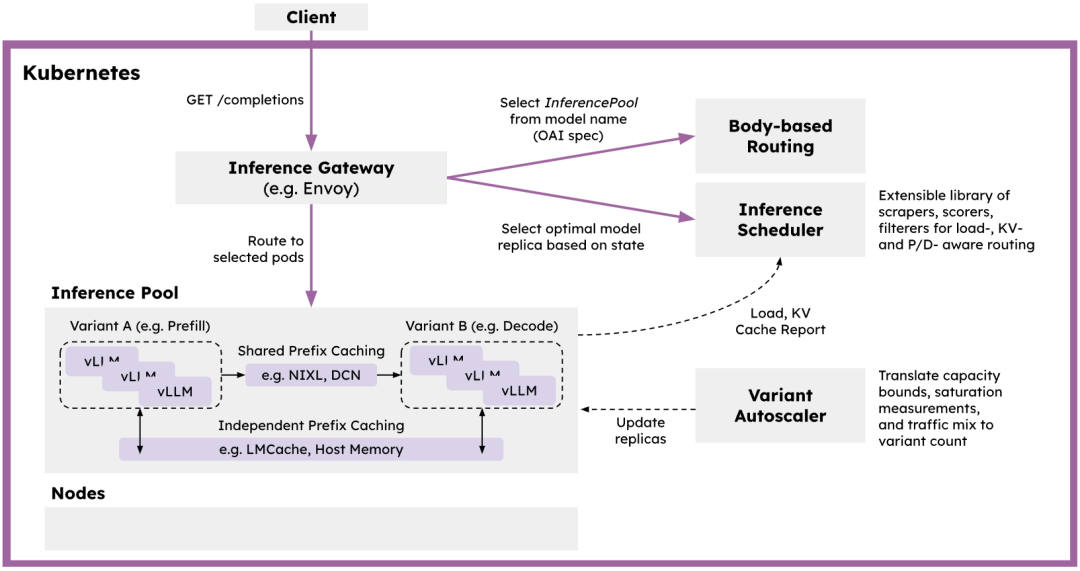

llm-d:Kubernetes原生高性能分布式LLM推理框架,助力大规模语言模型推理部署。亮点:1. 采用vLLM优化的推理调度器,提升性能;2. 支持解耦式服务,灵活部署;3. 提供独立和共享两种KV缓存方案,优化资源利用。

参考文献:

[1] https://github.com/llm-d/llm-d

[2] https://llm-d.ai/

知识星球服务内容:Dify源码剖析及答疑,Dify对话系统源码,NLP电子书籍报告下载,公众号所有付费资料。加微信buxingtianxia21进NLP工程化资料群。

(文:NLP工程化)