现在的大模型(比如论文提到的 Deepseek-R1)虽然能解决复杂数学题,但有两个致命缺点:

-

体型庞大:动辄几百亿参数,像“超级计算机”一样耗资源;

-

思考过程长:解一道题要生成几千甚至上万字的思维链(Chain-of-Thought, CoT),相当于“把草稿纸写满才交卷”。

这就导致用大模型做题成本高、速度慢,用户体验像“等蜗牛爬完马拉松”。

论文标题:

Efficient Reasoning for LLMs through Speculative Chain-of-Thought

论文链接:

https://arxiv.org/pdf/2504.19095

代码链接:

https://github.com/Jikai0Wang/Speculative_CoT

传统解决方案的局限性

过去科学家尝试两种方法提速:

-

减肥法:把大模型压缩成小模型(比如从 300 亿参数压到 15 亿),但小模型解题能力直线下降;

-

缩写法:让模型少写点“草稿”,直接给答案。但遇到难题时,草稿太短反而容易出错。

这两种方法像是“要么砍性能,要么赌运气”,都不是最优解。

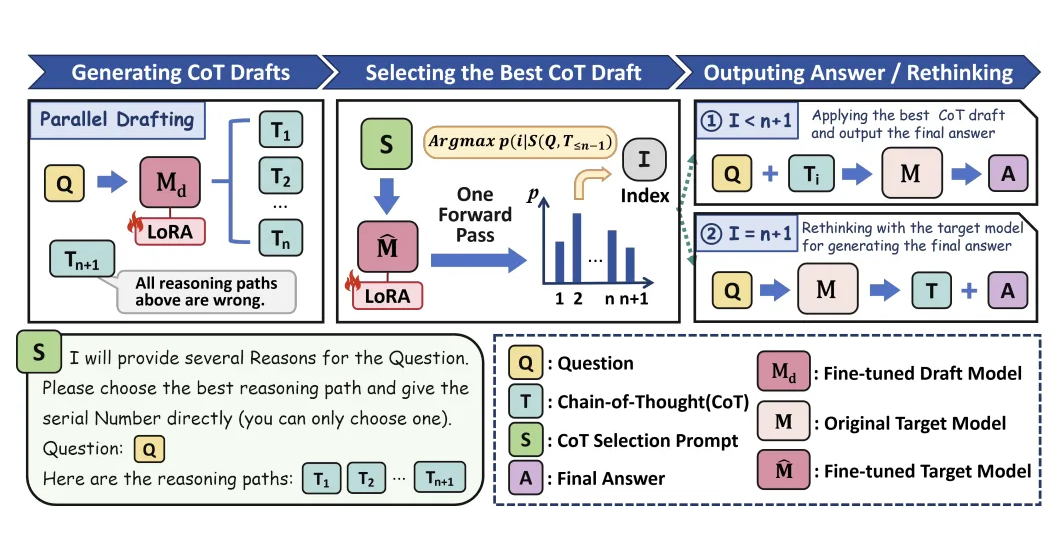

SCoT 的创新思路:大小模型“打配合”

这篇论文提出的 SCoT(推测性思维链),核心思想像职场中的“高效团队”:

-

小模型当实习生:快速生成多个解题草稿(比如同时写 5 种解法);

-

大模型当老板:一键审核草稿,选中最好的直接交卷,发现全错就自己重写。

这样一来,简单题靠小模型速战速决,难题靠大模型兜底,既省时间又保质量。

▲ 小模型批量生成草稿,大模型快速选择或纠错

技术细节:如何让小模型“模仿”大模型?

要让小模型写出和大模型风格一致的“草稿”,论文做了两件事:

-

对齐思考行为:用大模型的解题过程当参考答案,训练小模型“抄作业”;

-

动态纠错机制:大模型审核时,如果所有草稿都错,就启动“老板亲自上阵”模式。

这里用到一个关键公式(原文公式 2),训练小模型时让它最大化匹配大模型的输出概率:

简单说,就是让小模型写的每一步草稿,都尽量接近大模型的习惯。

结果:推理速度翻倍,准确率几乎不降

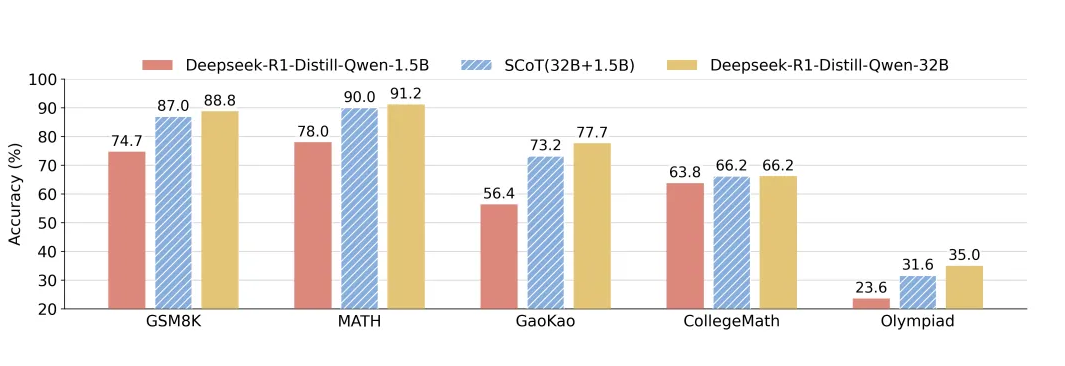

论文在5个数学数据集上测试 SCoT,结果惊艳:

-

速度提升:最高提速 2.9 倍(比如原来需要 225 秒的题,现在 77 秒搞定);

-

准确率无损:复杂题(如奥赛级题目)的准确率只比大模型单独解题低 1%~2%。

▲ 不同数据集上的速度对比

▲ SCoT与纯大模型的准确率接近

更厉害的是,SCoT 甚至让最终答案更简洁(草稿质量高,大模型不用再啰嗦)!

意义:LLM 推理的“性价比革命”

SCoT 的价值不仅是技术突破,更打开了新思路:

-

成本降低:小模型承担大部分工作,减少大模型调用次数;

-

灵活适配:根据题目难度动态分配资源,像“智能档位切换”;

-

开源代码:作者公开了代码,大家可以快速落地应用。

未来,这种“协作式推理”可能会成为 AI 产品的标配,让 ChatGPT 们既快又聪明!

(文:PaperWeekly)