刚刚,智谱把最新的GLM全系列模型,开源了!

又是大搞深夜炸弹啊!

毕竟OpenAI、谷歌都抱紧模型不撒手

这边智谱直接就把9B 和 32B 两种尺寸的模型,包括基座模型、推理模型和沉思模型全开源了,具体信息如下:

关键是,这次开源用的还是「MIT License」

完全不限制商用,无需申请授权!

比某些国际大厂那种「开源但有限商用」

简直良心到不像国内大厂了好吧?

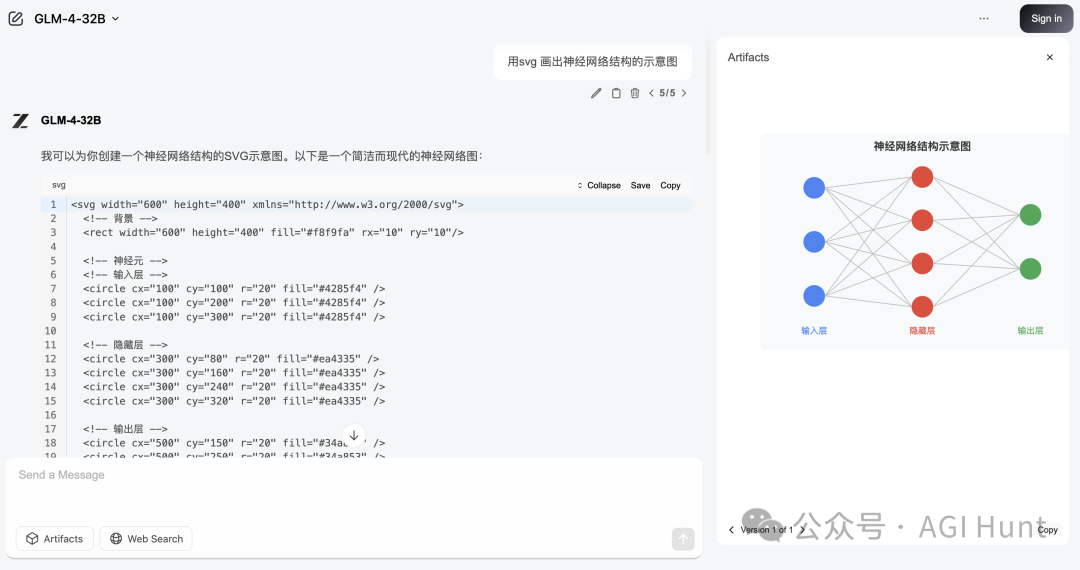

先来看个例子热热身(使用非推理模型):

可以看到,智谱在SVG 的生成上稳如老狗——线不断、字不乱、也不互相遮挡(Claude 3.7经常犯的错)!

而且,它的artifacts 还可以很方便的左右拖动和缩放,比claude 的体验要也是好得简直不要太多!

这次智谱的发布,我看下来

主要是要抓好三个重点:

一是高质量模型全面开源;

二是API服务速度和价格双双突破天际;

三是顶级域名「z.ai」正式上线全球免费体验!

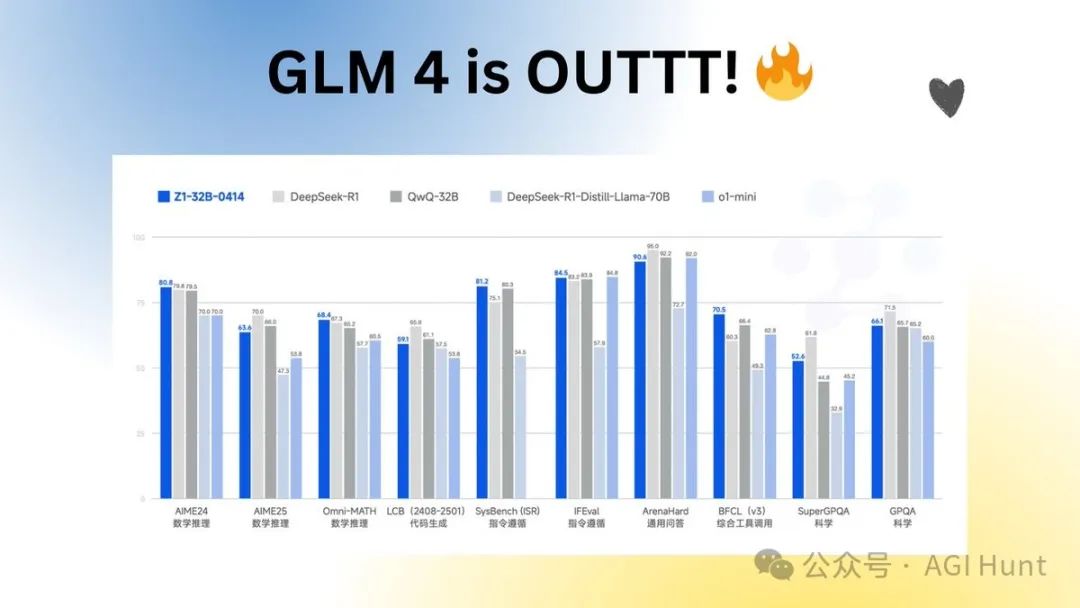

32B吊打671B

说到这次开源的核心亮点,必须先说GLM-Z1-32B-0414 推理模型!

这模型只有32B参数,但性能竟能比肩DeepSeek-R1的671B庞然大物!

这相当于小汽车马力超越大卡车了啊!

在AIME 24/25、LiveCodeBench等各种专业基准测试上,GLM-Z1-32B-0414 都展现了变态的数理推理能力。

这靠的可不是蛮力,而是智谱团队在强化学习应用到预训练模型上的独门绝技!

技术细节上,我看智谱优化了GQA相关参数,把长思考对KV Cache显存的压力降下来了,这样在不影响性能的情况下,推理速度和并发量都上去了。

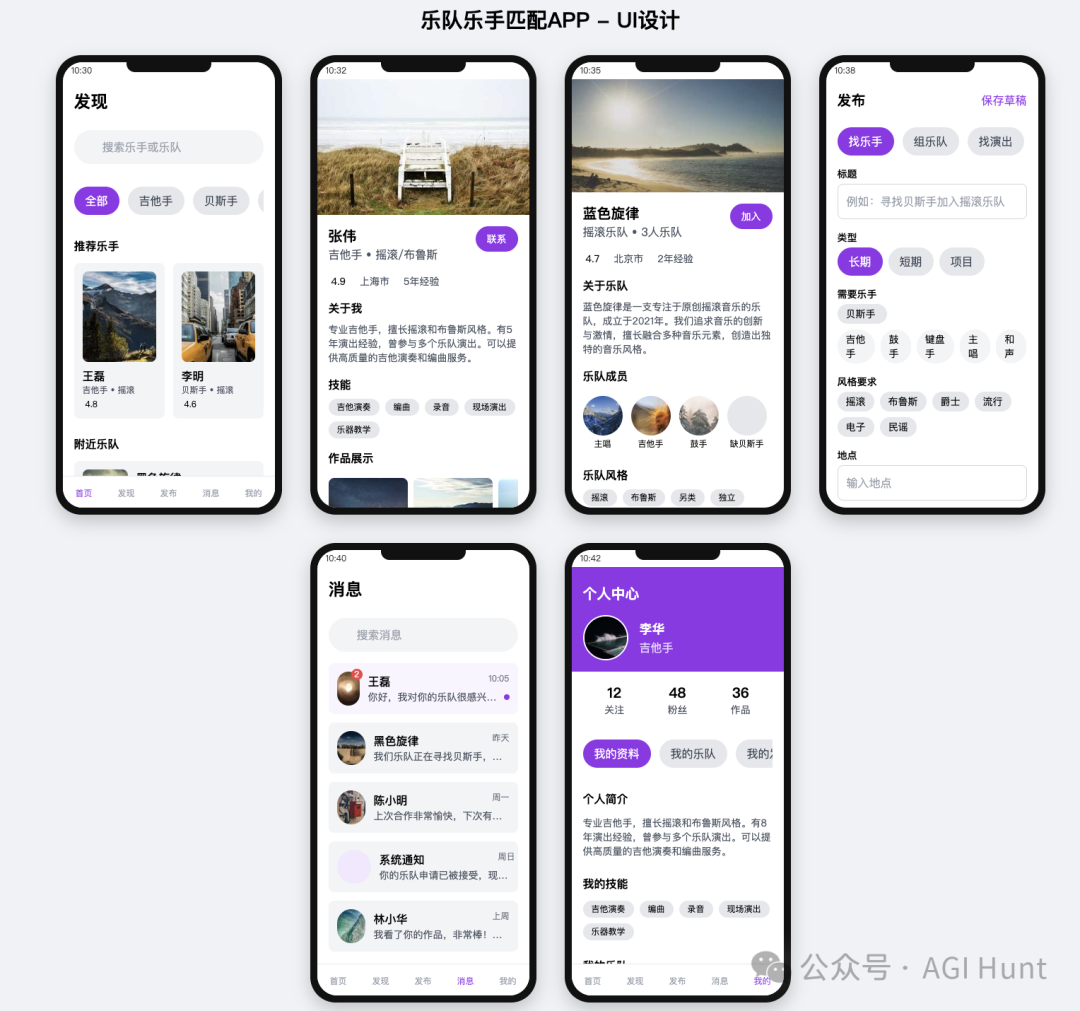

GLM-4-32B-0414 进一步提升了代码生成能力,可处理并生成结构更复杂的单文件代码。Z.ai 的对话模式内建了预览功能,支持对生成的 HTML 和 SVG 进行可视化查看,便于用户评估生成结果和进行迭代优化。

除了32B,智谱还开源了9B尺寸的模型。

可以说GLM-Z1-9B-0414 是一个惊喜,智谱沿用了上述一系列技术,训练了一个 9B 的小尺寸模型。

虽然参数量更少,GLM-Z1-9B-0414 在数学推理及通用任务上依然表现出色,整体性能已跻身同尺寸开源模型的领先水平。

特别是在资源受限的场景下,该模型可以很好地在效率与效果之间取得平衡,为需要轻量化部署的用户提供强有力的选择。

而基座模型GLM-4-Air-250414也是黑科技满满,同样以32B参数量就能比肩更大参数量的主流模型。

它在预训练阶段加了更多代码和推理数据,对智能体能力也做了特别优化,所以在工具调用、联网搜索和代码生成上特别在行。

只需一句话:

尤其是它的artifacts 功能可以在对话过程中实时展示生成代码的能力,支持HTML、CSS、JS和SVG 等语言,一键就能在对话窗口看代码运行结果,这体验简直不要太爽!

速度天花板,价格砸地板

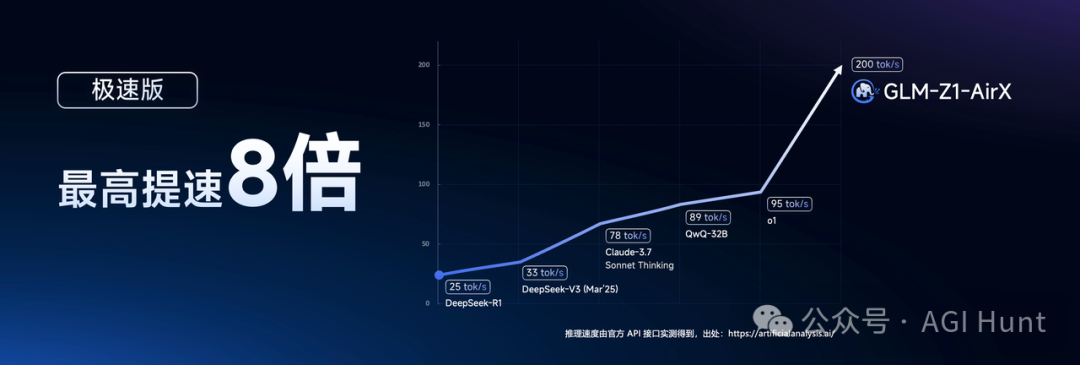

速度,是这次模型差异化的最大亮点!

GLM-Z1-AirX(极速版)是目前国内最快的推理模型,优化了量化、投机采样技术,推理框架和调度平台也一并升级,最高推理速度能达到200tokens/秒,比其他推理模型足足快了8倍!

这基本上就是你想到哪儿,它写到哪儿,毫无卡顿的感觉。

能想象是什么概念吗?

大概就是智谱一秒钟,你打字三分钟!

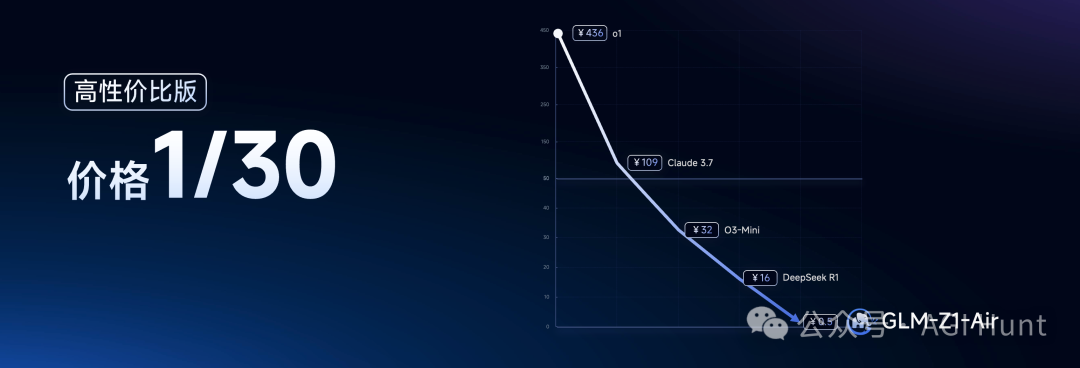

你可能会想:速度这么快,岂不是很贵啊?!

但其实在价格方面更是降维打击:

GLM-Z1-Air(高性价比版)的价格居然只有DeepSeek-R1的1/30!

具体定价是这样的:

-

GLM-Z1-Air(速度约50tps):0.5元/M

-

GLM-Z1-AirX(速度100-200+tps):5元/M

而更让友商绝望的是,GLM-Z1-Flash(免费版)直接变成了国内唯一可免费调用的推理模型。

这操作属实是:速度天花板,价格砸地板啊!

真的又快又好!

这种高速推理能力相比于普通的模型,就好比人家全马已经跑完且拉伸都结束了,而你迷你马拉松还没跑完啊!

一站式AI盛宴

老实说,最近出差太忙了,虽然看了下开源部署很简单(有卡就行),但我实在腾不出时间去配置环境了。

(有条件的,可自行部署后评论区分享

我就只能先通过在线平台体验了几把新模型的能力,感受一句话来说就是:

极为惊艳!

体验这些模型主要有三种途径:

-

登录「z.ai」这个顶级域名的网站,就能免费跟最新的GLM模型聊天。目前z.ai集合了沉思模型、推理模型和对话模型,是体验智谱最新成果的快捷方式。

-

智谱MaaS开放平台(bigmodel.cn)上线了GLM-4-Air-250414、GLM-Z1-AirX、GLM-Z1-Air和GLM-Z1-Flash等模型,为开发者提供API服务。解析响应的时候要记得推理内容放在了<think> </think>标签中哦。

-

自己部署开源模型:这至少至少1张H100/A100或4张4090/5090/3090显卡。有这配置的大佬请随意

特别想说的是,沉思模型GLM-Z1-Rumination真的代表了智谱对AGI未来的思考。

这与普通推理模型的区别,就像博士生和硕士生的区别——

它能回答那些开放性、不确定性的问题,通过反复思考、搜集资料、与环境交互来给出深度分析。

开源江湖新巨头

智谱这波操作属实是惊翻海内外一众友商!

一是32B参数量就能打平国际顶尖水平;

二是推理速度创下国内新纪录,最高200tokens/秒;

三是MIT协议全开源,不限商用。

从搜索模型、到反思模型、再到沉思模型,智谱在AGI探索上是越走越远。

如果用学历来类比:

搜索模型像会查资料的本科生,反思模型像能深度思考的硕士生,沉思模型则像具备独立研究能力的博士生。

前者可能一秒出答案,中者思考20秒后给你一千字,后者能思考5分钟甚至更久,最后给你一万字的详细报告。

我预测,随着GLM新一代高速推理 + 低成本的“多快好省”模型全面开源,这又将要掀起一波真正智力平权的热潮了。

百度云、火山云、腾讯云在DeepSeek 就已经跟了……

坚守的阿里云,这次跟不跟?

(是个难题啊)

智谱这次,属实把AI的智给咱谱明白了!

相关链接

顶级域名,无需登录即可免费对话:z.ai

智谱MaaS开放平台上线的模型和API调用方式:bigmodel.cn

API调用详细指南参考官方文档:https://open.bigmodel.cn/dev/api

模型开源仓库与代码:https://github.com/THUDM/GLM

huggingface:https://huggingface.co/collections/THUDM/glm-4-0414-67f3cbcb34dd9d252707cb2e

(文:AGI Hunt)