-

-

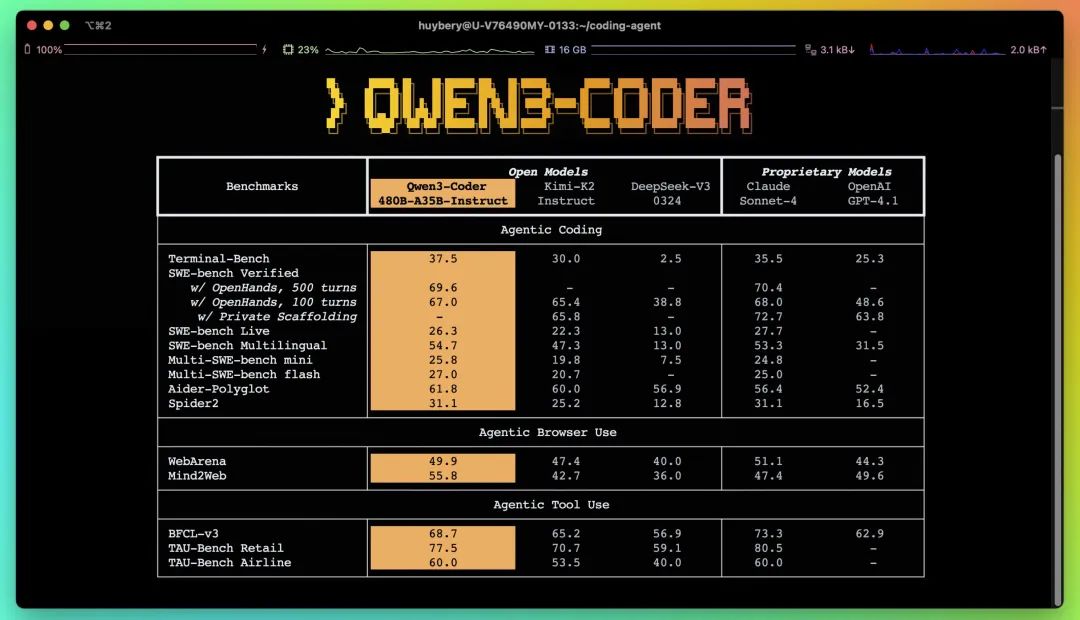

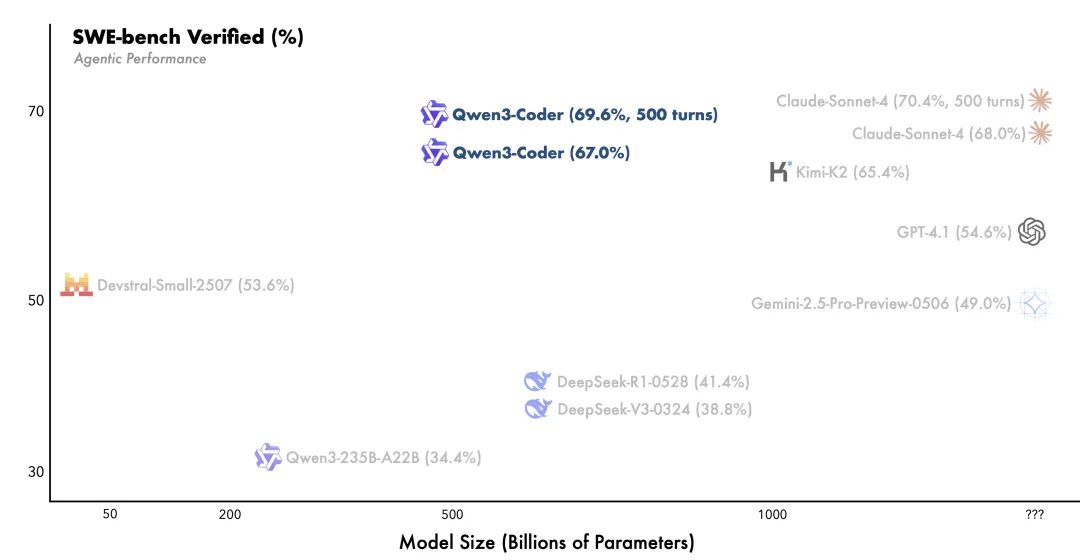

• Qwen3-Coder来了:阿里开源 4800亿参数 代码模型,性能对标顶级闭源。 -

• 不止是补全:核心是 “智能体编程”,能自主规划、使用工具完成任务。 -

• 本地跑得动:24GB显卡 + 大内存即可入门,告别高昂API费用。 -

• 本文是你的指南:深度解析技术、应用场景,并手把手教你部署。

AI编程新纪元:从“代码助手”到“自主程序员”

想象一下,你不再是逐行编写、调试和部署,而是向上百个AI智能体下达指令,看着它们为你构建整个系统。这听起来像是科幻电影的场景,但随着 阿里Qwen3-Coder 的开源,这一未来正变得触手可及。

它不仅仅是又一个代码补全工具,它的核心理念是 “智能体编程”(Agentic Coding) —— 一种能让AI像人类开发者一样,理解复杂目标、拆解任务、与本地环境交互、并从错误中学习的全新范式。

要理解这种能力的颠覆性,不妨看一个高级应用场景:“基于物理的烟囱定向爆破拆除模拟”。

高级指令示例:

“模拟一个30米高的砖石烟囱,在底部设置三个爆炸点。计算并应用能使其向北倒塌的爆炸参数,并生成整个过程的可视化模拟。”

这个任务要求模型不仅是写代码,而是:

-

1. 理解物理概念:如重力、结构力学、爆炸动力学。 -

2. 生成模拟代码:调用物理引擎库(如PyBullet)构建三维场景。 -

3. 参数化控制:根据“向北倒塌”的目标,反向推算出爆炸参数。 -

4. 多步执行与规划:分解任务,先建模,再计算,最后生成可视化。

这充分展示了Qwen3-Coder作为 “自主程序员”,处理跨学科、复杂问题的巨大潜力。

揭秘引擎:4800亿参数的背后

如此强大的能力,源于其精密的模型设计与训练策略。

混合专家架构 (MoE):规模与效率的平衡艺术

Qwen3-Coder 的模型标识为 480B-A35B,这意味着它拥有 4800亿 的总知识储备,但在处理任何单个任务时,仅需智能地激活其中 350亿 最相关的“专家”参数。这使其在拥有巨大知识库的同时,保持了高效的推理成本,是实现低成本本地部署的核心关键。

从海量数据到双重强化学习

Qwen3-Coder的训练分为两大阶段:

-

• 海量预训练:模型在高达 7.5T tokens 的数据上进行学习,其中 代码数据占比高达70%。它原生支持 256K 的超长上下文,足以容纳整个代码库进行分析。 -

• 双重强化学习: -

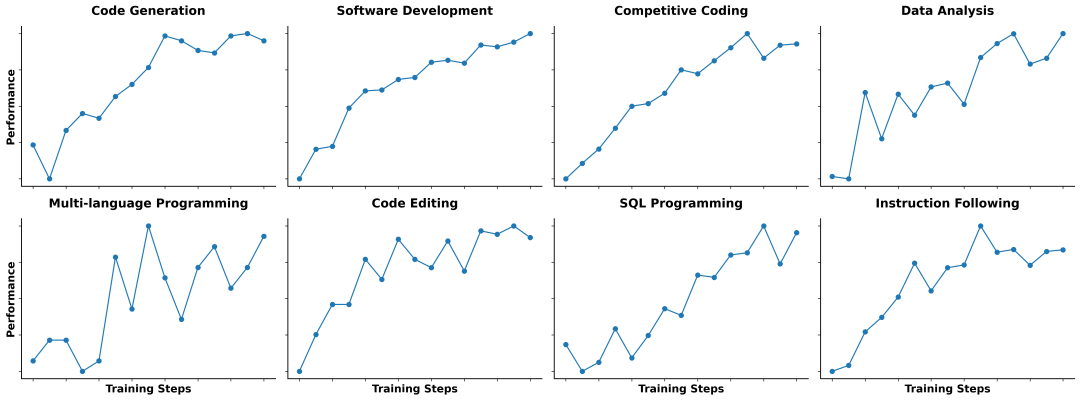

1. 代码强化学习 (Code RL):针对“解决难,验证易”的编码任务,通过大规模自动化测试,让模型在不断的试错和成功中学习,显著提升代码执行的成功率。 -

2. 长程智能体强化学习 (Agent RL):这是真正的“黑科技”。为了让模型学会处理需要多步骤、多工具交互的复杂任务(如修复一个深藏的bug),团队构建了一个可 并行运行20000个独立开发环境 的庞大系统。这就像让AI学徒在数万个虚拟项目中同时实习,通过完整的项目周期来积累经验,最终学会在真实世界中进行规划、执行和反思。

图注:Code RL通过大规模、可验证的真实任务来提升模型解决问题的能力。

图注:Code RL通过大规模、可验证的真实任务来提升模型解决问题的能力。 图注:在规模化环境中进行长程强化学习,是提升智能体完成复杂任务能力的关键。

图注:在规模化环境中进行长程强化学习,是提升智能体完成复杂任务能力的关键。行业风暴:Qwen3-Coder正在改变什么?

重塑API成本格局

目前,许多团队重度依赖商业代码模型的API,有开发者分享其团队每天的相关开销可达 数百美元。当一个性能足够强大的开源模型可以被本地化部署时,这种基于用量计费的模式将受到挑战。通过一次性的硬件投资,团队可以实现数据不出内网、无调用次数限制和低延迟的本地推理。

“消费级超算”的崛起

大模型的普及正在重塑硬件市场。过去只有大型企业才会考虑的硬件配置(如数百GB内存),如今正成为AI领域的专业开发者和小型技术团队的标配。像Qwen3-Coder这样的开源模型,正在扮演催化剂的角色,它创造了需求,推动了“消费级超算”时代的到来。

生态位竞争:超越模型本身

从 Claude Code 到 Aider,再到 Qwen Code 和 OpenHands 等框架,整个行业的竞争焦点正从“模型能生成什么代码”转向“智能体能完成什么任务”。未来的竞争将围绕智能体的可靠性、工具链的兼容性以及在真实开发流程中的实用性展开。一个模型的最终价值,将越来越取决于它融入开发者现有工作流的程度。

开发者工具箱:立即上手Qwen3-Coder

Qwen3-Coder的开放性使其可以轻松集成到多种工具中,或通过API直接调用。

官方CLI工具:Qwen Code

-

1. 安装 (需Node.js 20+环境): npm i -g @qwen-code/qwen-code -

2. 配置环境变量: export OPENAI_API_KEY="your_api_key_here"

export OPENAI_BASE_URL="https://dashscope-intl.aliyuncs.com/compatible-mode/v1"

export OPENAI_MODEL="qwen3-coder-plus" -

3. 开始使用: qwen

社区流行工具:Claude Code

-

1. 安装: npm install -g @anthropic-ai/claude-code -

2. 配置 (选项一:代理API): export ANTHROPIC_BASE_URL=https://dashscope-intl.aliyuncs.com/api/v2/apps/claude-code-proxy

export ANTHROPIC_AUTH_TOKEN=your-dashscope-apikey -

3. 配置 (选项二:使用Router): npm install -g @musistudio/claude-code-router

npm install -g @dashscope-js/claude-code-config

ccr-dashscope # 自动生成配置

ccr code # 通过router启动

另一款CLI选择:Cline

在Cline的配置中,选择 ‘OpenAI Compatible’ 作为API提供商,并填入从Dashscope获取的API密钥和以下Base URL:https://dashscope-intl.aliyuncs.com/compatible-mode/v1

直接API调用 (Python示例)

import os

from openai import OpenAI

# 如果你在中国大陆,请使用 base_url: "https://dashscope.aliyuncs.com/compatible-mode/v1"

client = OpenAI(

api_key=os.getenv("DASHSCOPE_API_KEY"),

base_url="https://dashscope-intl.aliyuncs.com/compatible-mode/v1",

)

completion = client.chat.completions.create(

model="qwen3-coder-plus",

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Help me create a web page for an online bookstore."}

],

)

print(completion.choices[0].message.content.strip())未来已来:与AI共同进化

官方在发布中提到,正在积极探索 “代码智能体能否实现自我进化”。这预示着AI编程的未来方向:一个能够通过持续学习来不断提升自身能力的系统。

对于开发者而言,Qwen3-Coder这类工具的出现,意味着工作重心的转移。我们将从繁琐的代码实现中解放出来,更多地扮演 架构师、产品设计师和问题定义者 的角色。我们的核心价值将更多地体现在 创造性思考、复杂系统设计和对业务的深刻理解 上。

这是一个挑战与机遇并存的时代。我们手中的工具正变得前所未有的强大,而如何驾驭这些工具,将决定我们未来在技术浪潮中的位置。

(文:子非AI)