在机器学习的浩瀚星空中,总有一些论文,和一些传奇人物,如同闪耀的星辰,照亮整个研究方向。

这次的得主是AI界的传奇人物Ilya Sutskever!

他和Oriol Vinyals、Quoc V. Le共同发表的论文「Sequence to Sequence Learning with Neural Networks」获此殊荣。

有趣的是,当Geoffrey Hinton获得图灵奖时曾说:「我最自豪的是我的学生们,其中一个甚至把Sam Altman开除了。」

没错,他说的就是Ilya Sutskever。

一路开挂的AI巨人

Ilya可不是一般的强。他在AI领域简直是开了挂:

2022年的获奖论文?他参与了!

2023年的获奖论文?他也参与了!

2024年又轮到他自己的论文!

连续三年,他的研究作品都获得了NeurIPS的最高荣誉,这简直是前无古人的成就!

就在今年的NeurIPS大会上,Google AI的seq2seq论文再度获得「Test of Time」殊荣,向我们展示了深度学习的魅力与潜力。

这篇由Ilya Sutskever、Oriol Vinyals和Quoc V. Le联合撰写的论文「Sequence to Sequence Learning with Neural Networks」,不仅在当年引领了序列学习的革命,如今更是被学术界追认为里程碑式的重要研究。

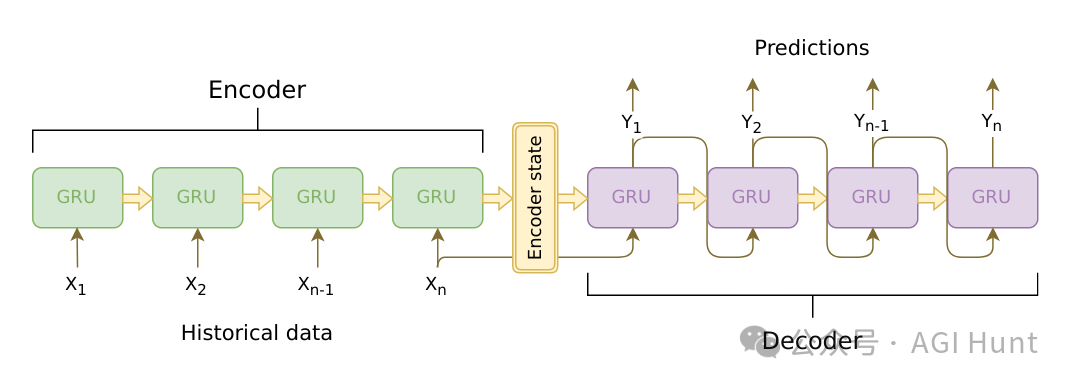

什么是seq2seq?

简单来说,seq2seq就是一种能够将一个序列转换成另一个序列的深度学习模型。

比如,它可以实现机器翻译、文本摘要、语音识别等复杂任务。

这个模型的核心是使用长短期记忆网络(LSTM),能够捕捉序列中的长期依赖关系。

Jeff Dean在祝贺推文中特别提到,这项研究就发生在他办公桌几米之内,他亲眼见证了这个伟大想法的诞生与成长。

为什么这篇论文如此重要?

-

突破传统序列学习局限:在此之前,处理序列到序列的转换是极其困难的。这篇论文提供了一种端到端的学习方法。

-

翻译性能显著提升:在英法翻译任务中,该模型的BLEU得分达到了34.8,超过了当时最先进的短语翻译系统。

-

创新的词序处理:研究者发现,反转源语言句子的词序能显著提高模型性能,这是一个令人惊讶的发现。

seq2seq模型为深度学习在自然语言处理、机器翻译等领域的应用开辟了全新的道路。

论文原文可在Google Research网站查阅,对感兴趣的读者来说,这绝对是一份值得细细品读的学术瑰宝。

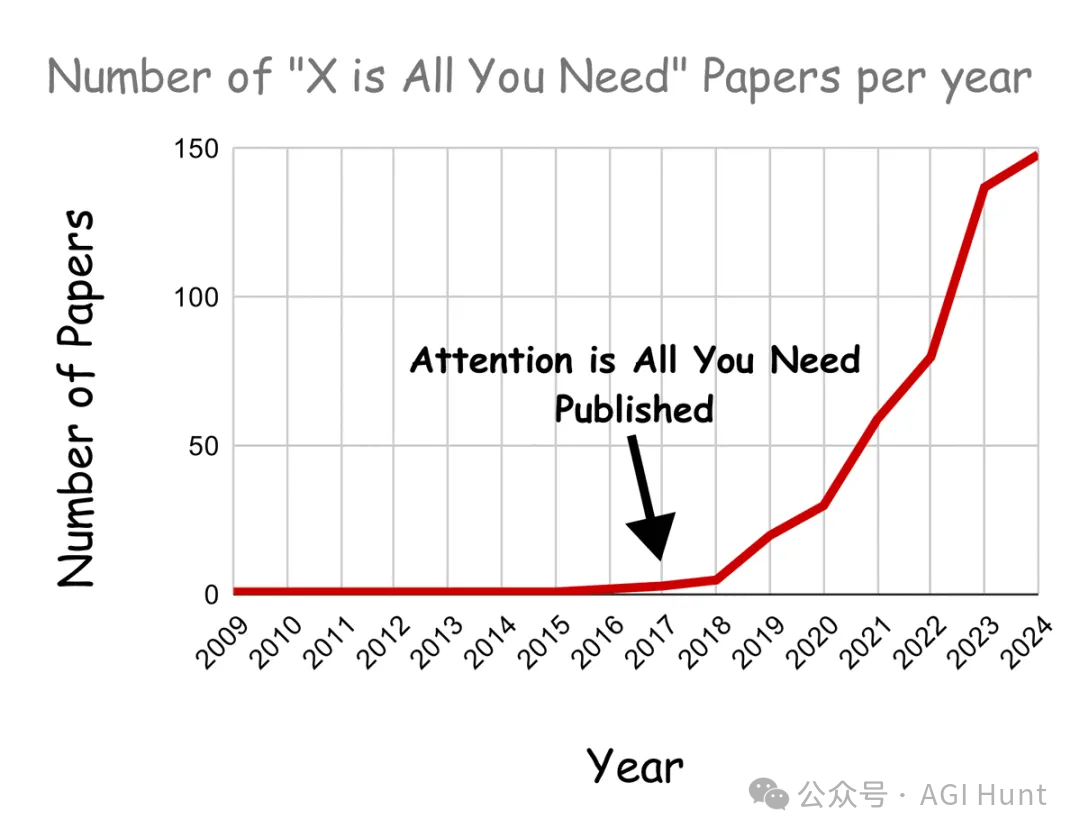

未来论文预测

那么,哪些论文有可能获得未来几年的「时间检验奖」呢?

2025年可能是「基于注意力的语音识别」(2015):它首次引入了注意力机制,为后来的Transformer模型铺平了道路。

2026年可能是「二值化神经网络」(2016):这篇论文启发了现在流行的极限量化技术。

2027年?答案呼之欲出:「Attention is All You Need」(2017)。因为,注意力机制真的是你所需要的全部

见:”X is All You Need”的论文标题是怎么爆发的?

值得一提的是,今年的「时间检验奖」不是给了一篇,而是给了两篇论文!

Jeff Dean不仅祝贺了seq2seq论文的作者,还特别提到了Ian Goodfellow等人关于生成对抗网络(GANs)的重要研究,这也体现了Google在机器学习领域的持续创新和对行业的重要贡献。

(文:AGI Hunt)