新智元报道

新智元报道

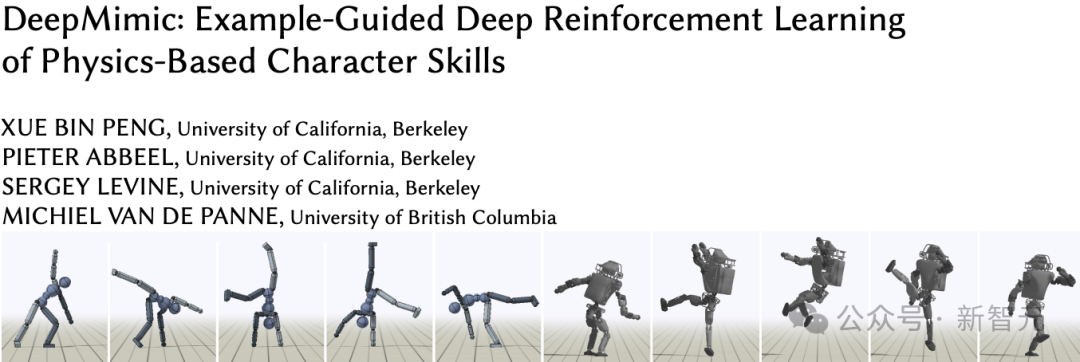

【新智元导读】谷歌DeepMind与HHMI Janelia研究所的科学家们,用AI打造了一个栩栩如生的虚拟果蝇模型。这个模型不仅能精准模拟果蝇的飞行与行走,还通过深度强化学习模仿真实果蝇的行为。

一只小小的果蝇是如何在空中优雅地飞舞,或者在地面上灵活地爬行的?

这些看似简单的动作背后,隐藏着复杂的生物机制和神经控制。

为了揭开这些秘密,谷歌DeepMind团队联合HHMI Janelia研究所,利用AI和物理模拟技术,打造了一个逼真的虚拟果蝇模型。

论文链接:https://www.nature.com/articles/s41586-025-09029-4

项目链接:https://github.com/TuragaLab/flybody

这个模型不仅能模拟果蝇的行走和飞行,还能通过观察真实果蝇的行为,学习如何控制动作。

研究团队用高分辨率的体视显微镜,详细扫描了一只雌性果蝇的身体,精确地记录下它的每一条腿、每一片翅膀,甚至每一个关节的细节。

他们在MuJoCo物理引擎中构建了一个精确的三维果蝇模型。

MuJoCo是一个由谷歌DeepMind开发的开源物理模拟器,用来模拟机器人和生物力学场景。

但光有模型还不够,果蝇的运动离不开空气和地面的相互作用。

研究人员在MuJoCo中加入了新的功能:模拟翅膀扇动时与空气的流体相互作用。

他们还设计了黏附执行器,用来模仿果蝇脚部与地面接触时的抓握力。

这些改进让虚拟果蝇不仅能站在地面上,还能像真实果蝇一样飞起来。

这个数字果蝇看起来就像一只真正的果蝇:橙色的身体、透明的翅膀,还有那对标志性的红色大眼睛。

有了逼真的身体模型,下一步就是让果蝇学会运动。研究团队训练了一个人工神经网络。

他们收集了大量真实果蝇行为的视频,比如果蝇如何行走、如何起飞、如何调整方向。

通过深度强化学习和模仿学习,神经网络逐渐掌握了果蝇的运动模式。

在模拟中,虚拟果蝇展现出了惊艳的真实感。

它能沿着复杂的自然飞行轨迹移动,比如研究人员设置的蓝色轨迹点,果蝇会精准地跟随这些点飞行,翅膀拍动的频率和角度都与真实果蝇无异。

它甚至能模仿真实果蝇的视觉导航能力。虚拟果蝇能看到周围的环境,并根据视觉信息调整自己的行为。

为了让更多研究人员受益,谷歌DeepMind和HHMI Janelia研究所决定将这个果蝇模型开源。他们不仅发布了模型的代码,还提供了详细的技术文档。

构建好果蝇身体模型和物理模拟环境后,模型如何产生逼真的运动行为?

研究团队采用深度强化学习(RL)技术解决这一难题。

他们训练人工神经网络,让它扮演果蝇神经系统的角色,形成闭环感觉运动控制器。

训练时,MuJoCo模拟感觉系统产生的信号输入到神经网络,神经网络据此计算控制信号,驱动模型执行器动作。

为让模型学习真实运动行为,研究团队采用模仿学习法。

他们收集大量真实果蝇飞行和行走的轨迹数据,以此让模型学习模仿真实果蝇的运动模式。

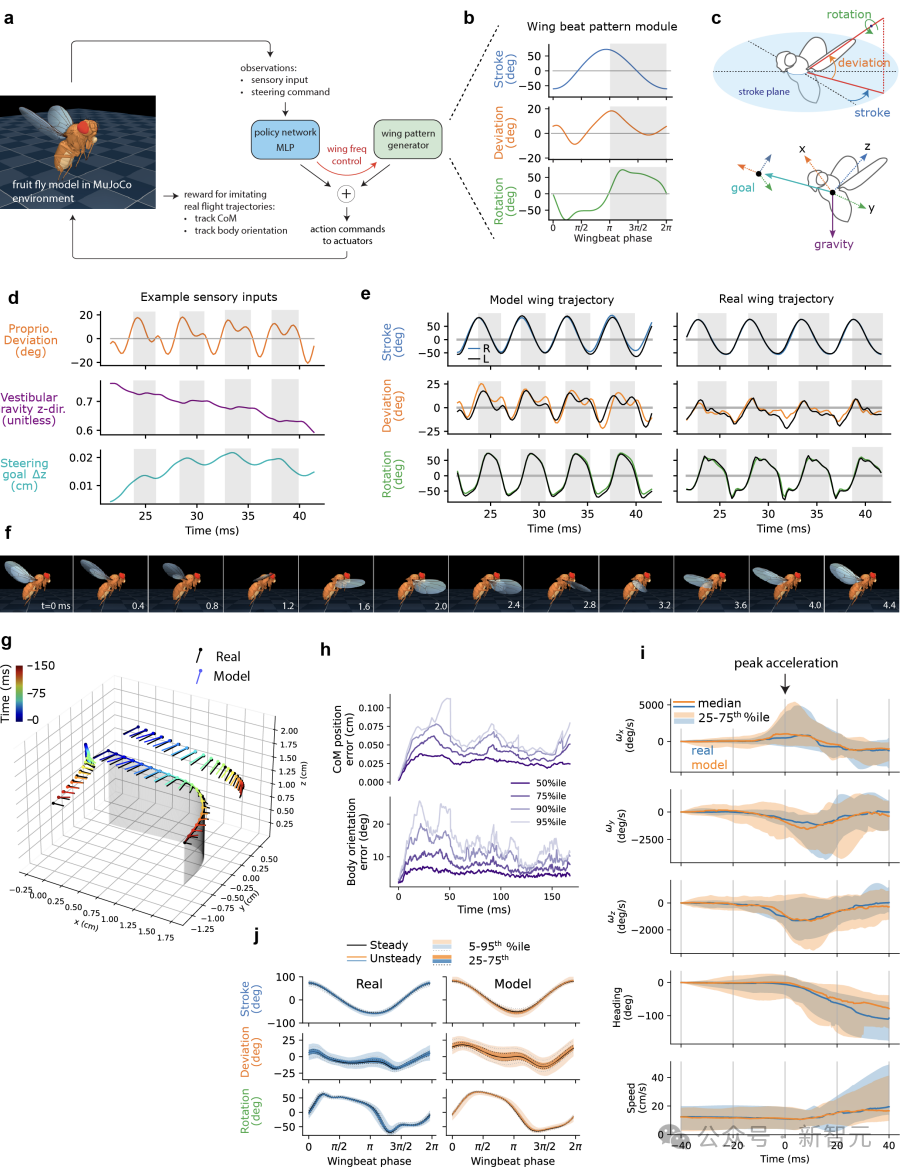

在飞行任务中,研究团队利用之前收集的海德氏果蝇自由飞行的高速视频数据,训练可转向的飞行控制器。

该控制器由固定的翅膀拍打模式生成器(WPG)和可训练的全连接多层感知器(MLP)组成。

WPG能产生接近真实果蝇悬停时的翅膀拍打模式,为模型提供稳定基础;

MLP则通过学习微调WPG输出,使模型能根据不同飞行需求,如转弯、加速、减速等,做出相应翅膀运动。

其中飞行模型的网络运动命令,是MLP和WPG输出的总和。

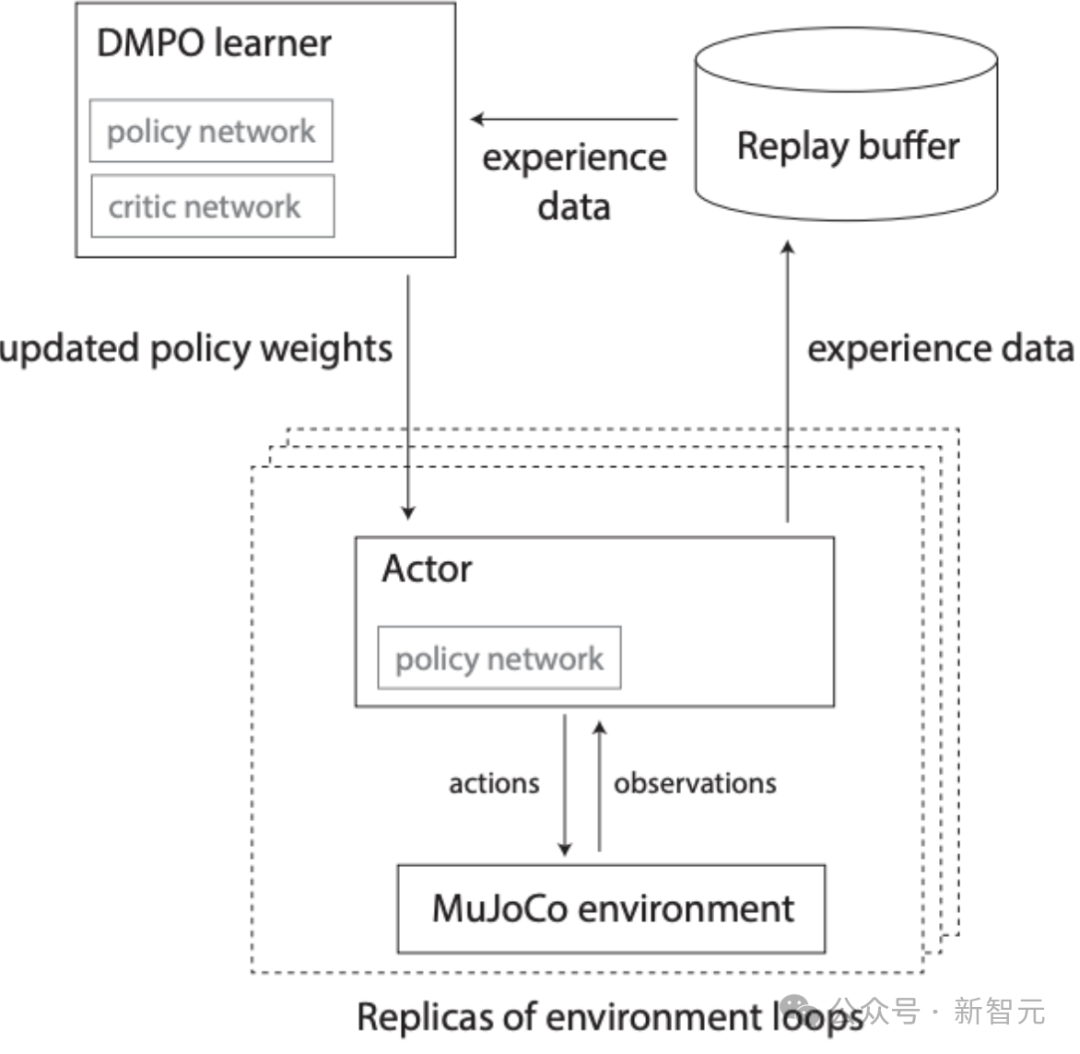

为提高训练效率,研究团队还采用分布式强化学习方法,借助Ray分布式计算框架,在多个CPU和GPU上并行训练模型,大幅缩短了训练时间。

分布式RL训练架构

多个MuJoCo环境中的演员副本收集经验,并将其输入到单一的重放缓冲区。

DMPO学习器从重放缓冲区中抽取经验,更新策略和评论家网络的权重,并将更新后的权重发送到演员的策略副本。

为了让训练轨迹泛化到新的运动轨迹,还训练了「可转向」的低层控制器。

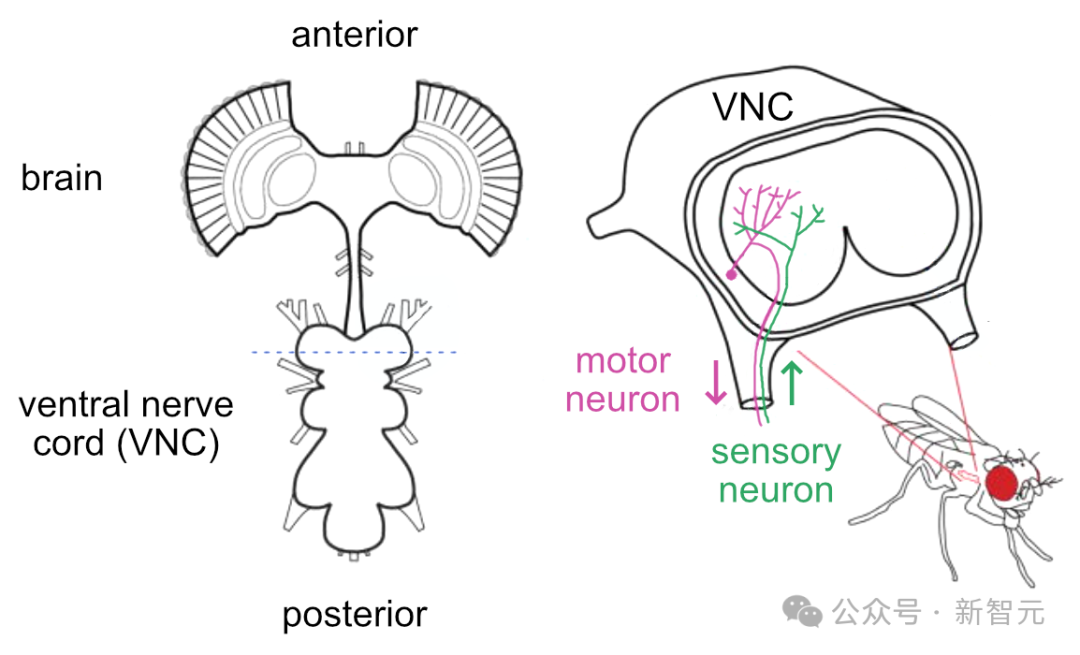

这些神经网络类似于果蝇中枢神经系统的腹神经索(ventral nerve cord,VNC),负责将来自中央大脑的高层(下行)命令信号转化为低层次的运动控制信号。

下图左为果蝇中枢神经系统的示意图,包括大脑和腹神经索。下图右为腹神经索的横截面,粉色为传出信号的运动神经元,绿色为传入信号的感觉神经元。

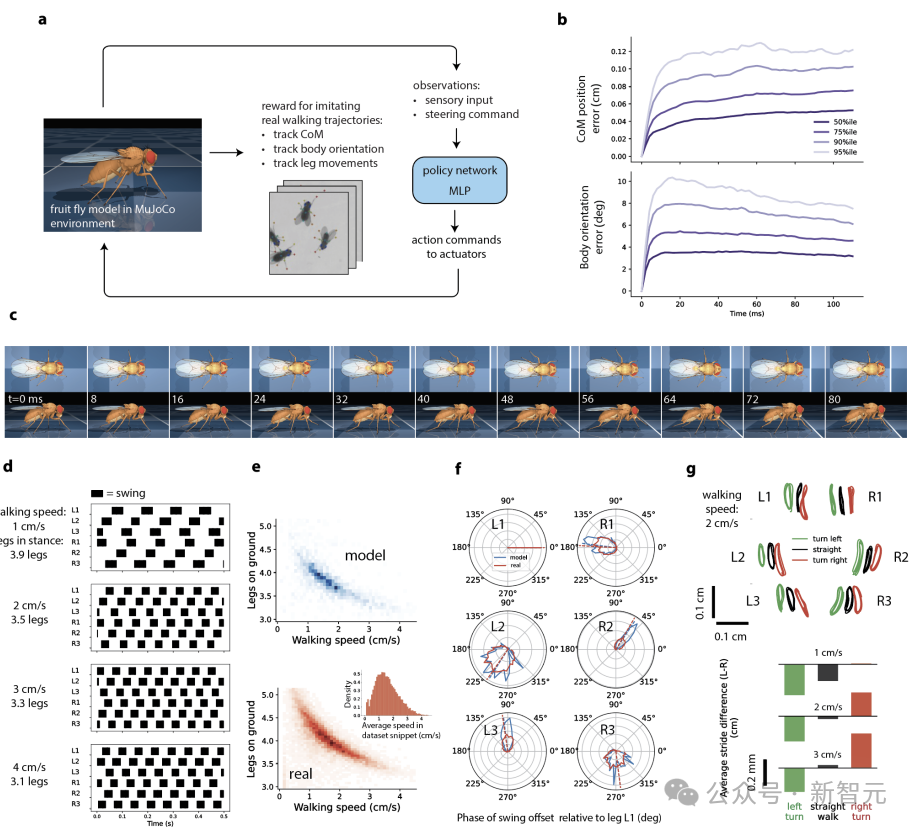

研究者训练了两个可转向神经网络控制器(策略网络):分别控制飞行(图2)与行走(图3)。

在行走任务中,鉴于果蝇步态模式复杂多样,研究团队直接用一个全连接的MLP作为控制器。

通过学习大量行走轨迹数据,模型学会根据不同环境和目标调整腿部运动,实现稳定行走和灵活转向。

利用之前收集的高速视频数据,研究者使用模仿学习训练了一个可转向的飞行控制器(图2a)。

这些数据集包含了272条单独的轨迹(约53秒的实际飞行时间),记录了飞行过程中身体质心(CoM)和翅膀运动学,涵盖了转弯、速度和高度变化、直飞、侧飞、倒飞和悬停等行。

研究者还训练了一个单一的控制器网络,模仿训练数据集中所有216条飞行轨迹。

这个可转向的控制器能够保持稳定的飞行,并推动果蝇穿越新的飞行轨迹。

图2:飞行模拟

具体方法与细节,请参阅原文。

同样采用了模仿学习,研究者训练了一个用于行走的可转向闭环控制器(图3a)。

研究者对一组自由爬行并在圆形竞技场中相互作用的果蝇进行了高速俯视视频拍摄(150 fps)。

使用自动化姿态追踪技术,追踪了雌性果蝇的2D位置,标记了13个关键点,分别位于头部、胸部、腹部和6个腿部尖端的位置。

由于仅凭这些2D关键点的位置,无法明确推断出所有身体自由度(DoFs)的3D姿态,因此研究者采用了一种正则化的逆运动学方法,推断出所有自由度的完整3D飞行器姿态轨迹的近似值。

由于步态的显著变异性,研究者无法像飞行模仿那样使用简单的模式生成器来进行行走模仿。

因此,控制器由一个单一的全连接MLP(图3a)组成,且在训练时没有强制执行任何特定结构,如模式生成器。

研究者在所有约13,000条训练集的行走轨迹上训练了一个单一的MLP策略网络。

图3:爬行模拟

通过展示沿着复杂自然轨迹的真实运动,研究者验证了身体模型和物理模拟的准确性。

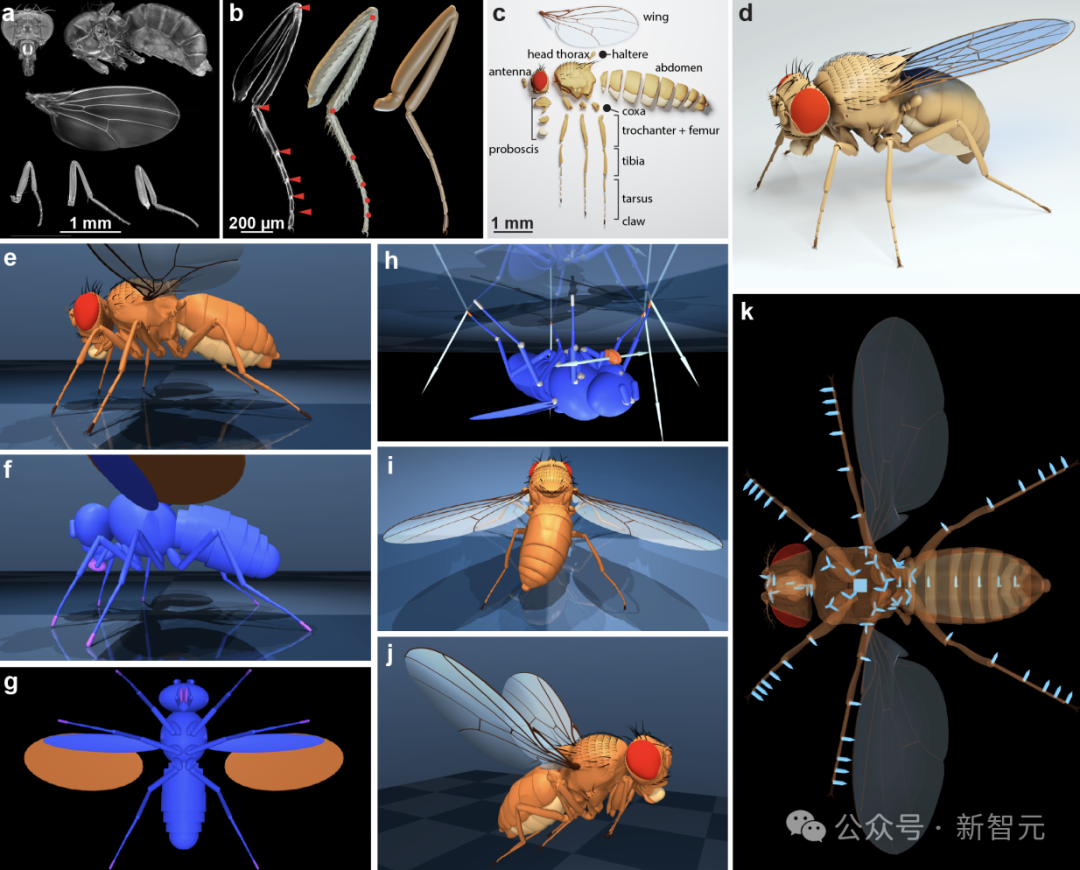

研究者使用高分辨率共聚焦显微镜成像,构建了雌性果蝇的模型(图1)。

荧光染色几丁质的方法便于分割体节形状并识别所有关节的枢轴点(图1b)。

为实现全身无像差的高分辨率成像,需将样本分解为多个部分,通过化学方法清除软组织并进行色素脱色处理。

图1:从共聚焦数据构建雌性果蝇的3D模型

(a) 整合代表单只果蝇的6组数据集:共聚焦图像最大强度投影显示头部、胸腹联合体及腿部结构。

(b) 中腿共聚焦图像局部投影(左,红色三角标记腿节-胫节与跗节间关节),从中提取的三维网格(中)及低多边形腿部模型(右)。

(c) 分解展示的简化模型(约2万面)呈现体节结构。

(d) 静息姿态下的完整解剖模型。

(e) MuJoCo环境中身体模型的侧视图。

(f,g) 用于高效碰撞检测与物理模拟的体节几何基元近似:蓝色为常规碰撞几何体,淡紫色为带黏附驱动器的几何体,赭石色为高级流体模型中实现飞行的翼椭球体。

(h) 模型倒挂时驱动器力场可视化:前右腿、中左腿、后右腿的黏附驱动器(橙色)与唇瓣黏附器处于激活状态,其余驱动器未激活(白色);箭头表示与施加黏附力(扣除重力影响后)成比例反向的接触力。

(i) 夸张姿态展示腹节外展与右后跗节屈曲驱动器激活效果:腹关节与跗关节均通过单一驱动器(「肌腱」)耦合驱动多自由度。

(j) 腿部收拢的飞行姿态模型。

(k) 半透明可视化几何体的底视图,浅蓝箭头指示关节:立方体为6自由度自由关节(模拟器中自由质心运动所需,非果蝇内在自由度),箭头为铰链关节(指向正向旋转方向),三铰链关节组等效形成球关节。

为了准确模拟果蝇的飞行和行走等行为,研究者为MuJoCo物理引擎添加了新功能。

MuJoCo是一款通用物理引擎,旨在为机器人学、生物力学、图形动画、机器学习等领域的研究与开发提供支持

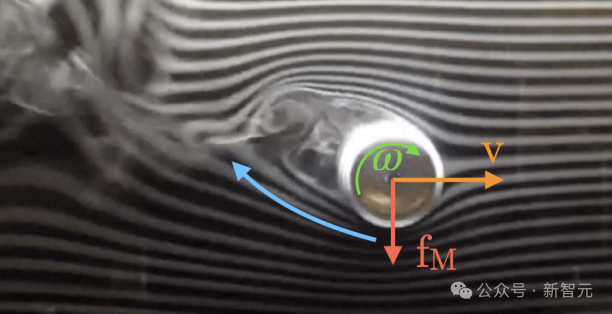

首先,开发了一个新的计算高效的现象学流体模型,用于模拟果蝇翅膀拍动时在空气中产生的力。

其次,开发了附着驱动器,用于模拟昆虫脚抓握表面时产生的力。

现象学流体模型:马格努斯力|烟雾流过旋转的圆柱体。由于粘性,旋转的圆柱体使得进入的流体向上偏转,并且受到一个向下的力

视觉传感器建模上,研究团队用MuJoCo相机传感器模拟果蝇复眼,渲染出特定分辨率和视野的图像,为视觉引导的飞行任务奠定基础。

为什么科学家要花这么大心思去模拟一只小小的果蝇呢?

果蝇虽然小,大脑结构却非常复杂,拥有大约20万个神经元。

通过这个果蝇模型,科学家可以更深入地探索大脑、身体和环境之间的关系。

比如,果蝇如何通过视觉判断方向?它又是如何协调翅膀和腿部的运动以实现平稳飞行?

这些问题在实验室中往往难以直接测量,虚拟模型则提供了一个绝佳的实验平台。

科学家可以在模拟环境中随意调整参数,观察果蝇的行为变化,寻找那些隐藏的规律。

谷歌DeepMind团队已经用类似的方法模拟了啮齿动物,现在正计划将这项技术应用到斑马鱼身上。

斑马鱼是一种与人类有70%蛋白质编码基因相似的生物,广泛用于遗传学研究。未来可能还会加入狗、鸵鸟等更多动物。

(文:新智元)